前言

处理数据样本的代码可能会变得杂乱无章且难以维护;为了获得更好的可读性和模块化,我们理想的情况是将数据集代码与模型训练代码解耦。PyTorch 提供了两个数据处理类:

torch.utils.data.DataLoader 和 torch.utils.data.Dataset,它们允许你使用预加载的数据集以及自己的数据。Dataset 存储样本及其相应的标签,而 DataLoader 在 Dataset 周围包装一个可迭代对象,以便轻松访问样本。

PyTorch领域库提供了许多预加载的数据集(如FashionMNIST),这些数据集继承自 torch.utils.data.Dataset 并实现了特定于该数据的函数。它们可用于对模型进行原型设计和基准测试。你可以在以下位置找到它们:图像数据集、文本数据集 和 音频数据集

加载数据集

以下是一个如何从TorchVision加载 Fashion-MNIST 数据集的示例。时尚MNIST是Zalando的商品图像数据集,由60000个训练示例和10000个测试示例组成。每个示例包含一张28×28的灰度图像以及一个来自10个类别之一的关联标签。

我们使用以下参数加载时尚MNIST数据集:

root是存储训练/测试数据的路径train指定训练数据集或测试数据集,”download=True如果数据在root中不可用,download=True会从互联网下载数据。transformandtarget_transform分别指定特征和标签的变换

import torch

from torch.utils.data import Dataset

from torchvision import datasets

from torchvision.transforms import ToTensor

import matplotlib.pyplot as plttraining_data = datasets.FashionMNIST(root="data",train=True,download=True,transform=ToTensor()

)test_data = datasets.FashionMNIST(root="data",train=False,download=True,transform=ToTensor()

)

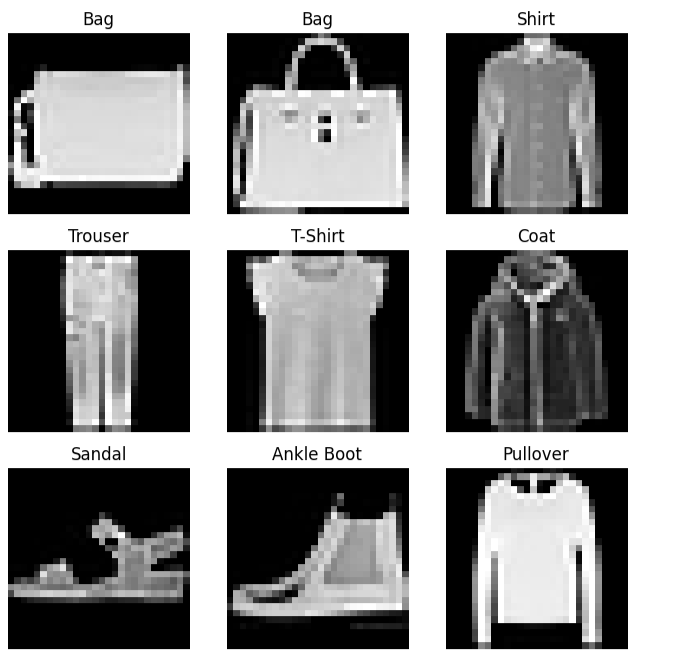

迭代和可视化数据集:

我们可以像列表一样手动对Datasets进行索引:training_data[index]。我们使用matplotlib来可视化训练数据中的一些样本。

labels_map = {0: "T-Shirt",1: "Trouser",2: "Pullover",3: "Dress",4: "Coat",5: "Sandal",6: "Shirt",7: "Sneaker",8: "Bag",9: "Ankle Boot",

}

figure = plt.figure(figsize=(8, 8))

cols, rows = 3, 3

for i in range(1, cols * rows + 1):sample_idx = torch.randint(len(training_data), size=(1,)).item()img, label = training_data[sample_idx]figure.add_subplot(rows, cols, i)plt.title(labels_map[label])plt.axis("off")plt.imshow(img.squeeze(), cmap="gray")

plt.show()

创建自定义数据集

自定义数据集类必须实现三个函数:__init__、__len__ 和 __getitem__。看一下这个实现;FashionMNIST图像存储在目录 img_dir 中,它们的标签则单独存储在CSV文件 annotations_file 中。

import os

import pandas as pd

from torchvision.io import decode_imageclass CustomImageDataset(Dataset):def __init__(self, annotations_file, img_dir, transform=None, target_transform=None):self.img_labels = pd.read_csv(annotations_file)self.img_dir = img_dirself.transform = transformself.target_transform = target_transformdef __len__(self):return len(self.img_labels)def __getitem__(self, idx):img_path = os.path.join(self.img_dir, self.img_labels.iloc[idx, 0])image = decode_image(img_path)label = self.img_labels.iloc[idx, 1]if self.transform:image = self.transform(image)if self.target_transform:label = self.target_transform(label)return image, label

__init__

__init__函数在实例化Dataset对象时运行一次。我们初始化包含图像的目录、注释文件以及两种变换(下一节将更详细介绍)。

tshirt1.jpg, 0

tshirt2.jpg, 0

......

ankleboot999.jpg, 9

def __init__(self, annotations_file, img_dir, transform=None, target_transform=None):self.img_labels = pd.read_csv(annotations_file)self.img_dir = img_dirself.transform = transformself.target_transform = target_transform

__len__

__len__函数返回我们数据集中样本的数量。

def __len__(self):return len(self.img_labels)

__getitem__

__getitem__函数会根据给定的索引idx从数据集中加载并返回一个样本。根据该索引,它会确定图像在磁盘上的位置,使用decode_image将其转换为张量,从self.img_labels中的CSV数据中检索相应的标签,对它们调用变换函数(如果适用),并以元组形式返回张量图像和相应的标签。

def __getitem__(self, idx):img_path = os.path.join(self.img_dir, self.img_labels.iloc[idx, 0])image = read_image(img_path)label = self.img_labels.iloc[idx, 1]if self.transform:image = self.transform(image)if self.target_transform:label = self.target_transform(label)return image, label

使用DataLoaders为训练准备数据

Dataset 每次检索一个样本,获取我们数据集的特征和标签。在训练模型时,我们通常希望以 “小批量” 方式传递样本,在每个时期对数据进行重新洗牌以减少模型过拟合,并使用 Python 的 multiprocessing 来加速数据检索。

DataLoader 是一个可迭代对象,它通过简单的API为我们抽象了这种复杂性。

from torch.utils.data import DataLoadertrain_dataloader = DataLoader(training_data, batch_size=64, shuffle=True)

test_dataloader = DataLoader(test_data, batch_size=64, shuffle=True)

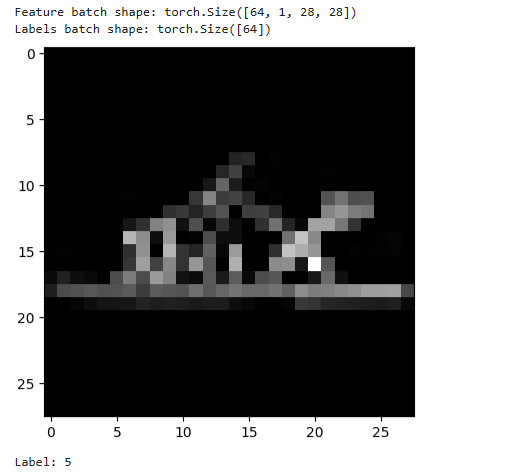

遍历DataLoader

我们已将该数据集加载到DataLoader中,并可根据需要遍历数据集。下面的每次迭代都会返回一批train_features和train_labels(分别包含batch_size=64个特征和标签)。因为我们指定了shuffle=True,所以在遍历完所有批次后,数据会被打乱。

# Display image and label.

train_features, train_labels = next(iter(train_dataloader))

print(f"Feature batch shape: {train_features.size()}")

print(f"Labels batch shape: {train_labels.size()}")

img = train_features[0].squeeze()

label = train_labels[0]

plt.imshow(img, cmap="gray")

plt.show()

print(f"Label: {label}")

)

![[激光原理与应用-254]:理论 - 几何光学 - 自动对焦的原理](http://pic.xiahunao.cn/[激光原理与应用-254]:理论 - 几何光学 - 自动对焦的原理)

——matplotlib库)