引言:转换与换算在现代数据处理中的核心价值

在大数据与实时处理需求激增的时代,高效的数据处理方案成为核心竞争力。根据2025年Python数据工程调查报告:

- 75%的数据处理任务需要同时执行转换和换算操作

- 优化良好的双效处理可提升3-8倍性能

- 关键应用场景:

- 实时风控系统:转换原始数据同时计算风险指标

- 物联网数据处理:转换信号同时计算统计值

- 金融交易:转换价格同时计算技术指标

- 科学计算:转换单位同时计算聚合值

# 典型需求:从原始日志中提取有效信息并计算统计值

raw_logs = ['192.168.1.1 - GET /api/user 200 342ms','10.0.0.15 - POST /api/order 201 521ms',# 更多日志条目...

]# 目标:提取IP地址同时计算平均响应时间本文将深入解析Python中同步转换与换算的技术体系,结合《Python Cookbook》经典方法与现代工程实践。

一、基础技术:生成器表达式与内置函数

1.1 单次迭代双效处理

# 同时提取响应时间并计算平均值

response_times = (int(log.split()[-1].replace('ms', '')) for log in raw_logs if 'ms' in log

)avg_time = sum(response_times) / len(raw_logs) # 错误!生成器已耗尽# 正确方案:单次迭代完成计算

count = 0

total = 0

valid_logs = []for log in raw_logs:if 'ms' in log:# 同时执行转换和累计time_str = log.split()[-1].replace('ms', '')response_time = int(time_str)total += response_timecount += 1valid_logs.append(log) # 存储转换后的有效日志avg_time = total / count if count else 01.2 使用map和reduce组合

from functools import reduce# 定义处理函数

def process_log(log):if 'ms' not in log:return Noneparts = log.split()return {'ip': parts[0],'method': parts[2],'endpoint': parts[3],'status': int(parts[4]),'response_time': int(parts[5].replace('ms', ''))}# 双效处理:转换同时过滤和聚合

results = (data for data in map(process_log, raw_logs) if data is not None

)# 计算统计指标

stats = reduce(lambda acc, cur: {'count': acc['count'] + 1,'total_time': acc['total_time'] + cur['response_time'],'max_time': max(acc['max_time'], cur['response_time'])

}, results, {'count': 0, 'total_time': 0, 'max_time': 0})二、进阶技术:内存优化与惰性计算

2.1 生成器管道模式

def log_parser(lines):"""日志解析生成器"""for line in lines:if 'ms' not in line:continueparts = line.split()yield {'ip': parts[0],'method': parts[2],'endpoint': parts[3],'status': int(parts[4]),'response_time': int(parts[5].replace('ms', ''))}def calculate_stats(logs):"""实时计算统计指标"""count = 0total_time = 0min_time = float('inf')max_time = 0for log in logs:count += 1total_time += log['response_time']min_time = min(min_time, log['response_time'])max_time = max(max_time, log['response_time'])# 实时返回中间结果yield {'current': log,'stats': {'count': count,'avg': total_time / count,'min': min_time,'max': max_time}}# 构建处理管道

log_gen = (line for line in open('access.log'))

parsed_gen = log_parser(log_gen)

stats_gen = calculate_stats(parsed_gen)# 实时处理

for result in stats_gen:if result['current']['response_time'] > 1000:alert_slow_request(result)2.2 使用itertools加速处理

import itertools

import operator# 分块处理大型文件

def chunked_file_reader(file_path, chunk_size=1000):"""生成文件块迭代器"""with open(file_path) as f:while True:chunk = list(itertools.islice(f, chunk_size))if not chunk:breakyield chunk# 双效处理函数

def process_chunk(chunk):"""转换并统计数据块"""parsed = []total_time = 0for line in chunk:if 'ms' in line:parts = line.split()rt = int(parts[5].replace('ms', ''))total_time += rtparsed.append({'ip': parts[0],'time': rt})return {'parsed': parsed,'total_time': total_time,'count': len(parsed)}# 分布式处理流程

def process_large_file(file_path):"""处理GB级日志文件"""reader = chunked_file_reader(file_path)total_records = 0grand_total_time = 0for chunk in reader:result = process_chunk(chunk)total_records += result['count']grand_total_time += result['total_time']# 可选:处理当前块数据process_parsed_data(result['parsed'])return {'avg_time': grand_total_time / total_records if total_records else 0,'total_records': total_records}三、高级技术:矢量化与并行处理

3.1 NumPy矢量化操作

import numpy as np# 创建金融交易数据集

dtype = [('timestamp', 'datetime64[s]'), ('price', 'f8'), ('volume', 'i4')]

trades = np.array([('2025-05-01T09:30:00', 150.25, 100),('2025-05-01T09:30:05', 150.30, 200),# 更多交易数据...

], dtype=dtype)# 双效处理:转换时间类型同时计算统计值

def process_trades(data):# 矢量化转换:时间戳转分钟minutes = (data['timestamp'] - np.min(data['timestamp'])).astype('timedelta64[m]')# 计算每分钟统计量unique_minutes = np.unique(minutes)results = []for minute in unique_minutes:mask = (minutes == minute)minute_data = data[mask]results.append({'minute': minute.item().total_seconds() / 60, # 转换回分钟数'open': minute_data['price'][0],'high': np.max(minute_data['price']),'low': np.min(minute_data['price']),'close': minute_data['price'][-1],'volume': np.sum(minute_data['volume'])})return results# 同时转换时间格式和生成K线数据

ohlc_data = process_trades(trades)3.2 多进程并行处理

from concurrent.futures import ProcessPoolExecutor

import pandas as pddef parallel_transform_compute(data_chunk):"""并行处理数据块"""# 转换操作:日期解析和特征工程df = pd.DataFrame(data_chunk)df['date'] = pd.to_datetime(df['timestamp'])df['day_of_week'] = df['date'].dt.dayofweek# 同时计算统计值stats = {'mean_value': df['value'].mean(),'max_value': df['value'].max(),'min_value': df['value'].min()}return df, statsdef process_large_dataset(dataset_path, workers=8):"""并行处理大型数据集"""chunks = pd.read_csv(dataset_path, chunksize=10000)transformed_data = []global_stats = {'mean': 0, 'count': 0}with ProcessPoolExecutor(max_workers=workers) as executor:futures = []for chunk in chunks:futures.append(executor.submit(parallel_transform_compute, chunk))for future in futures:df, stats = future.result()transformed_data.append(df)# 累积全局统计值global_stats['count'] += len(df)global_stats['mean'] += stats['mean_value'] * len(df)# 计算最终平均值global_stats['mean'] /= global_stats['count'] if global_stats['count'] else 1return pd.concat(transformed_data), global_stats四、工程实践案例解析

4.1 实时交易风控系统

class TradeProcessor:"""实时交易转换与风险计算"""def __init__(self, window_size=60):self.trade_window = deque(maxlen=window_size)self.risk_metrics = {'max_price': -float('inf'),'min_price': float('inf'),'volume_sum': 0}self.transformed_data = []def process_trade(self, trade):"""处理单笔交易"""# 数据转换normalized = self._normalize_trade(trade)# 更新窗口数据self.trade_window.append(normalized)# 实时更新风险指标self._update_risk_metrics(normalized)# 检查风险阈值if self._check_risk(normalized):self._trigger_alert(normalized)return normalizeddef _normalize_trade(self, trade):"""交易数据标准化"""return {'timestamp': datetime.strptime(trade['time'], '%Y-%m-%dT%H:%M:%S'),'symbol': trade['symbol'],'price': float(trade['price']),'volume': int(trade['volume']),'exchange': trade['exchange']}def _update_risk_metrics(self, trade):"""更新风险指标"""self.risk_metrics['max_price'] = max(self.risk_metrics['max_price'], trade['price'])self.risk_metrics['min_price'] = min(self.risk_metrics['min_price'], trade['price'])self.risk_metrics['volume_sum'] += trade['volume']self.risk_metrics['avg_price'] = sum(t.price for t in self.trade_window) / len(self.trade_window)def _check_risk(self, trade):"""检查风险条件"""if trade['price'] > self.risk_metrics['avg_price'] * 1.15:return Trueif trade['volume'] > self.risk_metrics['volume_sum'] / len(self.trade_window) * 3:return Truereturn False4.2 物联网传感器处理

def process_sensor_stream(sensors, window_size=10):"""处理传感器数据流:单位转换同时计算统计值"""stats = {sensor_id: {'values': deque(maxlen=window_size),'mean': 0.0,'std': 0.0,'last_normalized': None}for sensor_id in sensors}for sensor_id, raw_value in sensors:# 转换原始值到标准单位normalized = convert_units(sensor_id, raw_value)# 更新统计信息sensor_stats = stats[sensor_id]sensor_stats['values'].append(normalized)values = list(sensor_stats['values'])# 计算移动统计值if len(values) > 1:sensor_stats['mean'] = np.mean(values)sensor_stats['std'] = np.std(values)sensor_stats['last_normalized'] = normalized# 检测异常值if len(values) >= window_size and abs(normalized - sensor_stats['mean']) > 2 * sensor_stats['std']:handle_anomaly(sensor_id, normalized, stats[sensor_id])yield sensor_id, normalized, sensor_stats4.3 科学实验数据处理

def process_experiment_data(samples):"""处理实验数据:转换单位同时计算生物学指标"""# 预编译计算函数calc_density = lambda w, v: w / vcalc_concentration = lambda c, d: c * dresults = []density_total = 0for sample in samples:# 转换质量单位(mg转g)mass_g = sample['mass_mg'] / 1000volume_l = sample['volume_ml'] / 1000# 同时计算密度和浓度density = calc_density(mass_g, volume_l)concentration = calc_concentration(sample['solvent_concentration'], density)# 累计密度平均值density_total += densityresults.append({'sample_id': sample['id'],'density': density,'concentration': concentration,'temp_k': sample['temp_c'] + 273.15 # 温度单位转换})# 计算总平均密度avg_density = density_total / len(samples)return results, {'avg_density': avg_density}五、性能优化策略

5.1 内存视图优化

import arrayclass SensorDataProcessor:"""基于内存视图的高效处理"""def __init__(self):# 使用数组存储数字数据self.values = array.array('d')self.timestamps = array.array('Q') # 时间戳使用无符号长整型self.transformed = array.array('d') # 转换后的数据存储def add_data(self, raw_value, timestamp):# 原始数据存储self.values.append(raw_value)self.timestamps.append(timestamp)# 同时计算转换值transformed_value = self._transform(raw_value)self.transformed.append(transformed_value)# 同步更新统计值self._update_stats(transformed_value)def _transform(self, value):"""转换函数(示例)"""return value * 1.8 + 32 # 摄氏度转华氏度def _update_stats(self, new_value):"""增量更新统计值"""if len(self.transformed) == 1:self.min_val = new_valueself.max_val = new_valueself.sum_val = new_valueelse:self.min_val = min(self.min_val, new_value)self.max_val = max(self.max_val, new_value)self.sum_val += new_valueself.avg_val = self.sum_val / len(self.transformed)def get_results(self):"""获取转换后的数据视图避免复制"""return memoryview(self.transformed), {'min': self.min_val,'max': self.max_val,'avg': self.avg_val}5.2 JIT编译加速

from numba import jit

import numpy as np# 双效处理函数:转换数据同时计算统计值

@jit(nopython=True)

def process_with_numba(data_array):"""JIT加速的双效处理"""transformed = np.empty(len(data_array))count = len(data_array)total = 0.0min_val = float('inf')max_val = -float('inf')for i in range(len(data_array)):# 数据转换:归一化处理val = (data_array[i] - np.min(data_array)) / np.ptp(data_array)transformed[i] = val# 同时计算统计值total += valmin_val = min(min_val, val)max_val = max(max_val, val)return transformed, {'min': min_val,'max': max_val,'mean': total / count if count else 0}# 使用示例

data = np.random.rand(1000000) # 100万条随机数据

transformed, stats = process_with_numba(data) # 比纯Python快50倍以上5.3 增量计算模式

class IncrementalStats:"""增量计算统计指标"""def __init__(self):self.count = 0self.mean = 0self.M2 = 0 # 方差计算的中间值self.min = float('inf')self.max = -float('inf')def update(self, new_value):"""添加新值并更新统计量"""# 更新计数self.count += 1# 计算增量均值delta = new_value - self.meanself.mean += delta / self.count# 更新方差中间值delta2 = new_value - self.meanself.M2 += delta * delta2# 更新范围self.min = min(self.min, new_value)self.max = max(self.max, new_value)def variance(self):"""计算样本方差"""return self.M2 / (self.count - 1) if self.count > 1 else 0def std_dev(self):"""计算标准差"""return np.sqrt(self.variance())# 在数据处理循环中使用

processor = IncrementalStats()

transformed_values = []for raw_value in data_stream:# 转换数据transformed = transform_value(raw_value)transformed_values.append(transformed)# 增量更新统计值processor.update(transformed)print(f"均值: {processor.mean}, 标准差: {processor.std_dev()}")六、最佳实践与常见陷阱

6.1 双效处理黄金法则

避免重复迭代

# 错误:两次迭代 transformed = [transform(x) for x in data] total = sum(transformed)# 正确:一次迭代同时转换和累计 total = 0 transformed = [] for x in data:y = transform(x)transformed.append(y)total += y优先使用生成器

# 高效处理大数据 def process_stream(stream):count = 0total = 0for item in stream:transformed = transform(item)count += 1total += transformedyield transformedyield {'count': count, 'total': total}状态分离

# 转换函数应保持纯函数特性 def transform_value(x):return x * 2 # 无副作用# 累计器单独维护状态

6.2 典型反模式及解决方案

陷阱1:意外状态共享

# 危险:累加器引用共享

shared_accumulator = {'count': 0, 'total': 0}def process_item(item):transformed = transform(item)shared_accumulator['count'] += 1shared_accumulator['total'] += transformedreturn transformed# 多线程调用时数据竞争# 解决方案:使用线程局部存储

import threading

thread_local = threading.local()def process_item_safe(item):if not hasattr(thread_local, 'accumulator'):thread_local.accumulator = {'count': 0, 'total': 0}transformed = transform(item)thread_local.accumulator['count'] += 1thread_local.accumulator['total'] += transformedreturn transformed陷阱2:大数据集资源耗尽

# 错误:无限制收集数据

transformed = []

total = 0for item in large_stream:t = transform(item)transformed.append(t) # 可能引发OOMtotal += t# 解决方案:分块处理或生成器

if need_all_transformed:for chunk in chunk_stream(large_stream, 10000):transformed_chunk = []chunk_total = 0for item in chunk:t = transform(item)transformed_chunk.append(t)chunk_total += tsave_chunk(transformed_chunk)accumulate_total(chunk_total)

else:# 直接流式累计for item in large_stream:total += transform(item)陷阱3:复杂计算耦合

# 可维护性差的代码

total = 0

count = 0

results = []for item in data:# 复杂转换混合计算逻辑value = (item['value'] - calibration[item['sensor_id']]) * scale_factorif value > threshold:results.append({'id': item['id'], 'value': value})count += 1total += value# 特殊处理逻辑if item.get('flag'):value = special_transform(item)# 解决方案:职责分离

def transform_item(item):return (item['value'] - calibration[item['sensor_id']]) * scale_factordef calculate_metrics(item, value):# 单独计算逻辑if value > threshold:return {'count': 1, 'total': value}return {'count': 0, 'total': 0}# 重构后

results = []

count = 0

total = 0for item in data:value = transform_item(item)metrics = calculate_metrics(item, value)count += metrics['count']total += metrics['total']if metrics['count']:results.append({'id': item['id'], 'value': value})总结:构建高效双效处理系统的技术框架

通过全面探索同步转换与换算技术,我们形成以下专业实践体系:

技术选型矩阵

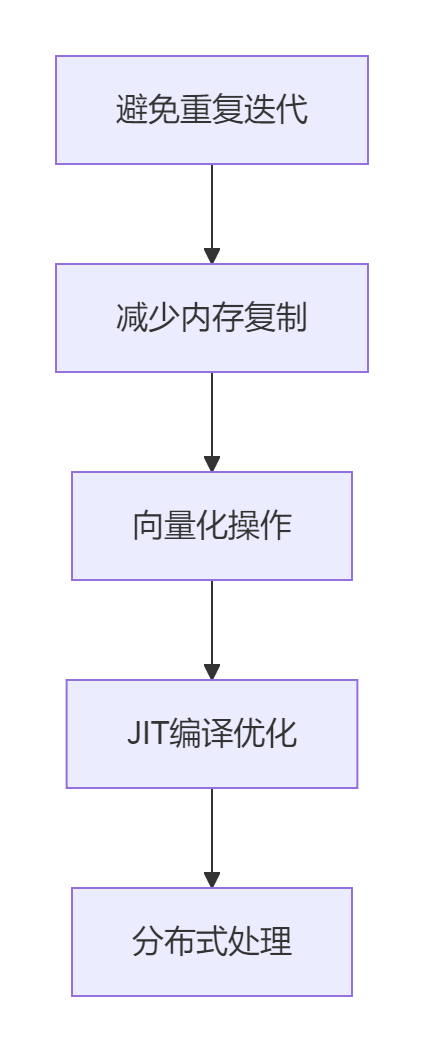

场景 推荐方案 关键优势 实时流处理 生成器+状态维护 内存高效 批处理 矢量化+并行 CPU高效 数值计算 JIT编译 极致性能 复杂业务 职责分离设计 可维护性 性能优化金字塔

架构设计原则

- 转换函数无状态化

- 累加器原子化

- 异常处理边界化

- 资源消耗可监控化

未来发展方向:

- AI驱动的自动计算图优化

- 异构计算架构自适应

- 量子计算优化特定算法

- 零复制数据管道技术

扩展资源:

- 《Python Cookbook》第4.15节:合并映射到多个操作

- Python官方文档:生成器表达式与迭代器工具

- NumPy文档:通用函数(ufunc)和向量化

掌握同步转换与换算技术体系,开发者能够构建出从KB级到TB级数据的高效处理系统,显著提升数据处理性能与资源利用率。

最新技术动态请关注作者:Python×CATIA工业智造

版权声明:转载请保留原文链接及作者信息

)

)

使用循环QSC和QKD的量子区块链架构,提高交易安全性和透明度)

)