一、什么是数据集成?

数据集成的定义:

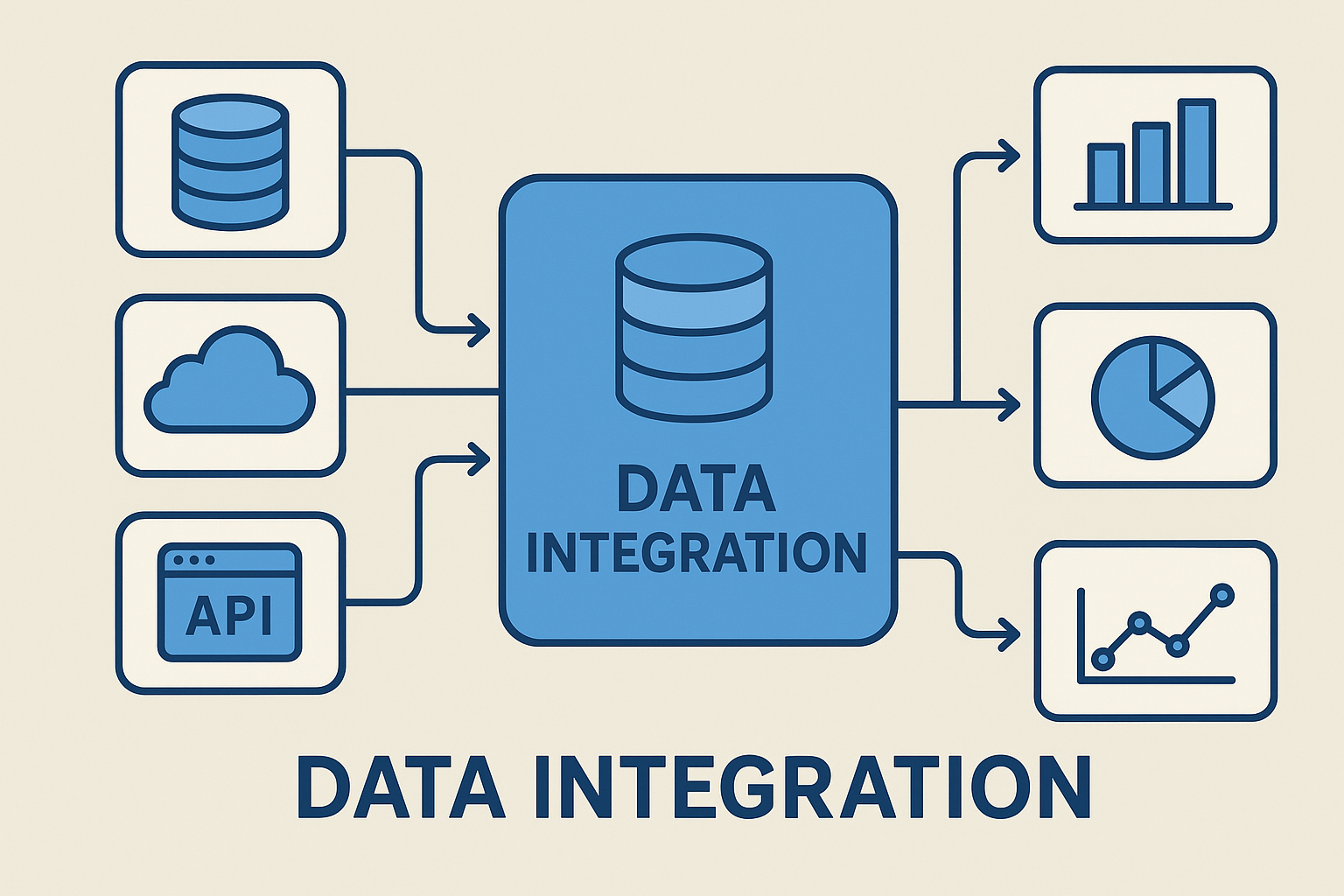

数据集成(Data Integration)是指将分布在不同来源、不同格式、不同结构的数据进行清洗、转换、统一和汇聚的过程。数据集成的目的是提供一个一致性高、可访问性强、质量可靠的数据视图,供企业进行决策分析和业务创新。

数据集成关键特征:

多源性:来自数据库、API、日志文件、IoT设备等多种渠道。

实时性:支持批处理(Batch)与流处理(Streaming)两类型数据传输的整合。

一致性:确保不同来源数据在口径与标准上保持统一。

可扩展性:能适应企业数据规模快速增长需求。

常见的数据集成方式:

ETL(抽取-转换-加载):传统的数据仓库方法, 相对要求有强大的数据转换能力。

ELT(抽取-加载-转换):通常见于云计算与大数据环境, 对于数据转换有高性能要求。

实时数据流集成:Kafka、Flink 等技术应用, 有流式数据分析需求,需要抽取流式数据。

简而言之,数据集成就是打通数据通道,让数据产出使用同一种语言。

二、数据集成对数据治理的影响?

数据治理强调对数据的标准化、合规性和价值实现,而数据集成正是其基础设施。

保障数据质量:数据集成在采集与处理过程中,会进行去重、清洗与标准化,从源头提升数据质量。

提升数据可用性:通过集成,不同系统的数据会集中到统一平台中,消除数据孤岛,让治理工作更顺畅。

增强数据合规与安全:数据治理需符合GDPR、数据安全法等规范。集成过程中内置审计与权限管理,确保数据流动合法合规。

支撑智能化决策:集成后的数据会提高质量,才能进一步用于BI分析、机器学习和AI预测,从而增强治理成效。

简言之,没有数据集成,就没有真正意义上的数据治理。

三、数据集成要做哪些事帮助数据治理?

统一数据命名规范, 如产品料号名称要叫 Item?还是 Part?

建立主数据管理, Master Data Management(MDM)

制定元数据 (Meta Data) 管理规则

数据清洗与质量控制:

去重、纠错、补全缺失值

数据一致性校验

自动化质量监控

数据安全与合规:

权限分级管理

数据加密与脱敏

数据使用日志审计

数据共享与开放:

建立统一的数据交换平台

提供API接口实现跨系统调用

构建数据服务化 DaaS(Data as a Service)模式

数据生命周期管理:

从采集、存储到销毁全流程可控

支持版本管理与历史追溯

数据集成不仅仅是“汇总数据”,更是“赋能数据治理”的重要引擎。

四、数据集成在数据治理会有哪些挑战?

数据来源复杂性:不同系统间存在格式差异、语义冲突,导致集成难度大。

数据质量难以保证:即使有自动清洗,仍可能出现脏数据、重复数据、缺失值。

实时与批处理的性能与需求平衡:企业需要既支持实时监控,又支持历史数据分析,这对架构设计提出挑战。

安全与隐私保护:跨系统数据共享增加了泄露风险,需要更严格的安全机制。

成本与技术门槛:高质量的数据集成平台需要投入大量人力、技术与资金。

因此,数据集成在支持推动治理同时,也需要企业不断迭代优化策略。

五、数据集成归纳总结

数据集成不仅是技术问题,更是企业战略的一部分。

数据治理的基石:没有集成,治理无法落地。

数据价值的放大器:让数据真正产生业务洞察与创新。

如何面临挑战:通过合适的工具与策略,可以有效解决。

未来,随着AI、云计算和大数据平台的不断发展,数据集成将更智能化、自动化,进一步助推数据治理的深化与升级。

六、常见问题解答(FAQs)

Q1: 数据集成与数据治理的关系是什么?

A1: 数据集成是数据治理的前提,治理依赖于完整、一致和可信的数据,这些都必须通过集成实现。

Q2: 企业为什么必须重视数据集成?

A2: 因为只有打通数据孤岛,企业才能实现跨部门协作、合规监管和智能决策。

Q3: 数据集成和ETL有什么区别?

A3: ETL是一种实现集成的方法,而数据集成是更大的概念,包含ETL、ELT、虚拟化和实时流处理等多种方法。

Q4: 数据集成如何保证数据安全?

A4: 通过加密、脱敏、权限管理与审计机制,确保数据在传输和存储过程中的安全合规。

Q5: 数据集成最大的挑战是什么?

A5: 数据源复杂性和数据质量问题最为突出,同时还需要平衡实时性与成本。

Q6: 未来数据集成的发展趋势是什么?

A6: 向智能化、自动化和云原生方向发展,更多依赖AI算法和大数据平台。