点一下关注吧!!!非常感谢!!持续更新!!!

🚀 AI篇持续更新中!(长期更新)

AI炼丹日志-31- 千呼万唤始出来 GPT-5 发布!“快的模型 + 深度思考模型 + 实时路由”,持续打造实用AI工具指南!📐🤖

💻 Java篇正式开启!(300篇)

目前2025年09月01日更新到:

Java-113 深入浅出 MySQL 扩容全攻略:触发条件、迁移方案与性能优化

MyBatis 已完结,Spring 已完结,Nginx已完结,Tomcat已完结,分布式服务正在更新!深入浅出助你打牢基础!

📊 大数据板块已完成多项干货更新(300篇):

包括 Hadoop、Hive、Kafka、Flink、ClickHouse、Elasticsearch 等二十余项核心组件,覆盖离线+实时数仓全栈!

大数据-278 Spark MLib - 基础介绍 机器学习算法 梯度提升树 GBDT案例 详解

数据库横向扩容方案详解

背景与需求

当业务进入高速增长期,系统用户量和数据量呈现指数级上升时,传统单一数据库架构很快就会遇到性能瓶颈。即使已经实施了分库分表策略,但随着时间推移,数据库容量和单表数据量仍会达到物理极限。此时,横向扩容(Scale-out)成为必要的解决方案。

扩容触发条件

- 容量指标:当磁盘使用率超过80%且预计3个月内将达到上限

- 性能指标:查询响应时间持续超过SLA阈值(如>500ms)

- 并发指标:活跃连接数长期维持在最大连接数的70%以上

- 监控报警:周期性出现CPU/IO饱和度报警

横向扩容实施步骤

1. 评估与规划阶段

- 进行容量评估,计算当前数据增长曲线

- 确定扩容比例(如增加50%节点数)

- 选择扩容策略:一致性哈希扩容或范围扩容

2. 数据迁移方案

方案A:在线迁移(推荐)

- 部署新节点并加入集群

- 配置数据同步机制(如MySQL的GTID复制)

- 分批迁移热点数据

- 切换流量验证

方案B:停机迁移

- 停止写入服务

- 全量备份现有数据

- 重新分配数据到新旧节点

- 恢复服务

3. 分片策略调整

- 重构分片键(Sharding Key)算法

- 更新路由配置(如MyCat/ShardingSphere配置)

- 测试数据均衡性

4. 应用层适配

- 更新数据源配置

- 调整连接池参数

- 修改可能受影响的SQL语句

常见挑战与解决方案

-

数据倾斜问题:

- 案例:某电商平台用户表按ID哈希分片,导致某些分片数据量是其他分片的3倍

- 解决方案:采用复合分片键(如ID+注册时间)

-

跨分片事务:

- 引入分布式事务框架(如Seata)

- 或采用最终一致性模式

-

扩容成本控制:

- 采用混部策略(SSD+HDD混合存储)

- 实施冷热数据分离

最佳实践案例

某社交平台在日活用户突破1000万时的扩容经验:

- 从8个分片扩容到12个分片

- 采用在线迁移方式,耗时72小时

- 迁移期间QPS下降控制在15%以内

- 扩容后TP99延迟从800ms降至300ms

监控与后续优化

扩容完成后需要:

- 建立容量预警机制(如每周增长报告)

- 配置自动扩缩容策略(基于K8s或云平台)

- 定期进行分片均衡检查

- 规划下一次扩容窗口

技术选型参考

- 关系型数据库:MySQL Cluster、PostgreSQL XL

- NoSQL:MongoDB分片集群、Cassandra

- 中间件:ShardingSphere、Vitess、MyCat

- 云服务:AWS Aurora、阿里云PolarDB

停机扩容

扩容方案详解

这是一种在数据库架构演进早期阶段常用的停机扩容方案,适用于数据库规模较小且能够接受短暂服务中断的场景。下面是完整的具体实施流程:

详细实施步骤

-

服务公告阶段

- 在扩容前3-5天,通过网站横幅、APP推送、短信等多渠道发布维护公告

- 公告示例:“为提升服务质量,我们将在2023年11月15日00:00-04:00进行系统升级,期间将暂停所有服务”

- 建议选择业务低峰期(如深夜)进行操作,最小化影响

-

服务停止阶段

- 在预定时间点,执行以下操作:

- 关闭负载均衡器流量入口

- 停止所有应用服务进程

- 断开与原有数据库的所有连接

- 确认措施:

- 通过监控系统验证所有外部请求已停止

- 检查数据库活动连接数为0

- 在预定时间点,执行以下操作:

-

数据迁移阶段

- 新数据库部署:

- 根据规划新增N个数据库实例(如从2个扩展到4个)

- 确保新实例配置(CPU/内存/存储)与原有实例一致

- 数据迁移程序:

- 编写特定迁移脚本(可使用Python/Go等语言)

- 示例分片规则变更:从

user_id % 2改为user_id % 4 - 迁移过程需包含数据校验机制,确保完整性

- 执行迁移:

- 先迁移基础数据(用户信息、配置表等)

- 再迁移业务数据(订单、交易记录等)

- 新数据库部署:

-

配置更新阶段

- 修改应用配置:

- 更新数据库连接池配置

- 调整分片路由逻辑

- 修改ORM框架设置

- 测试验证:

- 在测试环境验证新配置

- 执行基础功能测试用例

- 修改应用配置:

-

服务恢复阶段

- 按顺序启动:

- 先启动数据库服务

- 再启动应用服务

- 最后恢复负载均衡

- 监控观察:

- 密切监控系统指标15-30分钟

- 验证核心业务流程

- 按顺序启动:

回滚方案

-

回滚触发条件

- 数据迁移失败(如完整性校验不通过)

- 新配置导致服务异常

- 性能指标超出阈值(如CPU使用率>90%持续10分钟)

-

具体回滚步骤

- 立即停止所有新启动的服务

- 恢复原有数据库配置:

- 回退分片规则

- 还原连接池设置

- 数据回退:

- 使用备份恢复原数据库

- 验证数据一致性

- 服务恢复:

- 按照原架构重新启动服务

- 后续计划:

- 分析失败原因

- 重新评估扩容方案

- 择日重新发布公告

方案优缺点

优势:

- 实施简单直接,技术难度低

- 不需要复杂的数据同步机制

- 一次性完成架构调整

局限:

- 必须停机操作,影响业务连续性

- 随着数据量增长,迁移时间会显著增加

- 不适合7×24小时高可用要求的业务

典型应用场景

- 初创企业早期数据库扩展

- 内部管理系统升级

- 能接受定时维护的ToB服务

- 数据量在TB级别以下的迁移

注意事项

- 必须提前做好完整备份

- 建议准备详细的checklist

- 关键操作需要双人复核

- 预留充足缓冲时间(建议实际用时的2倍)

- 准备应急联络机制

此方案虽然简单,但在特定场景下仍然是最可靠的选择,特别是在没有专业DBA团队的中小型企业环境中。随着业务发展,建议逐步过渡到更高级的在线扩容方案。

停机优点

简单易用!

停机缺点

● 停止服务,缺乏高可用

● 程序员压力大,需要在规定的时间内完成

● 如果问题没有及时测试出来就启动了,后续发现有问题则会比较麻烦

适用场景

● 小型网站

● 大部分游戏

● 对高可用要求不高的服务

平滑扩容

扩容方案

数据库扩容是系统规模扩展过程中的关键环节,为确保业务连续性,平滑扩容是最优选择。平滑扩容的核心思想是采用渐进式倍增策略,通过分阶段操作将数据库数量逐步增加,同时保持服务不中断。以下是具体的扩容实施步骤:

方案概述

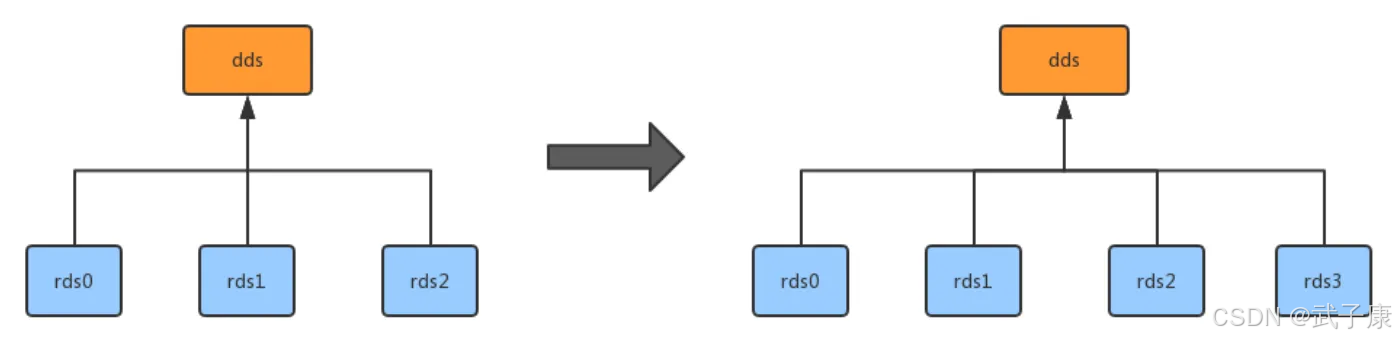

- 扩容比例:采用2倍扩容策略(如从2个DB节点扩展至4个节点)

- 技术要求:依赖双主复制机制实现数据同步

- 实施阶段:分测试验证和生产上线两个主要阶段

详细实施步骤

第一阶段:基础设施准备

-

资源规划:

- 根据当前数据库规格(如CPU/内存/存储配置)申请相同规格的新节点

- 网络配置需确保新节点与原有集群处于同一VPC和安全组

- 示例:原2节点配置为16核64G,新节点需保持相同规格

-

环境初始化:

- 安装相同版本的数据库软件(如MySQL 8.0.28)

- 配置文件需保持与现有集群一致的参数(如字符集、缓冲池大小等)

第二阶段:测试环境验证

-

搭建测试集群:

- 使用1个原节点+1个新节点建立双主复制

- 配置复制账号并验证双向同步(

SHOW SLAVE STATUS)

-

数据校验:

- 通过pt-table-checksum工具校验数据一致性

- 模拟业务流量(如使用sysbench)测试同步延迟

-

故障演练:

- 主动触发网络分区,验证自动恢复机制

- 测试主备切换流程(如通过VIP漂移或中间件切换)

第三阶段:生产环境上线

-

滚动部署:

- 凌晨低峰期逐个添加新节点(先添加DB3,再添加DB4)

- 每次添加后观察监控指标(QPS/连接数/延迟)

-

数据迁移:

- 对于存量数据,使用mysqldump+GTID方式初始化

- 增量数据通过binlog实时同步(需确保

log_slave_updates开启)

-

流量切换:

- 配置中间件(如ProxySQL)逐步将读流量迁移至新节点

- 使用影子表验证业务兼容性后切换写流量

第四阶段:后续维护

-

监控强化:

- 部署Prometheus监控各节点复制延迟

- 设置Alertmanager对异常同步状态告警

-

性能优化:

- 根据负载情况调整线程池参数

- 定期执行

OPTIMIZE TABLE维护新节点

注意事项

- 必须确保原集群有足够的磁盘空间支撑同步期间的binlog增长

- 建议提前准备回滚方案(如删除新节点并重建复制)

- 跨机房部署时需评估网络带宽对同步延迟的影响

通过这种分阶段、可验证的扩容方式,能够在保证服务可用性的同时,实现存储容量和吞吐量的线性扩展。该方案已在电商大促、金融结算等多个高并发场景中得到验证,平均扩容耗时约4-6小时(取决于数据量大小)。

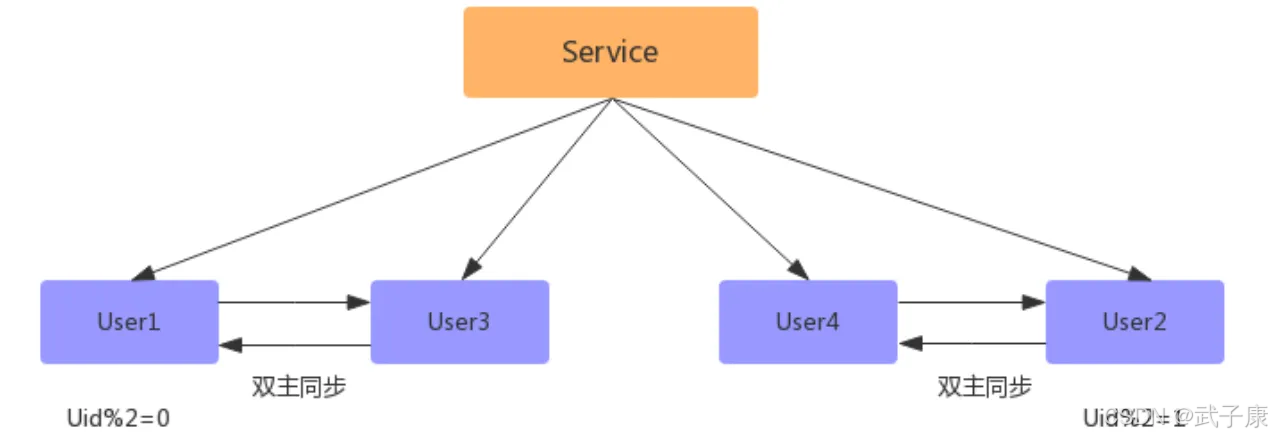

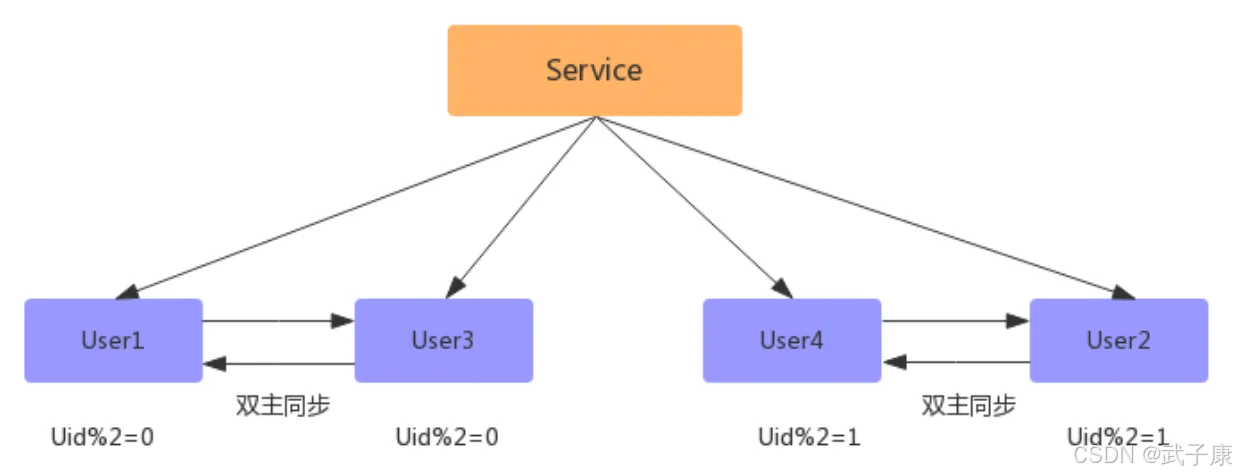

数据同步完成之后,配置双主双写(同步因为数据有延迟,如果时时刻刻都有写和更新操作,会存在不准确的问题)

数据同步完成之后,删除双主同步,修改数据库配置,并重启:

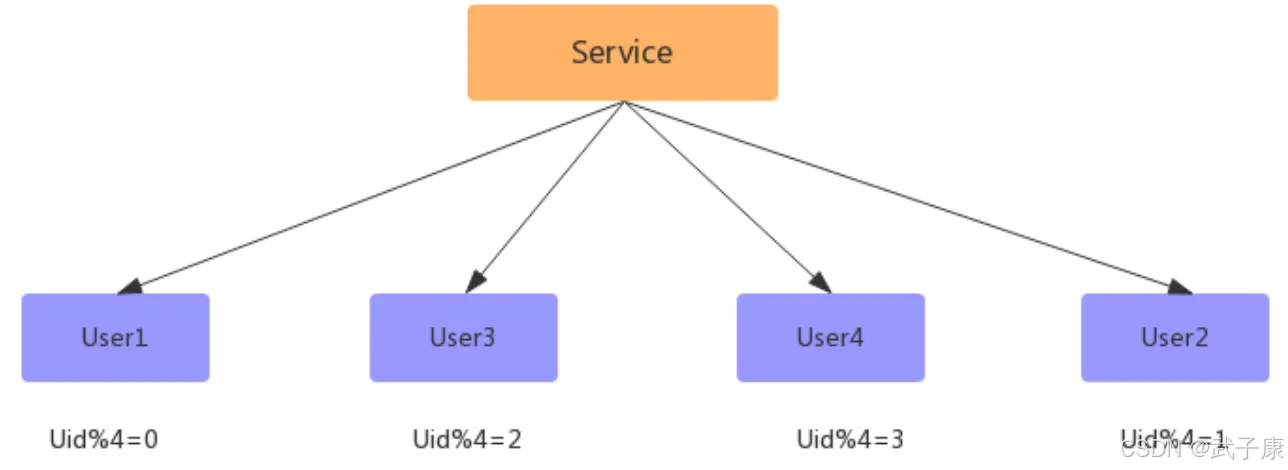

此时已经完成了扩容,但此时的数据没有减少,新增的数据和就得数据库一样多的数据,此时还需要写一个程序,清空数据库中多余的数据,比如:

● User1 去除 uid%4 = 2 的数据

● User3 去除 uid%4 = 0 的数据

● User2 去除 uid%4 = 3 的数据

● User4 去除 uid%4 = 1 的数据

平滑扩容方案能够实现N库扩展2N库的平滑扩容,增加数据库服务能力,降低单库一半的数据量,其核心原理是:成倍扩容,避免数据迁移。

平滑扩容的优点

-

业务连续性保障

- 扩容过程中服务持续可用,确保终端用户无感知

- 适用于7×24小时运营的关键业务系统

- 示例:电商平台在大促期间可保持正常交易

-

团队压力缓解

- 相比停机扩容,时间窗口更宽松(通常可延长至数周)

- 允许分阶段执行,单个步骤失败可回滚

- 每个阶段完成后可进行充分验证

-

风险控制优势

- 实时监控各环节状态,发现问题立即处理

- 支持"灰度"式扩容,先迁移部分数据验证

- 紧急情况下可暂停扩容流程

-

性能优化效果

- 单库数据量减少50%带来显著性能提升:

- 查询响应时间缩短30-50%

- 索引效率提高

- 备份恢复时间大幅减少

- 支持更精细的资源分配策略

- 单库数据量减少50%带来显著性能提升:

-

扩展性增强

- 为后续扩容建立标准化流程

- 积累的运维经验可复用

- 形成可扩展的架构基础

实施建议:

- 建议选择业务低峰期启动

- 每次迁移数据量控制在总量的5-10%

- 建立完善的监控告警机制

- 提前准备回滚方案

平滑缺点

1. 程序复杂度高

- 双主同步配置:需要设置数据库主从复制机制,确保两个主库之间的数据实时同步。例如MySQL的

master-master复制需要配置server-id、log-bin等参数,并处理可能出现的冲突问题。 - 双主双写实现:应用层需要支持双写逻辑,包括:

- 写操作路由(如通过分片键决定写入哪个主库)

- 冲突检测(如时间戳或版本号机制)

- 失败回滚(当一主库写入失败时需撤销另一主库的变更)

- 同步状态监控:需部署额外组件(如ZooKeeper)检测主库间同步延迟,并设置阈值告警。例如:当同步延迟超过5秒时触发切换逻辑。

2. 扩容成本高

- 横向扩展困难:若从双主扩展到三主或更多节点,需重新设计数据分片策略(如一致性哈希),且可能引发数据迁移问题。例如:增减节点时需重新平衡10TB数据的分布。

- 运维成本激增:每增加一个主库会带来:

- 同步链路数呈平方级增长(如4主库需维护6条双向同步链路)

- 硬件成本上升(需保证所有主库的SSD存储和万兆网络)

- 监控复杂度提升(需跟踪N×(N-1)条同步通道的状态)

- 典型场景限制:在物联网或用户日志场景下,若设备/用户ID分散在100个主库中,跨库查询(如统计全平台数据)需依赖额外的大数据聚合系统。

适用场景

● 大型网站

● 对高可用要求高的服务

)

)