Neural Architecture Search(NAS)

- 一个神经网络有不同类型的超参数

拓扑结构:resnet,mobilenet

单独层:核大小,卷积层的通道,输出隐藏单元的个数 - NAS自动设计神经网络

如何设计搜索空间

如何探索搜索空间

性能评估

one-shot 方法

- 将学习架构核模型参数联系在一起学习

- 构建训练一个单独的模型来表现一系列广泛的模型

- 评价候选结构

只关心候选排名

用一个近似的指标:几个轮次之后的准确度 - 重新训练最好的候选模型

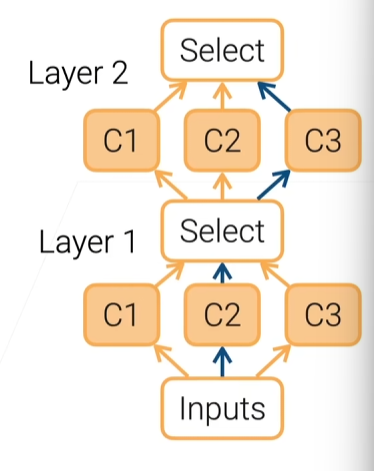

可微的架构搜索(Differentiable Architecture Search)

- 将子路类别选择给softmax执行

1、每一层有多个候选

2、在l层第i个候选的输出是oilo^l_ioil

3、学习一个混合权重ala^lal,第i+1层的输入是∑iαiloil\displaystyle\sum_{\substack i}\alpha^l_io^l_ii∑αiloil,其中αl=softmax(al)\alpha^l=softmax(a^l)αl=softmax(al)

4、选择候选argmaxiαiargmax_i\alpha_iargmaxiαi

5、将学习的ala^lal加入网络参数

Scaling CNNs

- 一个CNN能有3种方法调节

1、更深:更多层

2、更宽:更多输出通道

3、更大的输出:增加输入图像的分辨率 - EfficientNet建议一个混合的scaling

1、深度规模每次变换αϕ\alpha^\phiαϕ,宽度变换βϕ\beta^\phiβϕ,分辨率变换γϕ\gamma^\phiγϕ

2、αβ2γ2≈2\alpha\beta^2\gamma^2\approx2αβ2γ2≈2,若ϕ=1\phi=1ϕ=1,则把计算复杂度(FLOP)翻了一倍

3、可调参数α,β,γ,ϕ\alpha,\beta,\gamma,\phiα,β,γ,ϕ

研究方向

- NAS结果的可解释性

- 适合边缘设备(如手机)的搜索结构

- 到哪种程度我们能实现整个机器学习的自动化

------休眠函数sleep_for和sleep_until)

:计数排序)

;初识类的默认成员函数)

)

![【AI开发】【前后端全栈】[特殊字符] AI 时代的快速开发思维](http://pic.xiahunao.cn/【AI开发】【前后端全栈】[特殊字符] AI 时代的快速开发思维)

—PyTorch使用—张量的创建和类型转换】)