【终极指南】吃透机器学习环境配置:从Conda、CUDA到Docker容器化

大家好!在机器学习的旅程中,一个稳定、可复现的环境是成功的基石。

第一部分:核心理念——为何环境配置如此重要?

任何机器学习模型的运行,都离不开一个精确配置的环境 。一个好的环境配置实践,能为您带来以下核心优势:

-

隔离性:确保不同项目间的依赖库互不干扰,避免版本冲突 。

-

可复现性:让您的代码在任何机器上都能得到相同的结果,这在学术研究和工业生产中至关重要 。

-

易于迁移:方便地将整个工作环境打包、迁移,实现快速部署 。

第二部分:入门必备——包管理工具 (Conda & Pipenv)

包管理工具是环境配置的第一步,它们帮助我们创建独立的虚拟环境并管理项目所需的各种软件包。

1. Conda

Conda是一个开源、跨平台的包和环境管理系统,功能强大且社区支持广泛 。

-

创建环境:

conda create -n test_env -

安装包 (以PyTorch为例):

conda install -n test_env pytorch torchvision torchaudio cudatoolkit=11.3 -c pytorch -

激活与退出:

conda activate test_env和conda deactivate

2. Pipenv

Pipenv旨在将

pip(包安装)和virtualenv(虚拟环境)的功能合二为一,让依赖管理更自动化 。

-

安装包:

pipenv install numpy torch -

激活与退出:

pipenv shell和Ctrl + D

第三部分:进阶核心——深入理解GPU、驱动与CUDA

仅仅安装好软件包是不够的,要让代码在GPU上跑起来,我们必须理解硬件、驱动和CUDA之间的关系。

Q1:NVIDIA驱动和CUDA有什么区别?

这是一个非常关键的问题。简单来说,驱动是基础,CUDA是建立在该基础之上的应用开发平台。

-

NVIDIA驱动 (NVIDIA Driver):它是连接操作系统和GPU硬件的“桥梁” 。没有驱动,您的电脑根本无法识别GPU 。驱动程序本身包含一个版本的CUDA API,称为

驱动CUDA版本 (Driver CUDA Version),您可以通过在终端运行

nvidia-smi命令查看。这个版本代表了该驱动最高能够支持的CUDA功能 。 -

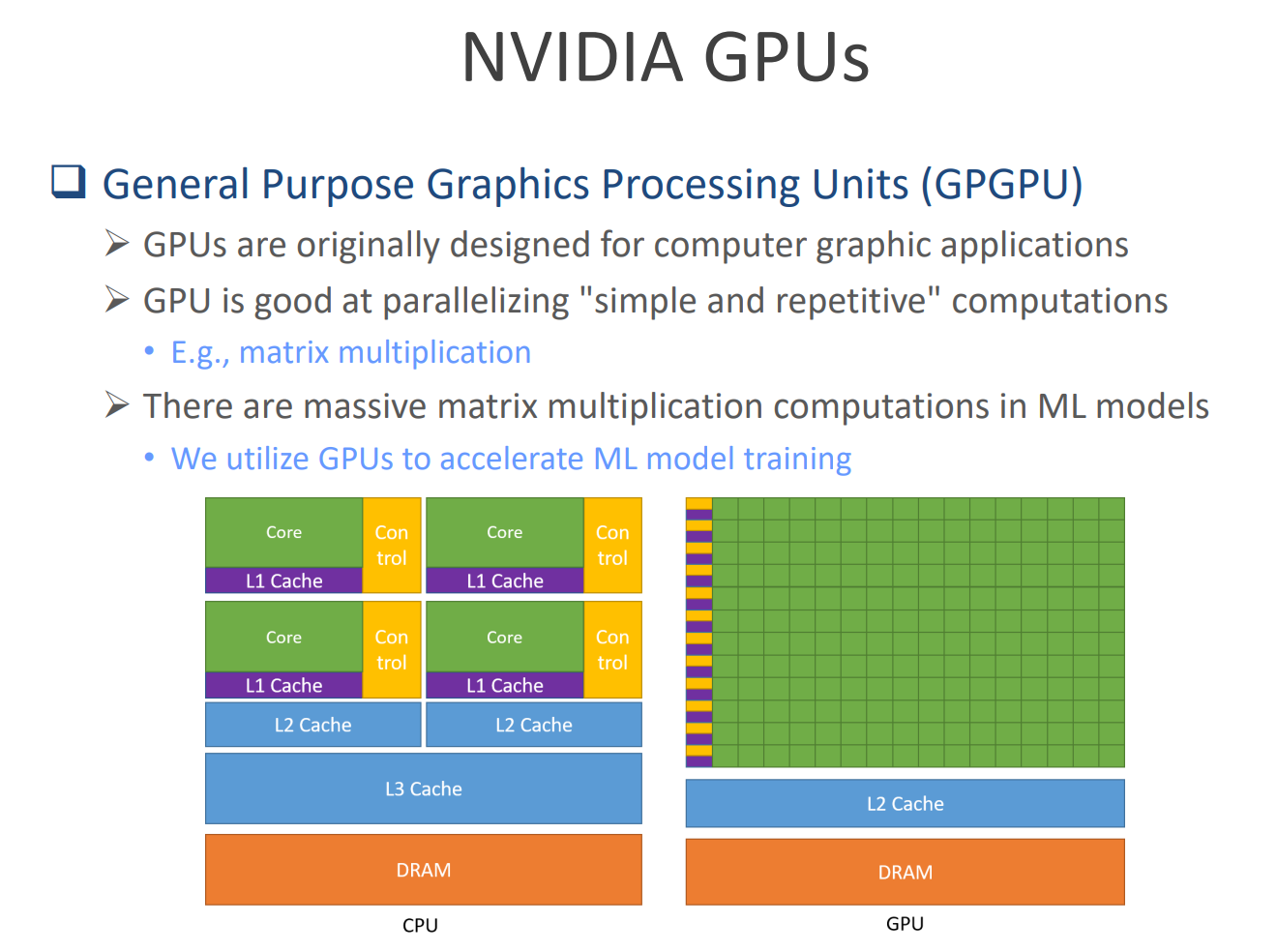

CUDA运行时 (CUDA Runtime):当我们说“为PyTorch安装CUDA”时,通常指的是安装CUDA运行时 。它是一个并行的计算平台和编程接口(API),允许像PyTorch这样的框架利用GPU强大的并行计算能力(如矩阵运算)来加速模型训练 。

最重要的兼容性法则:驱动的CUDA版本必须大于或等于运行时的CUDA版本 。例如,如果

nvidia-smi显示CUDA版本是11.6,那么您为项目安装的运行时CUDA版本(如11.3)不能超过11.6 。

第四部分:高手之路——拥抱容器化 (Docker)

当环境变得异常复杂时(例如,需要在最新的GPU上运行依赖旧版CUDA的旧项目),容器化技术就成了我们的终极武器。

Q2:虚拟机和容器有什么区别?我应该用哪个?

-

虚拟机 (Virtual Machine, VM):它虚拟化了整个操作系统 。就像在Windows上安装一个软件,运行一个完整的Linux系统。这使得它非常“重”,但隔离性极强 。

-

容器 (Container):它运行在同一个主机操作系统之上,共享系统内核 。它虚拟的不是操作系统,而是

应用程序及其所有依赖项的运行环境。这使得容器非常“轻量”,启动极快 。

对于机器学习开发,容器通常是更好的选择,因为它在提供了足够隔离性的同时,性能开销更小。

Q3:为什么要使用容器?它解决了什么问题?

使用容器的核心原因是为了解决环境的复杂性、可移植性和兼容性难题。

-

处理复杂依赖:当您需要特定版本的库(如cuDNN、NCCL)来进行分布式训练时,容器可以将这一切完美打包 。

-

解决兼容性噩梦:您可以在容器里打包旧版的PyTorch和它依赖的旧版CUDA,然后在安装了最新驱动和GPU的机器上无缝运行 。

-

行业标准:无论是工业界的Kubernetes还是学术界的Slurm,都广泛采用容器作为应用部署的标准单元 。

Q4:为什么文件推荐使用NVIDIA自己的容器?

因为标准的Docker容器无法很好地适配GPU。如果在普通容器里使用GPU,会要求容器内的驱动版本必须和主机的驱动版本

完全一致,这极大地破坏了容器的“可移植性” 。

NVIDIA Docker是完美的解决方案 。

-

核心优势:您无需在容器内安装任何NVIDIA驱动 。NVIDIA Docker会自动将主机的驱动和GPU设备安全地映射到容器中。

-

带来的好处:这让在容器中使用GPU变得极其简单,并且让您的容器镜像具有了真正的可移植性,可以在任何安装了NVIDIA Docker的机器上运行 。

使用NVIDIA Docker的流程:

-

在主机上安装好NVIDIA驱动和NVIDIA Docker 。

-

从Docker Hub拉取官方预构建的镜像 (如

docker pull pytorch/pytorch:1.9.1-cuda11.1-cudnn8-runtime) 。 -

使用

--gpus all参数启动容器,即可在容器内访问GPU 。

最终总结

-

驱动先行:无论采用何种方案,必须在主机上正确安装NVIDIA驱动 。

-

版本兼容:牢记,运行时的CUDA版本不能高于驱动支持的CUDA版本 。

-

拥抱容器:对于复杂的GPU环境,强烈推荐使用NVIDIA Docker。它能为您免去无数环境配置的烦恼,让您专注于算法和模型本身。

什么意思?有什么用?bmpData.Scan0;什么意思?有什么用?)

)

:自定义实现一个自增的StatefulWidget组件)

![[AI8051U入门第十三步]W5500实现MQTT通信](http://pic.xiahunao.cn/[AI8051U入门第十三步]W5500实现MQTT通信)

![linux81 shell通配符:[list],‘‘ ``““](http://pic.xiahunao.cn/linux81 shell通配符:[list],‘‘ ``““)