@浙大疏锦行

知识点回顾:

- 彩色和灰度图片测试和训练的规范写法:封装在函数中

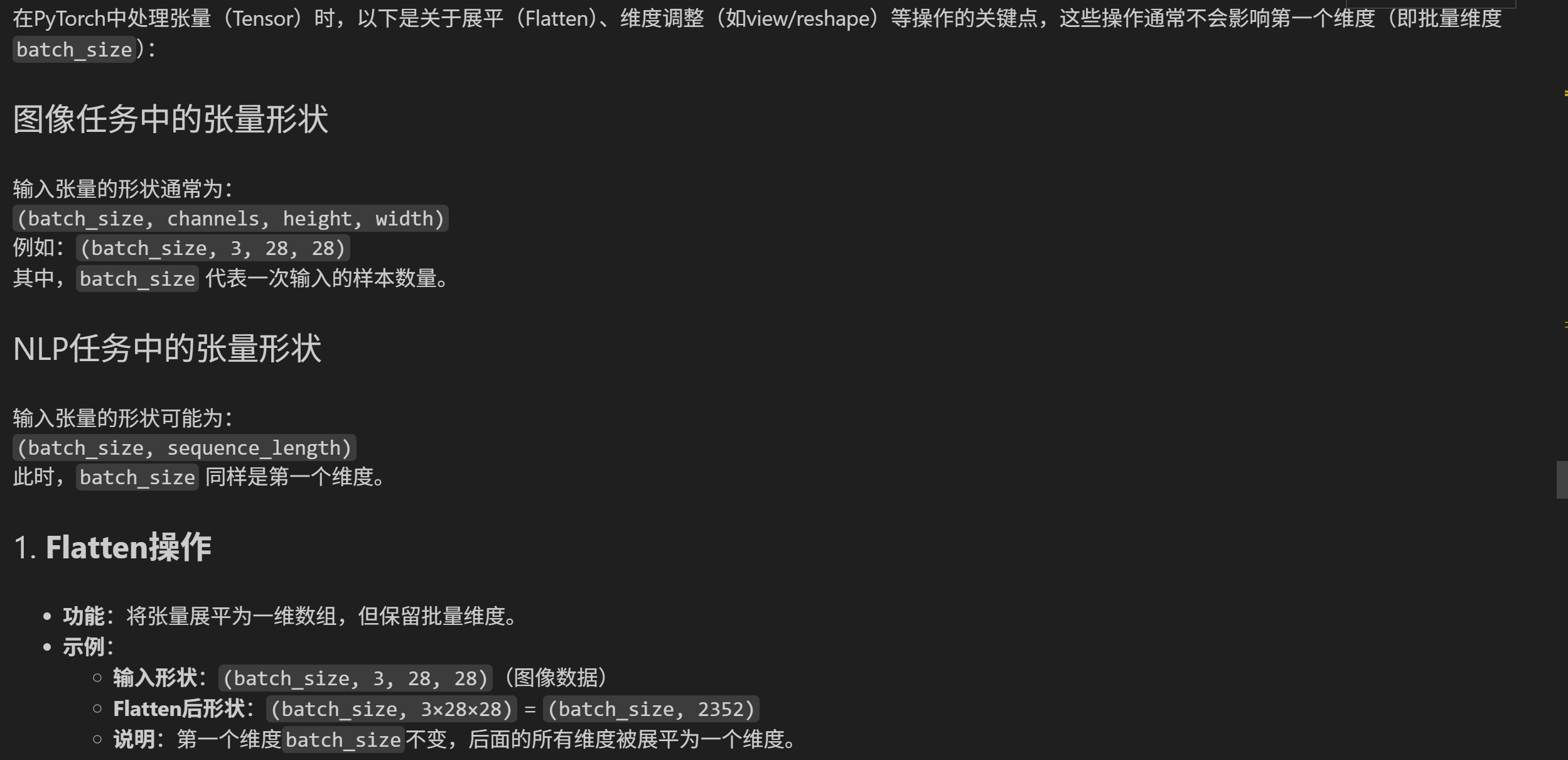

- 展平操作:除第一个维度batchsize外全部展平

- dropout操作:训练阶段随机丢弃神经元,测试阶段eval模式关闭dropout

作业:仔细学习下测试和训练代码的逻辑,这是基础,这个代码框架后续会一直沿用,后续的重点慢慢就是转向模型定义阶段了。

一.知识点学习

DAY 40

昨天我们介绍了图像数据的格式以及模型定义的过程,发现和之前结构化数据的略有不同,主要差异体现在2处

1. 模型定义的时候需要展平图像

2. 由于数据过大,需要将数据集进行分批次处理,这往往涉及到了dataset和dataloader来规范代码的组织

现在我们把注意力放在训练和测试代码的规范写法上。

# 先继续之前的代码

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import DataLoader , Dataset # DataLoader 是 PyTorch 中用于加载数据的工具

from torchvision import datasets, transforms # torchvision 是一个用于计算机视觉的库,datasets 和 transforms 是其中的模块

import matplotlib.pyplot as plt

import warnings

# 忽略警告信息

warnings.filterwarnings("ignore")

# 设置随机种子,确保结果可复现

torch.manual_seed(42)

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

print(f"使用设备: {device}")

# 1. 数据预处理

transform = transforms.Compose([transforms.ToTensor(), # 转换为张量并归一化到[0,1]transforms.Normalize((0.1307,), (0.3081,)) # MNIST数据集的均值和标准差

])# 2. 加载MNIST数据集

train_dataset = datasets.MNIST(root=r'E:\60天打卡训练营-DL\minst/data',train=True,download=False,transform=transform

)test_dataset = datasets.MNIST(root=r'E:\60天打卡训练营-DL\minst/data',train=False,transform=transform

)# 3. 创建数据加载器

batch_size = 64 # 每批处理64个样本

train_loader = DataLoader(train_dataset, batch_size=batch_size, shuffle=True)

test_loader = DataLoader(test_dataset, batch_size=batch_size, shuffle=False)# 4. 定义模型、损失函数和优化器

class MLP(nn.Module):def __init__(self):super(MLP, self).__init__()self.flatten = nn.Flatten() # 将28x28的图像展平为784维向量self.layer1 = nn.Linear(784, 128) # 第一层:784个输入,128个神经元self.relu = nn.ReLU() # 激活函数self.layer2 = nn.Linear(128, 10) # 第二层:128个输入,10个输出(对应10个数字类别)def forward(self, x):x = self.flatten(x) # 展平图像x = self.layer1(x) # 第一层线性变换x = self.relu(x) # 应用ReLU激活函数x = self.layer2(x) # 第二层线性变换,输出logitsreturn x# 初始化模型

model = MLP()

model = model.to(device) # 将模型移至GPU(如果可用)# from torchsummary import summary # 导入torchsummary库

# print("\n模型结构信息:")

# summary(model, input_size=(1, 28, 28)) # 输入尺寸为MNIST图像尺寸criterion = nn.CrossEntropyLoss() # 交叉熵损失函数,适用于多分类问题

optimizer = optim.Adam(model.parameters(), lr=0.001) # Adam优化器# 5. 训练模型(记录每个 iteration 的损失)

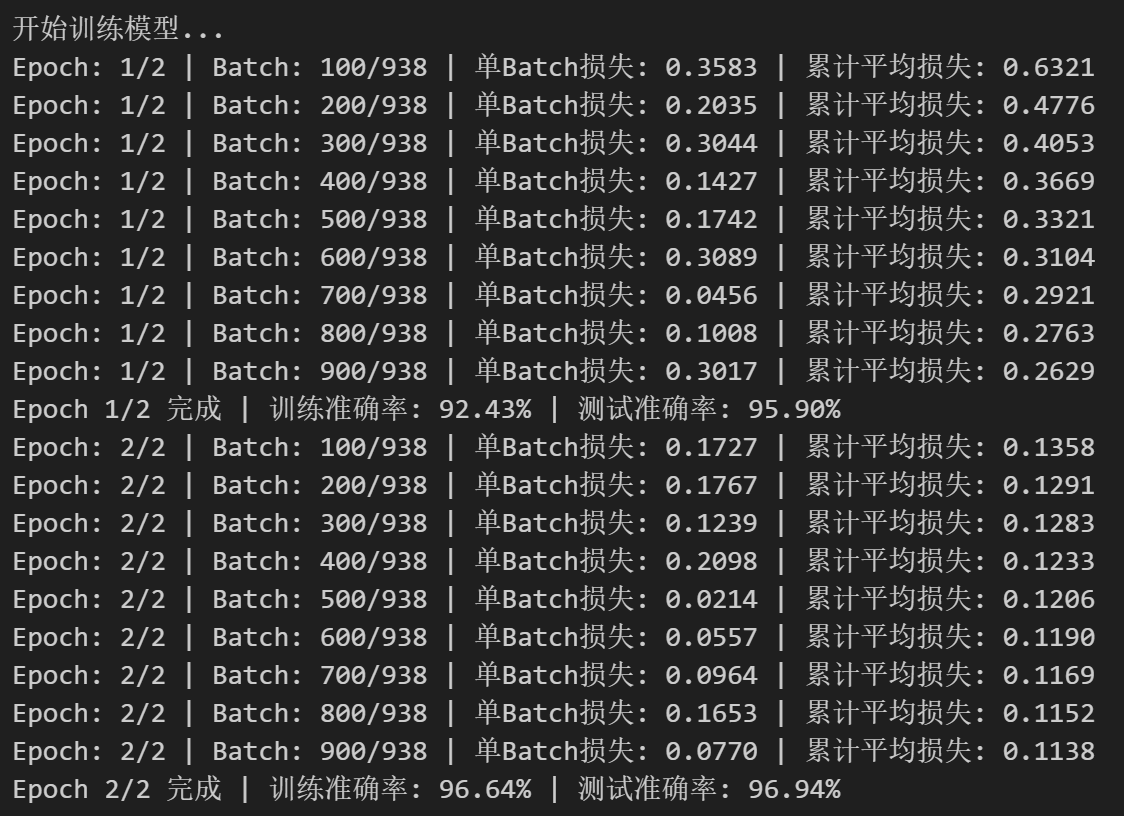

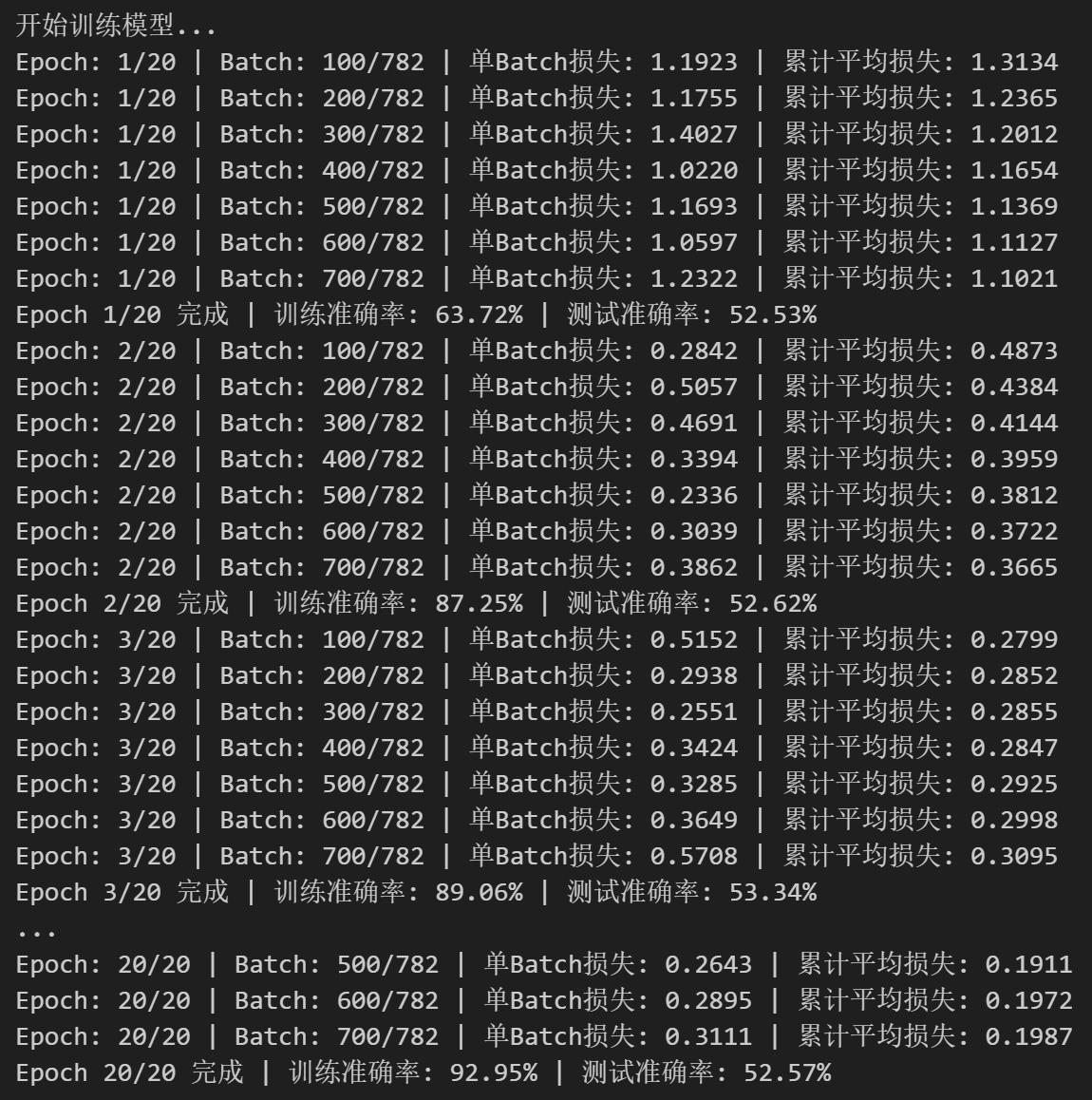

def train(model, train_loader, test_loader, criterion, optimizer, device, epochs):model.train() # 设置为训练模式# 新增:记录每个 iteration 的损失all_iter_losses = [] # 存储所有 batch 的损失iter_indices = [] # 存储 iteration 序号(从1开始)for epoch in range(0,epochs):running_loss = 0.0correct = 0total = 0for batch_idx, (data, target) in enumerate(train_loader):# batch_idx可不是普通的图片索引,而是一个batch的索引对不对# enumerate() 是 Python 内置函数,用于遍历可迭代对象(如列表、元组)并同时获取索引和值。# batch_idx:当前批次的索引(从 0 开始)# (data, target):当前批次的样本数据和对应的标签,是一个元组,这是因为dataloader内置的getitem方法返回的是一个元组,包含数据和标签。# 只需要记住这种固定写法即可data, target = data.to(device), target.to(device) # 移至GPU(如果可用)optimizer.zero_grad() # 每一个我批次都要清0,梯度清零output = model(data) # 前向传播loss = criterion(output, target) # 计算损失loss.backward() # 反向传播optimizer.step() # 更新参数# 记录当前 iteration 的损失(注意:这里直接使用单 batch 损失,而非累加平均)iter_loss = loss.item()all_iter_losses.append(iter_loss)iter_indices.append(epoch * len(train_loader) + batch_idx + 1) # iteration 序号从1开始。为什么要加1,是因为batch_idx从0开始# 统计准确率和损失running_loss += loss.item() #将loss转化为标量值并且累加到running_loss中,计算总损失。“把这个轮次(比如第三轮)的所有每一批次的所有损失加起来”_, predicted = output.max(1) # output:是模型的输出(logits),形状为 [batch_size, 10](MNIST 有 10 个类别)。从当前批次的模型输出中,为每个样本选出得分最高的类别作为预测结果。是一个批次中每个样本哦。# 获取预测结果,max(1) 返回每行(即每个样本)的最大值和对应的索引,这里我们只需要索引total += target.size(0) # target.size(0) 返回当前批次的样本数量,即 batch_size,累加所有批次的样本数,最终等于训练集的总样本数correct += predicted.eq(target).sum().item() # 返回一个布尔张量,表示预测是否正确,sum() 计算正确预测的数量,item() 将结果转换为 Python 数字# 每100个批次打印一次训练信息(可选:同时打印单 batch 损失)if (batch_idx + 1) % 100 == 0:print(f'Epoch: {epoch+1}/{epochs} | Batch: {batch_idx+1}/{len(train_loader)} 'f'| 单Batch损失: {iter_loss:.4f} | 累计平均损失: {running_loss/(batch_idx+1):.4f}')# 我的理解就是,比如当前是第1轮,当前损失总和去除以当前处理好的批次# 测试、打印 epoch 结果epoch_train_loss = running_loss / len(train_loader)#计算当前 epoch 训练集的每个批次平均损失。epoch_train_acc = 100. * correct / total# 计算当前 epoch 训练集的准确率(百分比)epoch_test_loss, epoch_test_acc = test(model, test_loader, criterion, device)# 别慌看下一段代码print(f'Epoch {epoch+1}/{epochs} 完成 | 训练准确率: {epoch_train_acc:.2f}% | 测试准确率: {epoch_test_acc:.2f}%')# 绘制所有 iteration 的损失曲线plot_iter_losses(all_iter_losses, iter_indices)# 保留原 epoch 级曲线(可选)# plot_metrics(train_losses, test_losses, train_accuracies, test_accuracies, epochs)return epoch_test_acc # 返回最终测试准确率之前我们用mlp训练鸢尾花数据集的时候并没有用函数的形式来封装训练和测试过程,这样写会让代码更加具有逻辑-----隔离参数和内容。

1. 后续直接修改参数就行,不需要去找到对应操作的代码

2. 方便复用,未来有多模型对比时,就可以复用这个函数

这里我们先不写早停策略,因为规范的早停策略需要用到验证集,一般还需要划分测试集

1. 划分数据集:训练集(用于训练)、验证集(用于早停和调参)、测试集(用于最终报告性能)。

2. 在训练过程中,使用验证集触发早停。

3. 训练结束后,仅用测试集运行一次测试函数,得到最终准确率。

测试函数和绘图函数均被封装在了train函数中,但是test和绘图函数在定义train函数之后,这是因为在 Python 中,函数定义的顺序不影响调用,只要在调用前已经完成定义即可。

# 6. 测试模型(不变)

def test(model, test_loader, criterion, device):model.eval() # 设置为评估模式test_loss = 0correct = 0total = 0with torch.no_grad(): # 不计算梯度,节省内存和计算资源for data, target in test_loader:data, target = data.to(device), target.to(device)output = model(data)test_loss += criterion(output, target).item()_, predicted = output.max(1)total += target.size(0)correct += predicted.eq(target).sum().item()avg_loss = test_loss / len(test_loader)accuracy = 100. * correct / totalreturn avg_loss, accuracy # 返回损失和准确率如果打印每一个batchsize的损失和准确率,会看的更加清晰,更加直观

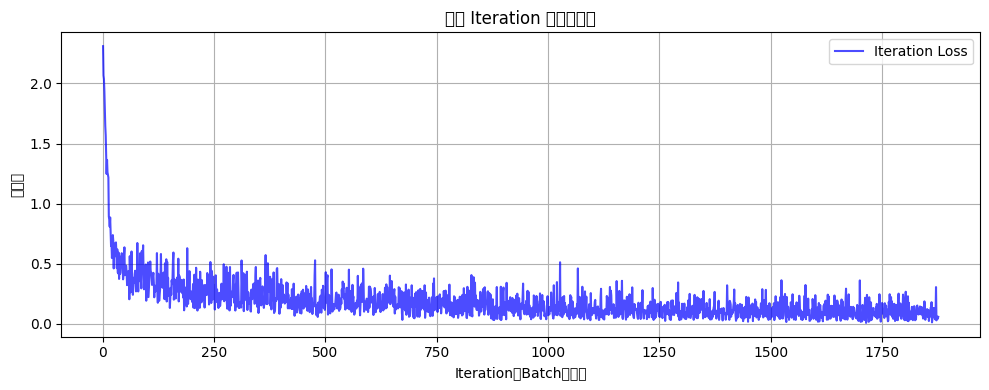

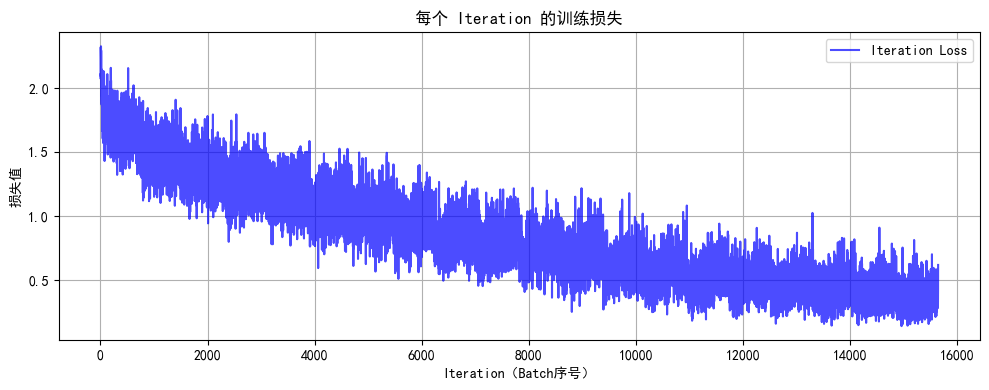

# 7. 绘制每个 iteration 的损失曲线

def plot_iter_losses(losses, indices):plt.figure(figsize=(10, 4))plt.plot(indices, losses, 'b-', alpha=0.7, label='Iteration Loss')plt.xlabel('Iteration(Batch序号)')plt.ylabel('损失值')plt.title('每个 Iteration 的训练损失')plt.legend()plt.grid(True)plt.tight_layout()plt.show()# 8. 执行训练和测试(设置 epochs=2 验证效果)

epochs = 2

print("开始训练模型...")

final_accuracy = train(model, train_loader, test_loader, criterion, optimizer, device, epochs)

print(f"训练完成!最终测试准确率: {final_accuracy:.2f}%")

# import torch

# import torch.nn as nn

# import torch.optim as optim

# from torchvision import datasets, transforms

# from torch.utils.data import DataLoader

# import matplotlib.pyplot as plt

# import numpy as np# # 设置中文字体支持

# plt.rcParams["font.family"] = ["SimHei"]

# plt.rcParams['axes.unicode_minus'] = False # 解决负号显示问题# # 1. 数据预处理

# transform = transforms.Compose([

# transforms.ToTensor(), # 转换为张量并归一化到[0,1]

# transforms.Normalize((0.1307,), (0.3081,)) # MNIST数据集的均值和标准差

# ])# # 2. 加载MNIST数据集

# train_dataset = datasets.MNIST(

# root='./data',

# train=True,

# download=True,

# transform=transform

# )# test_dataset = datasets.MNIST(

# root='./data',

# train=False,

# transform=transform

# )# # 3. 创建数据加载器

# batch_size = 64 # 每批处理64个样本

# train_loader = DataLoader(train_dataset, batch_size=batch_size, shuffle=True)

# test_loader = DataLoader(test_dataset, batch_size=batch_size, shuffle=False)# # 4. 定义模型、损失函数和优化器

# class MLP(nn.Module):

# def __init__(self):

# super(MLP, self).__init__()

# self.flatten = nn.Flatten() # 将28x28的图像展平为784维向量

# self.layer1 = nn.Linear(784, 128) # 第一层:784个输入,128个神经元

# self.relu = nn.ReLU() # 激活函数

# self.layer2 = nn.Linear(128, 10) # 第二层:128个输入,10个输出(对应10个数字类别)# def forward(self, x):

# x = self.flatten(x) # 展平图像

# x = self.layer1(x) # 第一层线性变换

# x = self.relu(x) # 应用ReLU激活函数

# x = self.layer2(x) # 第二层线性变换,输出logits

# return x# # 检查GPU是否可用

# device = torch.device("cuda" if torch.cuda.is_available() else "cpu")# # 初始化模型

# model = MLP()

# model = model.to(device) # 将模型移至GPU(如果可用)# criterion = nn.CrossEntropyLoss() # 交叉熵损失函数,适用于多分类问题

# optimizer = optim.Adam(model.parameters(), lr=0.001) # Adam优化器# # 5. 训练模型(记录每个 iteration 的损失)

# def train(model, train_loader, test_loader, criterion, optimizer, device, epochs):

# model.train() # 设置为训练模式# # 新增:记录每个 iteration 的损失

# all_iter_losses = [] # 存储所有 batch 的损失

# iter_indices = [] # 存储 iteration 序号(从1开始)# for epoch in range(epochs):

# running_loss = 0.0

# correct = 0

# total = 0# for batch_idx, (data, target) in enumerate(train_loader):

# data, target = data.to(device), target.to(device) # 移至GPU(如果可用)# optimizer.zero_grad() # 梯度清零

# output = model(data) # 前向传播

# loss = criterion(output, target) # 计算损失

# loss.backward() # 反向传播

# optimizer.step() # 更新参数# # 记录当前 iteration 的损失(注意:这里直接使用单 batch 损失,而非累加平均)

# iter_loss = loss.item()

# all_iter_losses.append(iter_loss)

# iter_indices.append(epoch * len(train_loader) + batch_idx + 1) # iteration 序号从1开始# # 统计准确率和损失(原逻辑保留,用于 epoch 级统计)

# running_loss += iter_loss

# _, predicted = output.max(1)

# total += target.size(0)

# correct += predicted.eq(target).sum().item()# # 每100个批次打印一次训练信息(可选:同时打印单 batch 损失)

# if (batch_idx + 1) % 100 == 0:

# print(f'Epoch: {epoch+1}/{epochs} | Batch: {batch_idx+1}/{len(train_loader)} '

# f'| 单Batch损失: {iter_loss:.4f} | 累计平均损失: {running_loss/(batch_idx+1):.4f}')# # 原 epoch 级逻辑(测试、打印 epoch 结果)不变

# epoch_train_loss = running_loss / len(train_loader)

# epoch_train_acc = 100. * correct / total

# epoch_test_loss, epoch_test_acc = test(model, test_loader, criterion, device)# print(f'Epoch {epoch+1}/{epochs} 完成 | 训练准确率: {epoch_train_acc:.2f}% | 测试准确率: {epoch_test_acc:.2f}%')# # 绘制所有 iteration 的损失曲线

# plot_iter_losses(all_iter_losses, iter_indices)

# # 保留原 epoch 级曲线(可选)

# # plot_metrics(train_losses, test_losses, train_accuracies, test_accuracies, epochs)# return epoch_test_acc # 返回最终测试准确率# # 6. 测试模型

# def test(model, test_loader, criterion, device):

# model.eval() # 设置为评估模式

# test_loss = 0

# correct = 0

# total = 0# with torch.no_grad(): # 不计算梯度,节省内存和计算资源

# for data, target in test_loader:

# data, target = data.to(device), target.to(device)

# output = model(data)

# test_loss += criterion(output, target).item()# _, predicted = output.max(1)

# total += target.size(0)

# correct += predicted.eq(target).sum().item()# avg_loss = test_loss / len(test_loader)

# accuracy = 100. * correct / total

# return avg_loss, accuracy # 返回损失和准确率# # 7.绘制每个 iteration 的损失曲线

# def plot_iter_losses(losses, indices):

# plt.figure(figsize=(10, 4))

# plt.plot(indices, losses, 'b-', alpha=0.7, label='Iteration Loss')

# plt.xlabel('Iteration(Batch序号)')

# plt.ylabel('损失值')

# plt.title('每个 Iteration 的训练损失')

# plt.legend()

# plt.grid(True)

# plt.tight_layout()

# plt.show()# # 8. 执行训练和测试(设置 epochs=2 验证效果)

# epochs = 2

# print("开始训练模型...")

# final_accuracy = train(model, train_loader, test_loader, criterion, optimizer, device, epochs)

# print(f"训练完成!最终测试准确率: {final_accuracy:.2f}%")

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

from torch.utils.data import DataLoader

import matplotlib.pyplot as plt

import numpy as np# 设置中文字体支持

plt.rcParams["font.family"] = ["SimHei"]

plt.rcParams['axes.unicode_minus'] = False # 解决负号显示问题# 1. 数据预处理

transform = transforms.Compose([transforms.ToTensor(), # 转换为张量transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5)) # 标准化处理

])# 2. 加载CIFAR-10数据集

train_dataset = datasets.CIFAR10(root=r'E:\60天打卡训练营-DL\cifar/data',train=True,download=False,transform=transform

)test_dataset = datasets.CIFAR10(root=r'E:\60天打卡训练营-DL\cifar/data',train=False,transform=transform

)# 3. 创建数据加载器

batch_size = 64

train_loader = DataLoader(train_dataset, batch_size=batch_size, shuffle=True)

test_loader = DataLoader(test_dataset, batch_size=batch_size, shuffle=False)# 4. 定义MLP模型(适应CIFAR-10的输入尺寸)

class MLP(nn.Module):def __init__(self):super(MLP, self).__init__()self.flatten = nn.Flatten() # 将3x32x32的图像展平为3072维向量self.layer1 = nn.Linear(3072, 512) # 第一层:3072个输入,512个神经元self.relu1 = nn.ReLU()self.dropout1 = nn.Dropout(0.2) # 添加Dropout防止过拟合self.layer2 = nn.Linear(512, 256) # 第二层:512个输入,256个神经元self.relu2 = nn.ReLU()self.dropout2 = nn.Dropout(0.2)self.layer3 = nn.Linear(256, 10) # 输出层:10个类别def forward(self, x):# 第一步:将输入图像展平为一维向量x = self.flatten(x) # 输入尺寸: [batch_size, 3, 32, 32] → [batch_size, 3072]# 第一层全连接 + 激活 + Dropoutx = self.layer1(x) # 线性变换: [batch_size, 3072] → [batch_size, 512]x = self.relu1(x) # 应用ReLU激活函数x = self.dropout1(x) # 训练时随机丢弃部分神经元输出# 第二层全连接 + 激活 + Dropoutx = self.layer2(x) # 线性变换: [batch_size, 512] → [batch_size, 256]x = self.relu2(x) # 应用ReLU激活函数x = self.dropout2(x) # 训练时随机丢弃部分神经元输出# 第三层(输出层)全连接x = self.layer3(x) # 线性变换: [batch_size, 256] → [batch_size, 10]return x # 返回未经过Softmax的logits# 检查GPU是否可用

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")# 初始化模型

model = MLP()

model = model.to(device) # 将模型移至GPU(如果可用)

criterion = nn.CrossEntropyLoss() # 交叉熵损失函数

optimizer = optim.Adam(model.parameters(), lr=0.001) # Adam优化器# 5. 训练模型(记录每个 iteration 的损失)

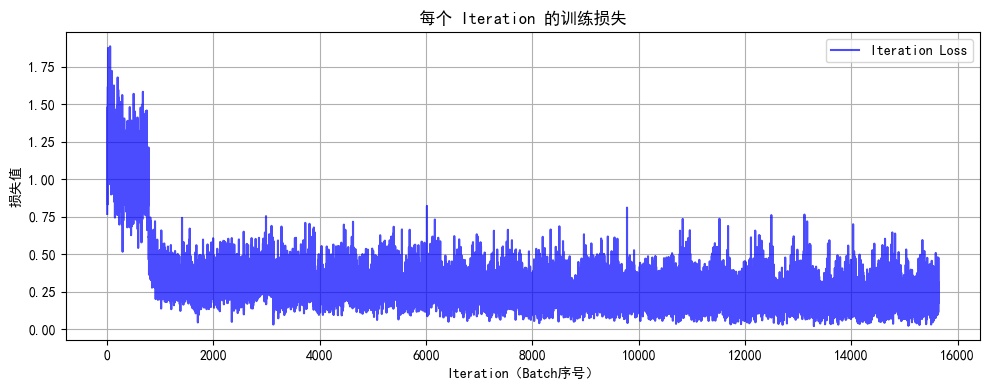

def train(model, train_loader, test_loader, criterion, optimizer, device, epochs):model.train() # 设置为训练模式# 记录每个 iteration 的损失all_iter_losses = [] # 存储所有 batch 的损失iter_indices = [] # 存储 iteration 序号for epoch in range(epochs):running_loss = 0.0correct = 0total = 0for batch_idx, (data, target) in enumerate(train_loader):data, target = data.to(device), target.to(device) # 移至GPUoptimizer.zero_grad() # 梯度清零output = model(data) # 前向传播loss = criterion(output, target) # 计算损失loss.backward() # 反向传播optimizer.step() # 更新参数# 记录当前 iteration 的损失iter_loss = loss.item()all_iter_losses.append(iter_loss)iter_indices.append(epoch * len(train_loader) + batch_idx + 1)# 统计准确率和损失running_loss += iter_loss_, predicted = output.max(1)total += target.size(0)correct += predicted.eq(target).sum().item()# 每100个批次打印一次训练信息if (batch_idx + 1) % 100 == 0:print(f'Epoch: {epoch+1}/{epochs} | Batch: {batch_idx+1}/{len(train_loader)} 'f'| 单Batch损失: {iter_loss:.4f} | 累计平均损失: {running_loss/(batch_idx+1):.4f}')# 计算当前epoch的平均训练损失和准确率epoch_train_loss = running_loss / len(train_loader)epoch_train_acc = 100. * correct / total# 测试阶段model.eval() # 设置为评估模式test_loss = 0correct_test = 0total_test = 0with torch.no_grad():for data, target in test_loader:data, target = data.to(device), target.to(device)output = model(data)test_loss += criterion(output, target).item()_, predicted = output.max(1)total_test += target.size(0)correct_test += predicted.eq(target).sum().item()epoch_test_loss = test_loss / len(test_loader)epoch_test_acc = 100. * correct_test / total_testprint(f'Epoch {epoch+1}/{epochs} 完成 | 训练准确率: {epoch_train_acc:.2f}% | 测试准确率: {epoch_test_acc:.2f}%')# 绘制所有 iteration 的损失曲线plot_iter_losses(all_iter_losses, iter_indices)return epoch_test_acc # 返回最终测试准确率# 6. 绘制每个 iteration 的损失曲线

def plot_iter_losses(losses, indices):plt.figure(figsize=(10, 4))plt.plot(indices, losses, 'b-', alpha=0.7, label='Iteration Loss')plt.xlabel('Iteration(Batch序号)')plt.ylabel('损失值')plt.title('每个 Iteration 的训练损失')plt.legend()plt.grid(True)plt.tight_layout()plt.show()# 7. 执行训练和测试

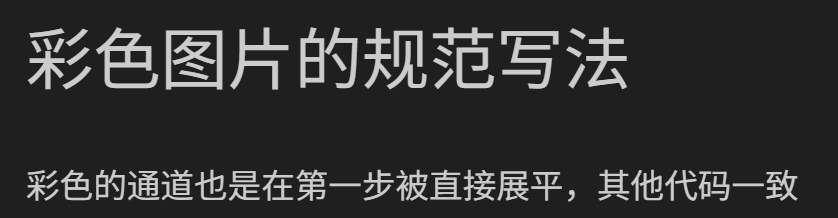

epochs = 20 # 增加训练轮次以获得更好效果

print("开始训练模型...")

final_accuracy = train(model, train_loader, test_loader, criterion, optimizer, device, epochs)

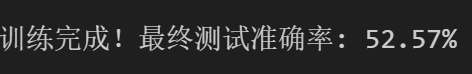

print(f"训练完成!最终测试准确率: {final_accuracy:.2f}%")# # 保存模型

# torch.save(model.state_dict(), 'cifar10_mlp_model.pth')

# # print("模型已保存为: cifar10_mlp_model.pth")

由于深度mlp的参数过多,为了避免过拟合在这里引入了dropout这个操作,他可以在训练阶段随机丢弃一些神经元,避免过拟合情况。dropout的取值也是超参数。

在测试阶段,由于开启了eval模式,会自动关闭dropout。

# 7. 执行训练和测试

epochs = 20 # 增加训练轮次以获得更好效果

print("开始训练模型...")

final_accuracy = train(model, train_loader, test_loader, criterion, optimizer, device, epochs)

print(f"训练完成!最终测试准确率: {final_accuracy:.2f}%")

此时你会发现MLP(多层感知机)在图像任务上表现较差(即使增加深度和轮次也只能达到 50-55% 准确率),主要原因与图像数据的空间特性和MLP 的结构缺陷密切相关。

1. MLP 的每一层都是全连接层,输入图像会被展平为一维向量(如 CIFAR-10 的 32x32x3 图像展平为 3072 维向量)。图像中相邻像素通常具有强相关性(如边缘、纹理),但 MLP 将所有像素视为独立特征,无法利用局部空间结构。例如,识别 “汽车轮胎” 需要邻近像素的组合信息,而 MLP 需通过大量参数单独学习每个像素的关联,效率极低。

2. 深层 MLP 的参数规模呈指数级增长,容易过拟合。

所以我们接下来将会学习CNN架构,CNN架构的参数规模相对较小,且训练速度更快,而且CNN架构可以解决图像识别问题,而MLP不能。

)

v1.4.20绿色免费版,U盘随走随检,结果即刻导出)