目录

- 环境准备

- 主机准备

- 补充说明

- JDK安装 (三台主机分别执行)

- 下载jdk

- jdk安装

- kafka 部署(三台主机分别执行)

- kafka 下载

- kafka 版本号结构解析

- kafka 安装

- 下载和解压安装包(3台主机都执行)

- 配置 server.properties (KRaft 模式)

- 192.168.37.10

- 192.168.37.11

- 192.168.37.12

- 格式化存储目录

- 第一个节点执行

- 三个节点分别执行

- 启动kafka (3个节点分别执行)

- Kafka 配置为 systemd 服务

- 查看集群控制器状态

- 注意事项

- 调整 JVM 内存参数

- 在Kraft模式下,Kafka有如下三个配置文件可以配置。

Kafka KRaft 版本(即 Kafka 3.0 及更高版本)使用 KRaft 模式(Kafka Raft 协议)替代 ZooKeeper 进行集群管理,简化了部署流程。以下是在 Linux 系统上部署 Kafka KRaft 的详细步骤。

环境准备

主机准备

| 主机IP | 角色 | 操作系统 |

|---|---|---|

192.168.37.10 | broker,controller | Centos 7 |

192.168.37.11 | broker,controller | Centos 7 |

192.168.37.12 | broker,controller | Centos 7 |

补充说明

我们这种,将Broker和Controllers部署一台的做法,称为 “组合式”。

同时充当代理和控制器的 Kafka 服务器被称为 “组合式” 服务器。对于开发环境等小型用例而言,组合式服务器的操作更为简单。其主要缺点在于,控制器与系统其他部分的隔离性较差。例如,在组合模式下,无法将控制器与代理分开进行滚动升级或扩展。在关键的部署环境中,不建议使用组合模式。

JDK安装 (三台主机分别执行)

下载jdk

https://www.oracle.com/java/technologies/downloads/?er=221886#java21

jdk安装

- 解压下载的文件到指定目录

tar xvf jdk-21_linux-x64_bin.tar.gz -C /usr/local/

- 设置环境变量 (以 Linux/macOS 为例)

vim /etc/profile

export JAVA_HOME=/usr/local/jdk-21.0.8

export PATH=$JAVA_HOME/bin:$PATH

- 刷新环境变量

source /etc/profile

- 验证安装

[root@test-10 bin]# java --version

java 21.0.8 2025-07-15 LTS

Java(TM) SE Runtime Environment (build 21.0.8+12-LTS-250)

Java HotSpot(TM) 64-Bit Server VM (build 21.0.8+12-LTS-250, mixed mode, sharing)kafka 部署(三台主机分别执行)

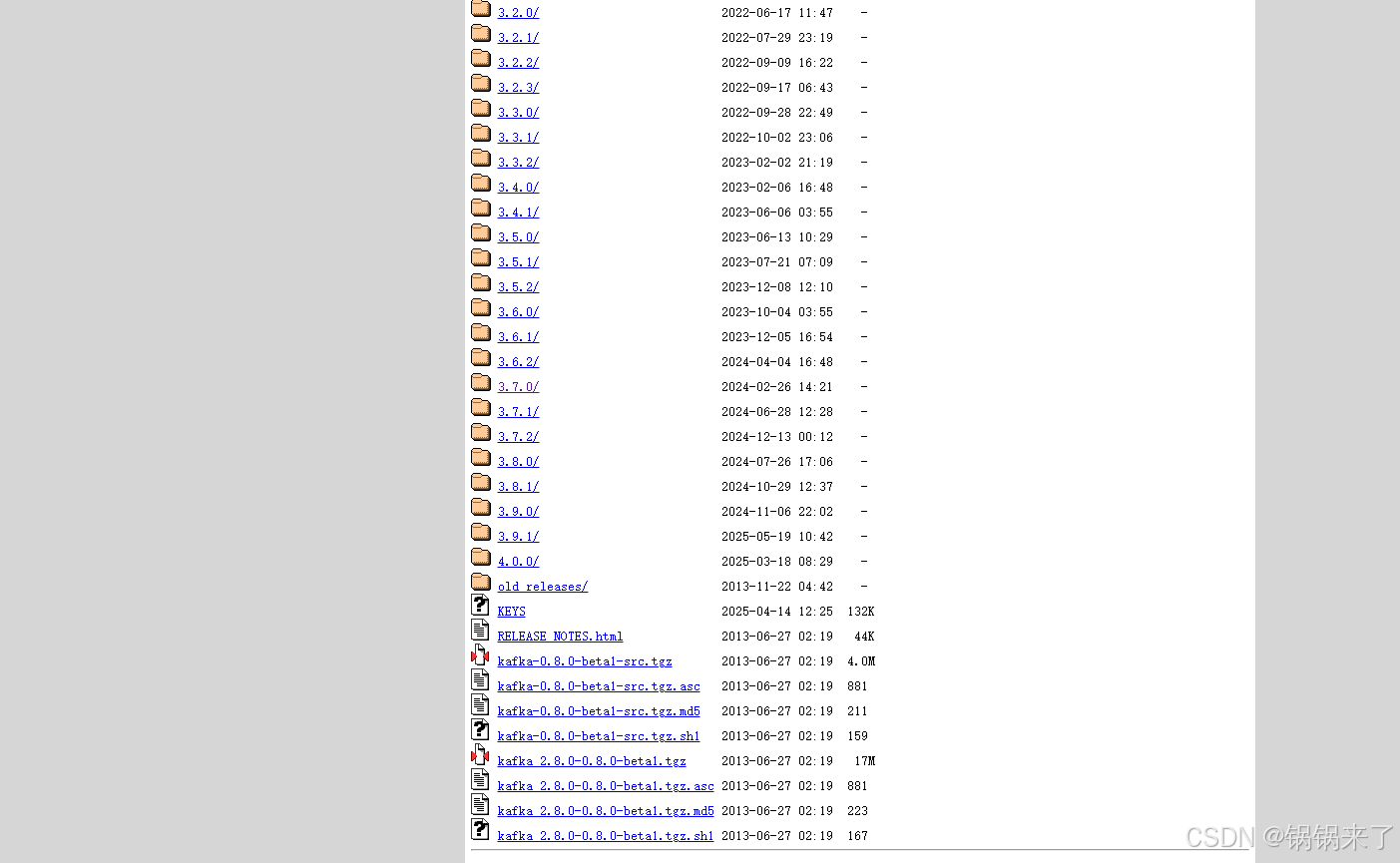

kafka 下载

地址:https://archive.apache.org/dist/kafka/

这里展示了历史的kafka各个版本。

本次我们下载 kafka_2.13-3.7.0.tgz 这个版本

https://archive.apache.org/dist/kafka/3.7.0/kafka_2.13-3.7.0.tgz

kafka 版本号结构解析

kafka_<SCALA_VERSION>-<KAFKA_VERSION>.tgz

Kafka 是用 Scala 和 Java 开发的,因此需要特定版本的 Scala 编译。版本号中的 2.13 表示该 Kafka 版本是用 Scala 2.13.x 编译的

3.7.0 是 Kafka 自身的版本号,采用 MAJOR.MINOR.PATCH 格式

kafka 安装

下载和解压安装包(3台主机都执行)

mkdir -p /data/middleware

tar xvf kafka_2.13-3.7.0.tgz -C /data/middleware/

配置 server.properties (KRaft 模式)

192.168.37.10

编辑 config/kraft/server.properties 文件:

node.id=1

advertised.listeners=PLAINTEXT://192.168.37.10:9092

controller.listener.names=CONTROLLER

controller.quorum.voters=1@192.168.37.10:9093,2@192.168.37.11:9093,3@192.168.37.12:9093

listeners=PLAINTEXT://:9092,CONTROLLER://:9093

log.dirs=/data/middleware/kafka_2.13-3.7.0/data192.168.37.11

node.id=2

advertised.listeners=PLAINTEXT://192.168.37.11:9092

controller.listener.names=CONTROLLER

controller.quorum.voters=1@192.168.37.10:9093,2@192.168.37.11:9093,3@192.168.37.12:9093

listeners=PLAINTEXT://:9092,CONTROLLER://:9093

log.dirs=/data/middleware/kafka_2.13-3.7.0/data192.168.37.12

node.id=3

advertised.listeners=PLAINTEXT://192.168.37.12:9092

controller.listener.names=CONTROLLER

controller.quorum.voters=1@192.168.37.10:9093,2@192.168.37.11:9093,3@192.168.37.12:9093

listeners=PLAINTEXT://:9092,CONTROLLER://:9093

log.dirs=/data/middleware/kafka_2.13-3.7.0/data格式化存储目录

第一个节点执行

Kafka KRaft 模式需要生成一个集群 ID 并配置相关参数:

[root@test-10 kafka_2.13-3.7.0]# ./bin/kafka-storage.sh random-uuid

BJODTrqBTbCBnwSG2VszJg三个节点分别执行

将生成的 UUID 记录下来, 使用生成的集群 ID 格式化存储目录:

./bin/kafka-storage.sh format -t <YOUR_CLUSTER_ID> -c config/kraft/server.properties

[root@test-10 kafka_2.13-3.7.0]# ./bin/kafka-storage.sh format -t BJODTrqBTbCBnwSG2VszJg -c config/kraft/server.properties

metaPropertiesEnsemble=MetaPropertiesEnsemble(metadataLogDir=Optional.empty, dirs={/data/middleware/kafka_2.13-3.7.0/data: EMPTY})

Formatting /data/middleware/kafka_2.13-3.7.0/data with metadata.version 3.7-IV4.# 执行后,data目录自动创建,并生成了两个文件。

[root@test-10 kafka_2.13-3.7.0]# ls data/

bootstrap.checkpoint meta.properties

[root@test-10 kafka_2.13-3.7.0]# cat data/meta.properties

#

#Fri Jul 18 11:25:00 CST 2025

cluster.id=BJODTrqBTbCBnwSG2VszJg

directory.id=YE6-pLr4UPcqstWaKaZJFw

node.id=1

version=1启动kafka (3个节点分别执行)

前台启动(方便调试)

./bin/kafka-server-start.sh config/kraft/server.properties

后台启动

./bin/kafka-server-start.sh -daemon config/kraft/server.properties

Kafka 配置为 systemd 服务

[root@test-10 logs]# systemctl cat kafka

# /etc/systemd/system/kafka.service

[Unit]

Description=Apache Kafka Server (KRaft Mode)

Documentation=https://kafka.apache.org/documentation/

Requires=network.target

After=network.target[Service]

Type=forking

Environment="JAVA_HOME=/usr/local/jdk-21.0.8"

ExecStart=/data/middleware/kafka_2.13-3.7.0/bin/kafka-server-start.sh -daemon /data/middleware/kafka_2.13-3.7.0/config/kraft/server.properties

ExecStop=/data/middleware/kafka_2.13-3.7.0/bin/kafka-server-stop.sh

Restart=on-failure

RestartSec=5

LimitNOFILE=100000[Install]

WantedBy=multi-user.target重新加载 systemd 并启动服务

sudo systemctl daemon-reload

sudo systemctl start kafka

sudo systemctl enable kafka # 设置开机自启

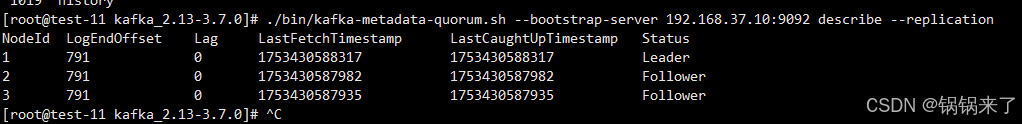

查看集群控制器状态

注意事项

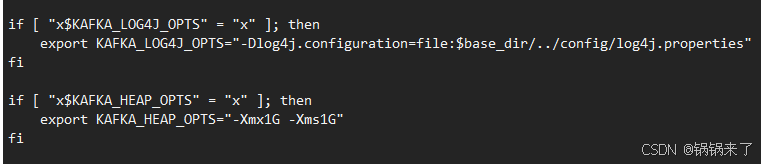

调整 JVM 内存参数

可以在Service文件中增加

Environment=“KAFKA_HEAP_OPTS=-Xmx4G -Xms4G”

不覆盖修改,则启动的JVM参数采用bin/kafka-server-start.sh 默认

在Kraft模式下,Kafka有如下三个配置文件可以配置。

- config/kraft/broker.properties 当节点作为[broker]角色运行时,会去读该文件中的配置项启动。

- config/kraft/controller.properties 当节点作为[controller]角色运行时,会去读该文件中的配置项启动。

- config/kraft/server.properties 当节点同时作为[broker, controller]角色运行时,会去读该文件中的配置项启动。

)