精读威斯康星大学综述《Coreference Resolution: A Survey》,揭秘NLP中"实体链接"的核心技术

一、什么是共指消解?为什么它是NLP的基石?

共指消解(Coreference Resolution) 旨在识别文本中指向同一实体的不同表述。例如:

text

[李华]₁昨天去了书店。[他]₁买了[一本《深度学习》]₂。[这本书]₂的价格是100元。

标注说明:相同下标(如₁)表示指向同一实体

核心价值:

问答系统:理解"他"指代谁

文本摘要:合并重复指代

知识图谱:链接实体别名

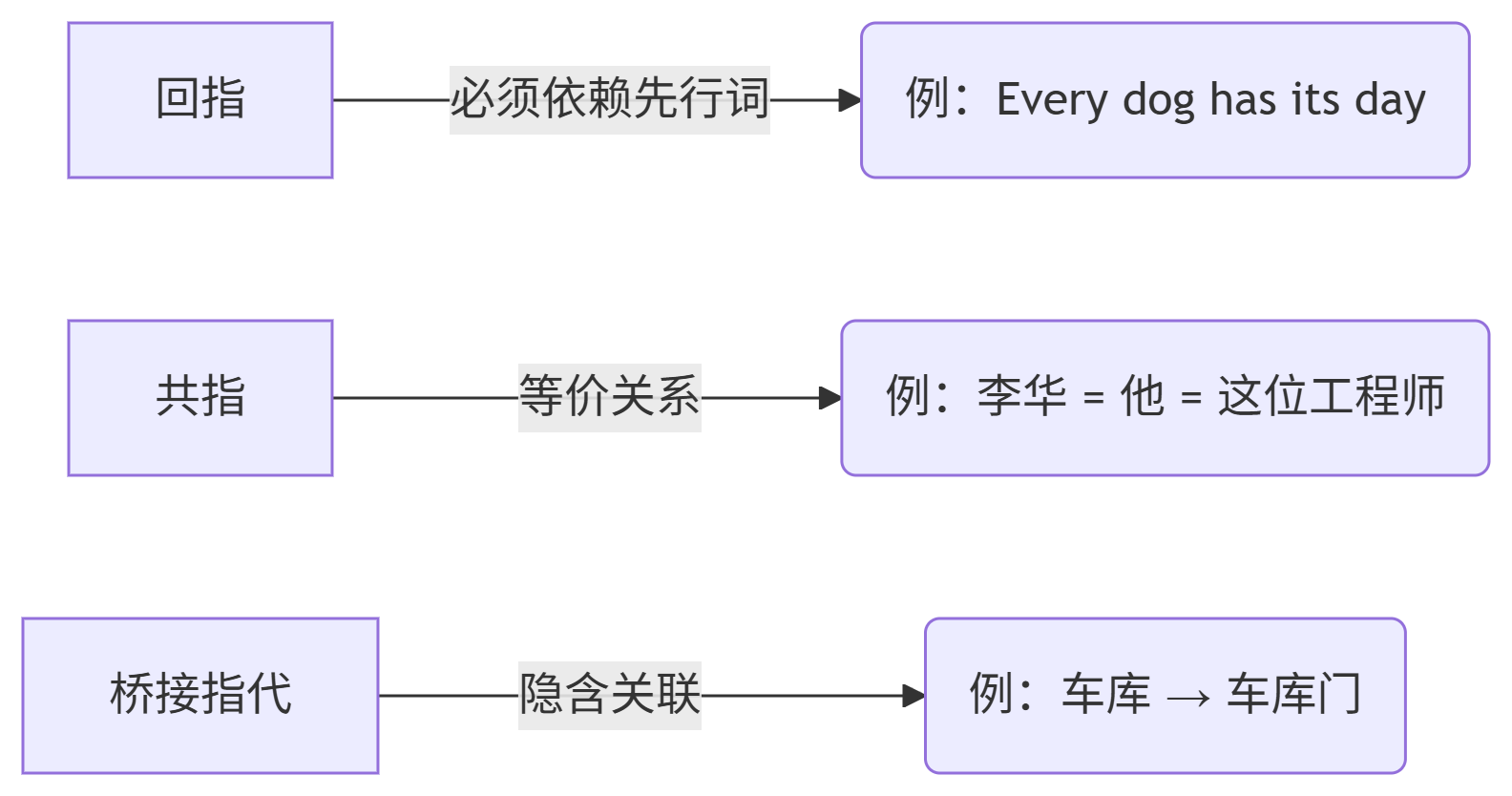

与回指(Anaphora)的区别(论文2.1节核心观点):

二、语言学方法:规则驱动的早期探索

1. Hobbs算法(1976)

基于句法树的遍历策略:

优先在当前句广度优先左向右搜索

满足绑定约束(如代词不能指代从句主语)

回溯前序句子(反向时序)

# 伪代码实现(简化版)

def hobbs_algorithm(pronoun, parse_tree):# 当前句内搜索for node in bfs_left_to_right(parse_tree.current_sentence):if match_constraints(node, pronoun):return node# 回溯前序句子for sent in reversed(previous_sentences):for node in bfs_left_to_right(sent.parse_tree):if match_constraints(node, pronoun):return nodereturn None2. 中心理论(Centering Theory)

动态追踪文本焦点(论文2.2节核心模型):

前视中心(Cf) :当前句的实体列表(按显著性排序)

后视中心(Cb) :上一句的核心焦点实体

状态转移:

延续(CONTINUE) :Cb不变且是Cf中最显著 → 最优

保持(RETAIN) :Cb不变但非最显著

转移(SHIFT) :Cb改变

📌 经典案例(论文2.2节示例):

“Terry犯错”→“他兴奋”→“他邀请Tony”→“他6点打电话”→“他生病了”

最后一句的"他"指代Tony(焦点转移),需领域知识才能解析

三、机器学习方法:数据驱动的现代突破

1. 特征工程进化史

| 特征类型 | 代表特征 | 论文章节 |

|---|---|---|

| 基础属性 | 距离、性别、数一致性 | 3.1 |

| 句法特征 | 语法角色(主语/宾语) | 3.2 |

| 语义特征 | WordNet路径相似度 | 3.2 |

| 别名特征 | "奥巴马" ≈ "Barack Obama" | 3.2 |

2. 三大主流模型对比

| 模型 | 核心思想 | F1@MUC-6 | 优势 |

|---|---|---|---|

| 决策树(Soon et al.) | 指代对二分类 | 68.2% | 特征可解释性强 |

| 条件随机场(CRF) | 建模指代链全局依赖 | 73.0% | 解决传递依赖(A=B,B=C⇒A=C) |

| 聚类方法(Cardie) | 无监督NP聚类 | 65.8% | 避免三角矛盾 |

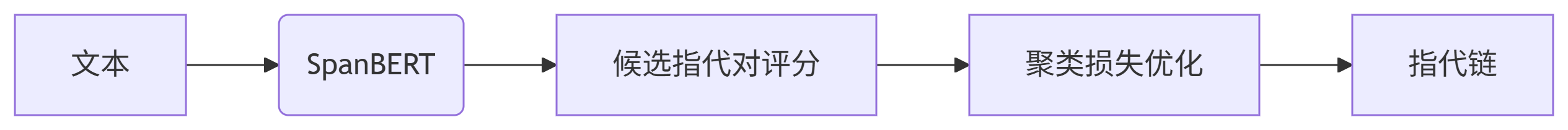

3. 桥接指代解析创新方案

解决隐含关联问题(如"车库→门"):

网络挖掘:搜索共现模式(论文2.6节)

python

# 基于搜索引擎的关联度计算

def bridging_score(phrase1, phrase2):query = f"\"{phrase1} and {phrase2}\""results = search_engine(query)return results.count / MAX_RESULTS知识库补全:WordNet扩展(论文3.4节)

四、领域差异:文体如何影响指代分布?

关键发现:

新闻报道:专有名词占比高(22.2%)

小说:代词占比超30%

学术文本:7.25%代词(需长距离消解)

💡 实践建议:

新闻领域优先优化命名实体链接,小说领域需强化代词解析

五、2025技术衔接:从传统方法到SOTA模型

低资源解决方案:

半监督学习:协同训练(论文3.6节)

提示学习:

[PRO]他[MASK]指代谁?

中文场景挑战:

零指代问题:"∅ 去了书店"(省略主语)

解决方案:清华ChineseBERT+规则后处理

六、实用工具与复现推荐

# 主流工具库

pip install allenai-allennlp # 包含端到端共指模型

pip install stanza # 支持中文共指消解# 论文复现代码

git clone https://github.com/msg-systems/corefhub训练建议:

# 添加领域自适应层(针对中文小说)

model.add_adapter("chinese_novel")

model.train_adapter("chinese_novel")参考文献

Elango P. (2006). Coreference Resolution: A Survey. University of Wisconsin-Madison

延申阅读

[SpanBERT: Improving Pre-training by Representing and Predicting Spans]

[CorefQA:基于问答的共指消解框架]

博主总结:共指消解是NLP的"实体链接器",需结合语言学规则与深度学习。选择方案时务必考虑领域特性!

欢迎在评论区交流指代消解实战问题 👇

【#NLP避坑指南】【#指代消解论文精读】

)

)

模型)

答疑解惑)

)

)

)