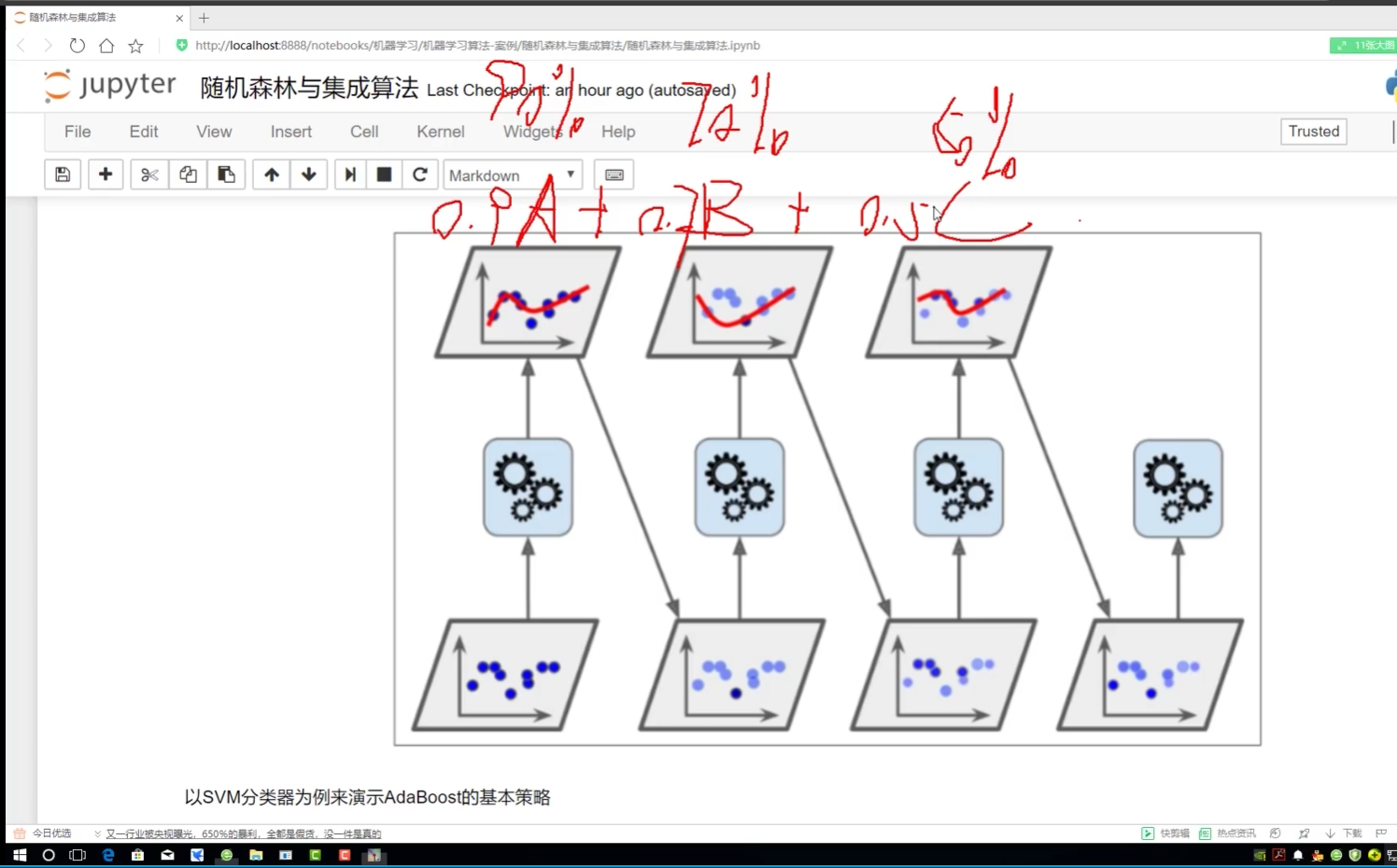

baggibg(rf随机森林) adaboostibg

用来展示

Project Jupyter | Home

展示源码

Eclipse IDE | The Eclipse Foundation

Eclipse 下载 |Eclipse 基金会

教程8-Adaboost决策边界效果_哔哩哔哩_bilibili

(23 封私信) 图解机器学习神器:Scikit-Learn - 知乎

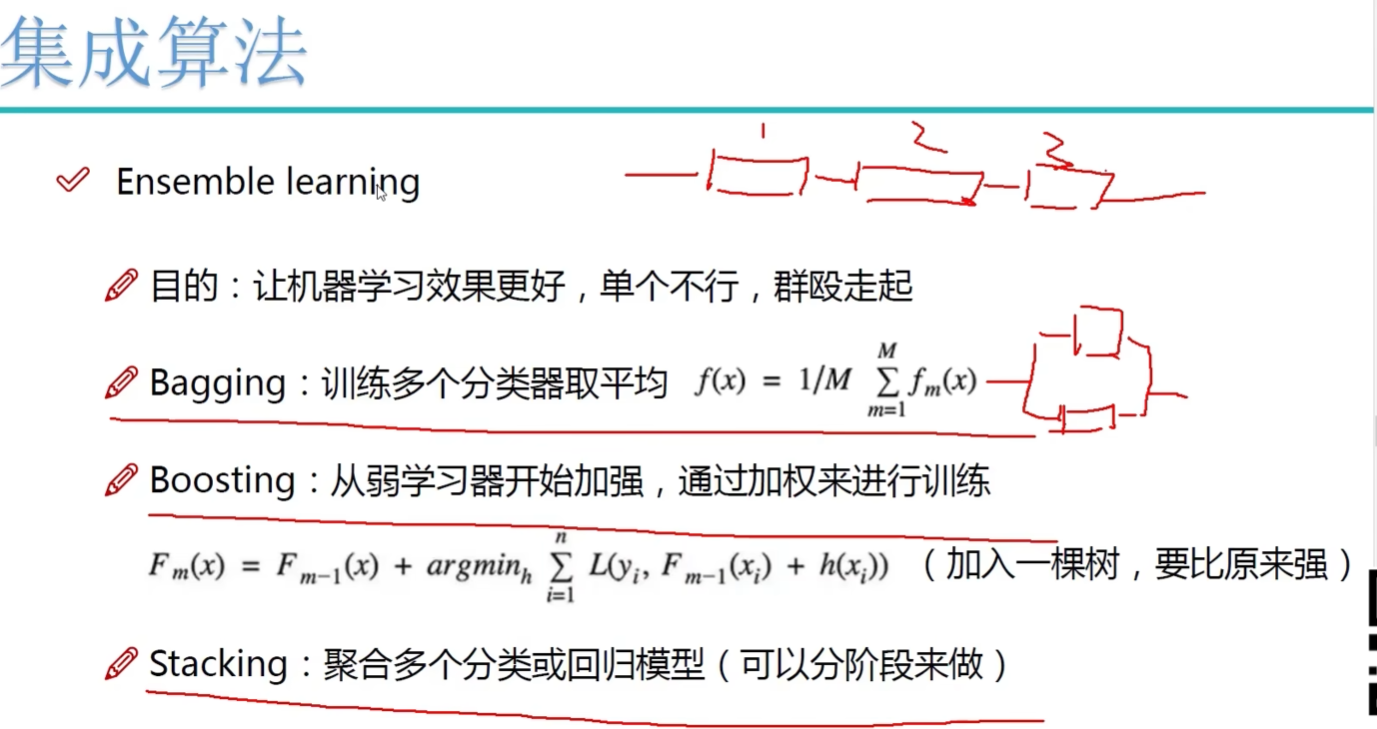

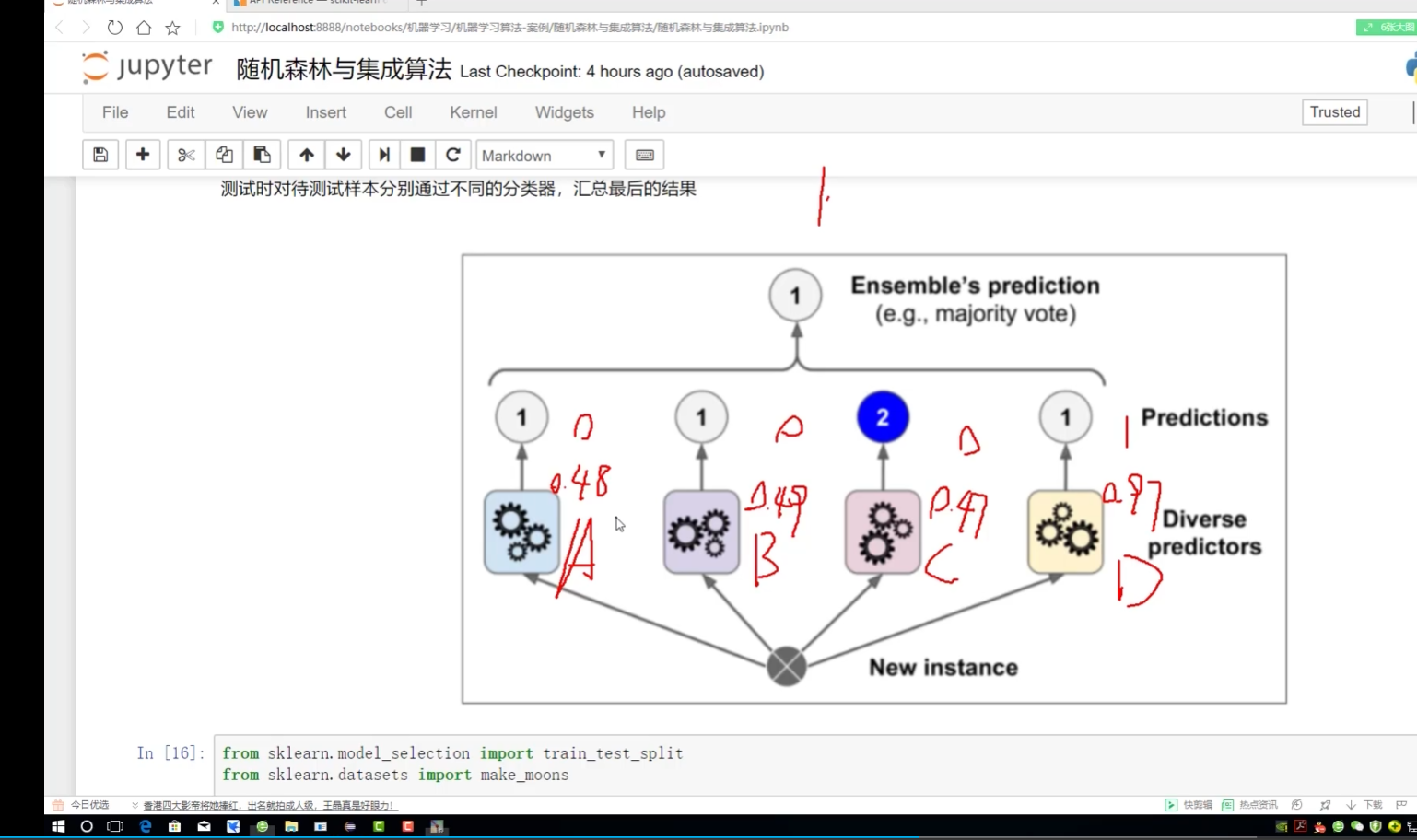

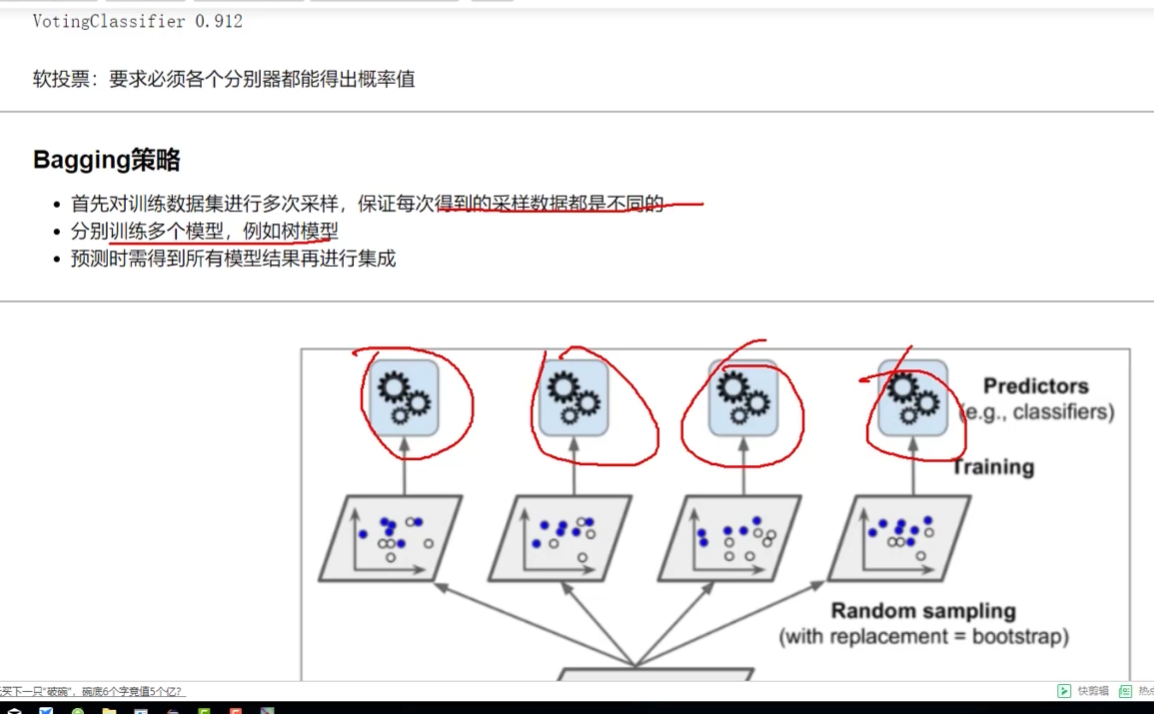

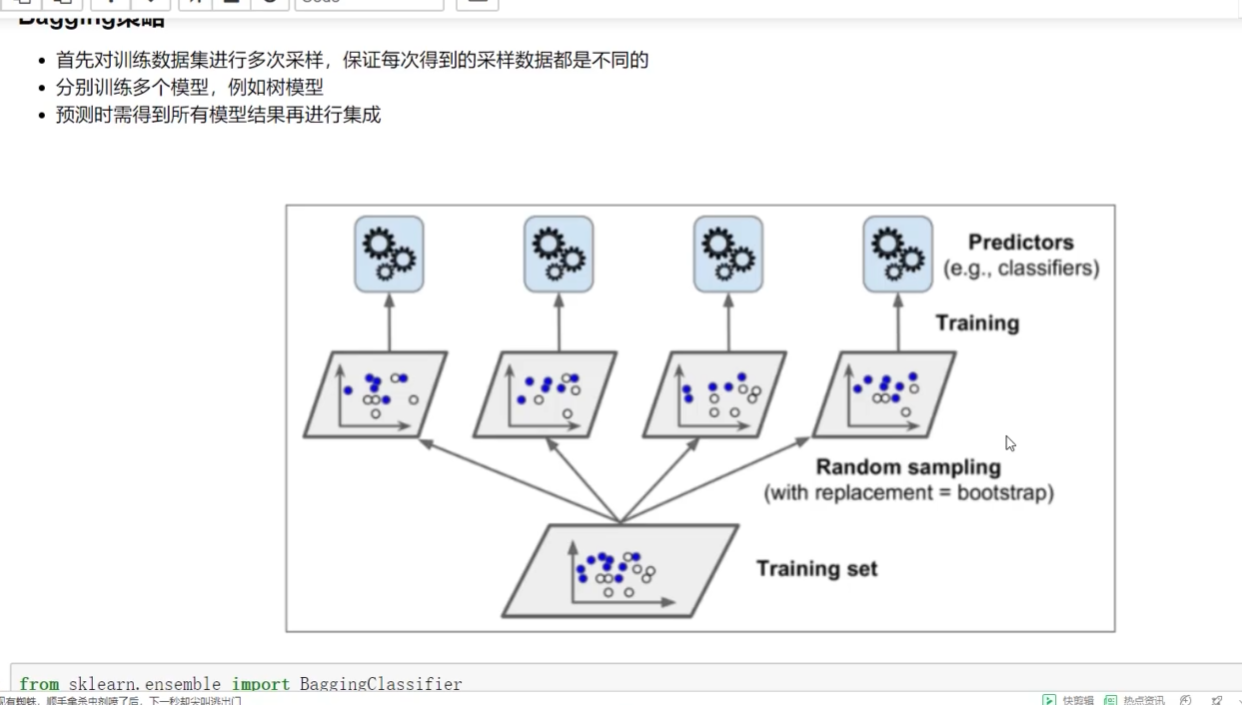

Bagging:取平均

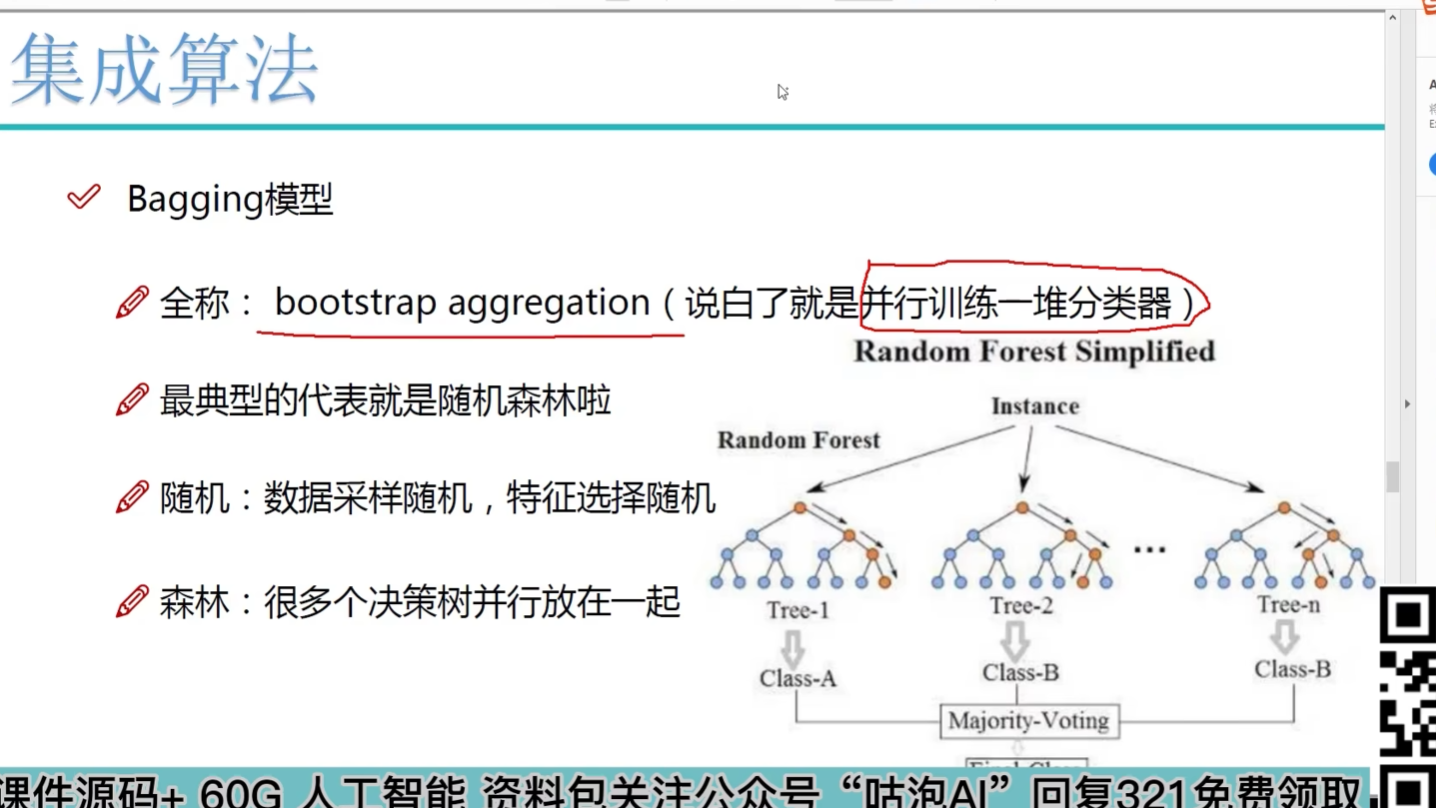

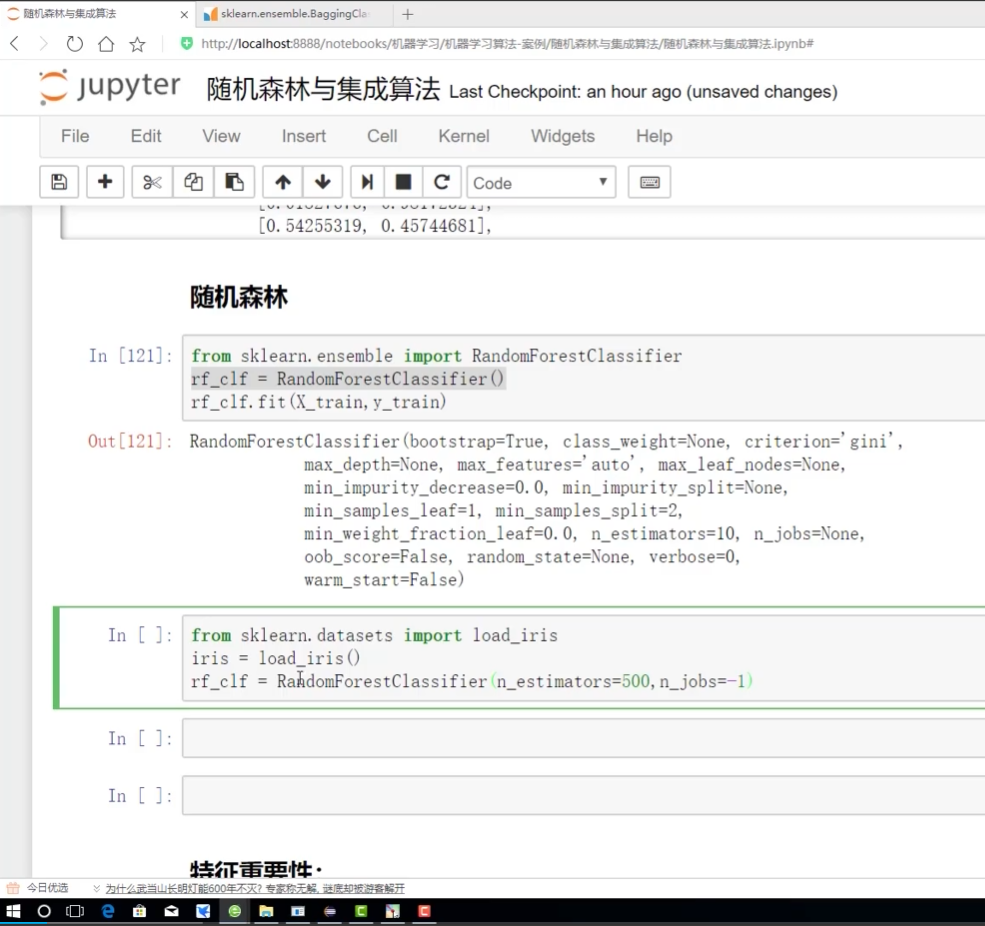

随机森林是典型

随机:随机样本采样 随机特征采样 自己测试不同比例值

森林:并行训练一对分类器(树) 多个树加在一起去平均

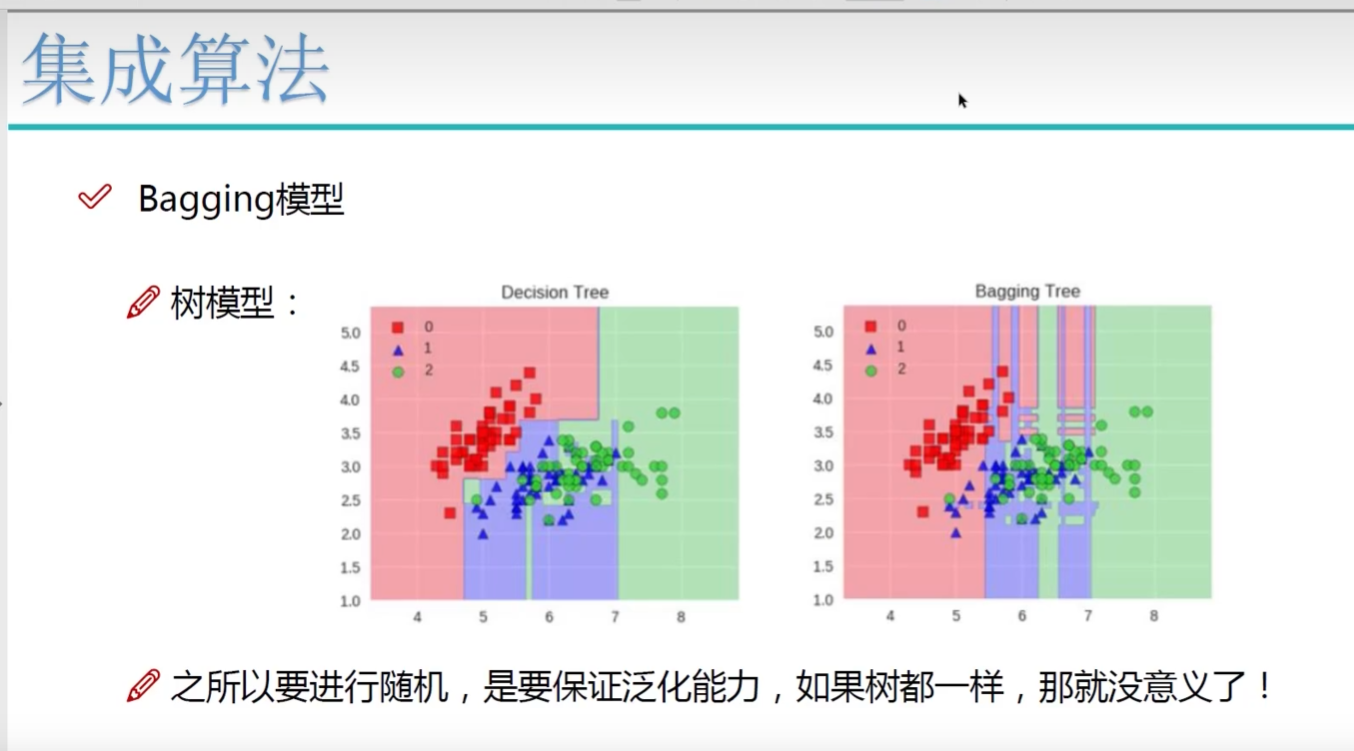

多样性

二重:数据随机采样--

先取100个样本: 80的部分1 80的部分2

再取100个里面的10个:6个分到部分1 6个分到部分2 (不同特征值)

树不一样 根节点有什么特征

全在用树模型:

什么特征上做了什么事

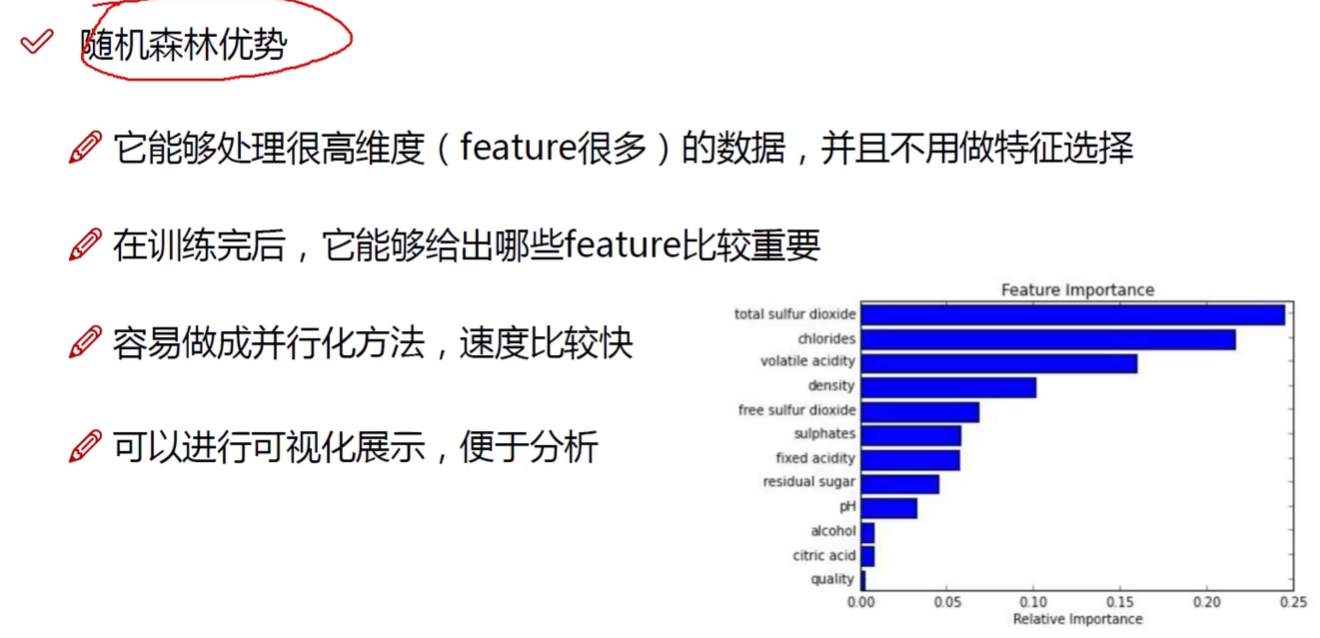

随机森林:可解释性强 自动的特征选择

神经网络:无法解释 输入输出可知 处理未知

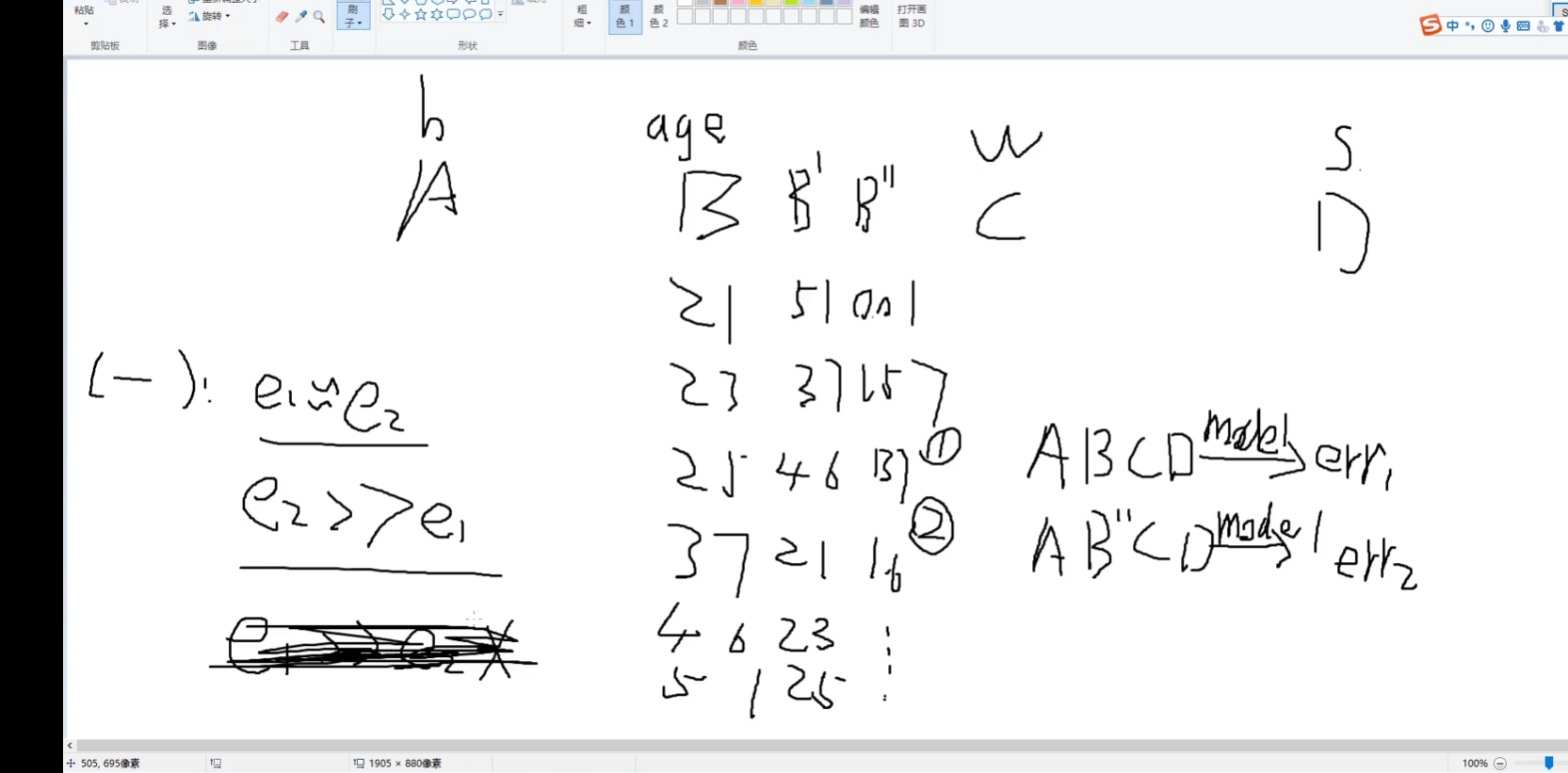

对B进行改变: B丿 B丿丿

A,B,C,D类参数:如身高/体重....

error1 error2

e1≈e2 B没用

e2>>e1 B有用

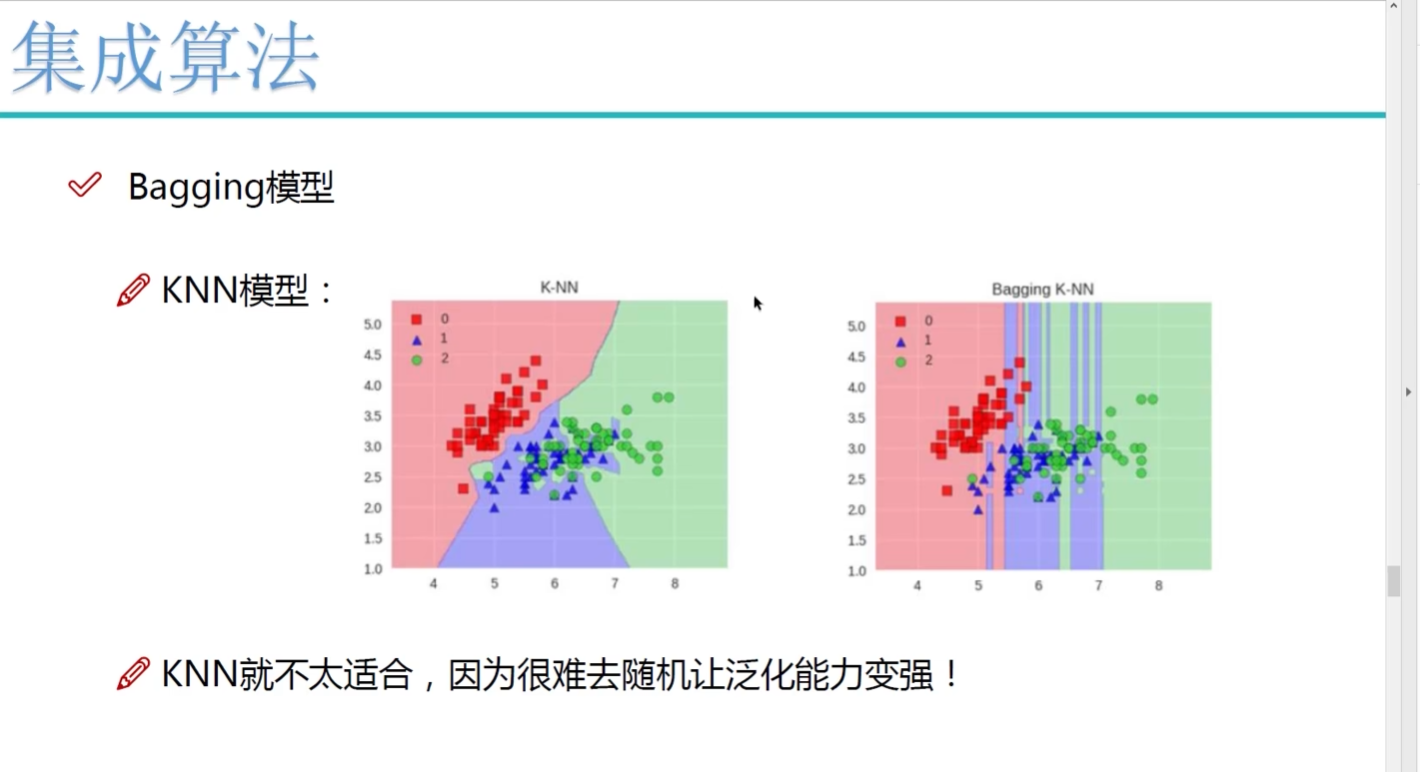

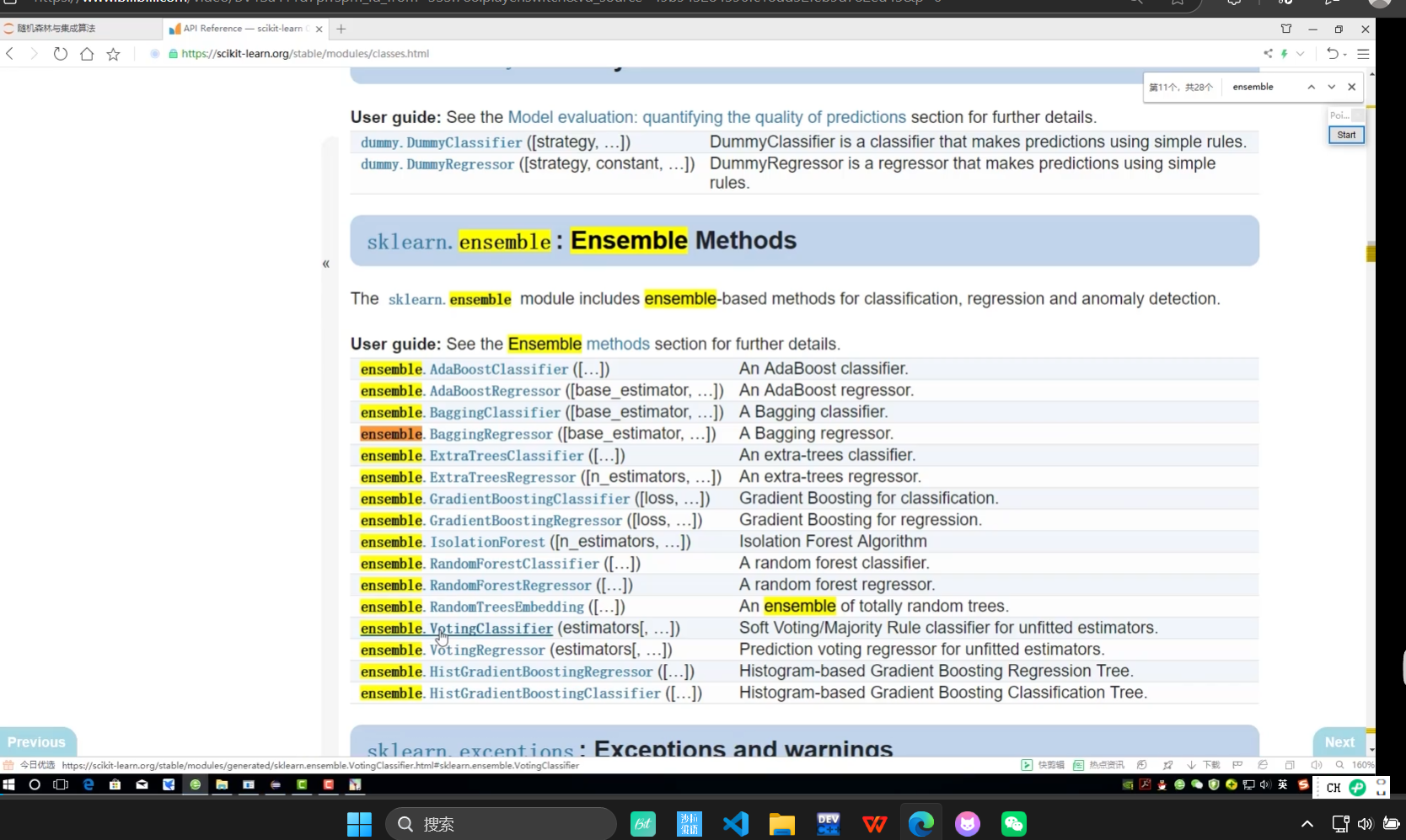

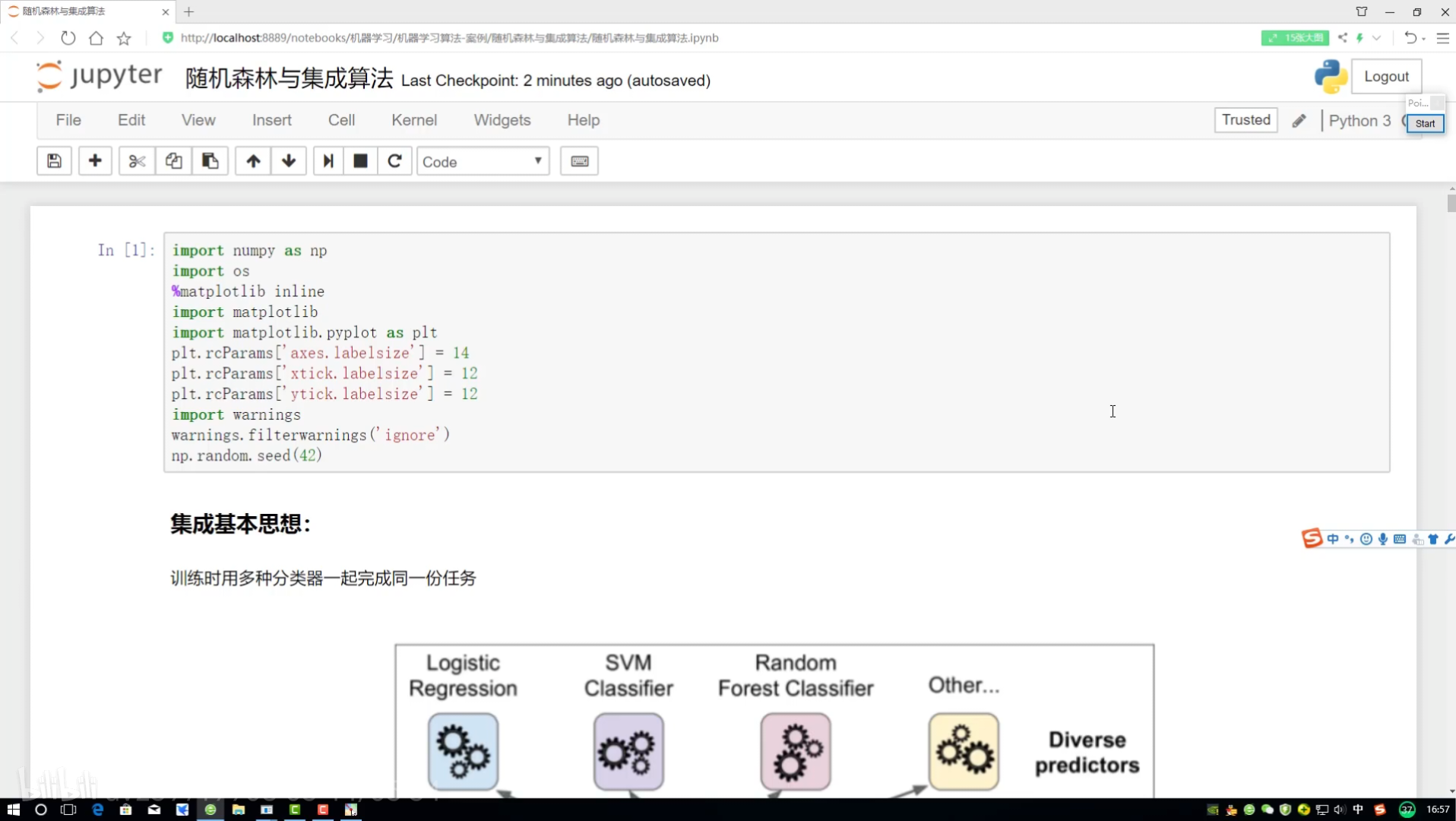

一些集成算法 除了树模型就不能再去集成了

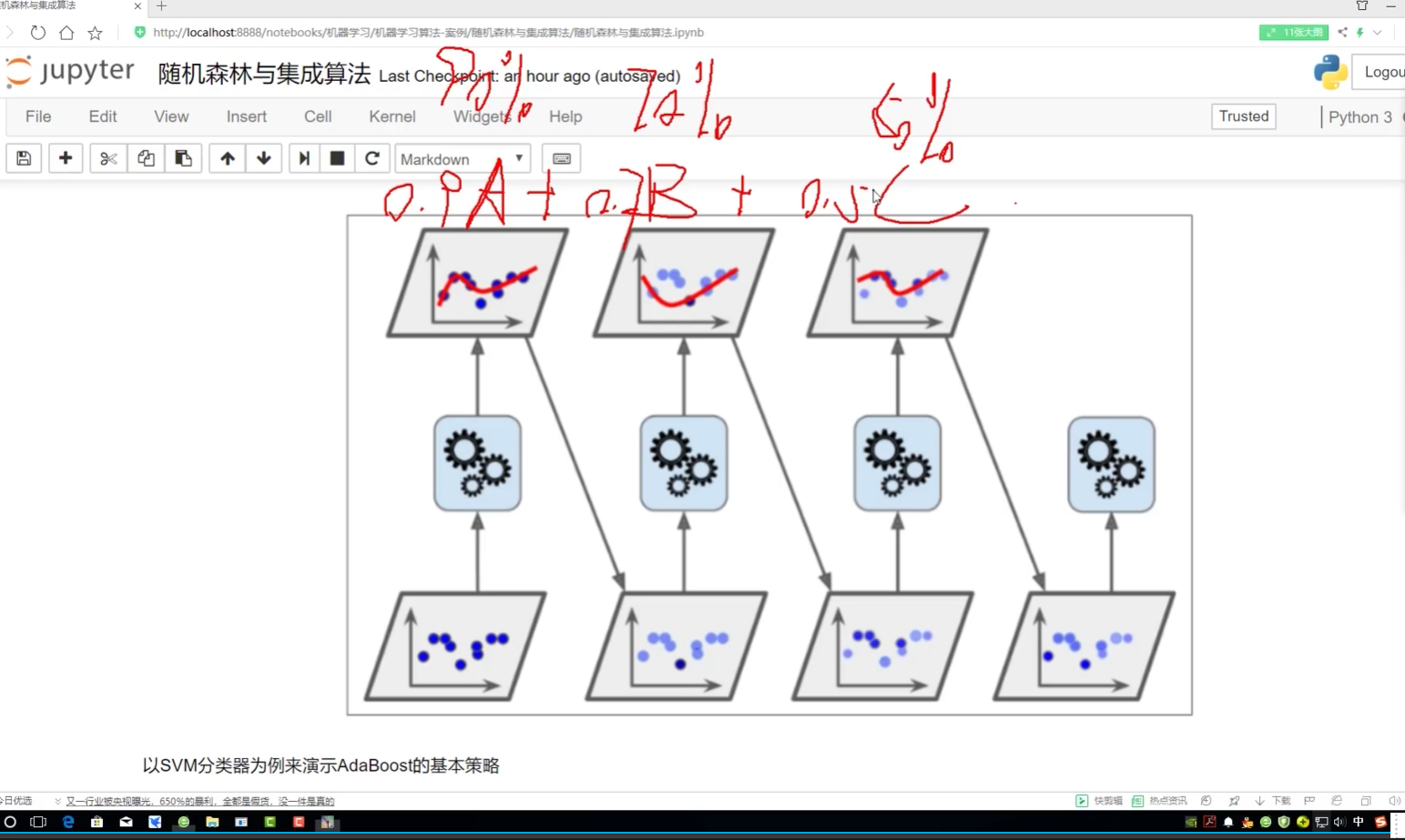

Boosting:提升

随机森林:总和求均

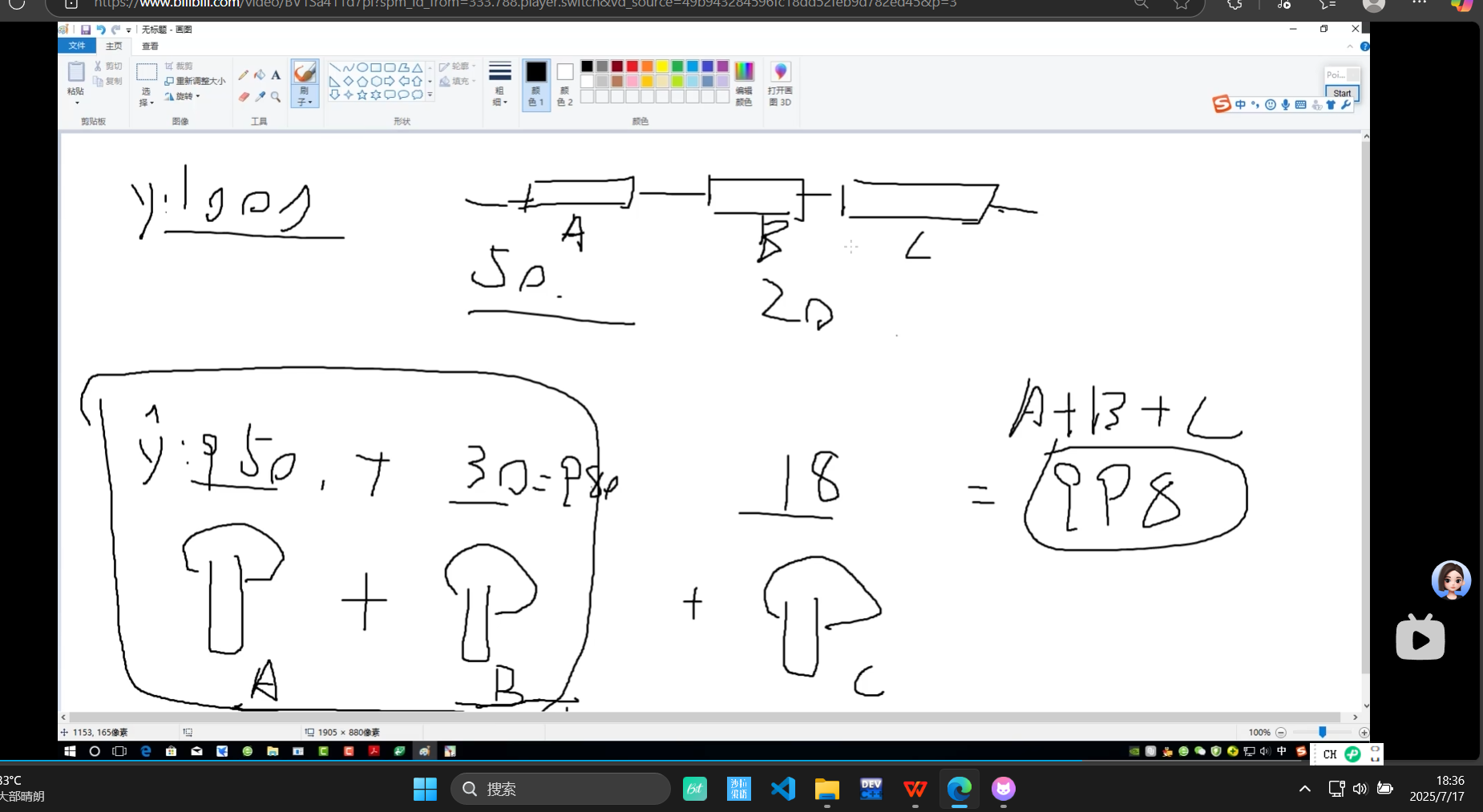

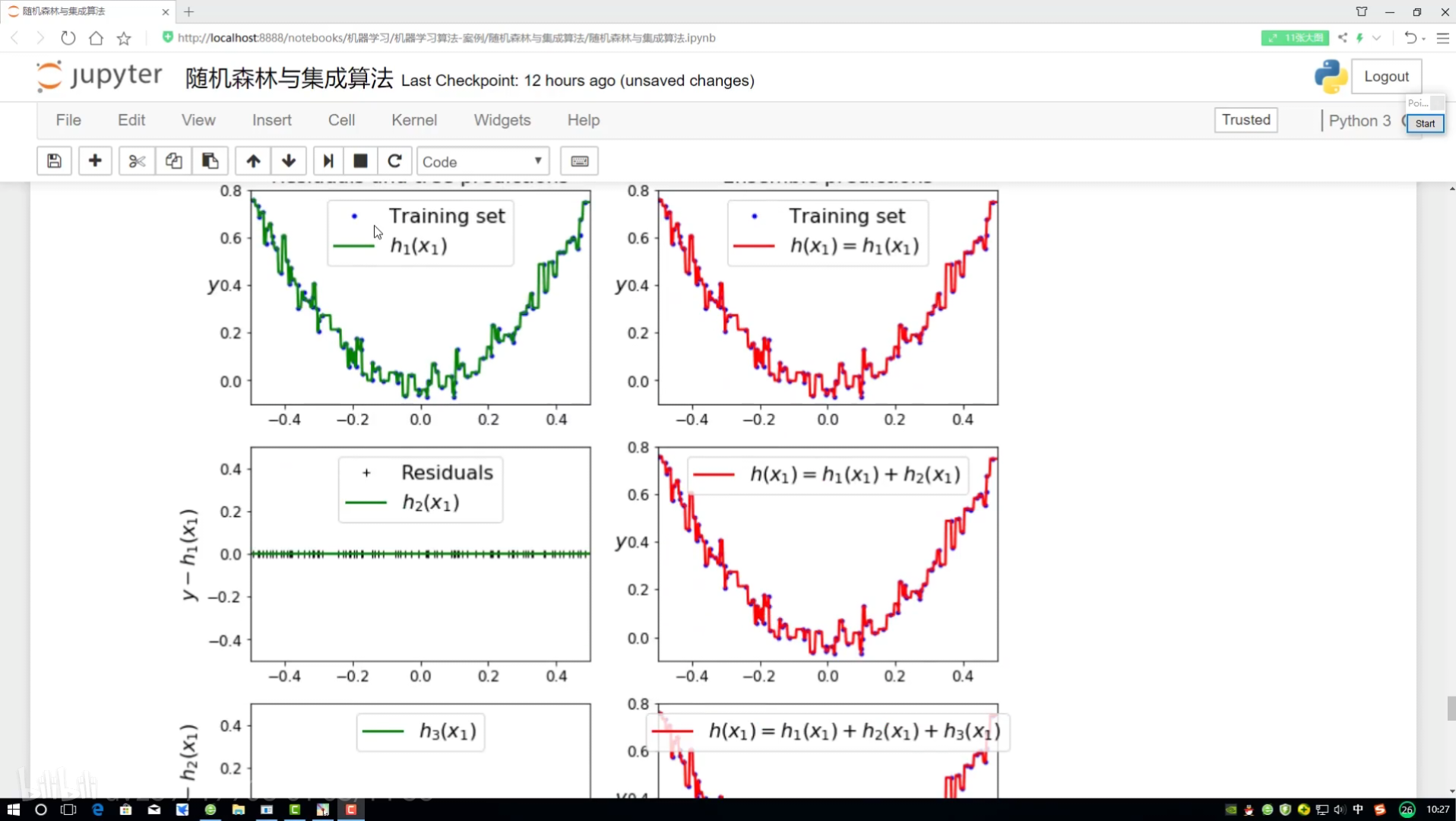

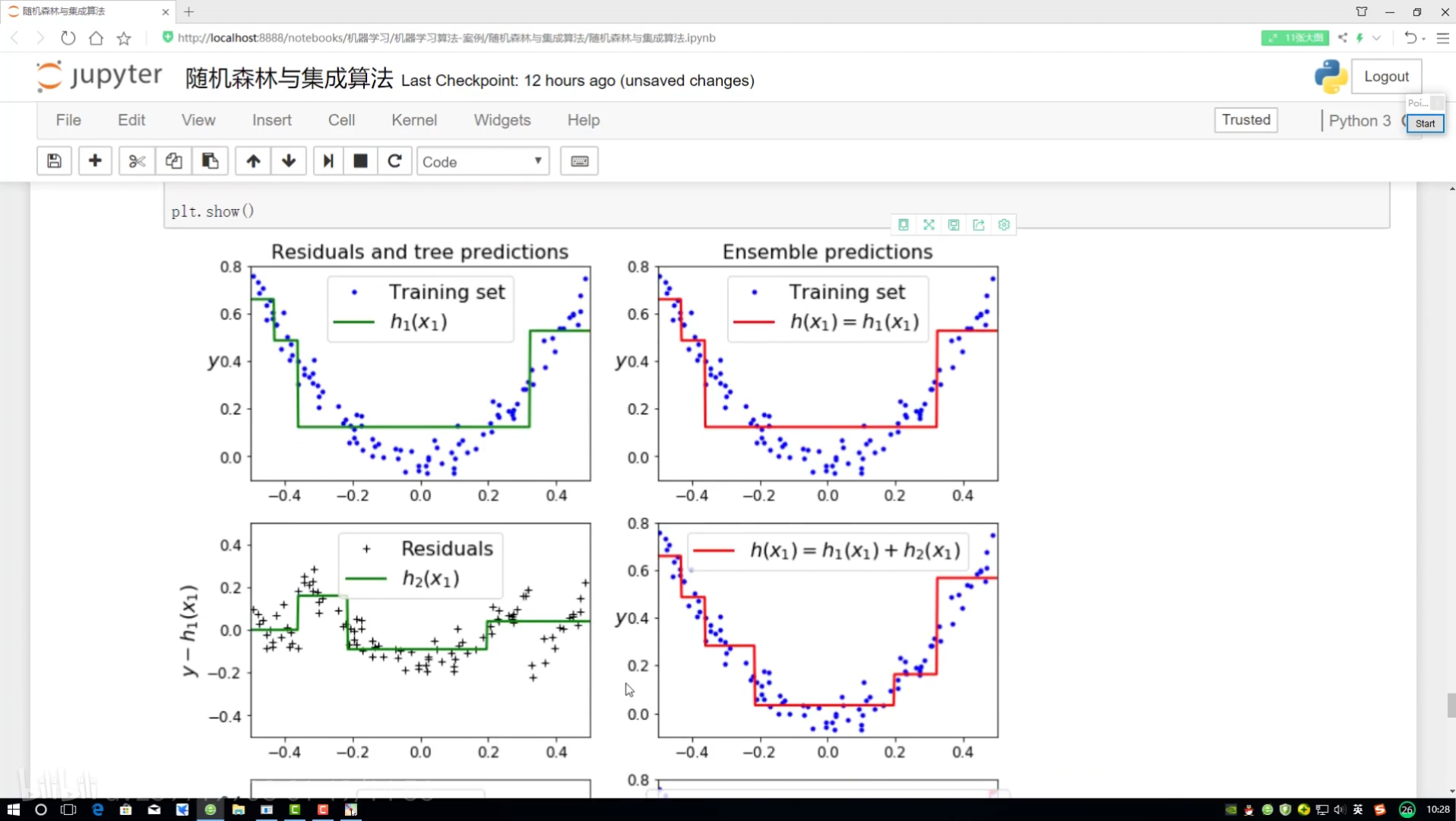

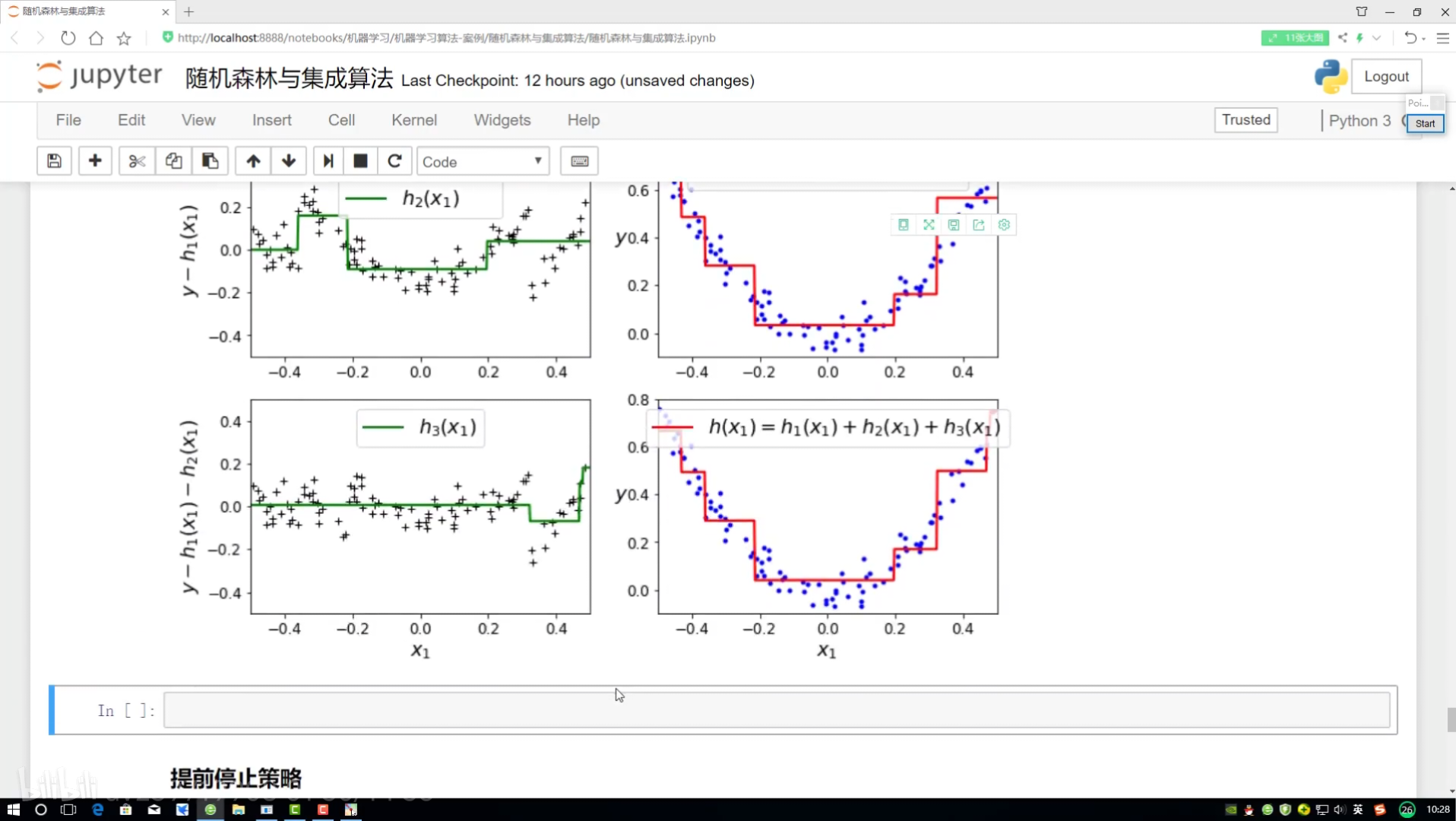

从100-预估950 剩下50中预估30 剩下20中预估18

Adaboost:不断切切 让数据有权重

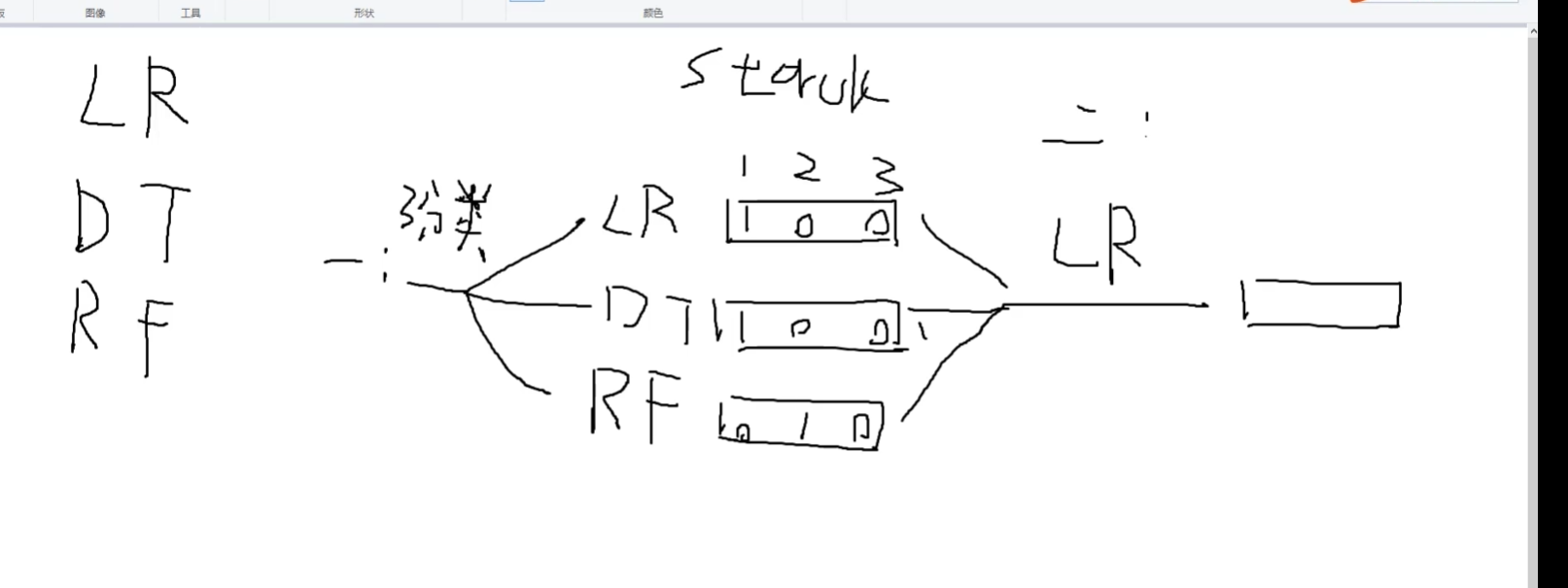

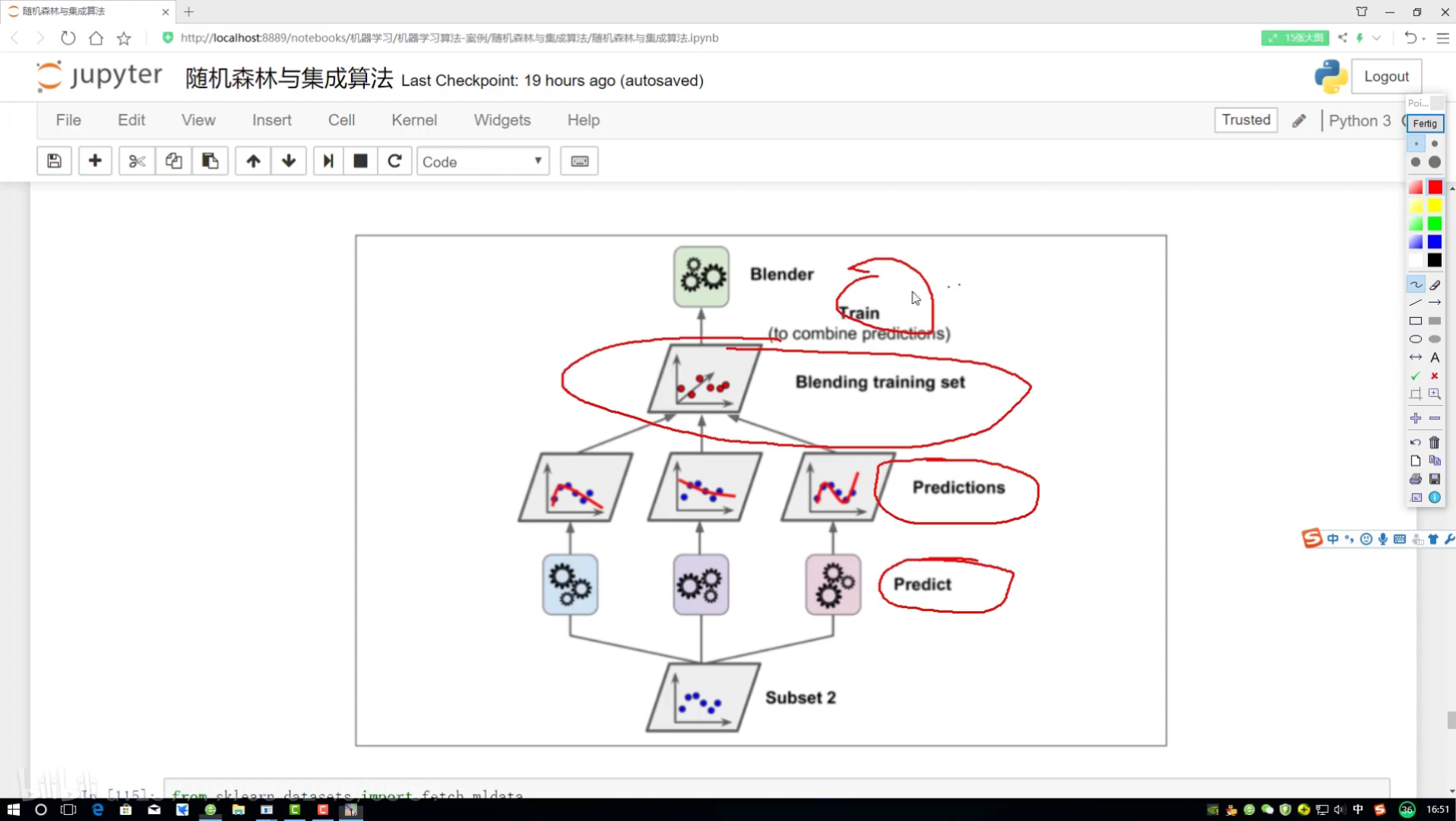

stacking:堆叠算法

LR:逻辑回归

DT:决策树

RF:random forest随机森林

stacking:堆叠算法 不常用

第一步多种 算法LR/DT/RTF得到多种输出

第二步 就选一种算法得到一种输出

集成:3种

1.随机森林式:并行

2.Boosting:提升 一点一点去做 234有关系

3.stacking:

第一步多种 算法LR/DT/RTF得到多种输出

第二步 就选一种算法得到一种输出

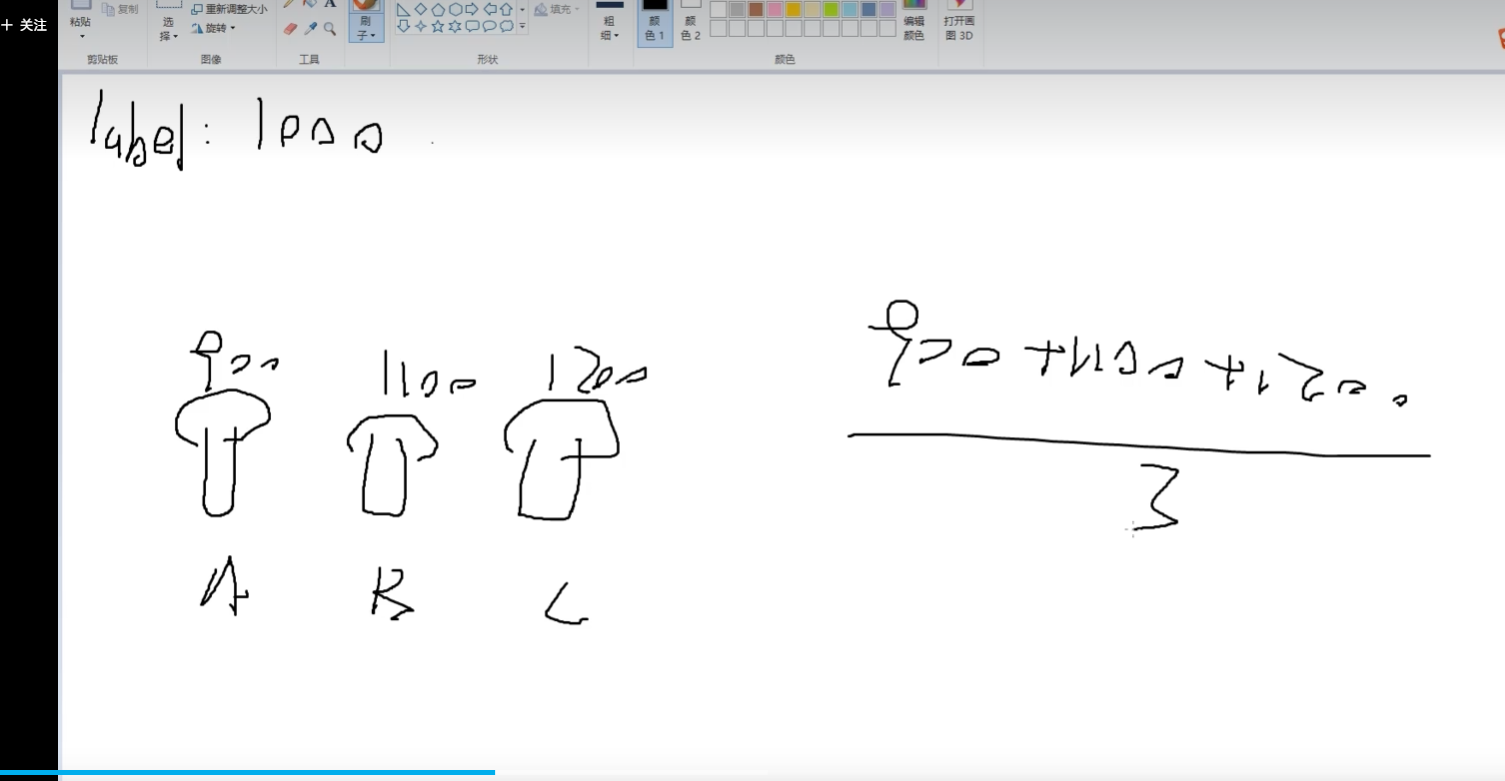

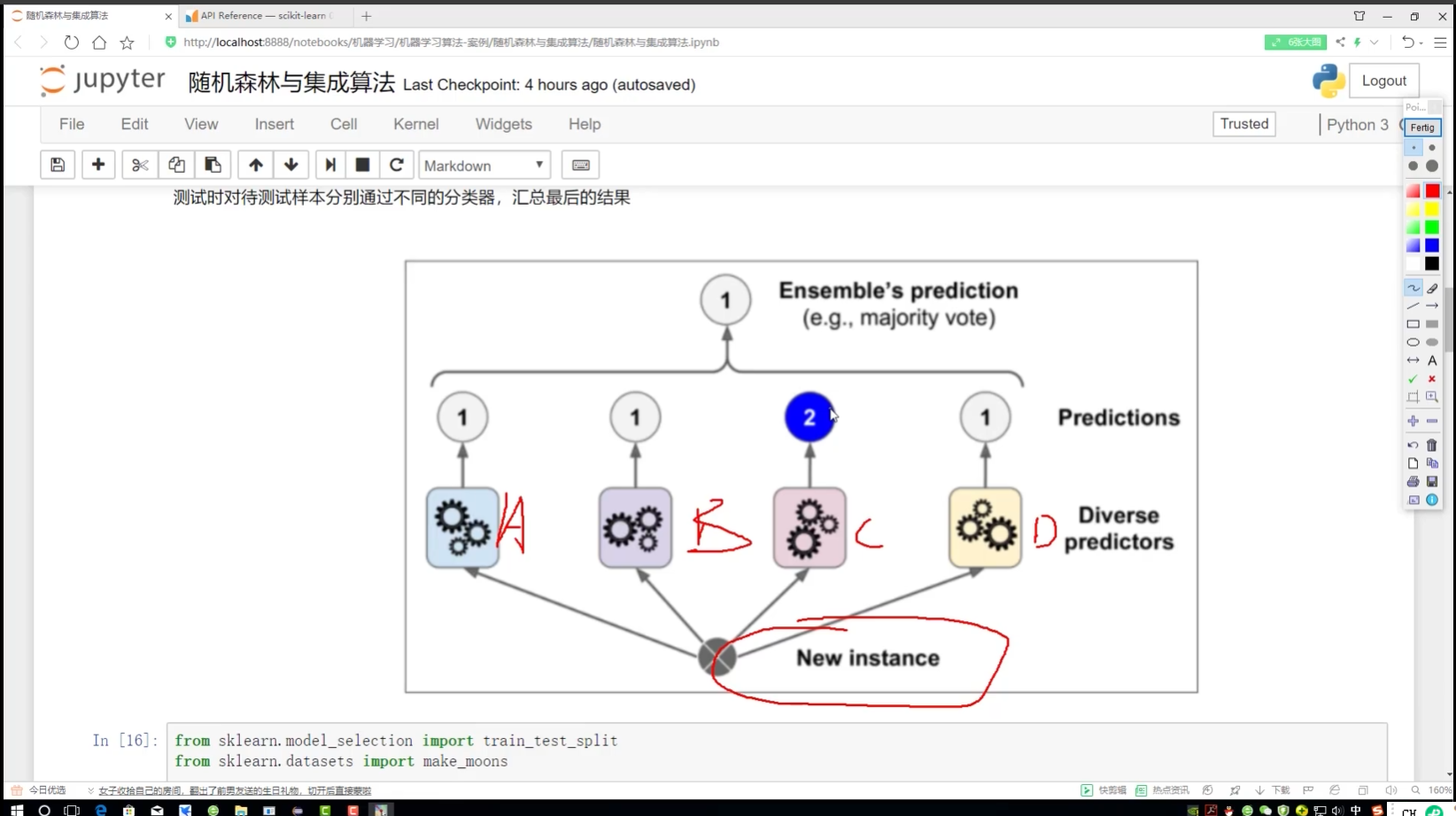

集成算法思路:

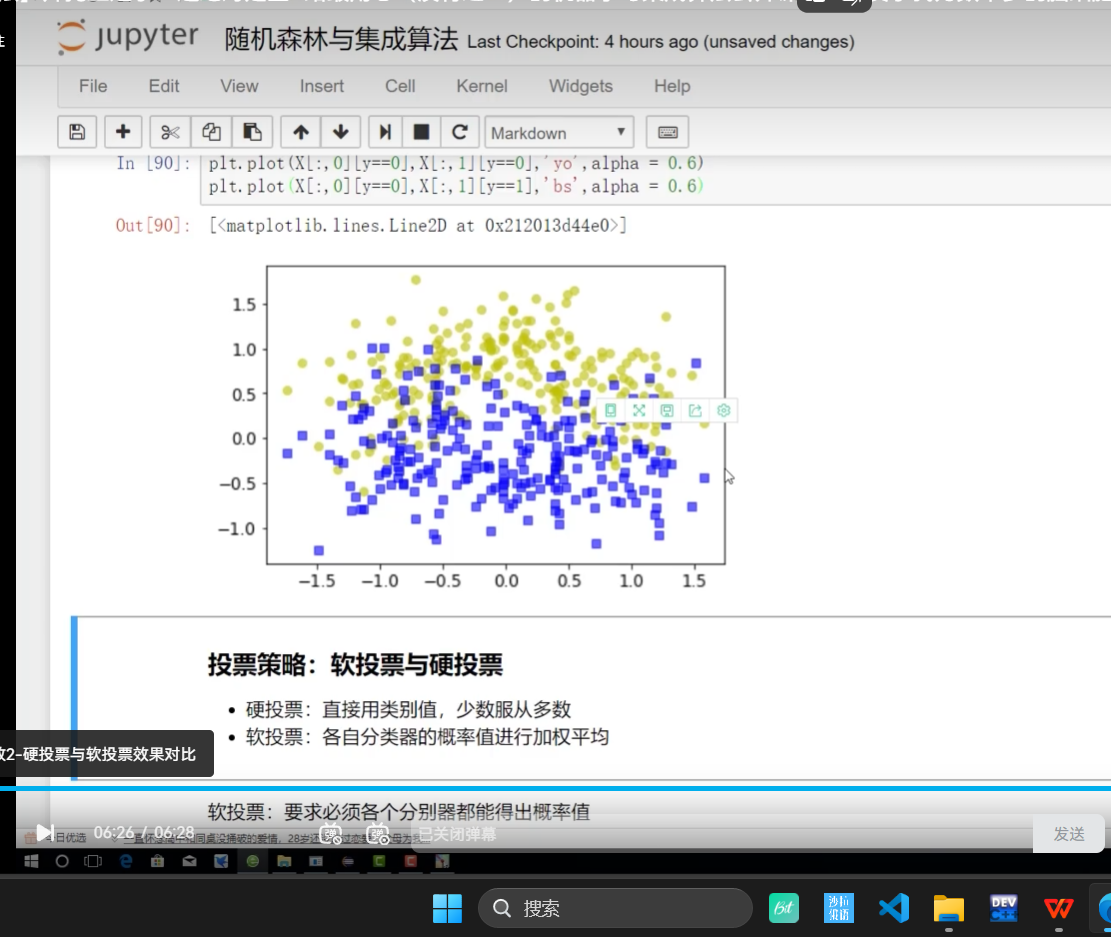

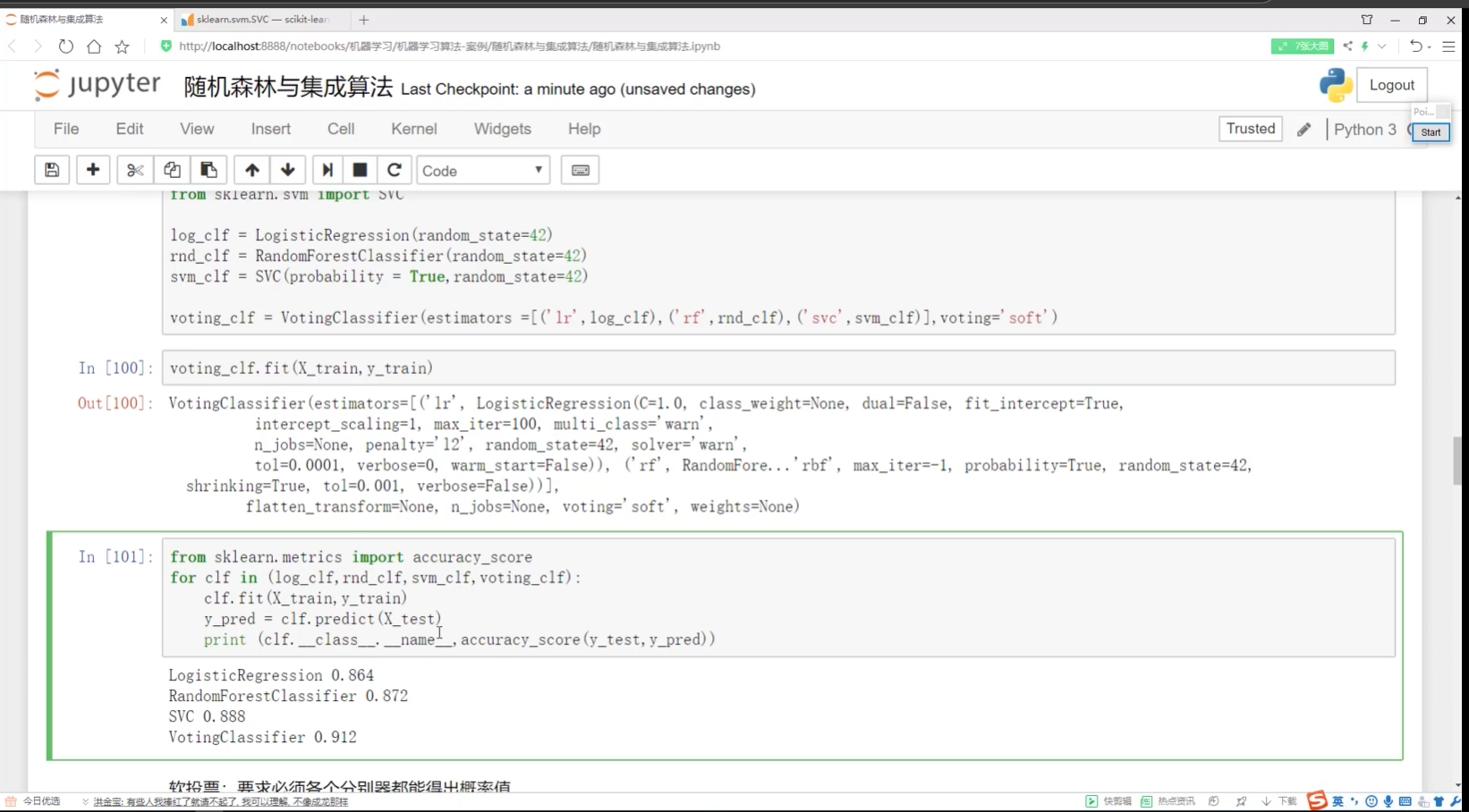

软投票:对概率加权平均

不认为类别:<0.5 认为类别:>0.5

不想上课

ABC:可能点名 D:非常可能会点名 soD 会点名,去上课了

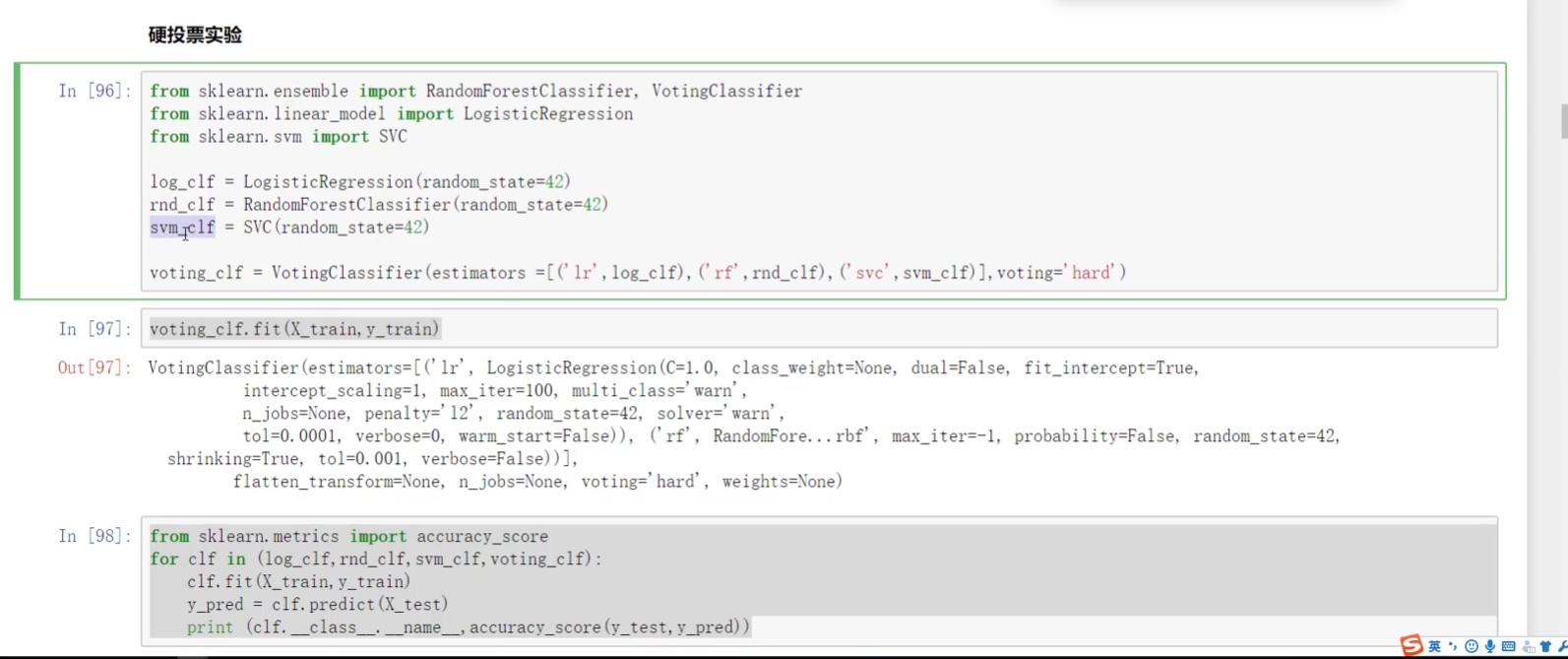

硬投票:只用结果

C∈2类 2类太少 soC归入1类

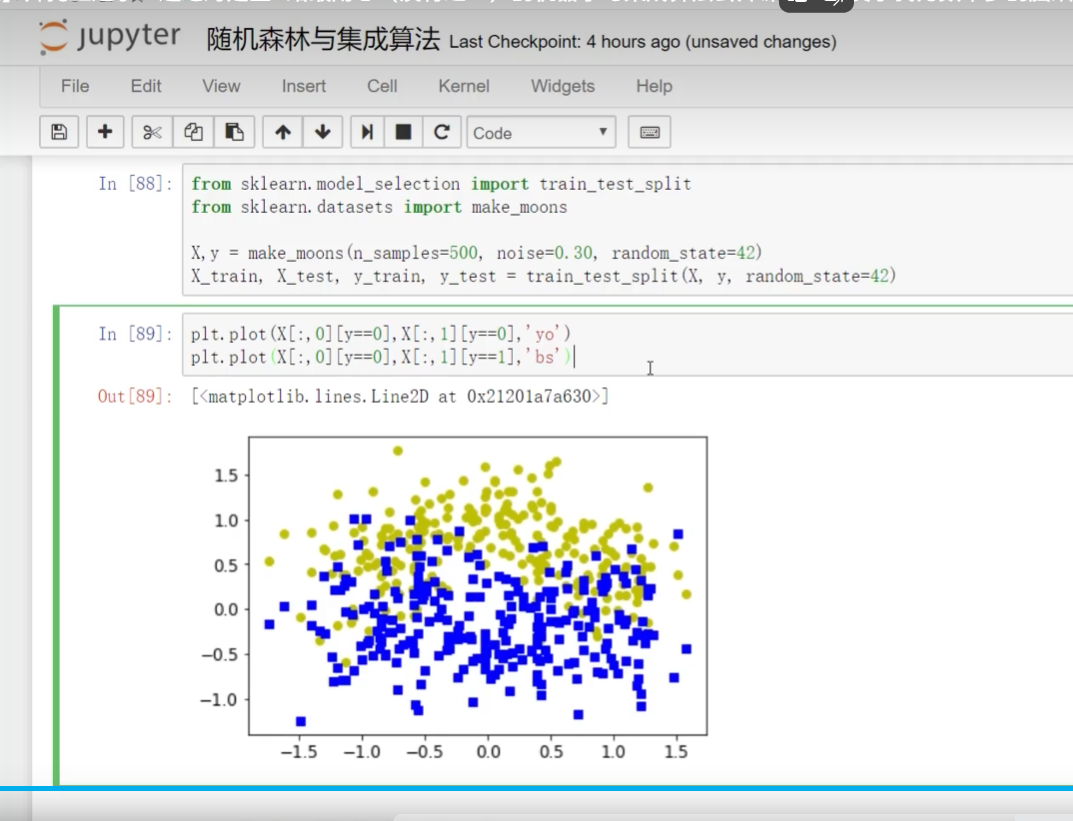

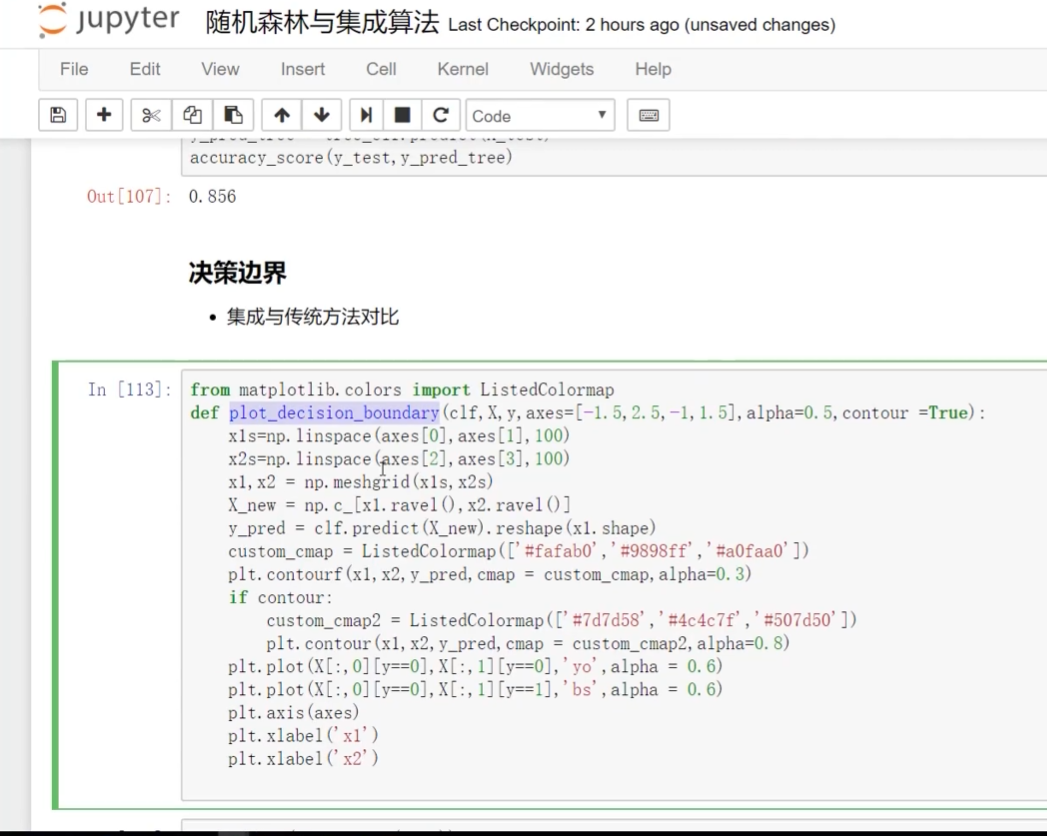

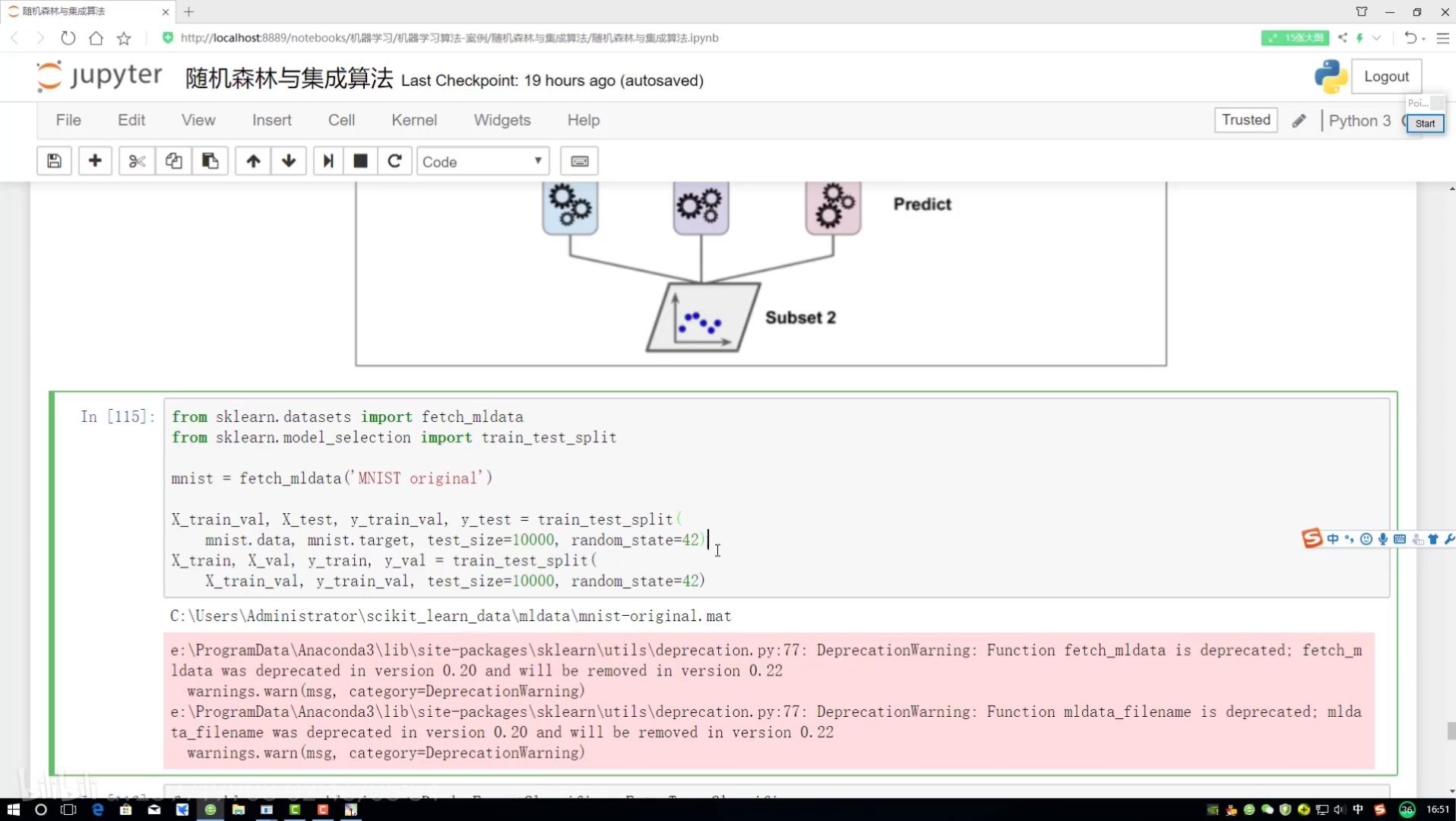

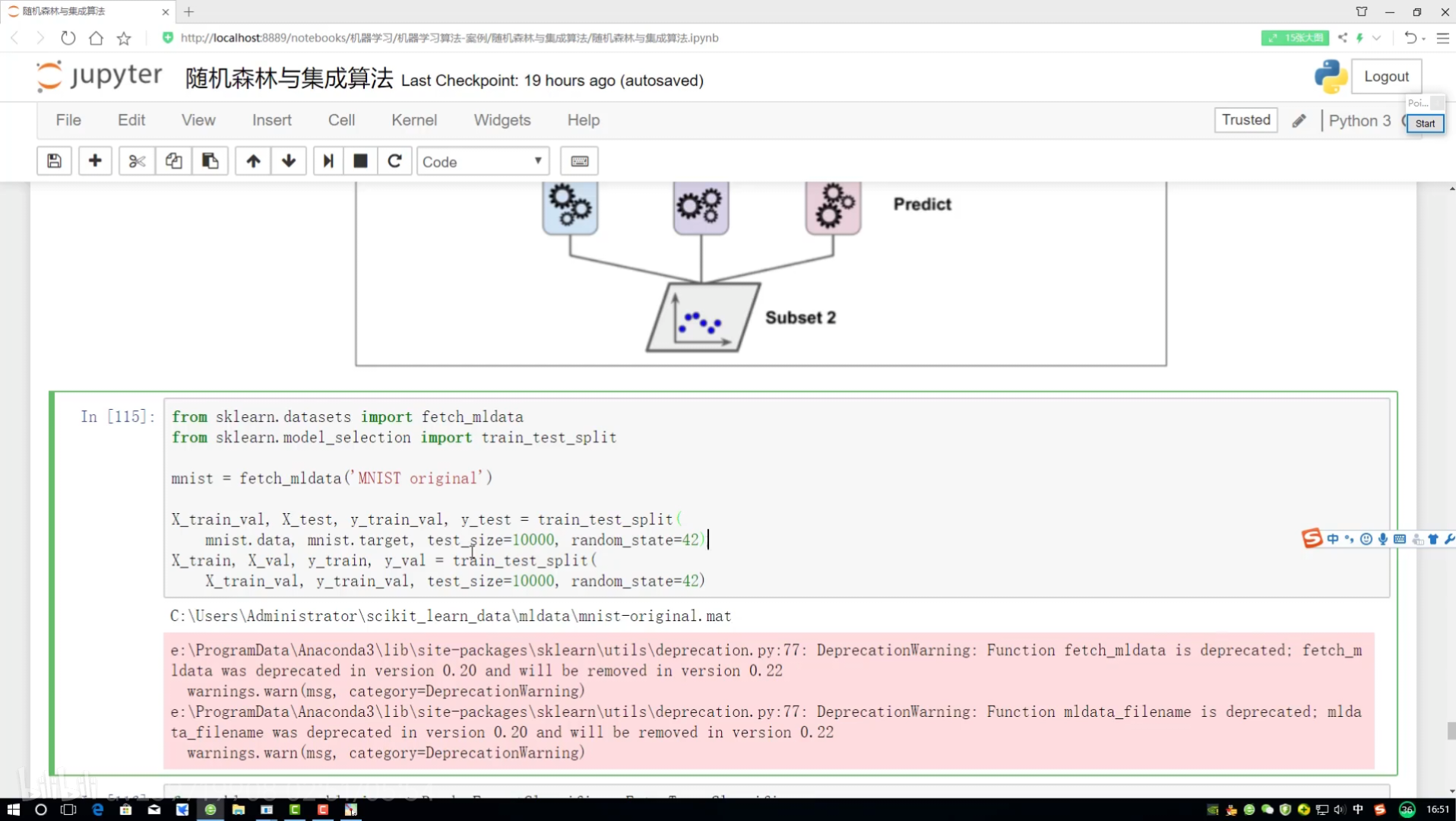

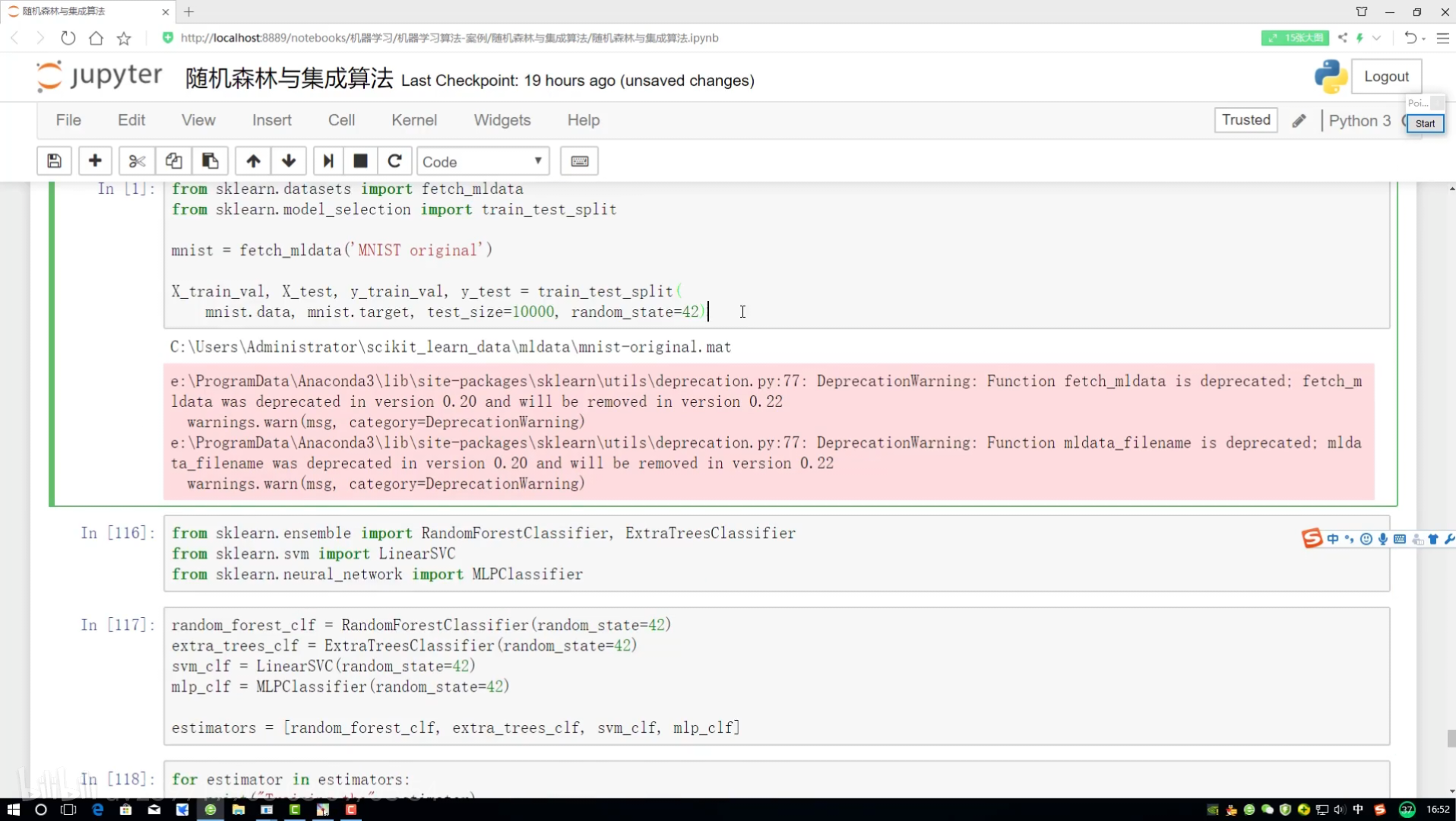

导入数据集selectio split切分

加了一个alpha:突出程度

选算法+选类别值

找分类任务的投票器

clf分类器

软投票:必须各个分类器都得到概率值

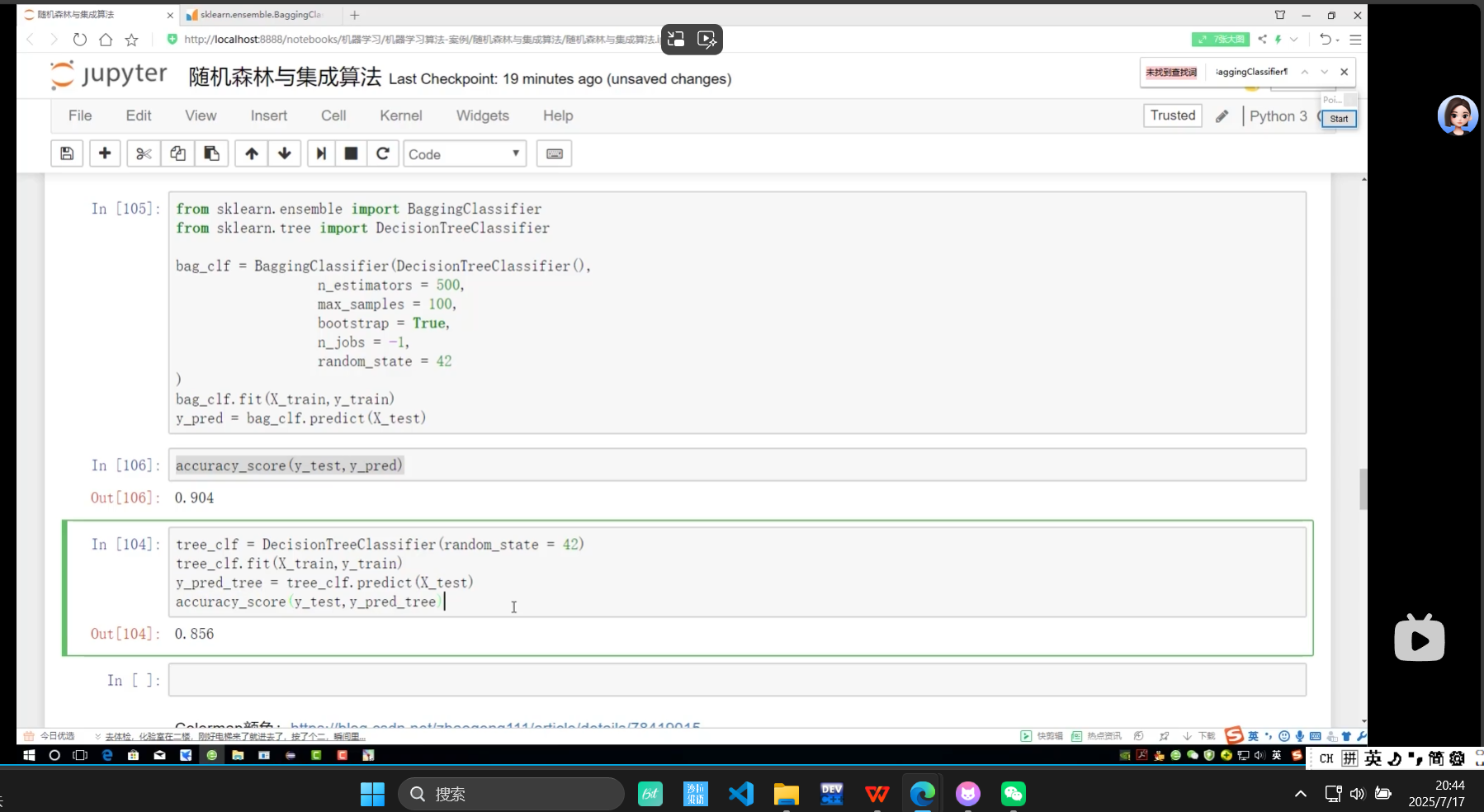

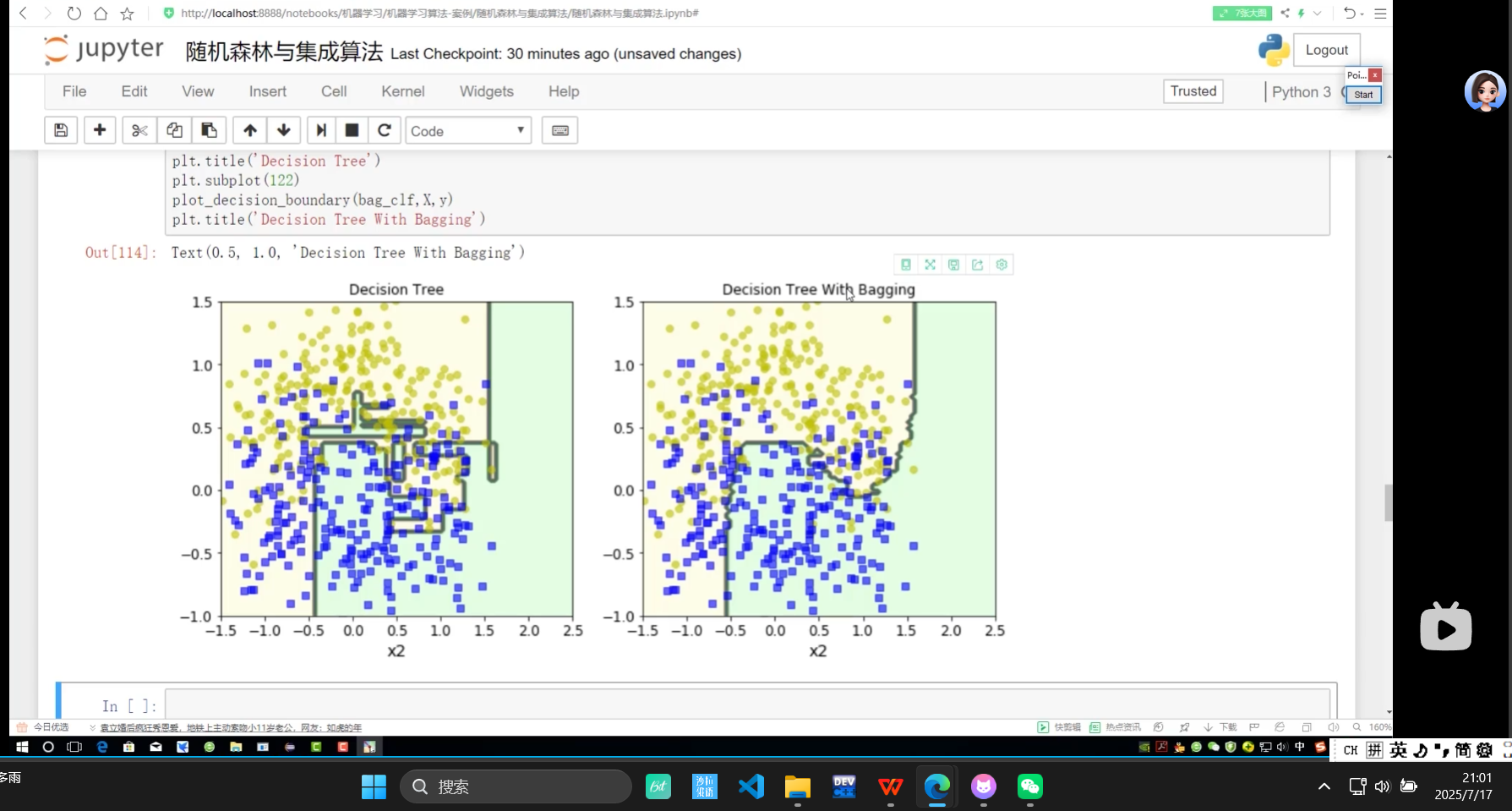

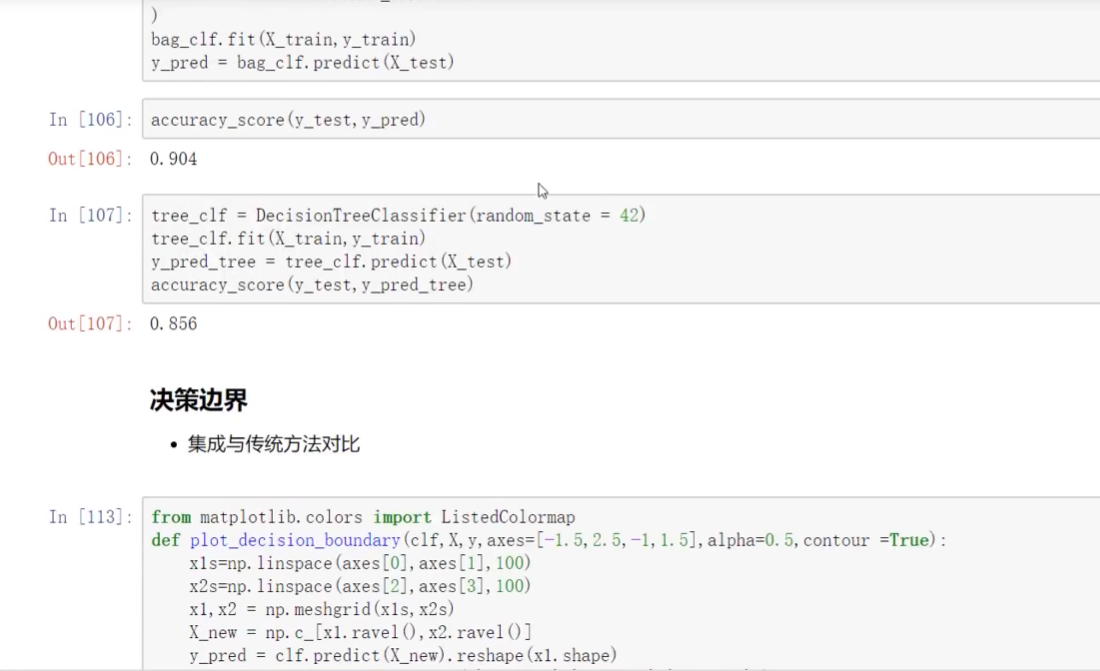

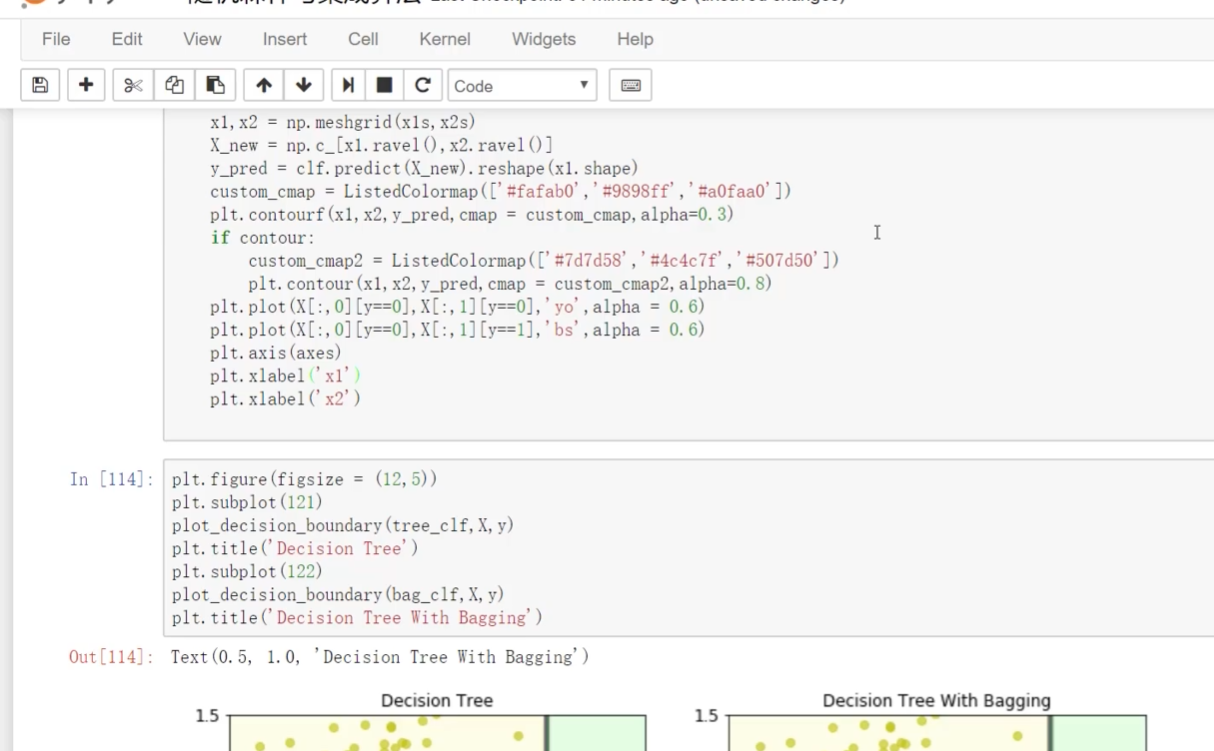

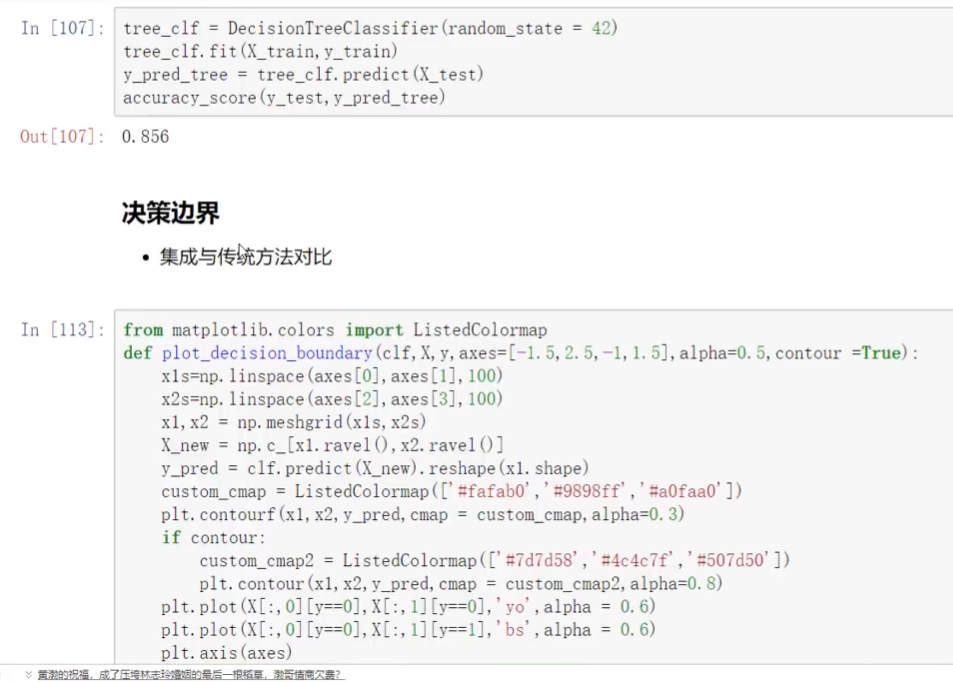

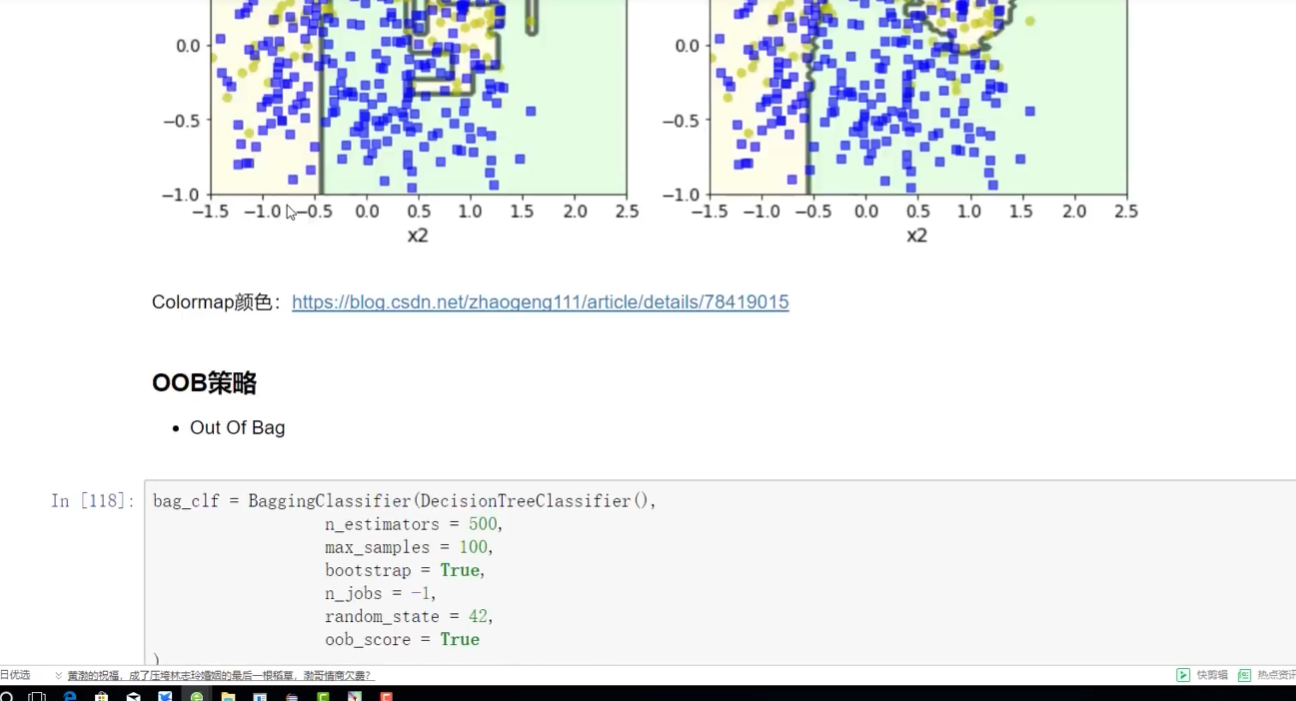

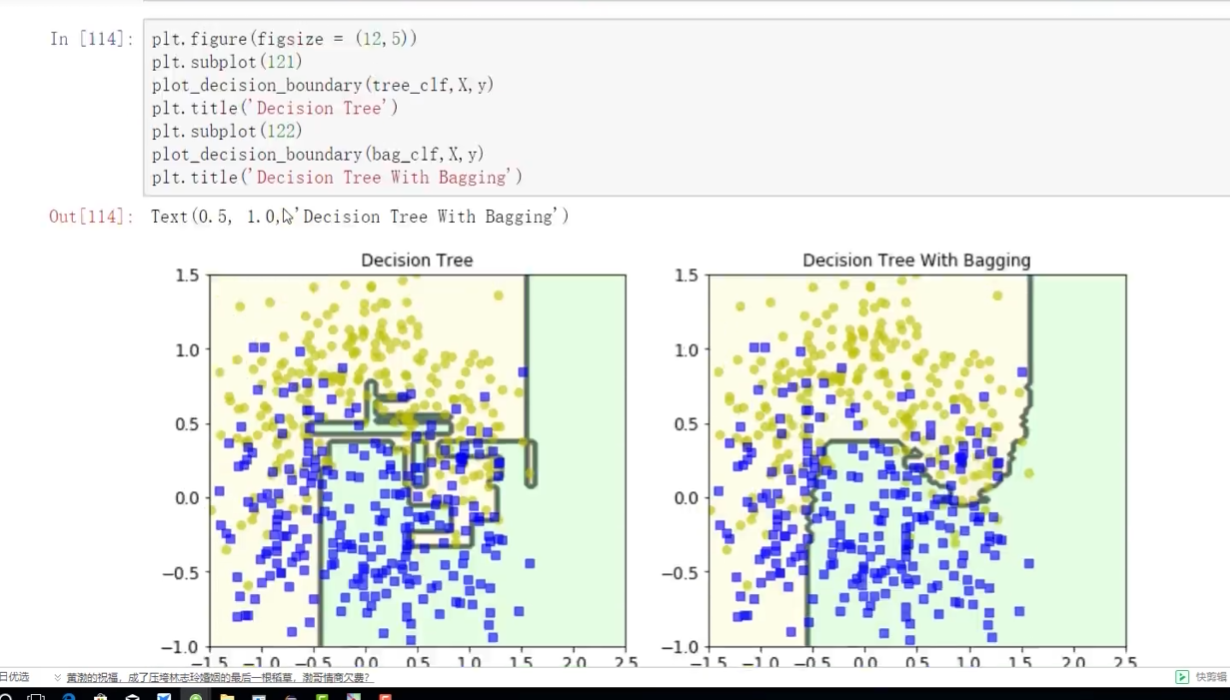

上面有bagging 下面是没有bagging

带bagging的更好些

OOB:代办数据 out of bag

加权平均

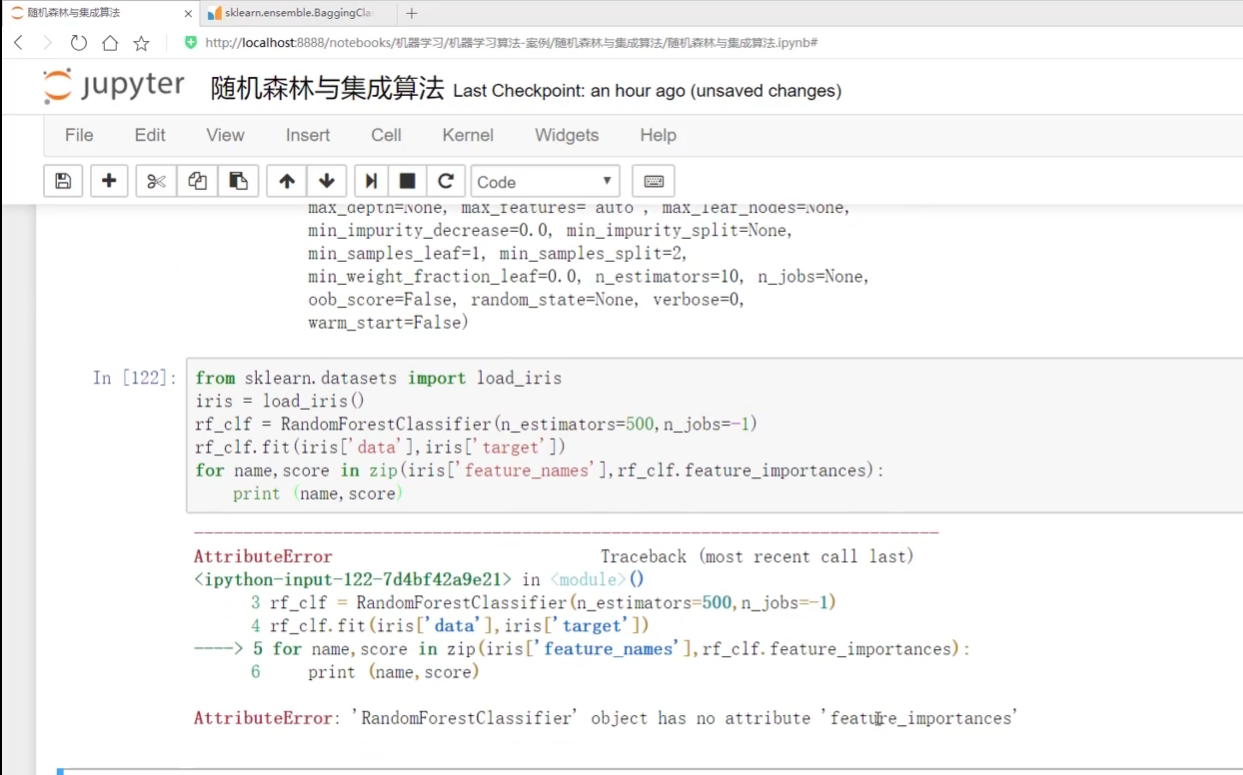

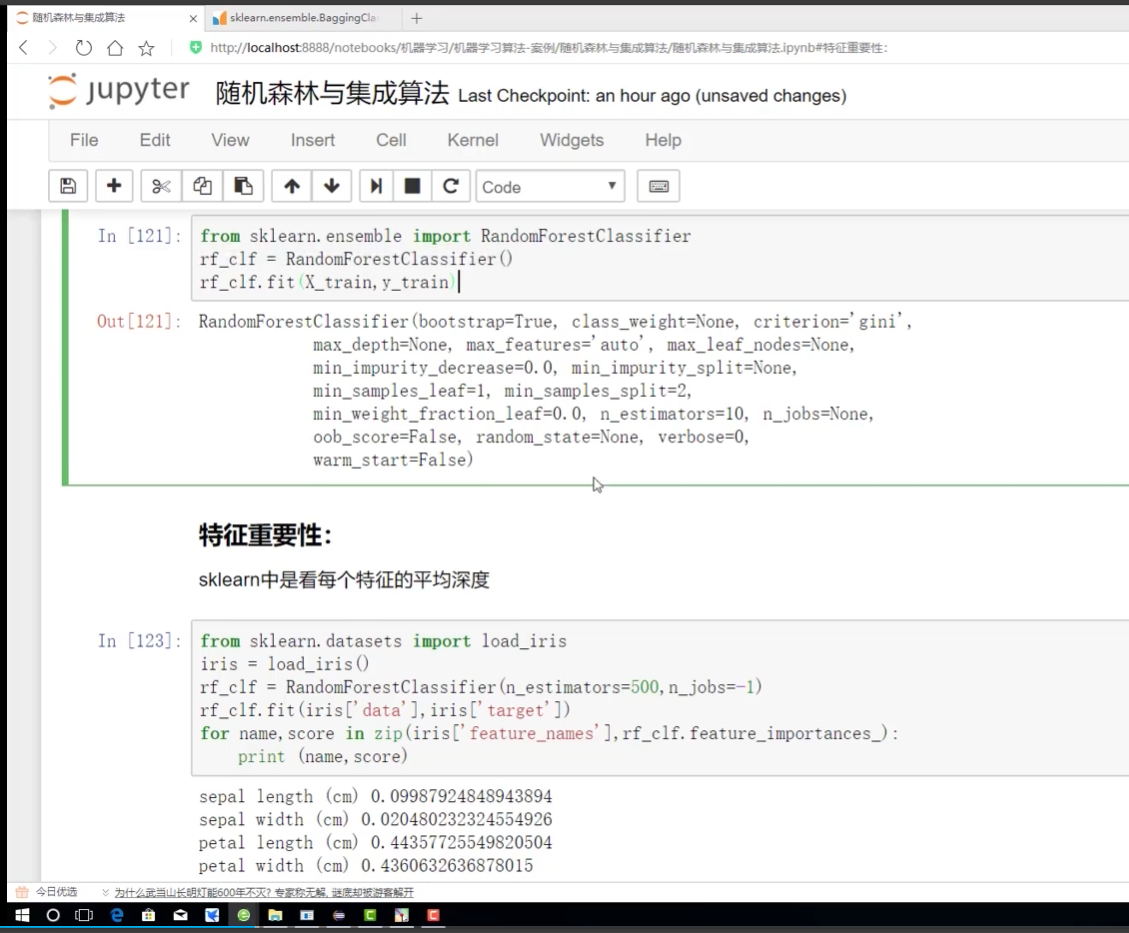

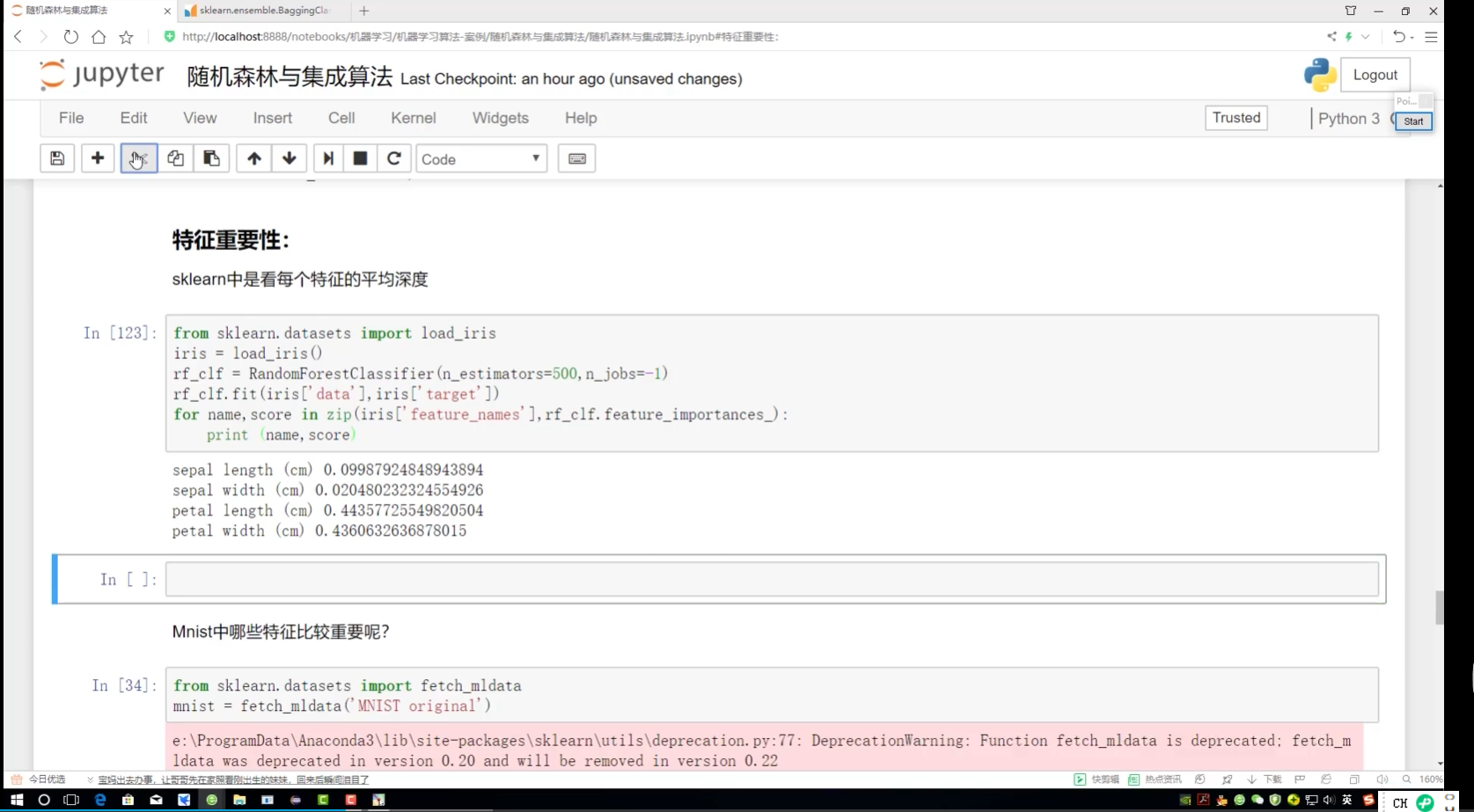

写train 让他们有属性可以调用 属性里面有一个:特征多样性

但上面X1,X2不好分辨

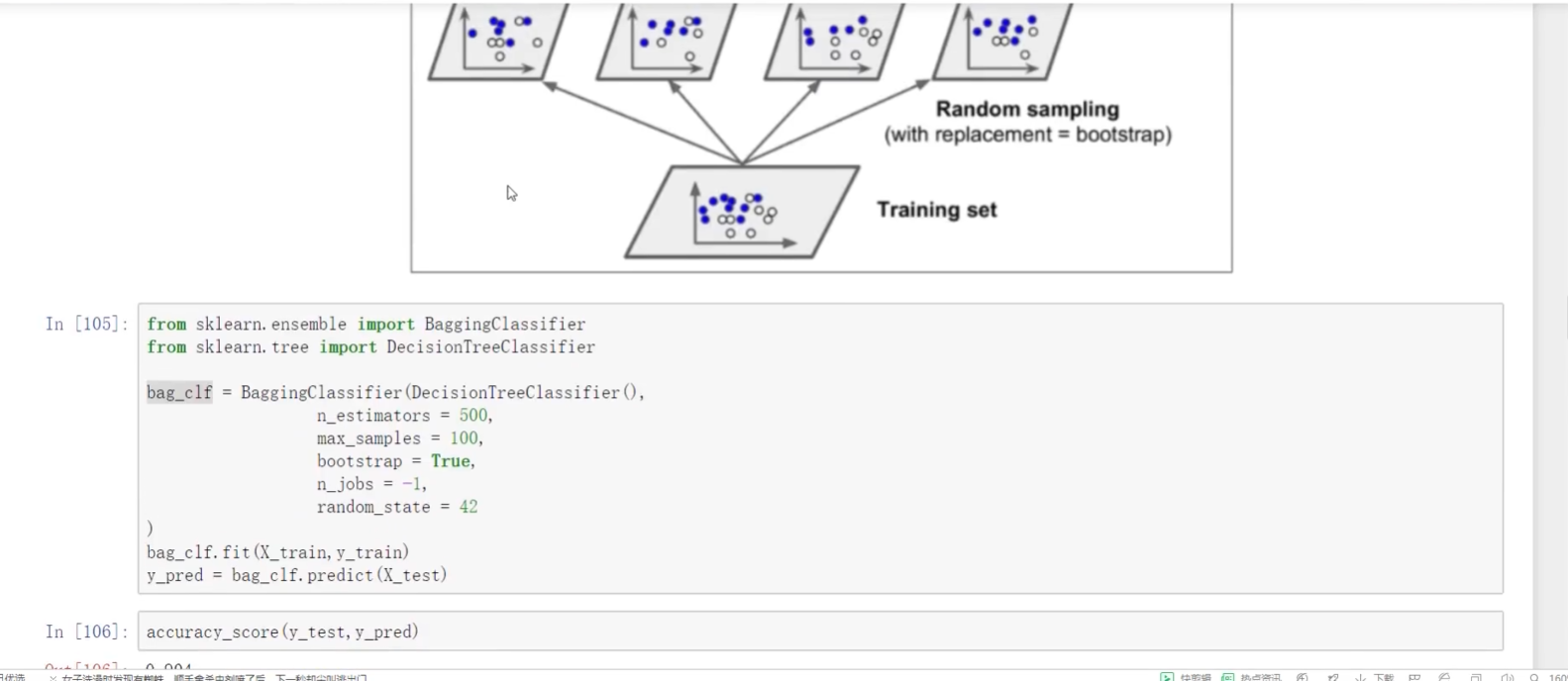

先实例化树模型

.fit当前数据 找到data 找到标签 .zip 结合完当前对象 .feature

Importances后面有个杠

sklearn 做法

数据越重要:越前 离根节点越近

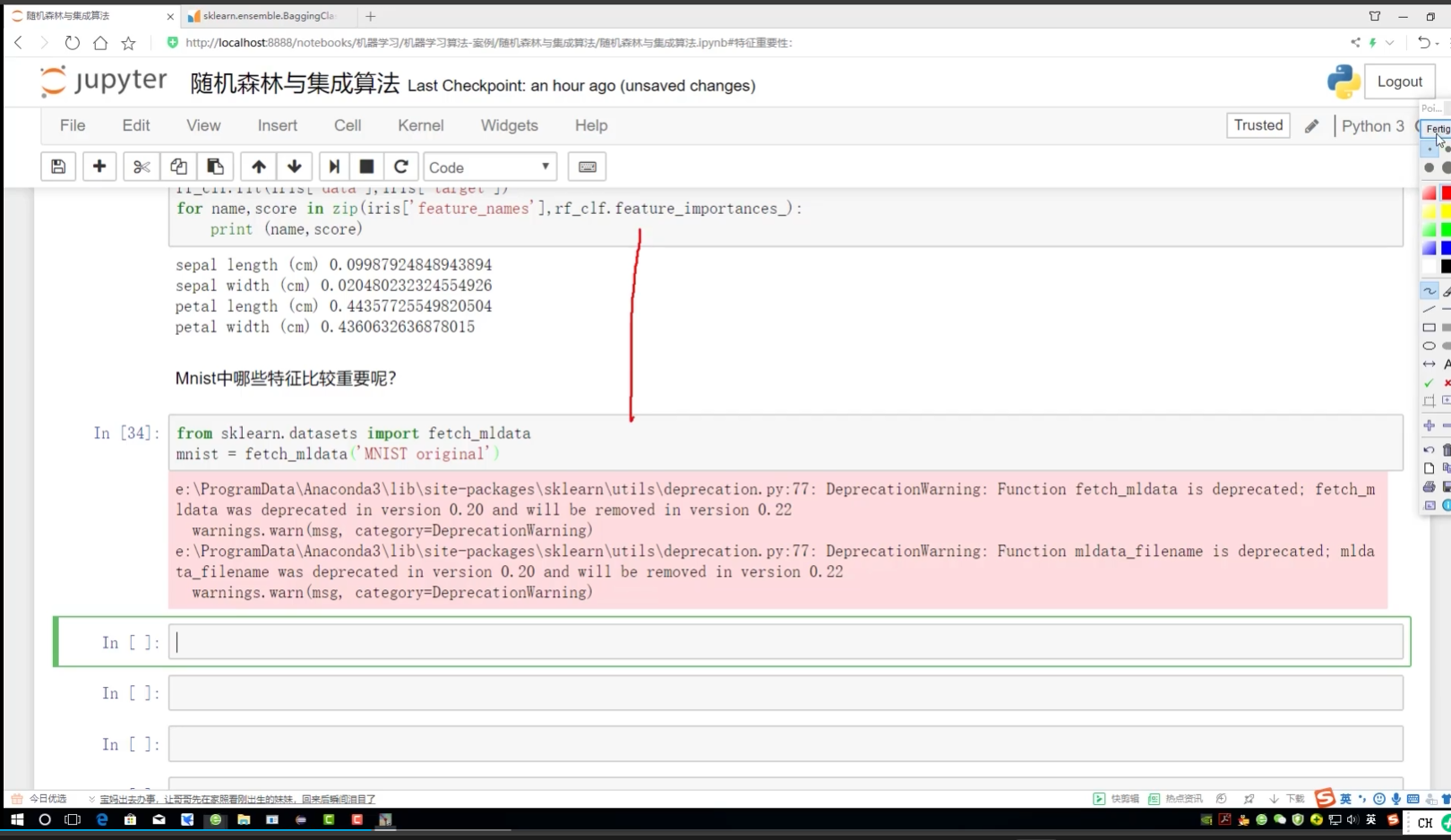

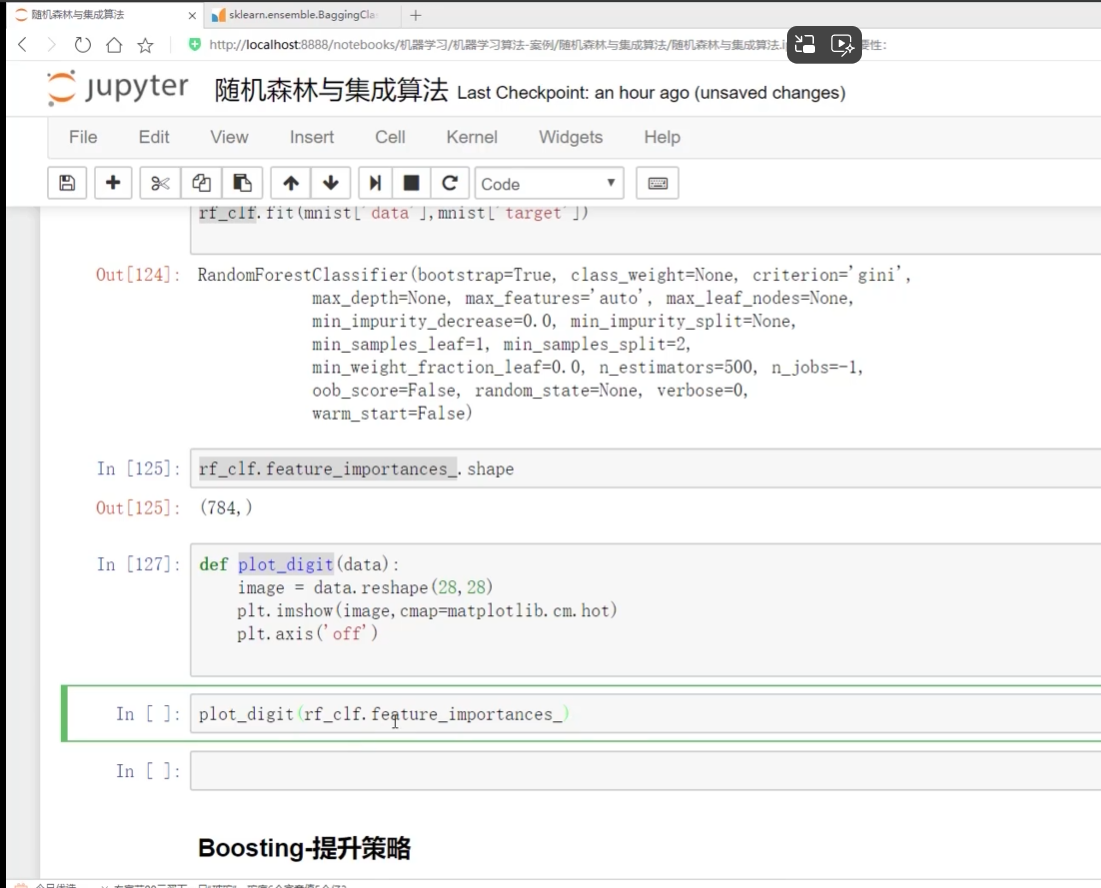

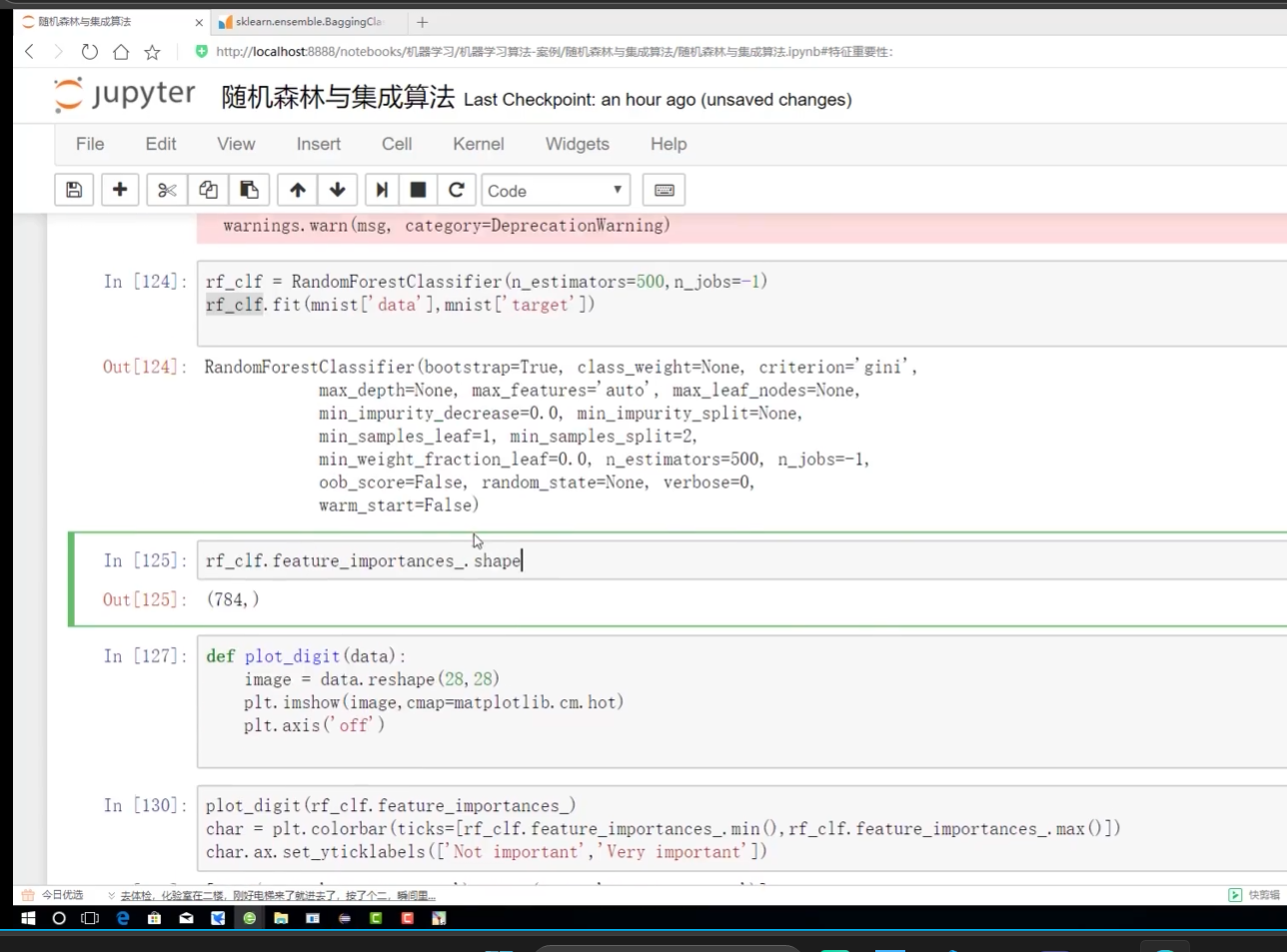

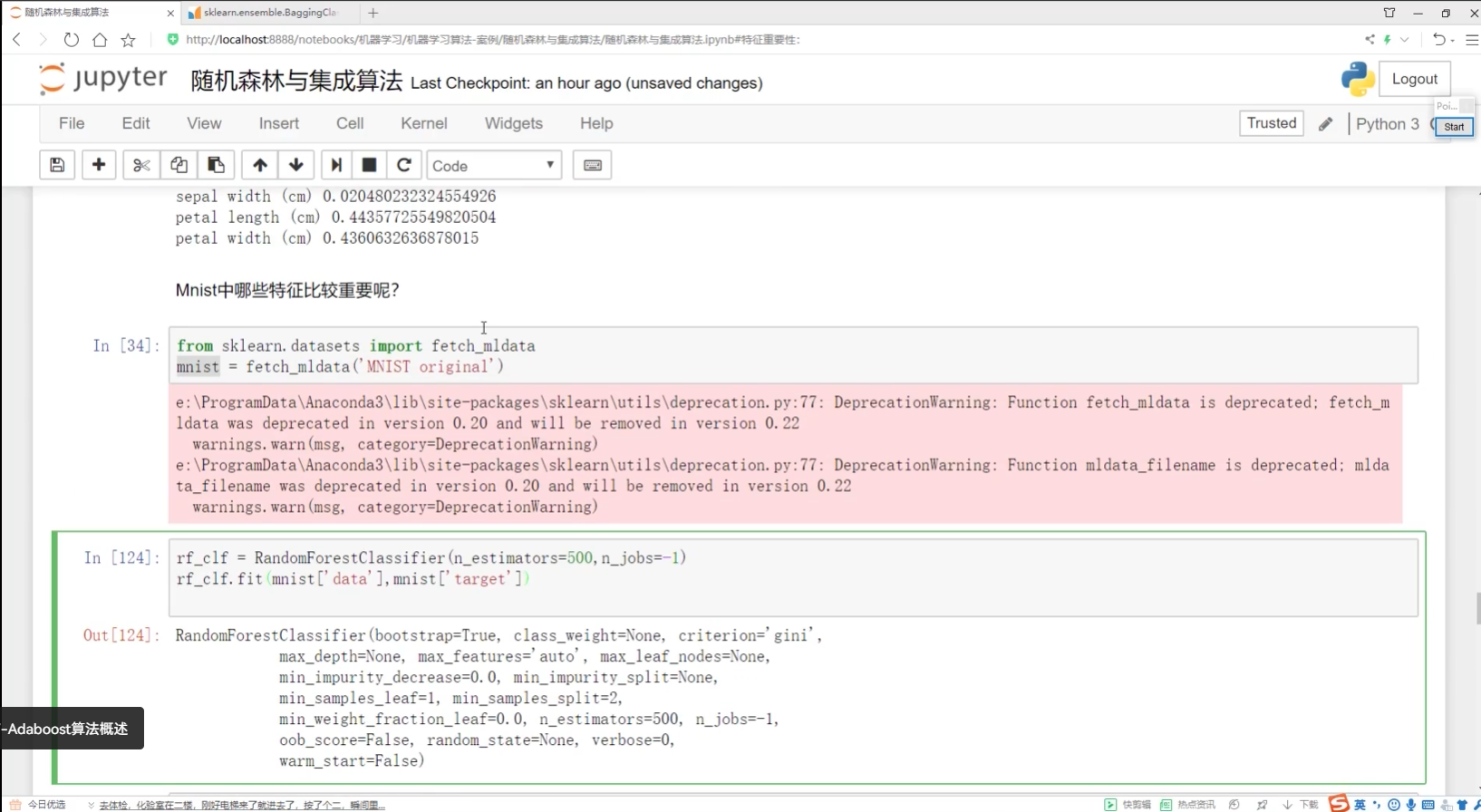

创建了MNIST 做随机森林 看特征多样性

_.shapes 784个点--每一个点的特征多样性都可以算

画热度图

热度图的图像展示

展示当前图像

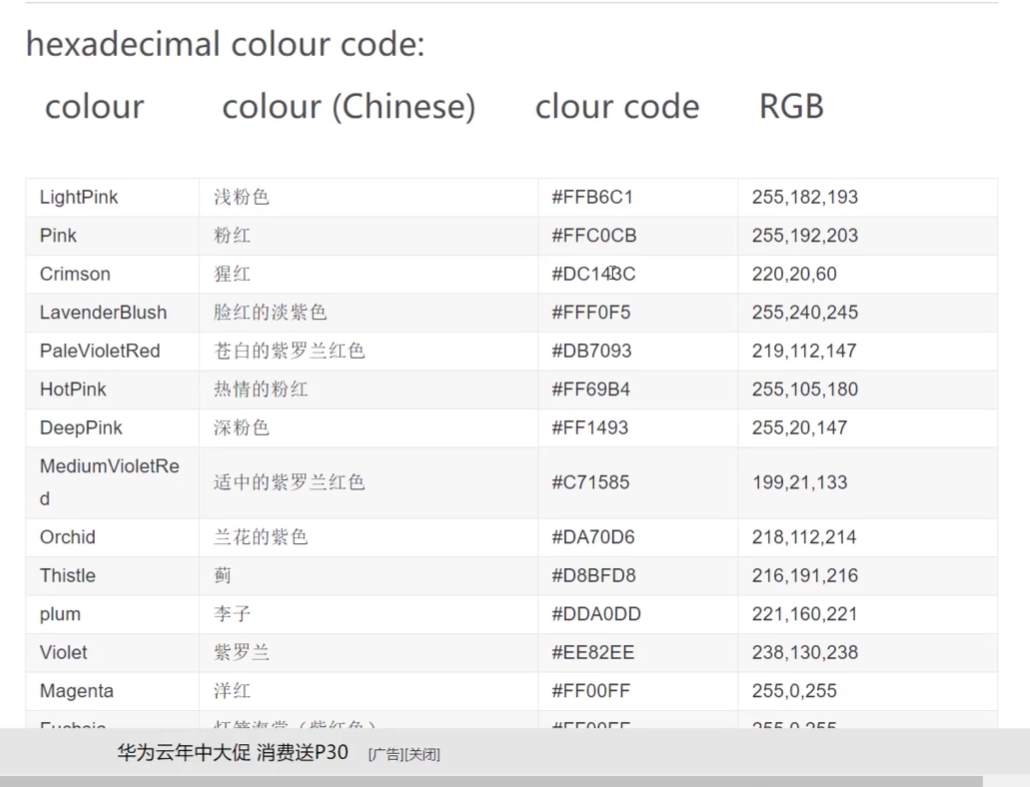

指定颜色,默认颜色,

off去掉坐标轴

colorbar:深色代表什么 浅色代表什么

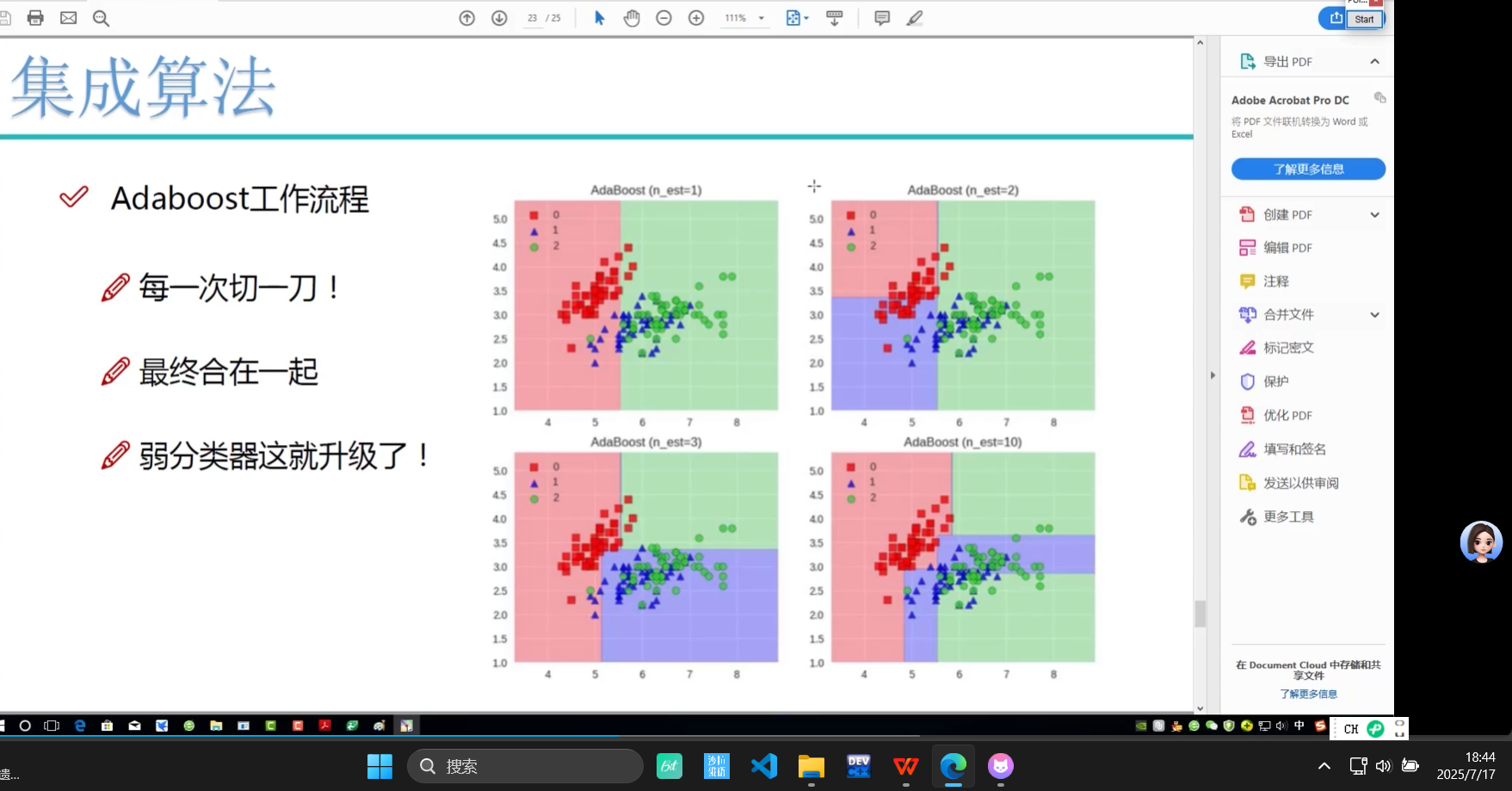

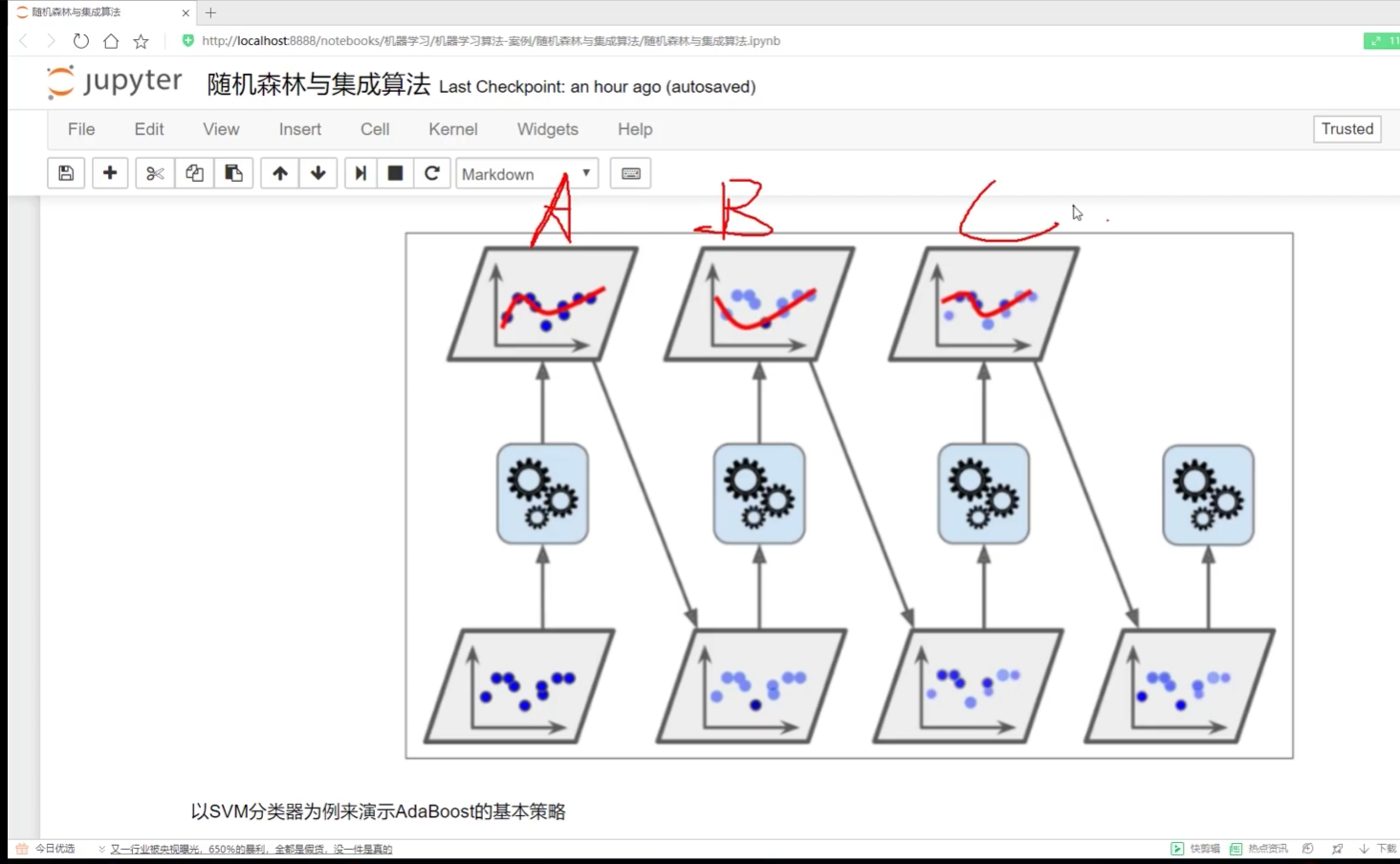

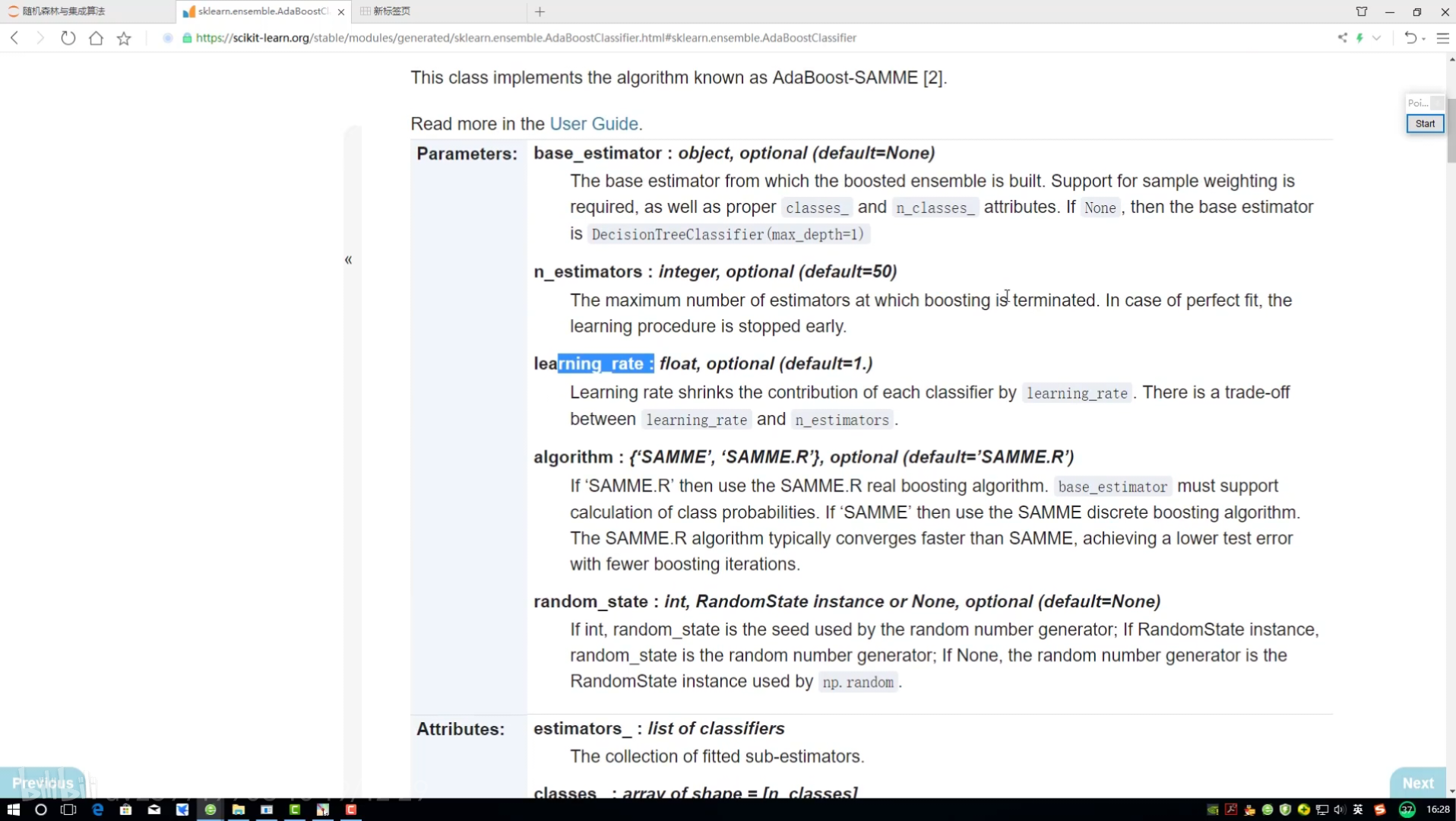

boosting:串联 一步步做

adaboost:调整权重-建模-调整权重-建模

像是整张试卷 现在做错题本 对的题权重变小 搓的题目权重变大

加权求和 模型效果好--权重越大

对每个样本进行权重赋值

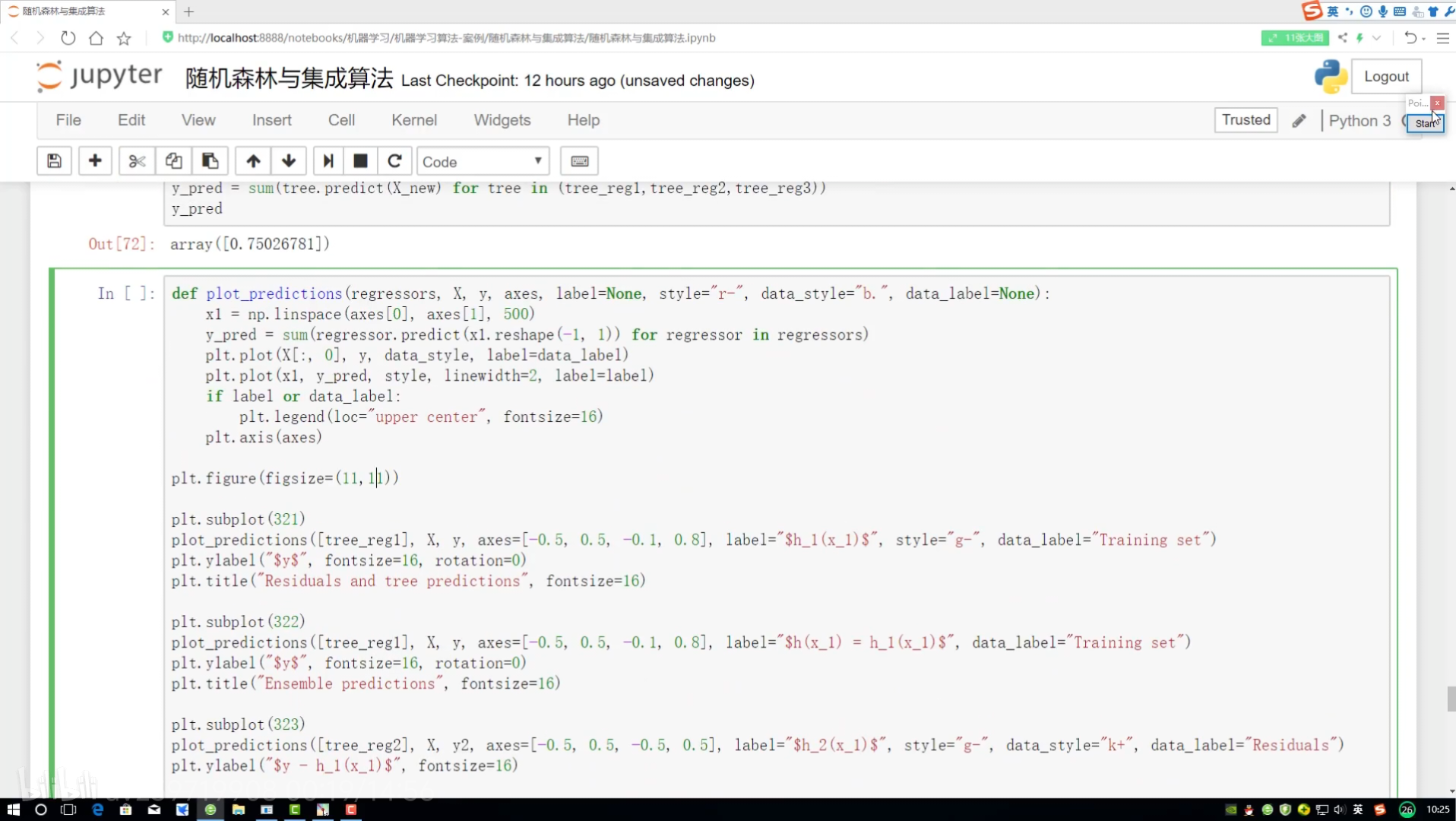

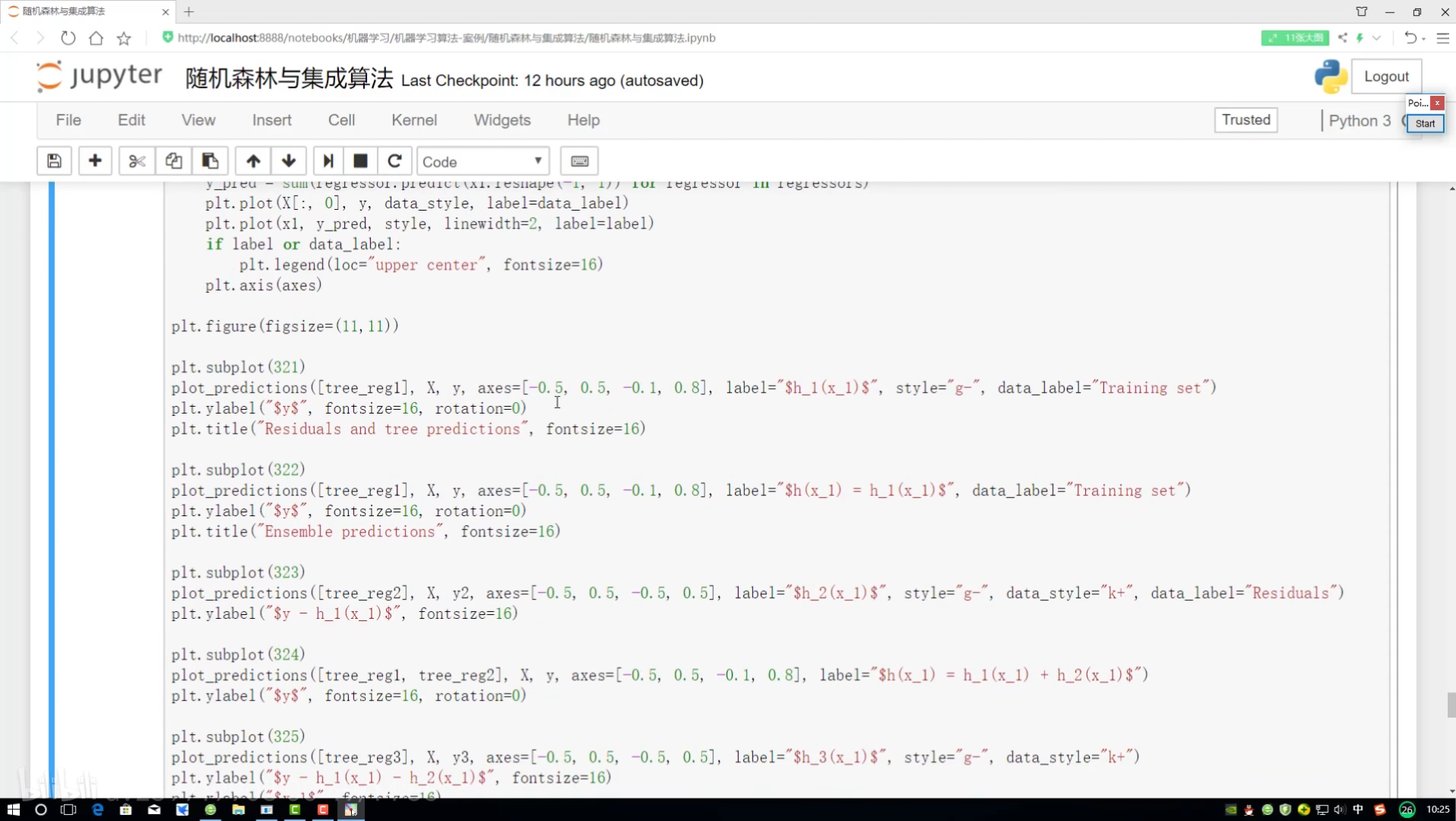

边画图边展示 画12*4图

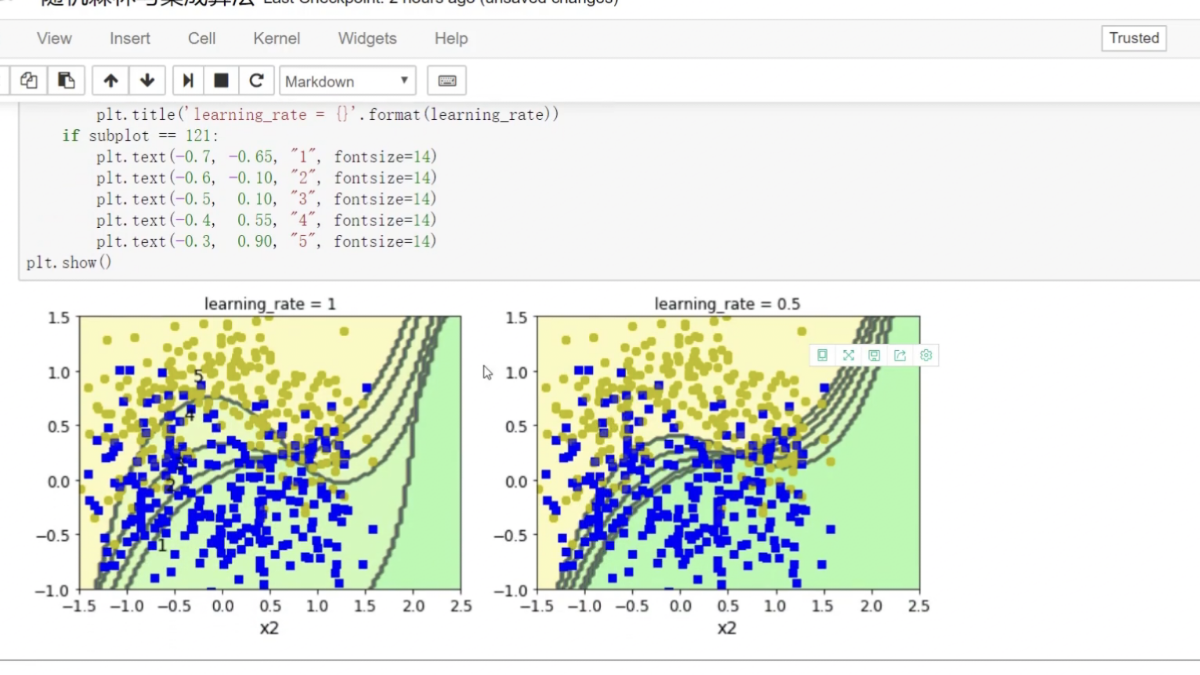

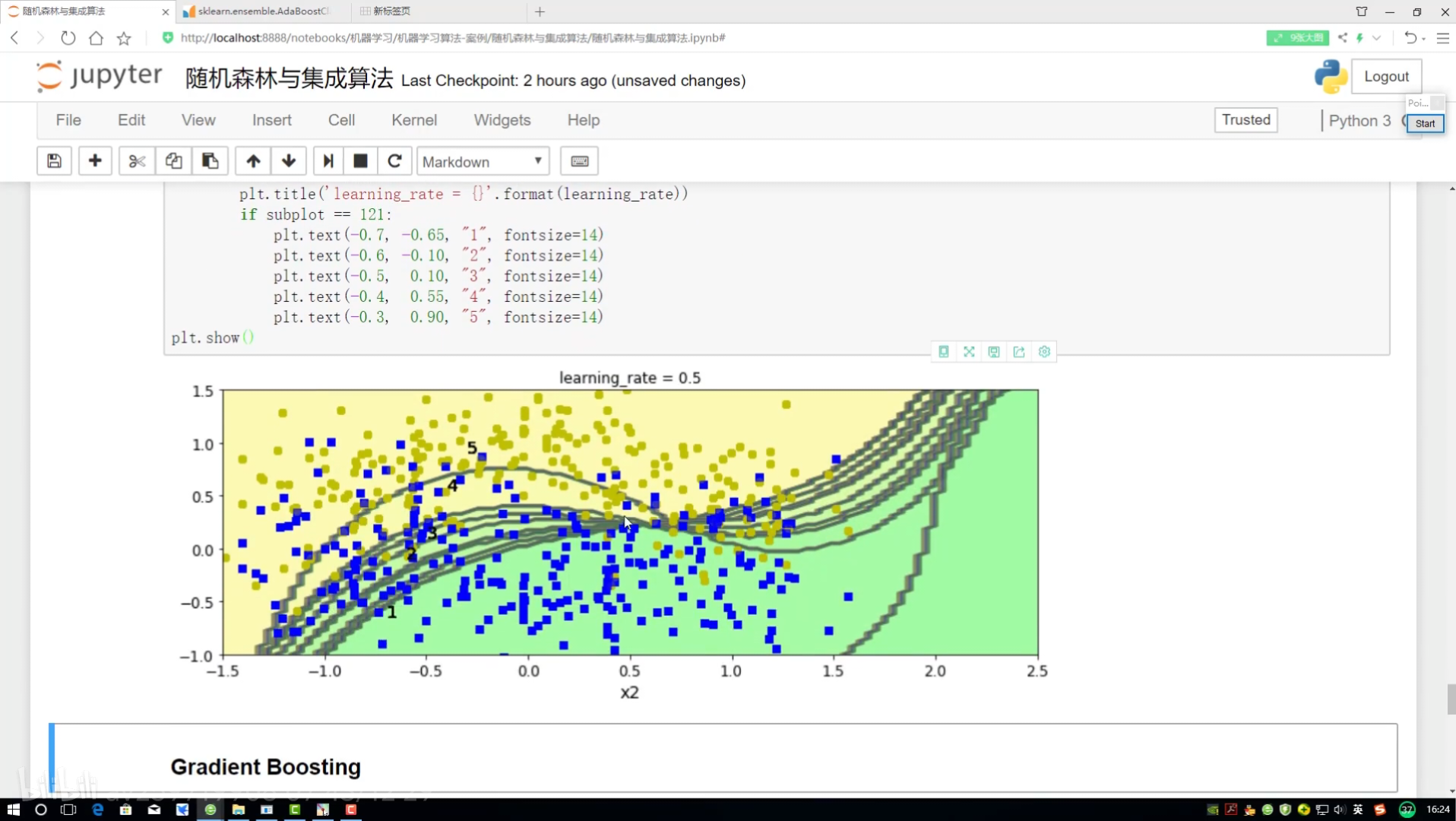

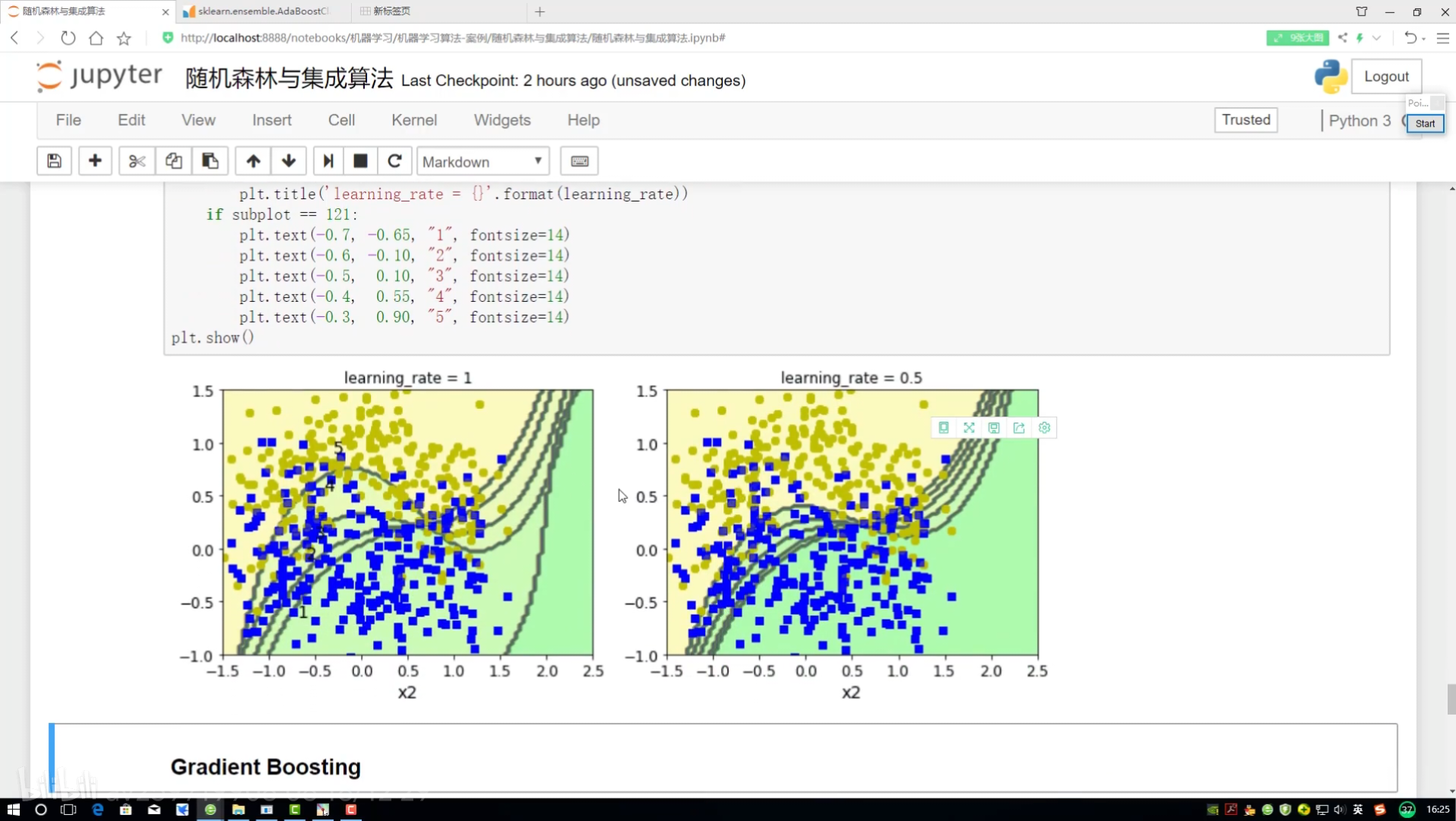

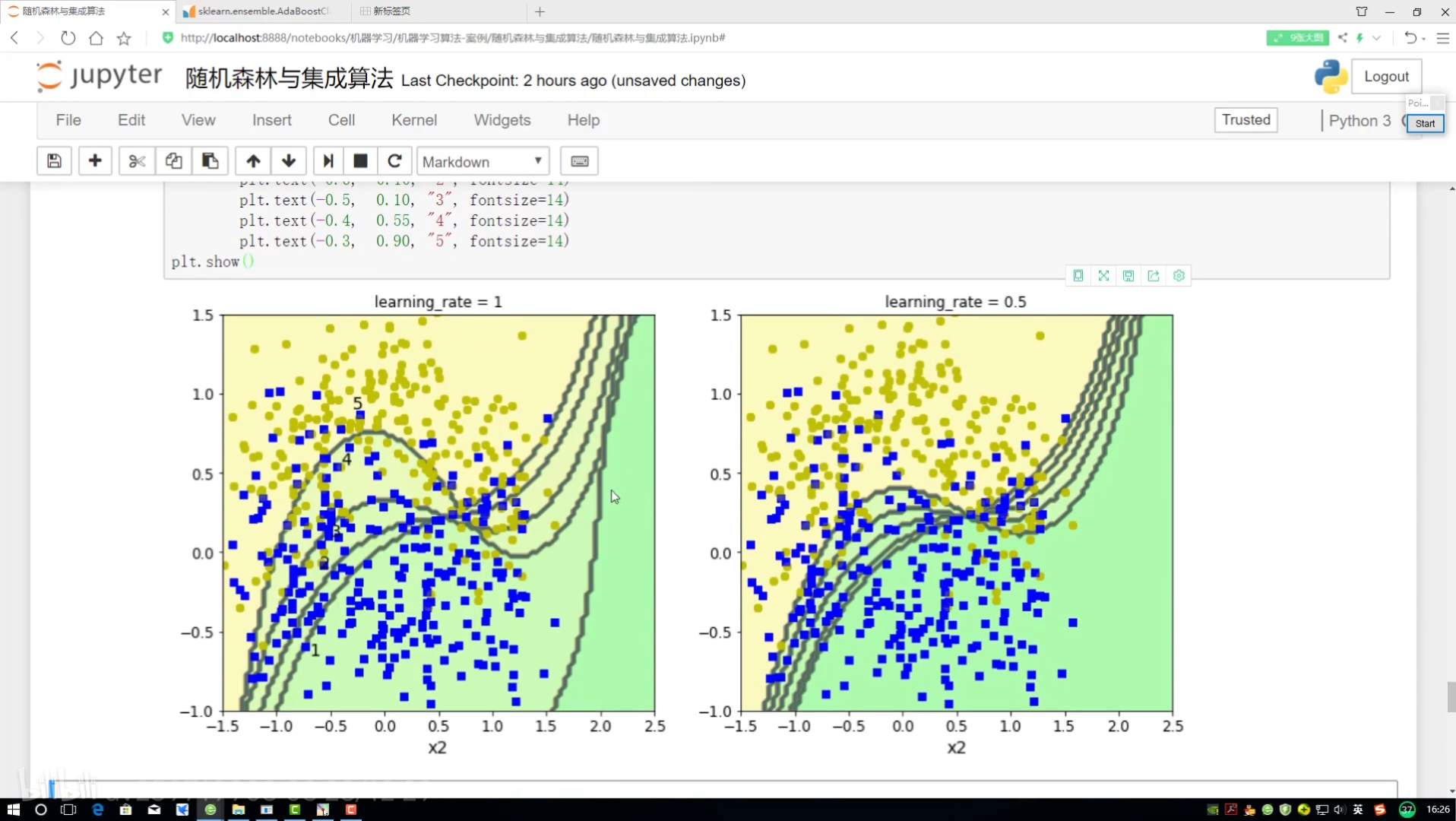

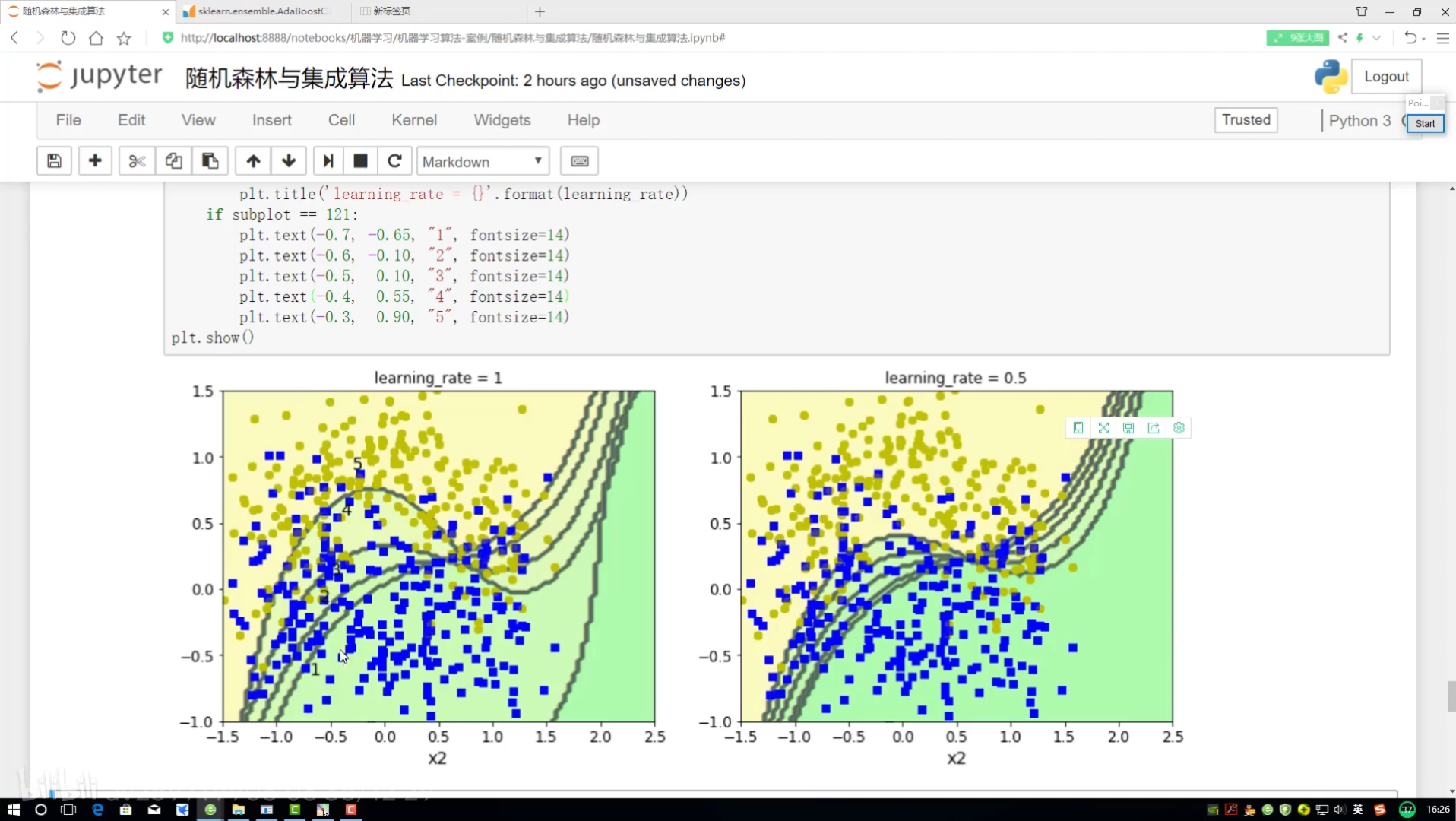

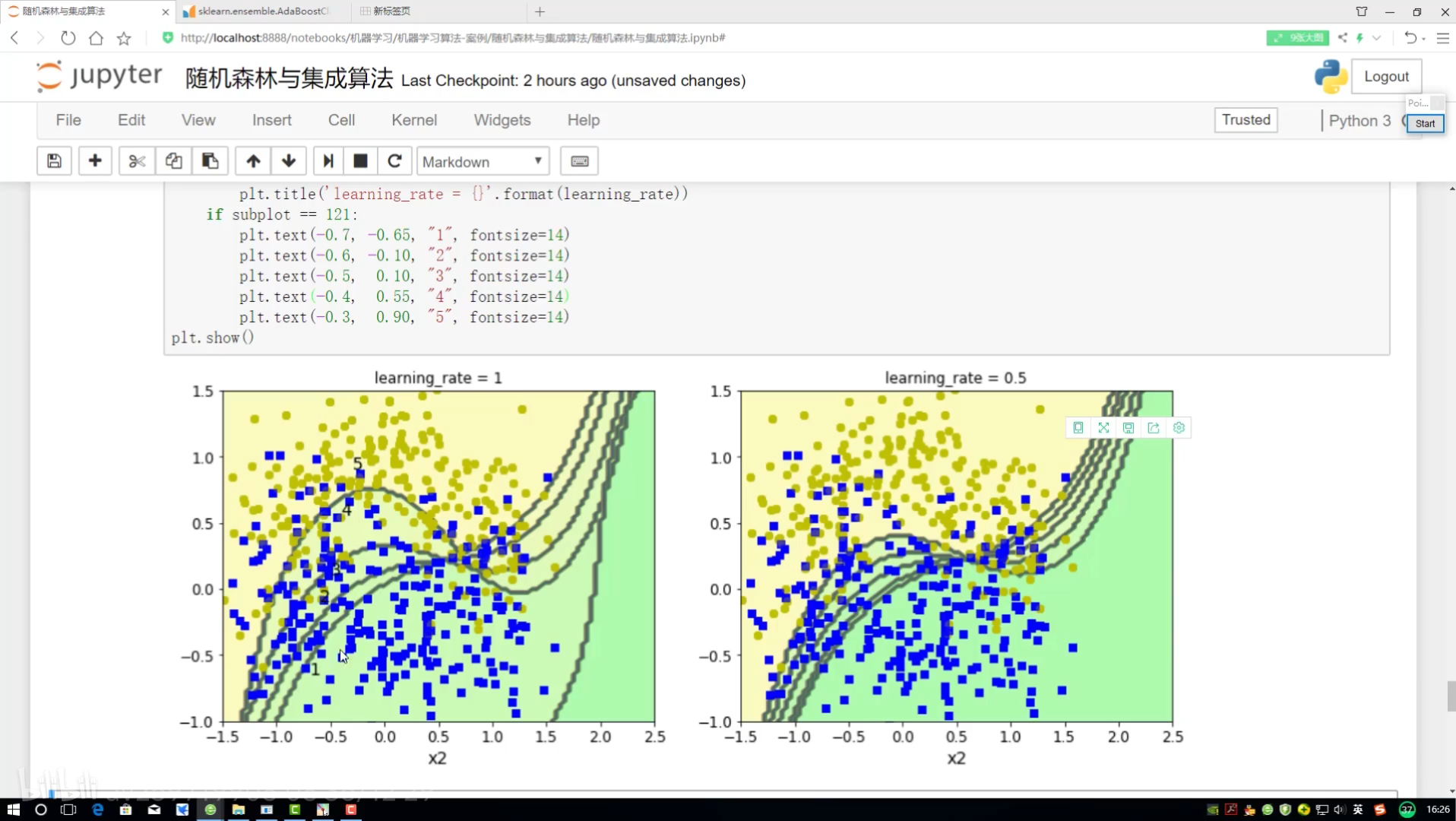

不同调节力度对结果影响 样本权重(更新速度 )(更新幅度)

kernel--和函数 rbf:高斯和函数 C:软间隔

实例化指定SVM的分类器clf

.fit一下(X_train,Y_train)

研究样本的权重项为多少

预测当前结果来展示

!= 不等 就是做错的 权重放大=(1+学习率)

找到定义画决策边界的函数

boundary:对样本权重进行更改

kernel:和函数 让特征量变化演示结果更好

软间隔

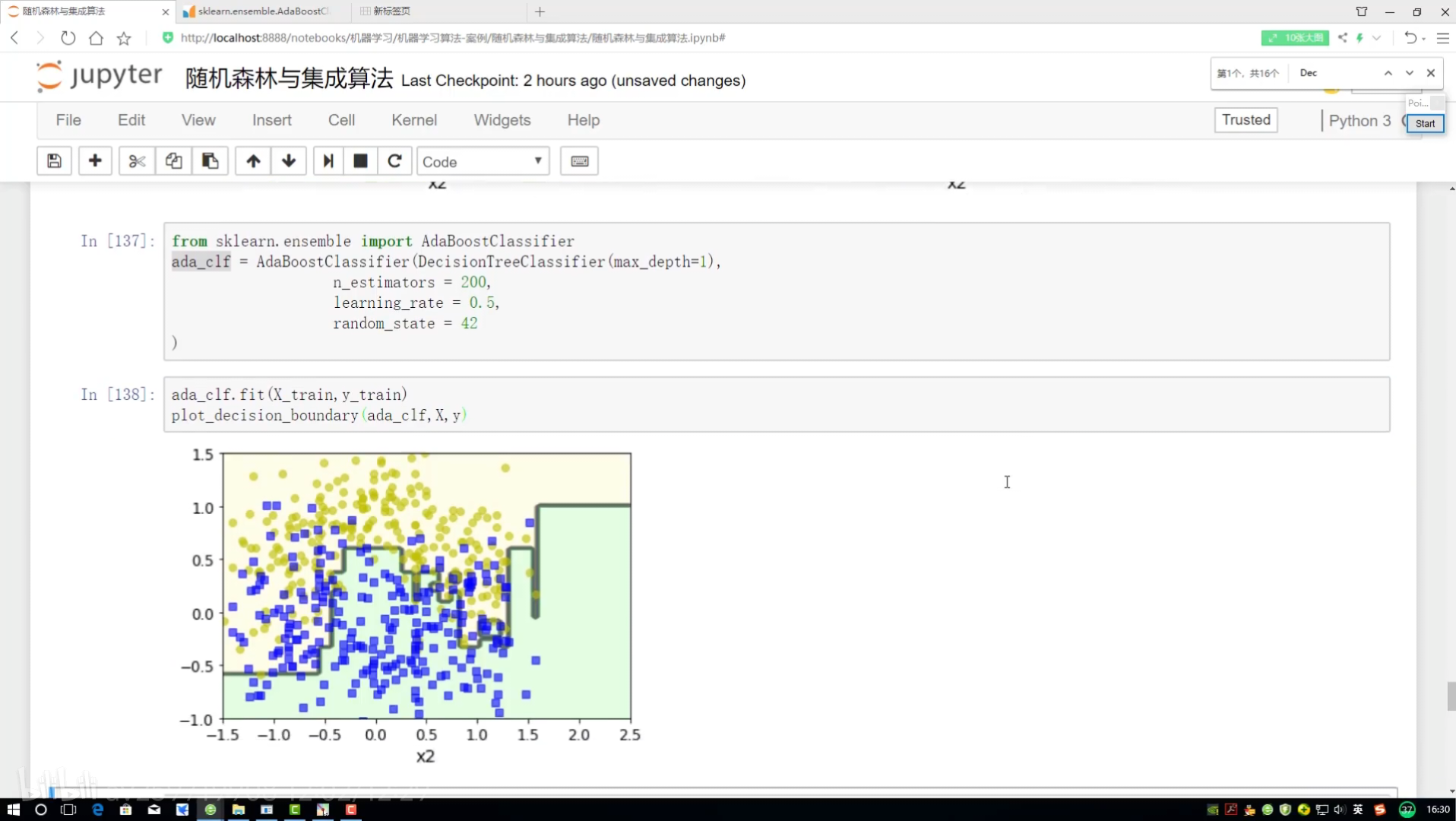

adaboost:权重项不同 集成算法对比

学习率:样本函数衰减程度

多少轮

提升策略:

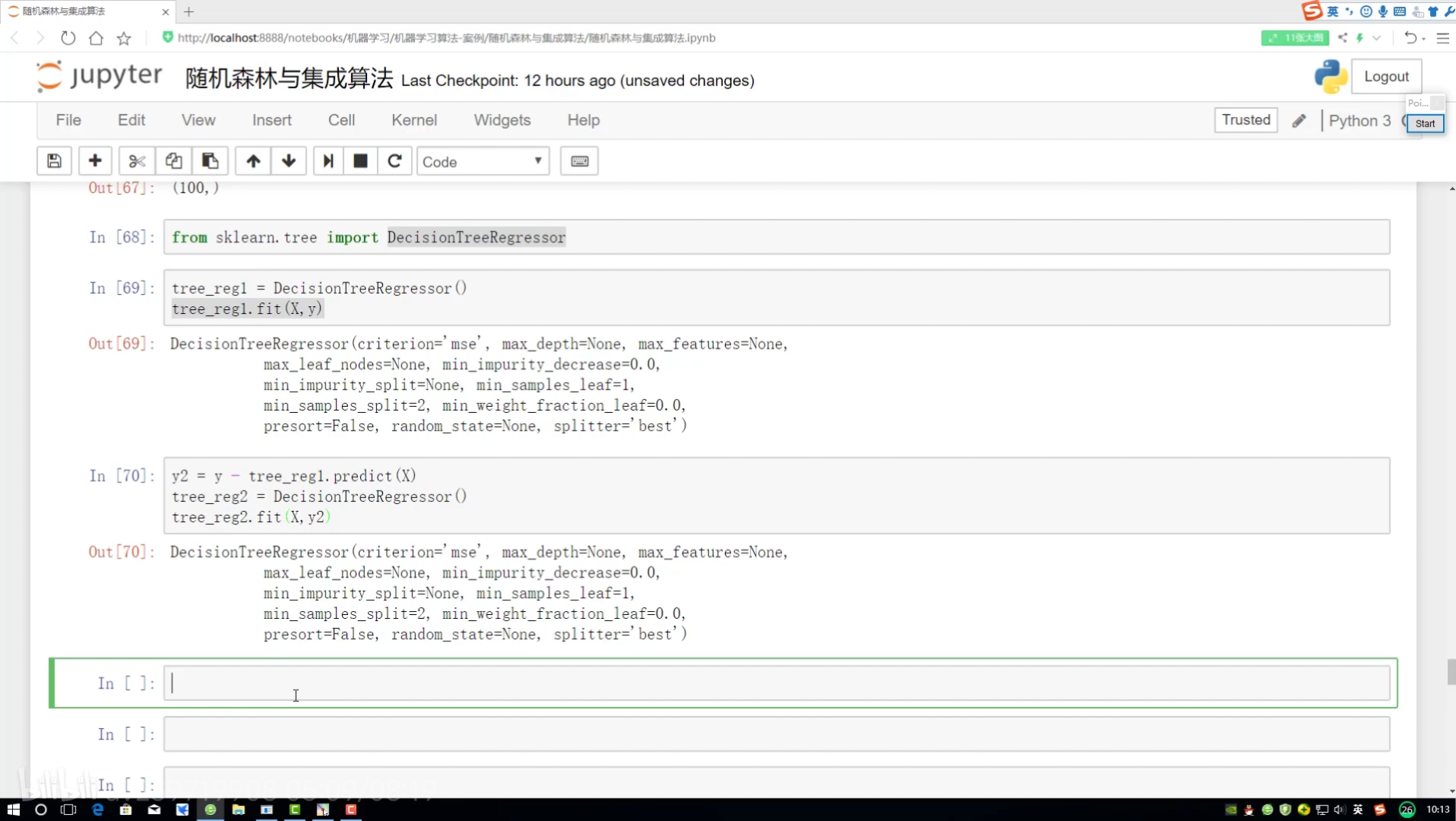

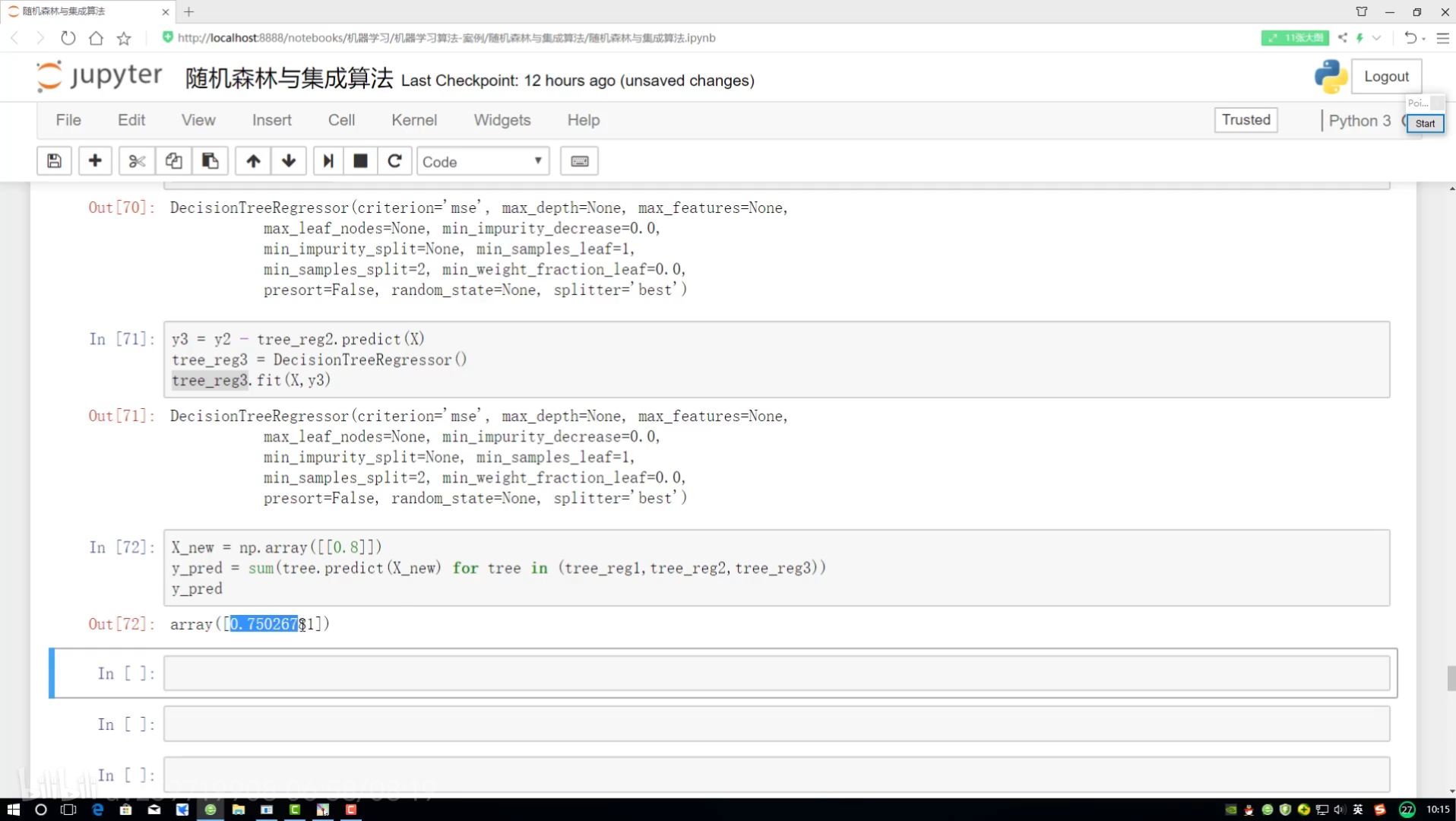

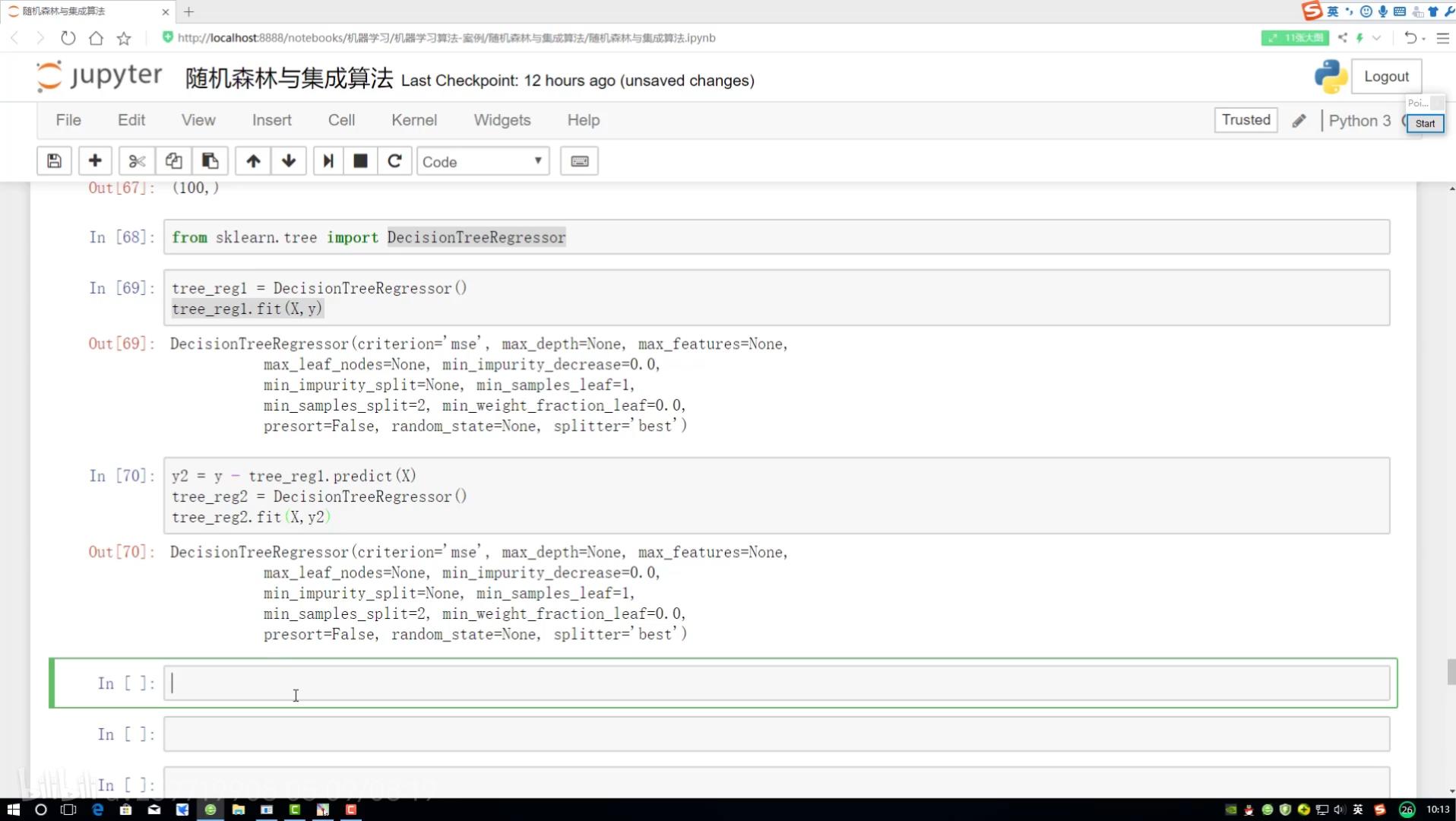

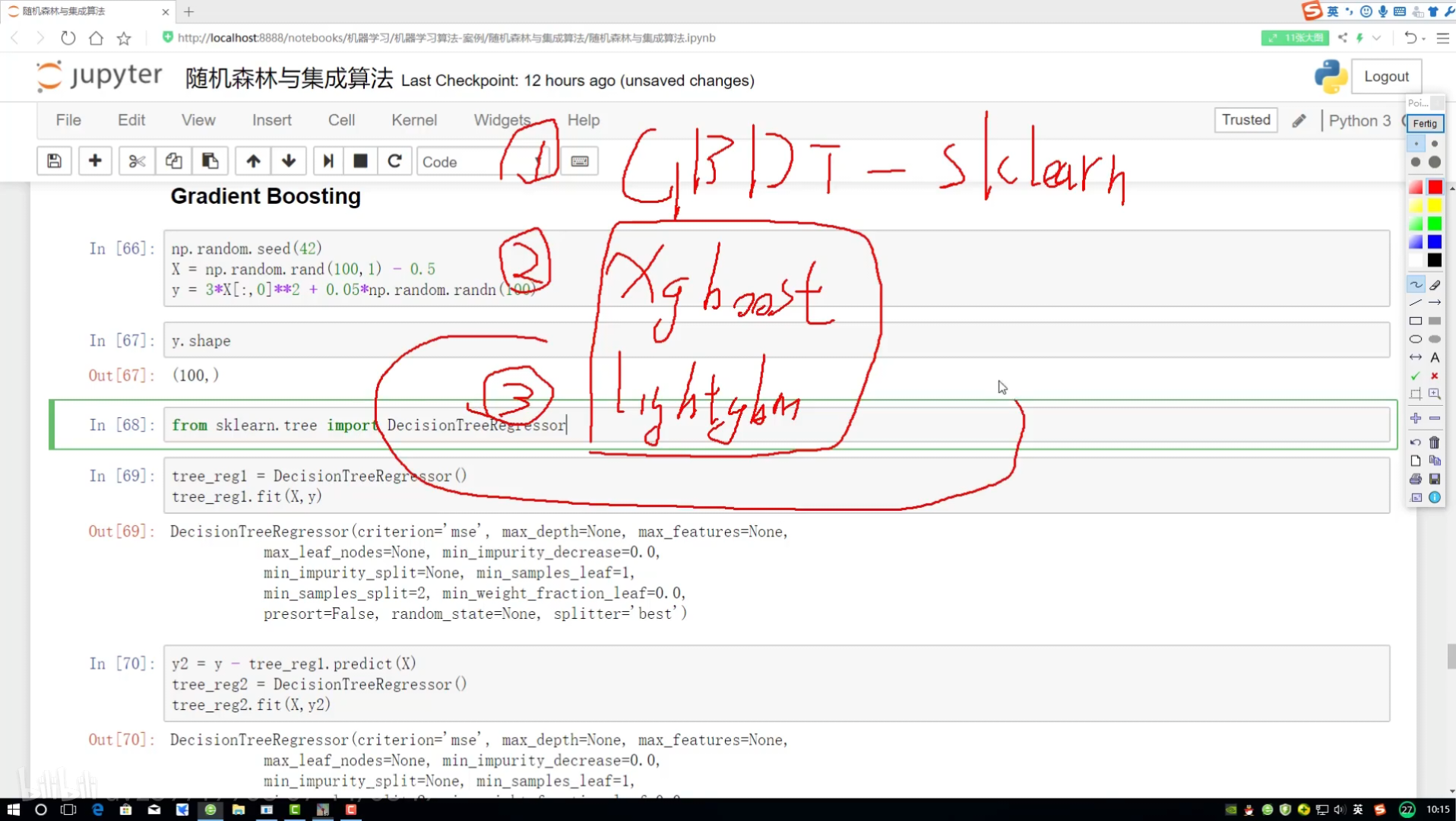

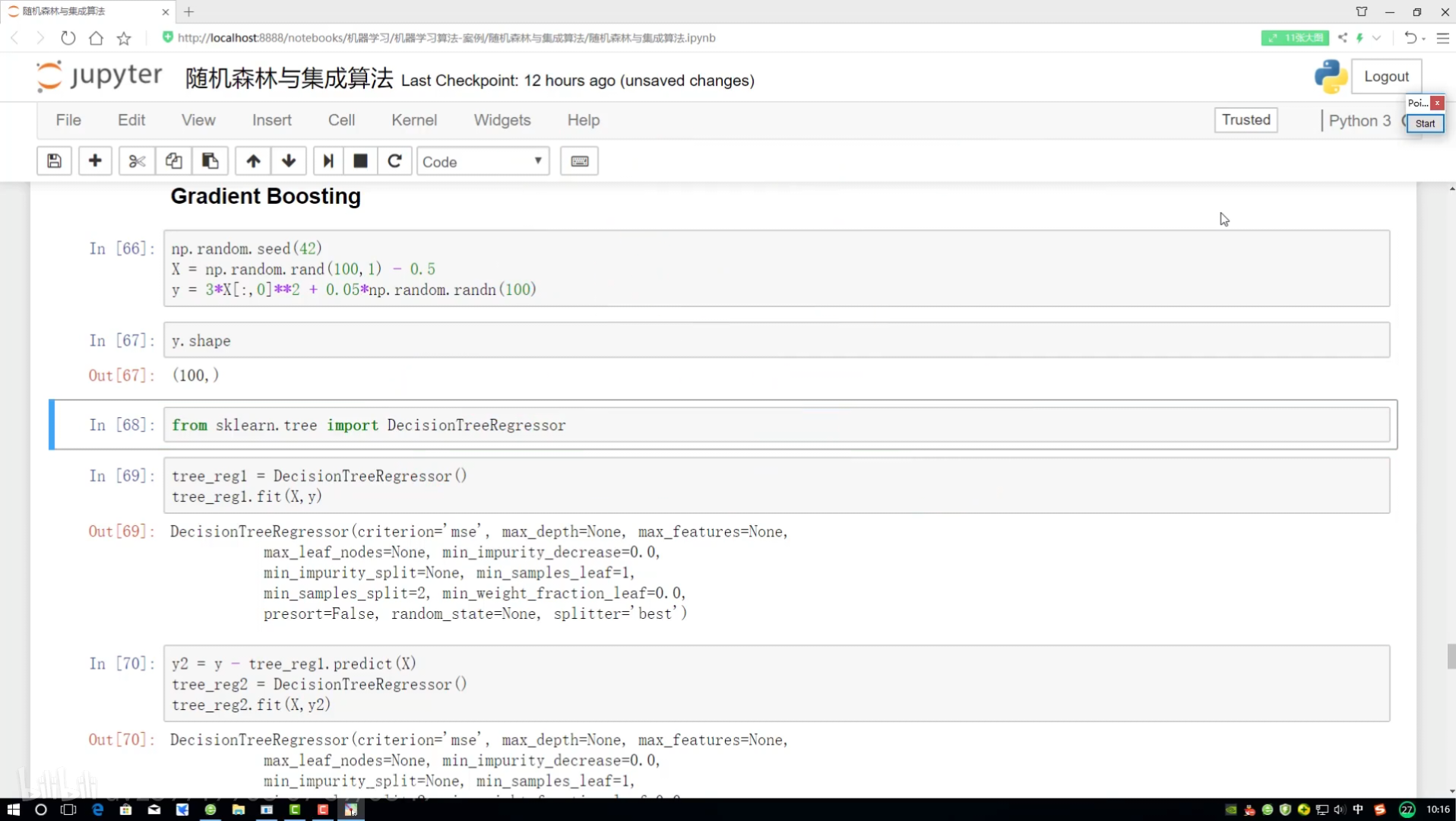

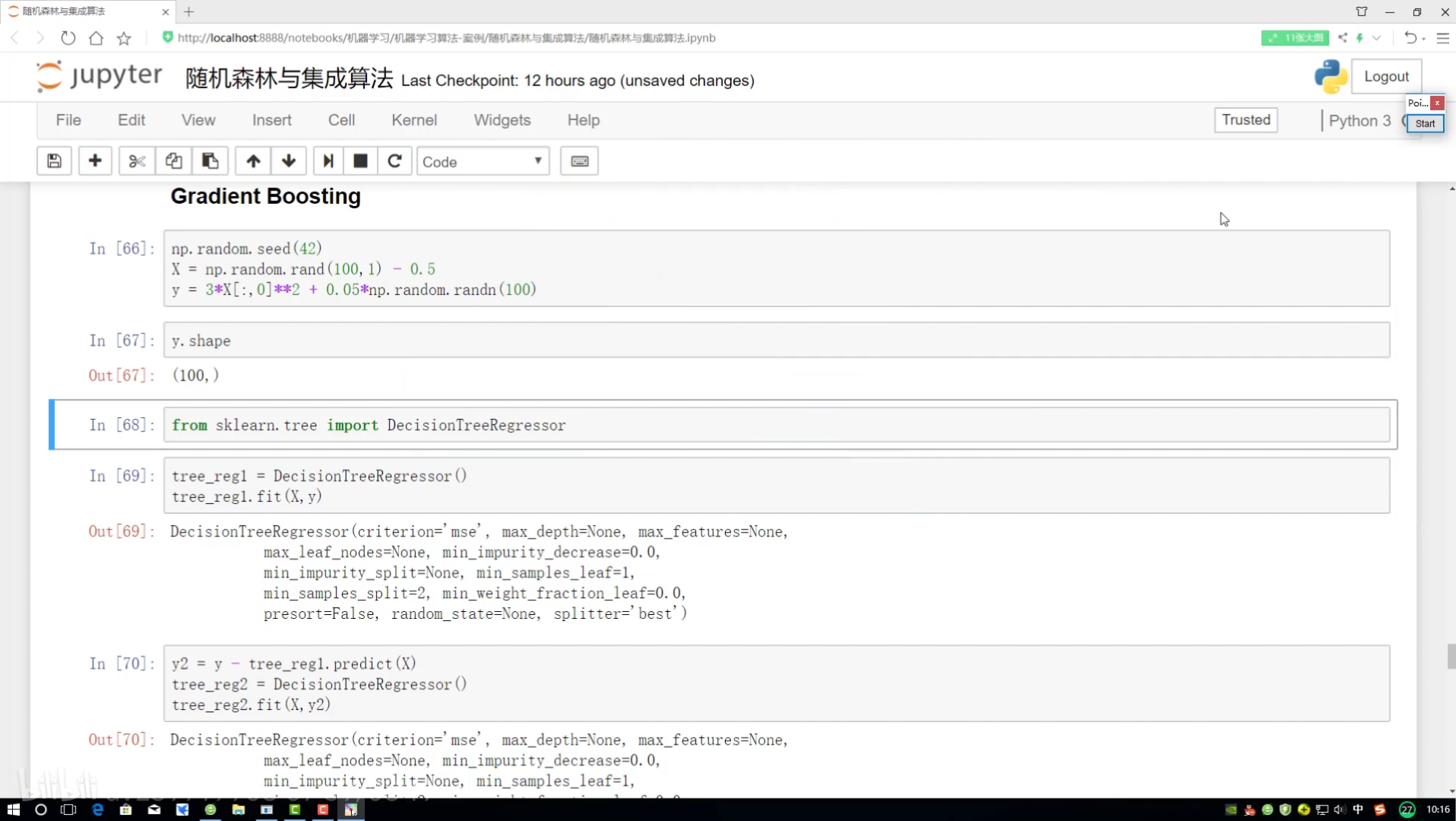

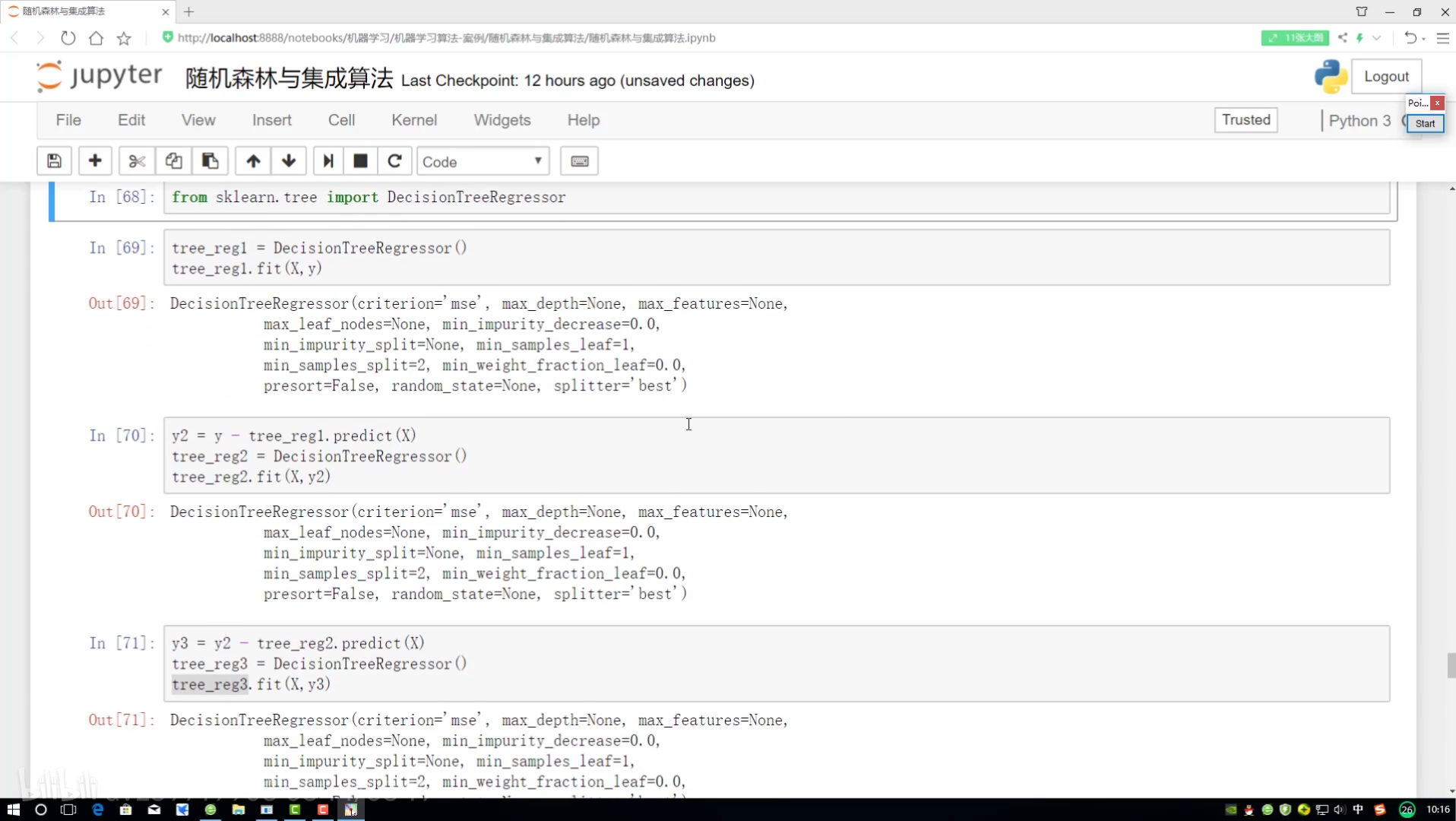

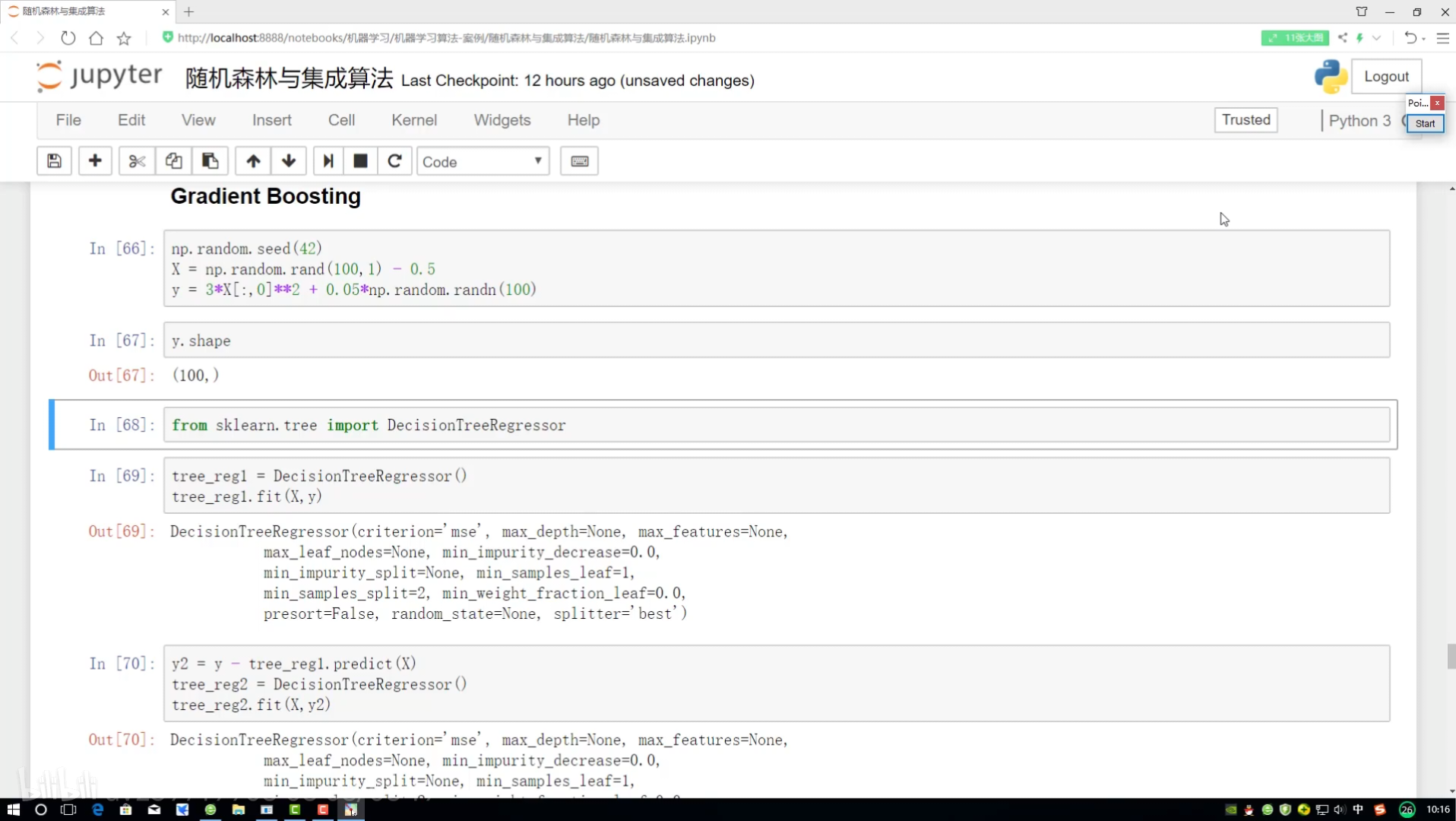

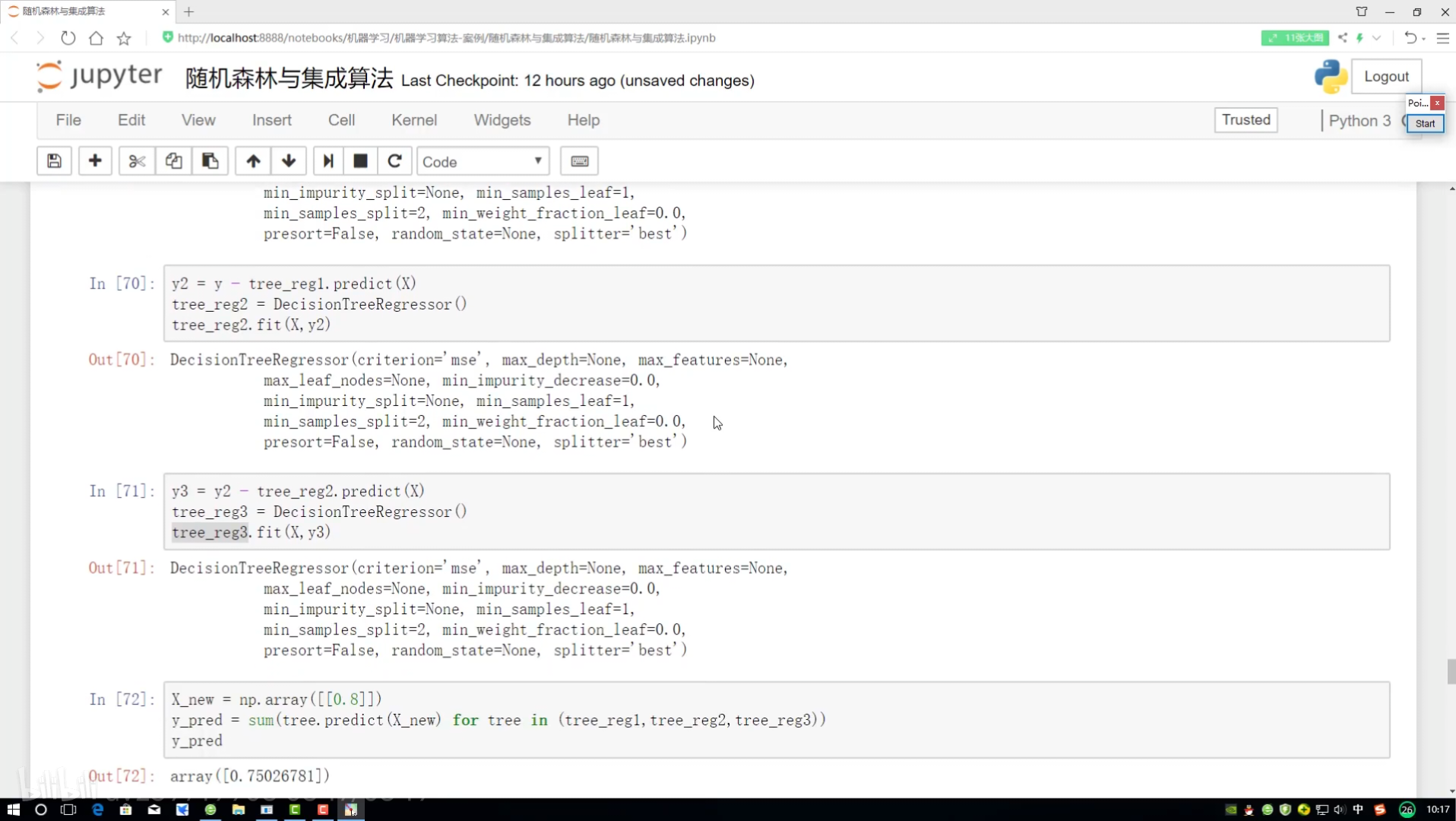

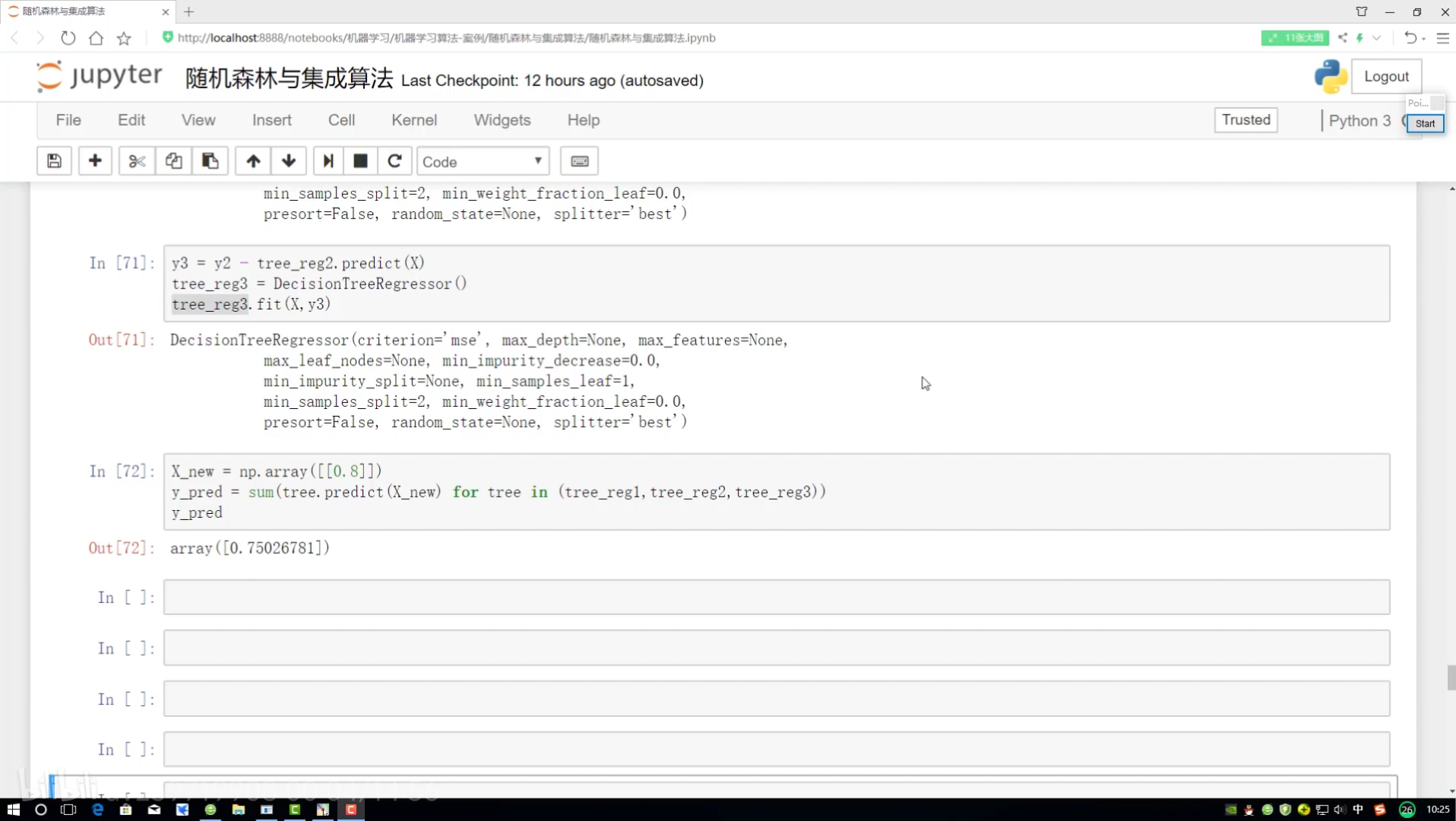

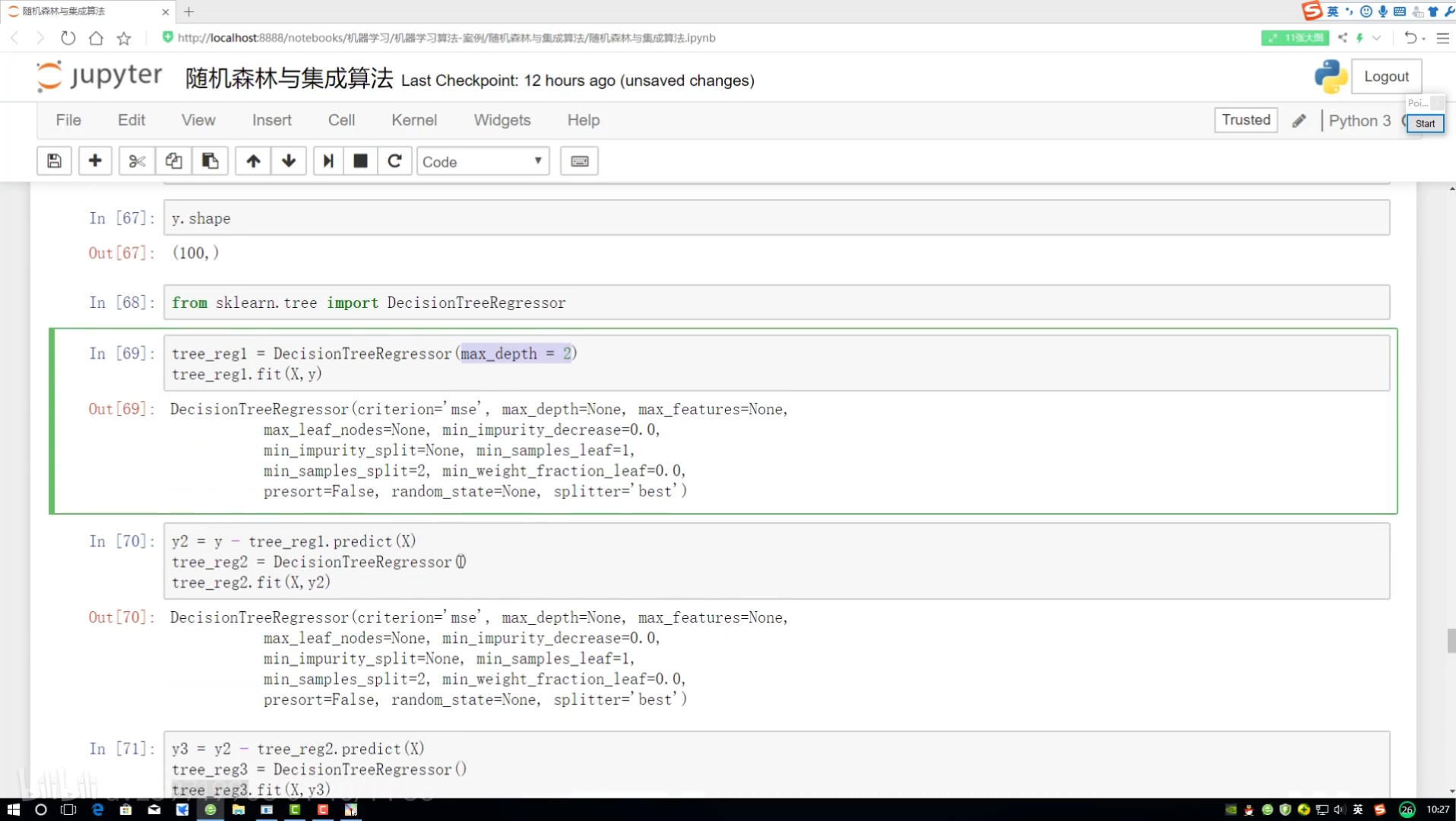

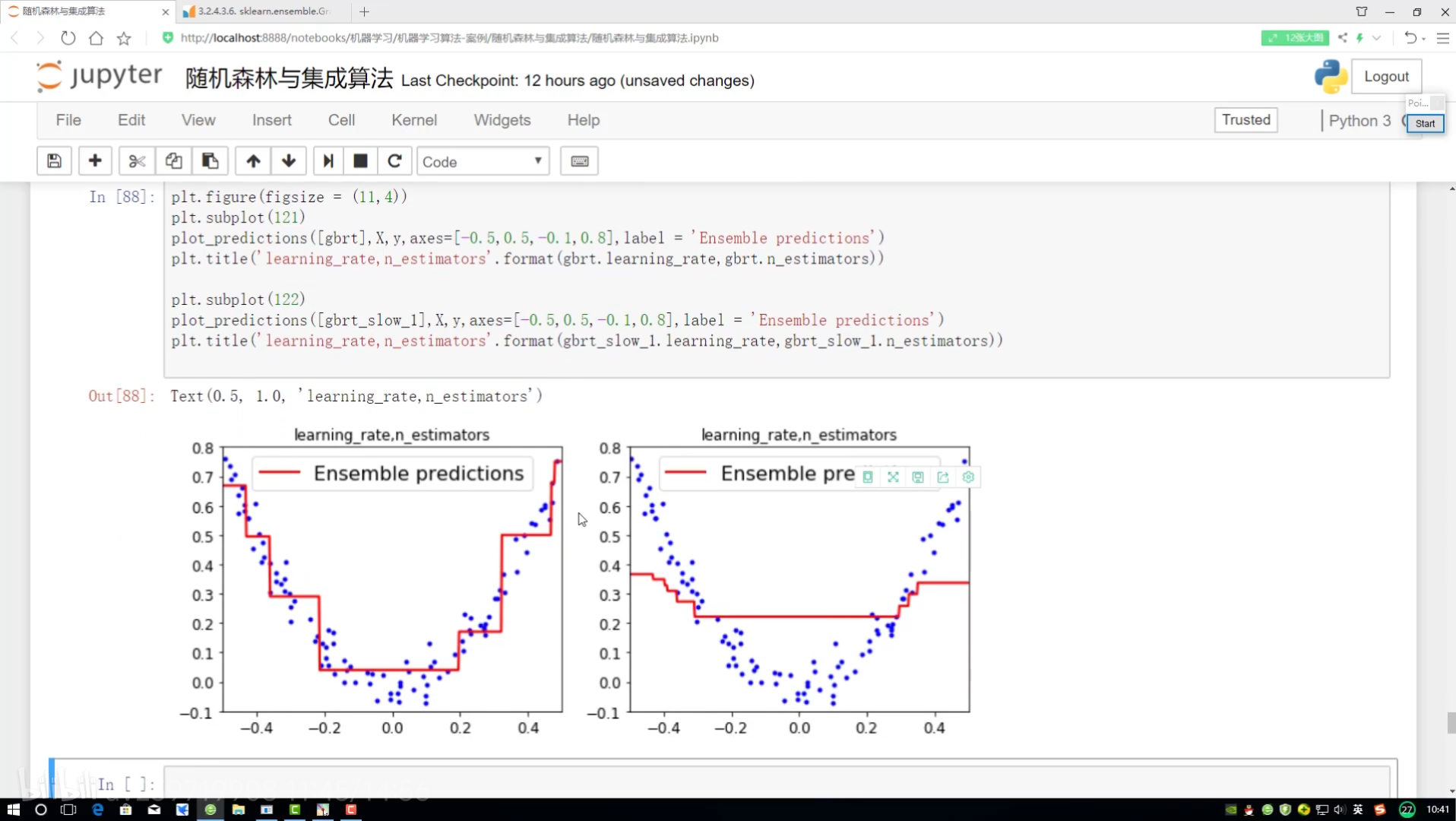

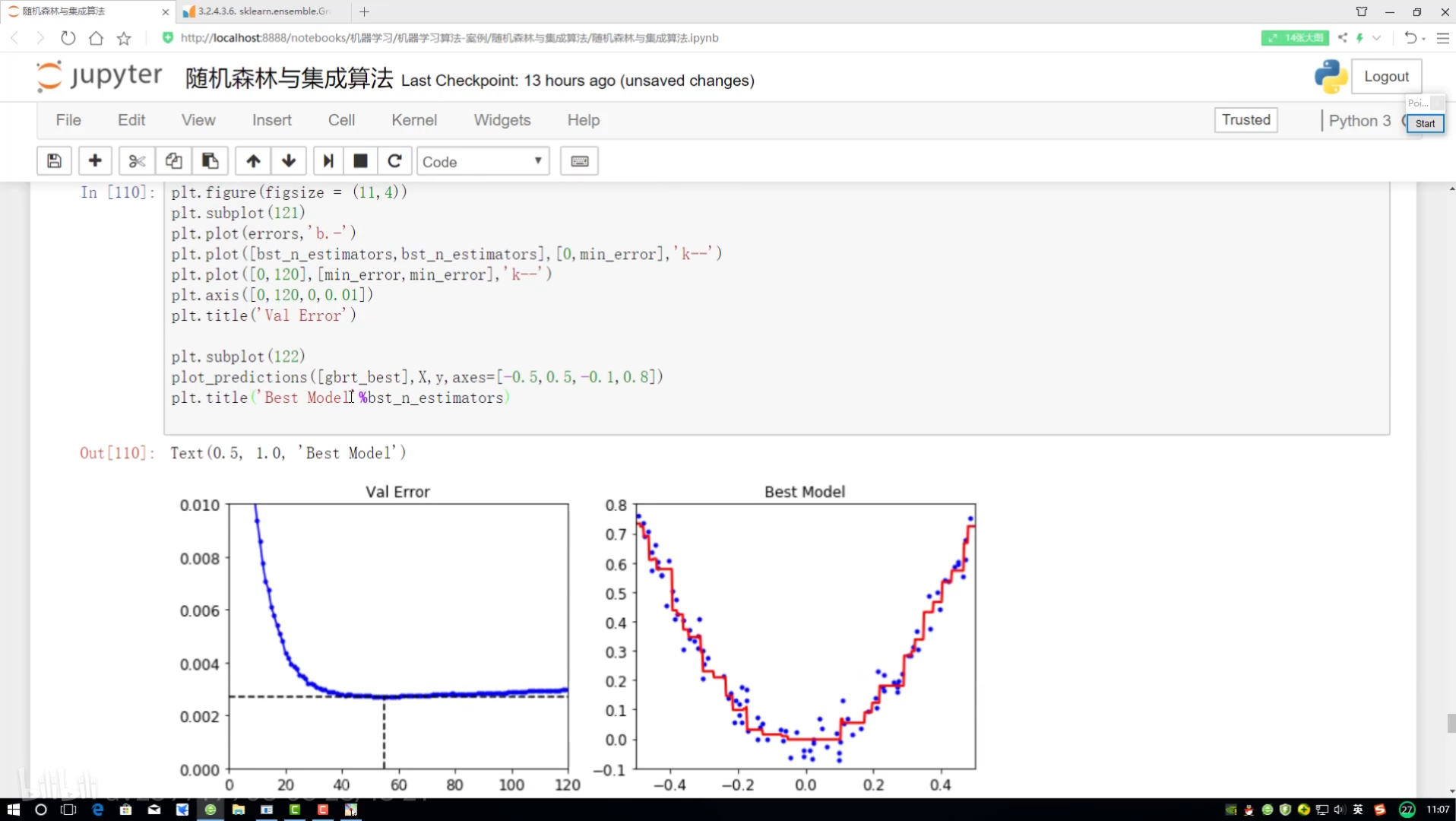

GBDT梯度提升决策树

种子 随机进行数据集构建

分别给预测结果 所有值加起来

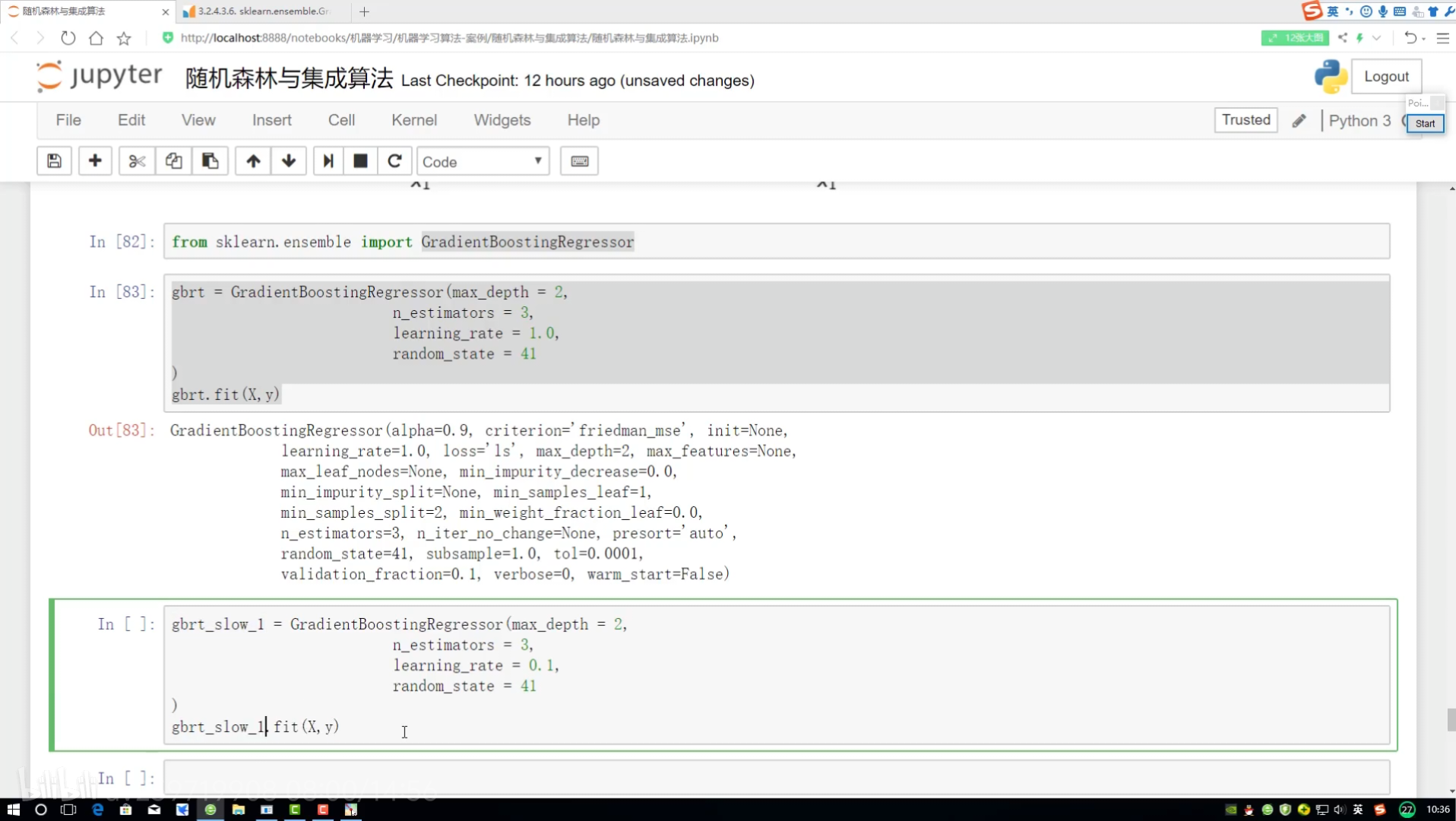

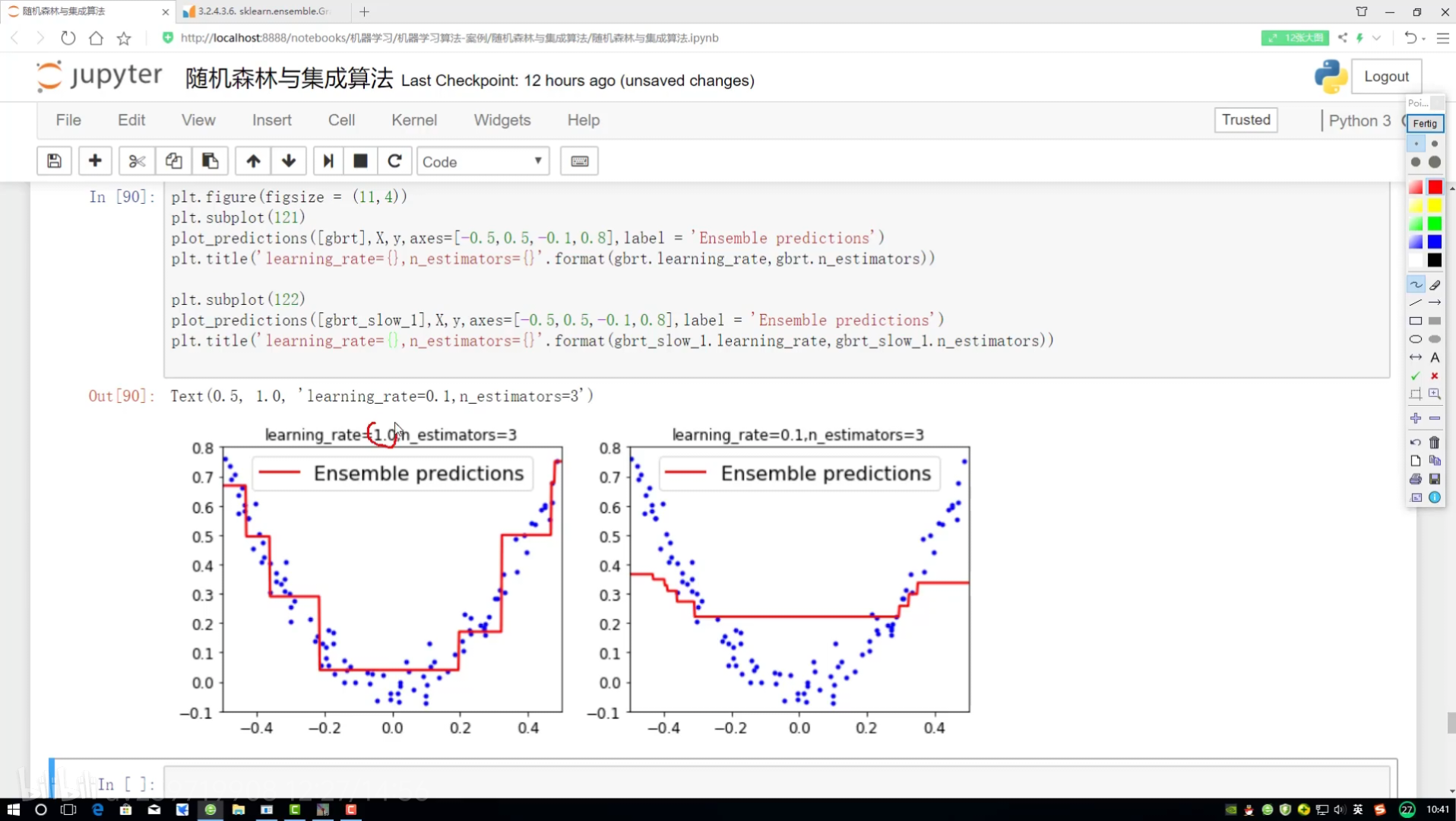

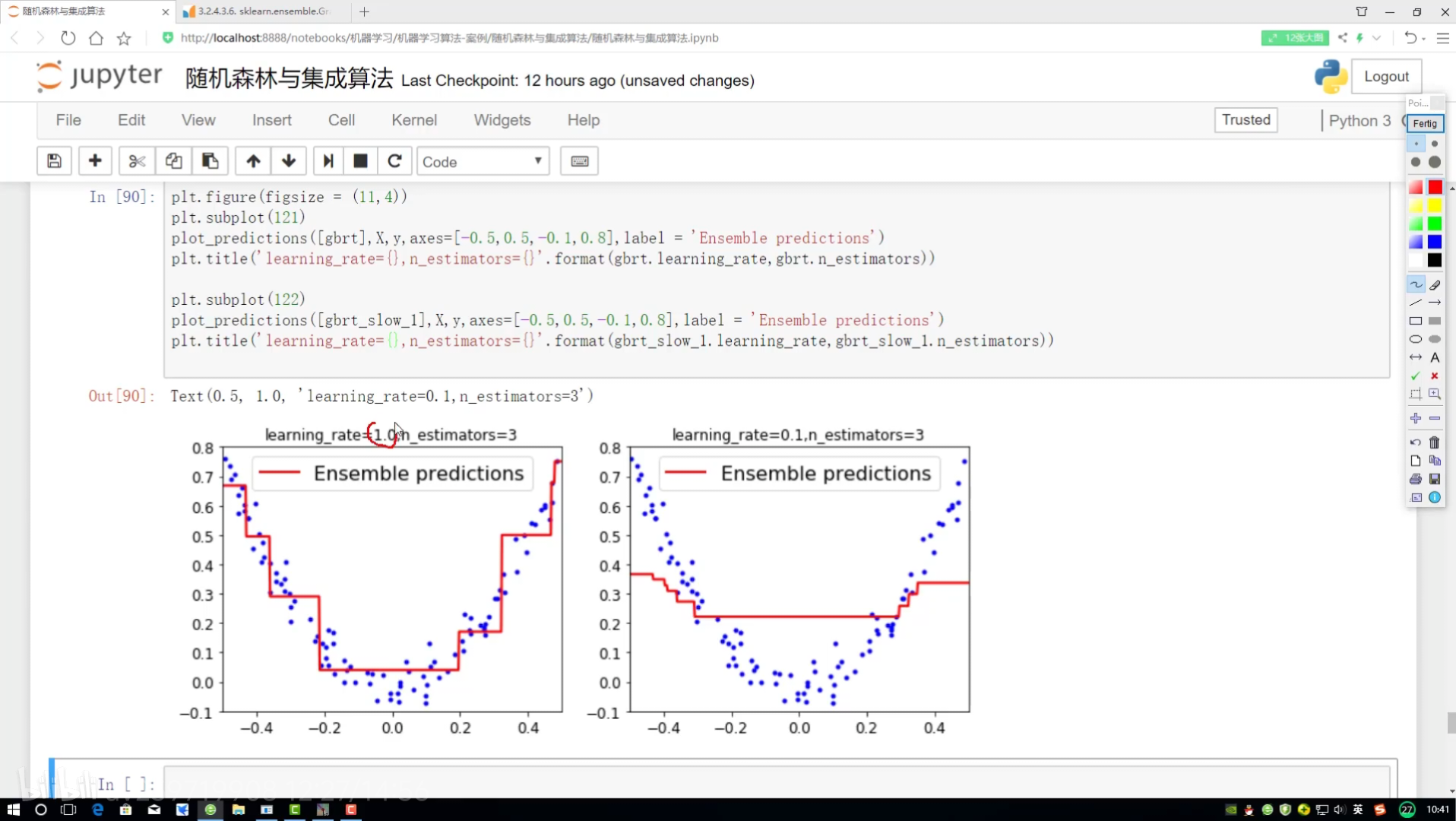

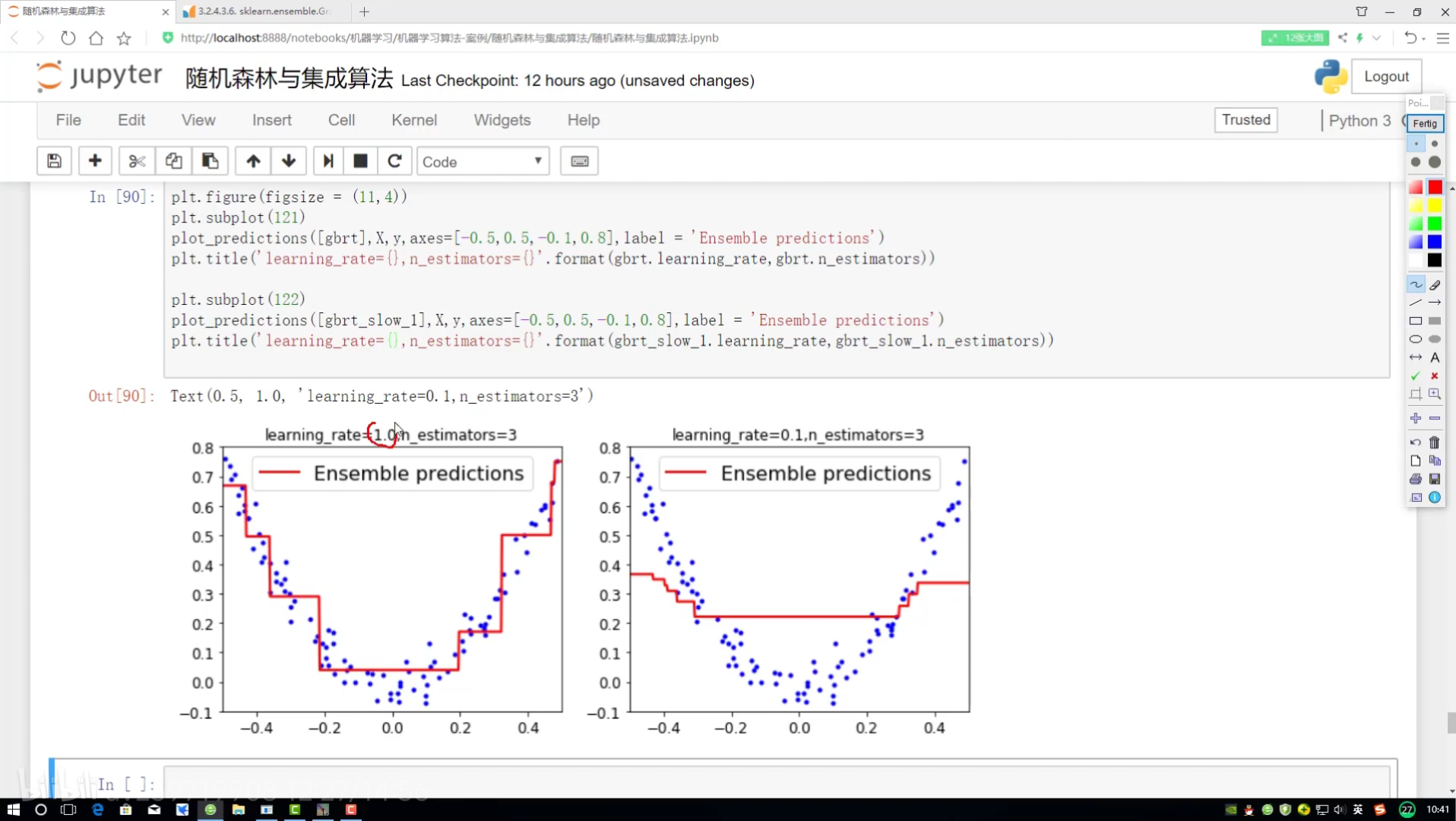

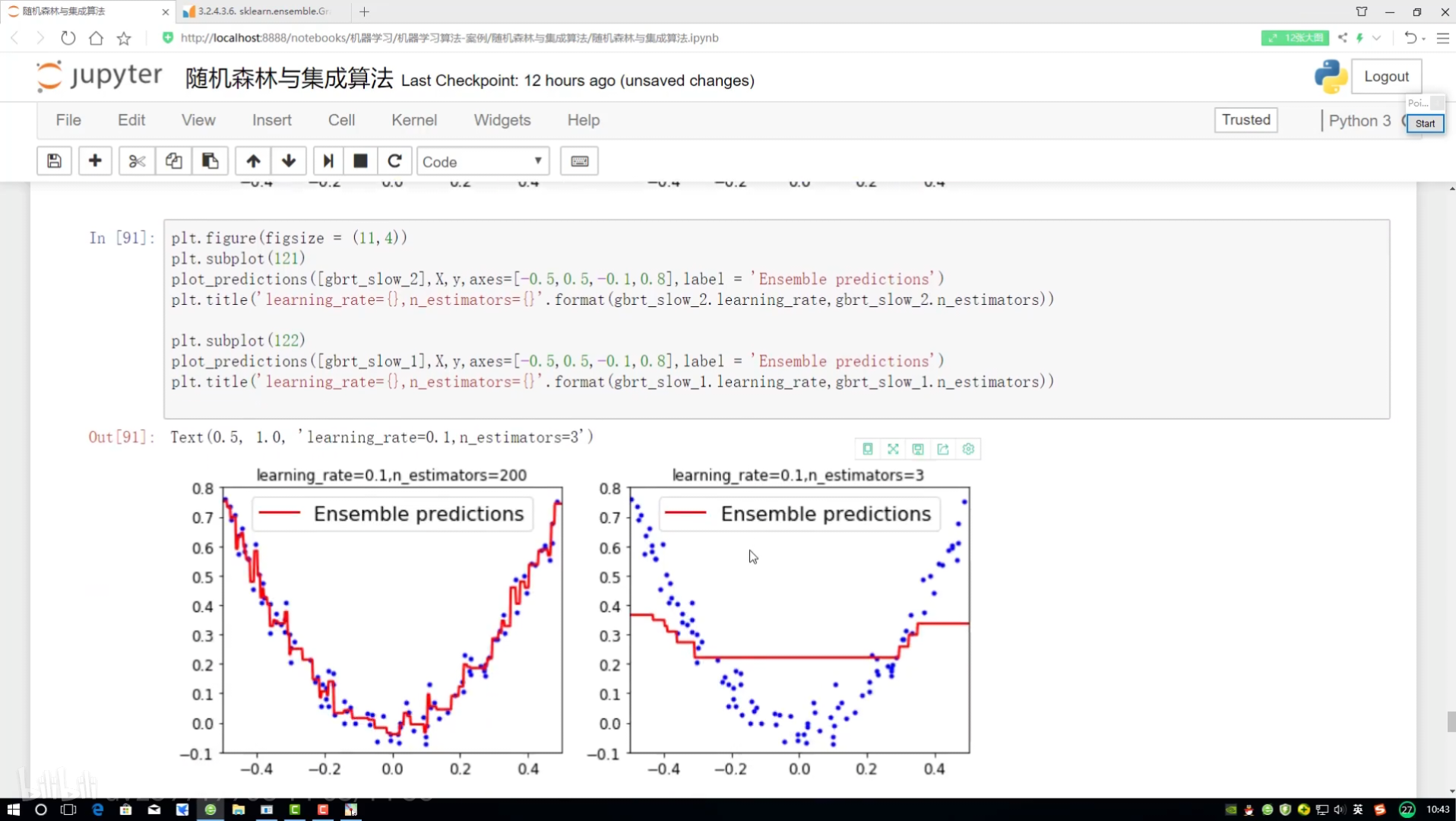

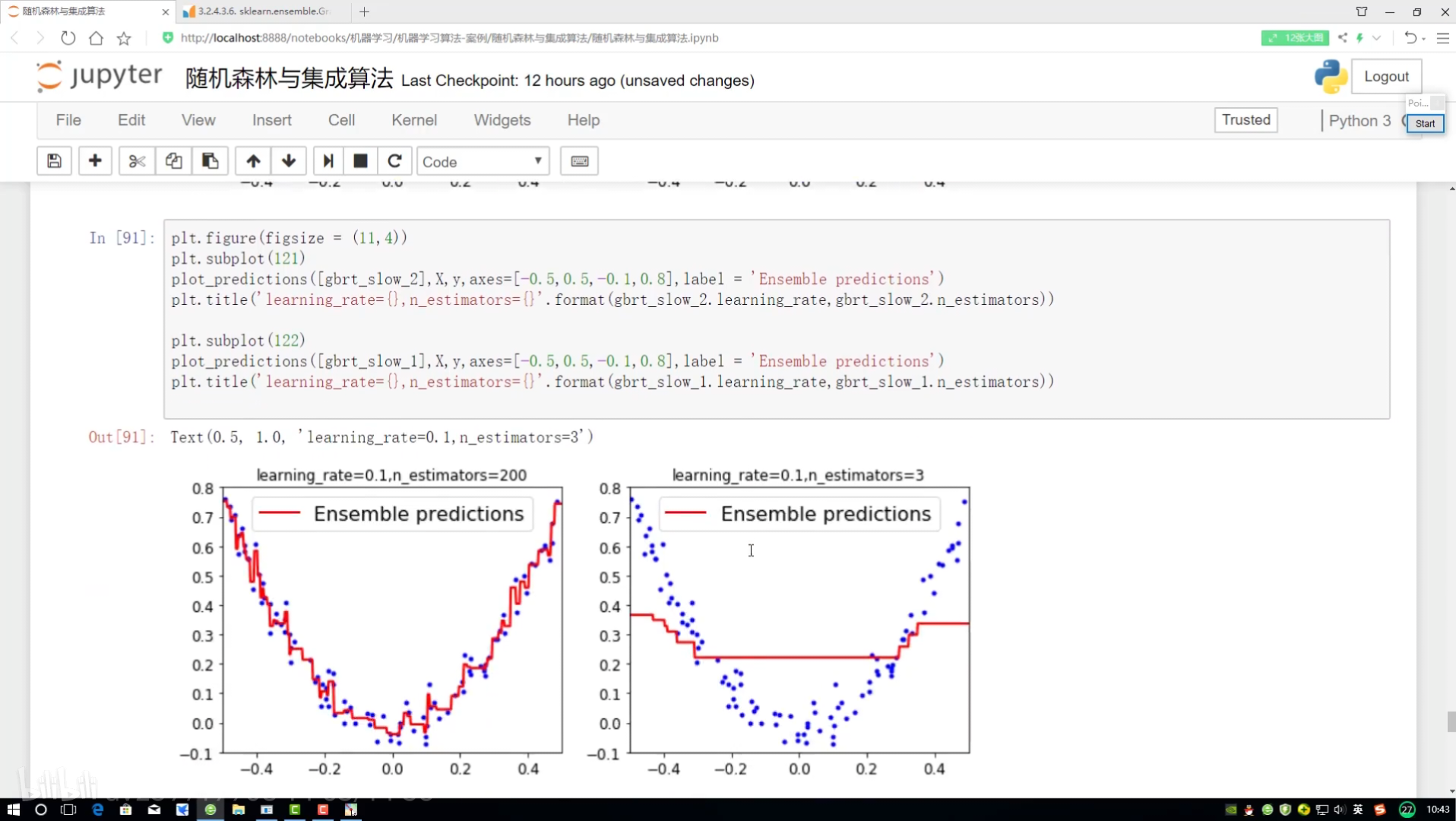

集成参数对比分析:

拿到测试数据点

修改深度

1.0 -> 0.1

没有实际打印值

rate后面➕{}

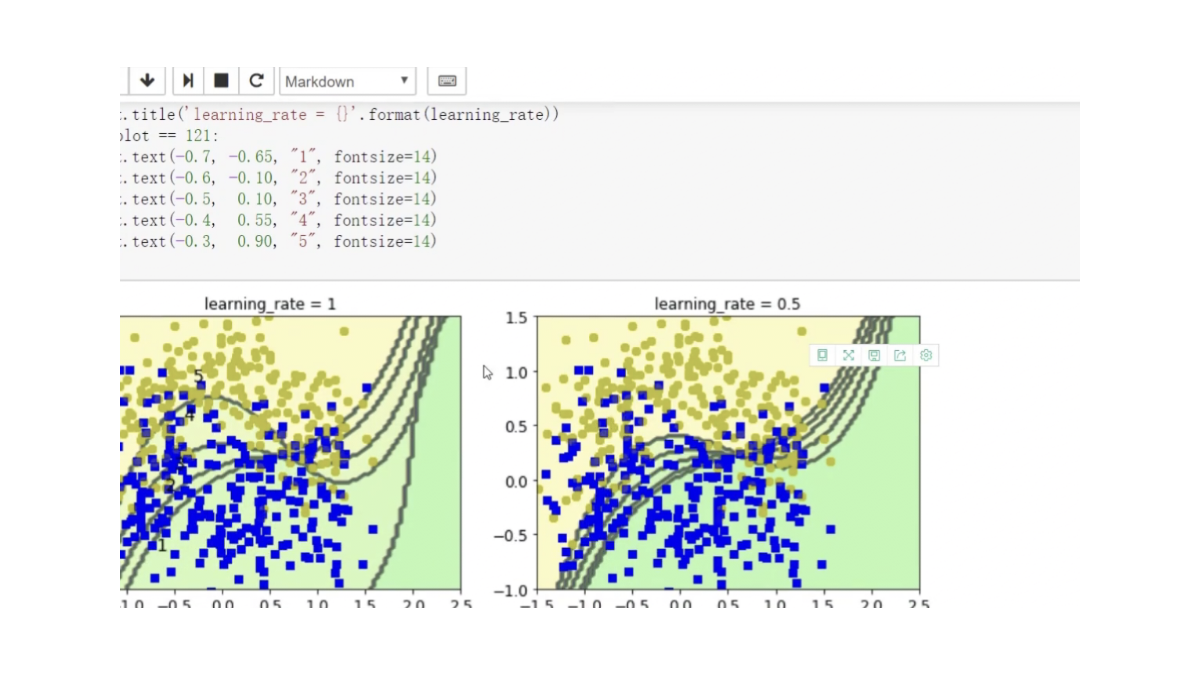

第二组对比实验:

全部改成2

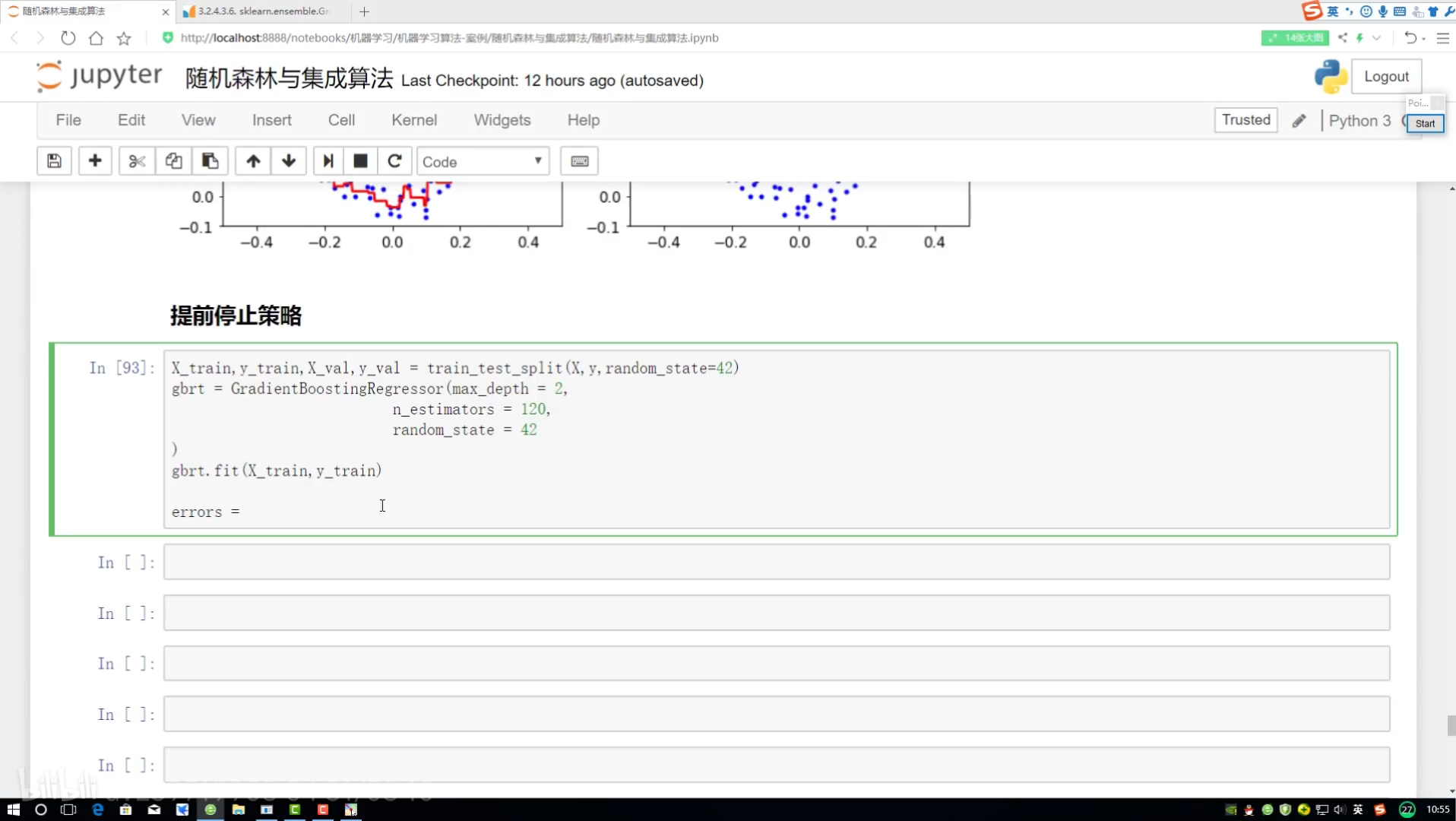

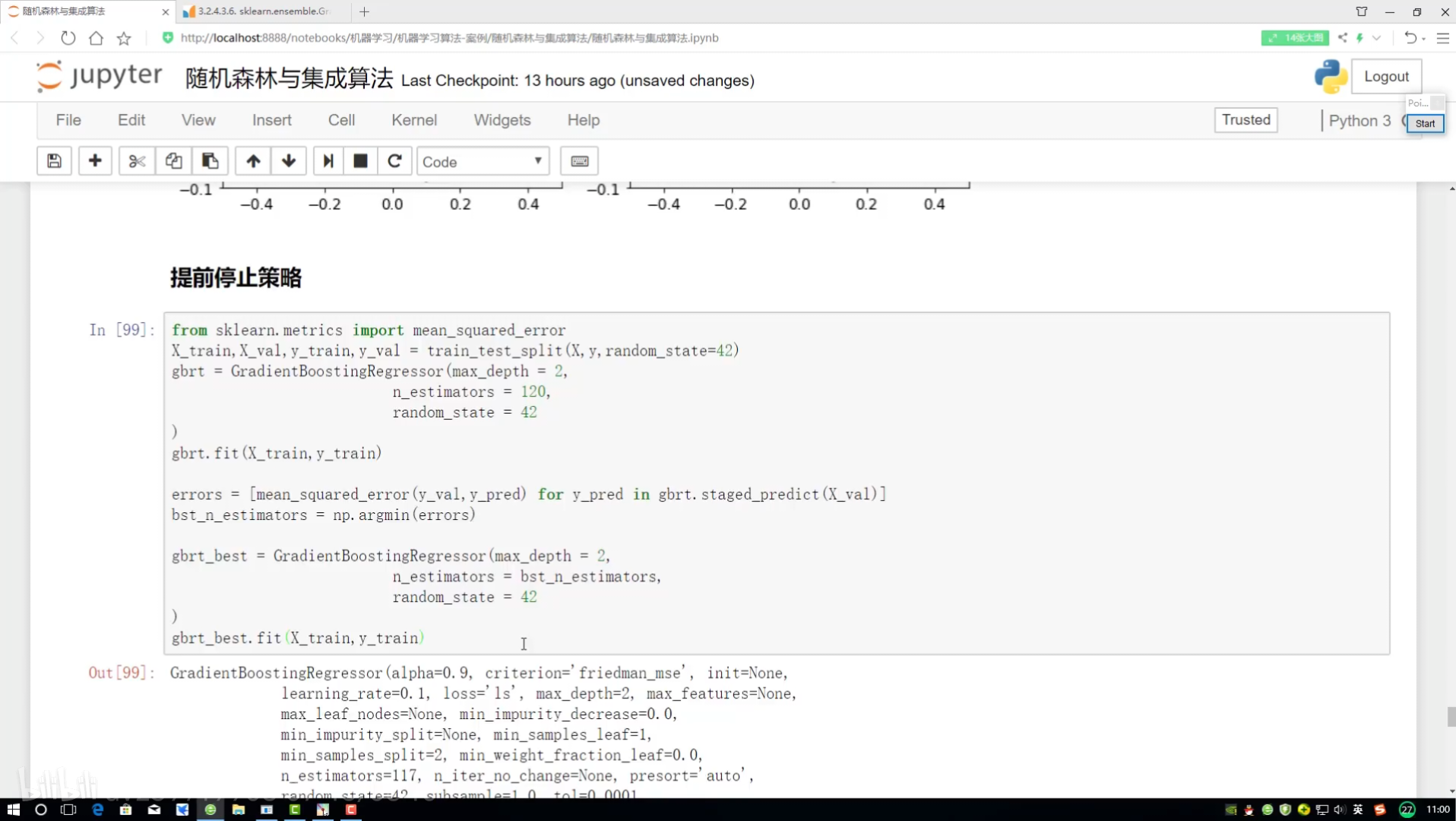

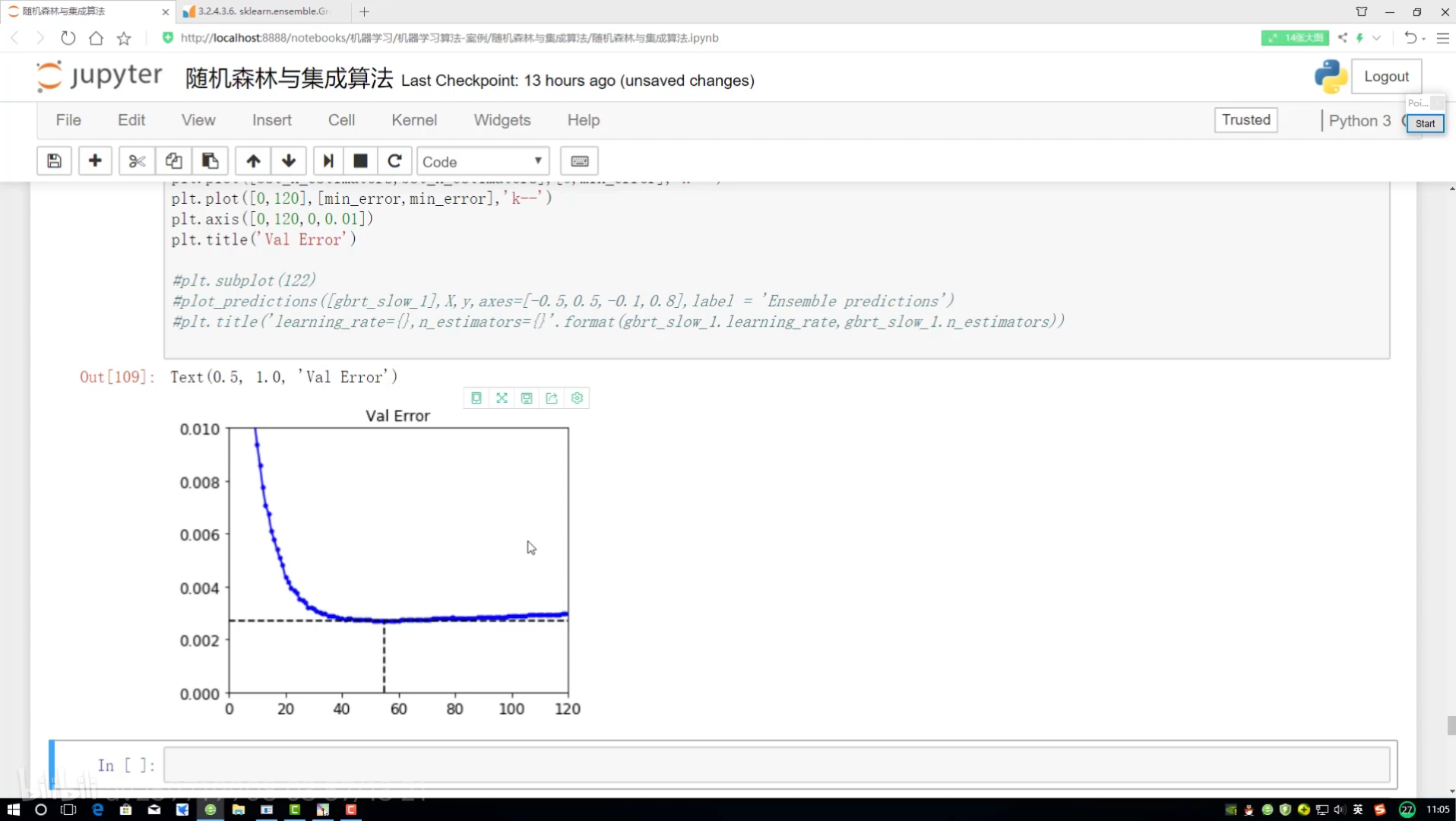

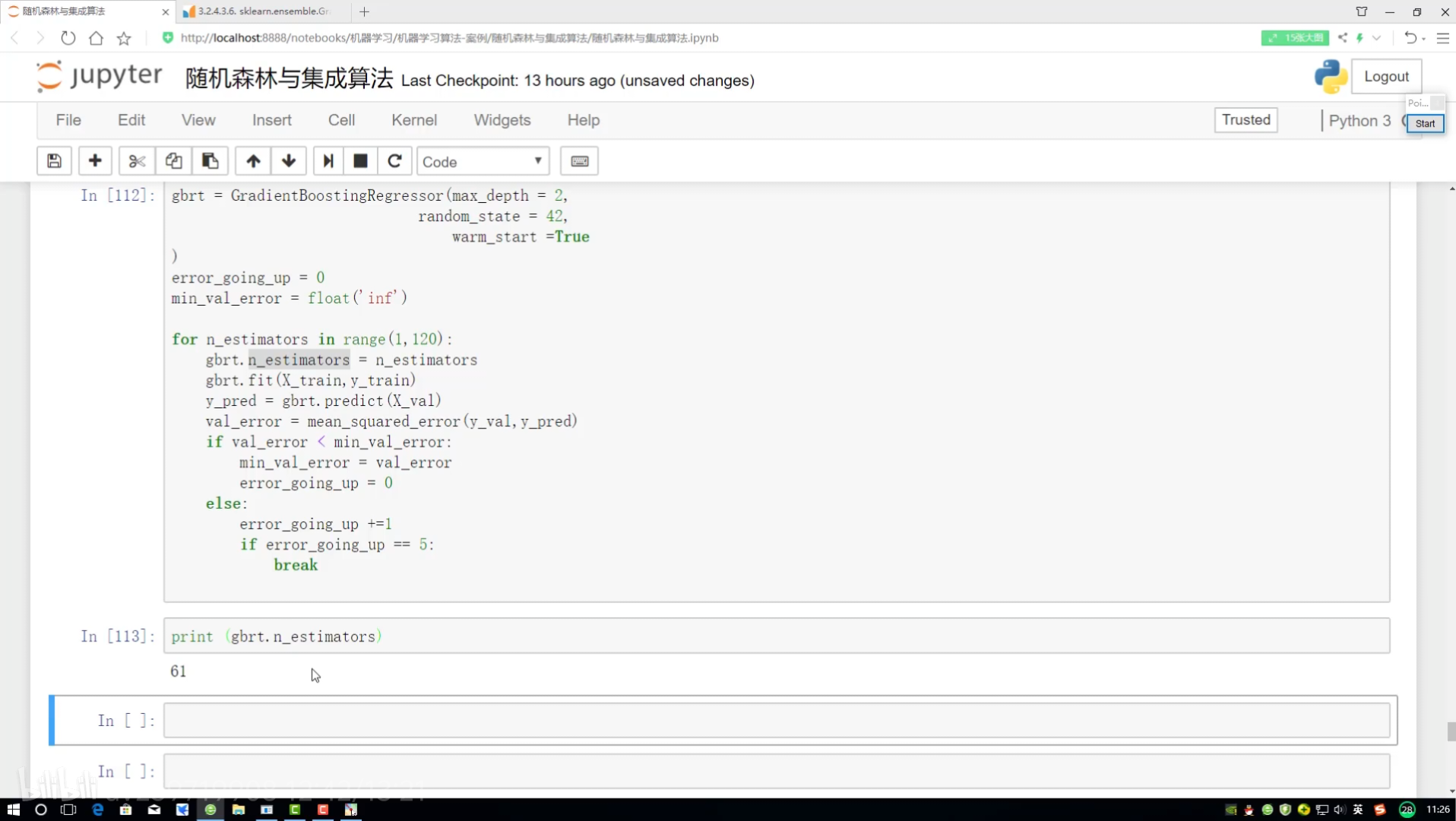

模型提前停止策略

.fit xtrain实例化

停止方案实施:

设置上限 若连续5次都没得到上升

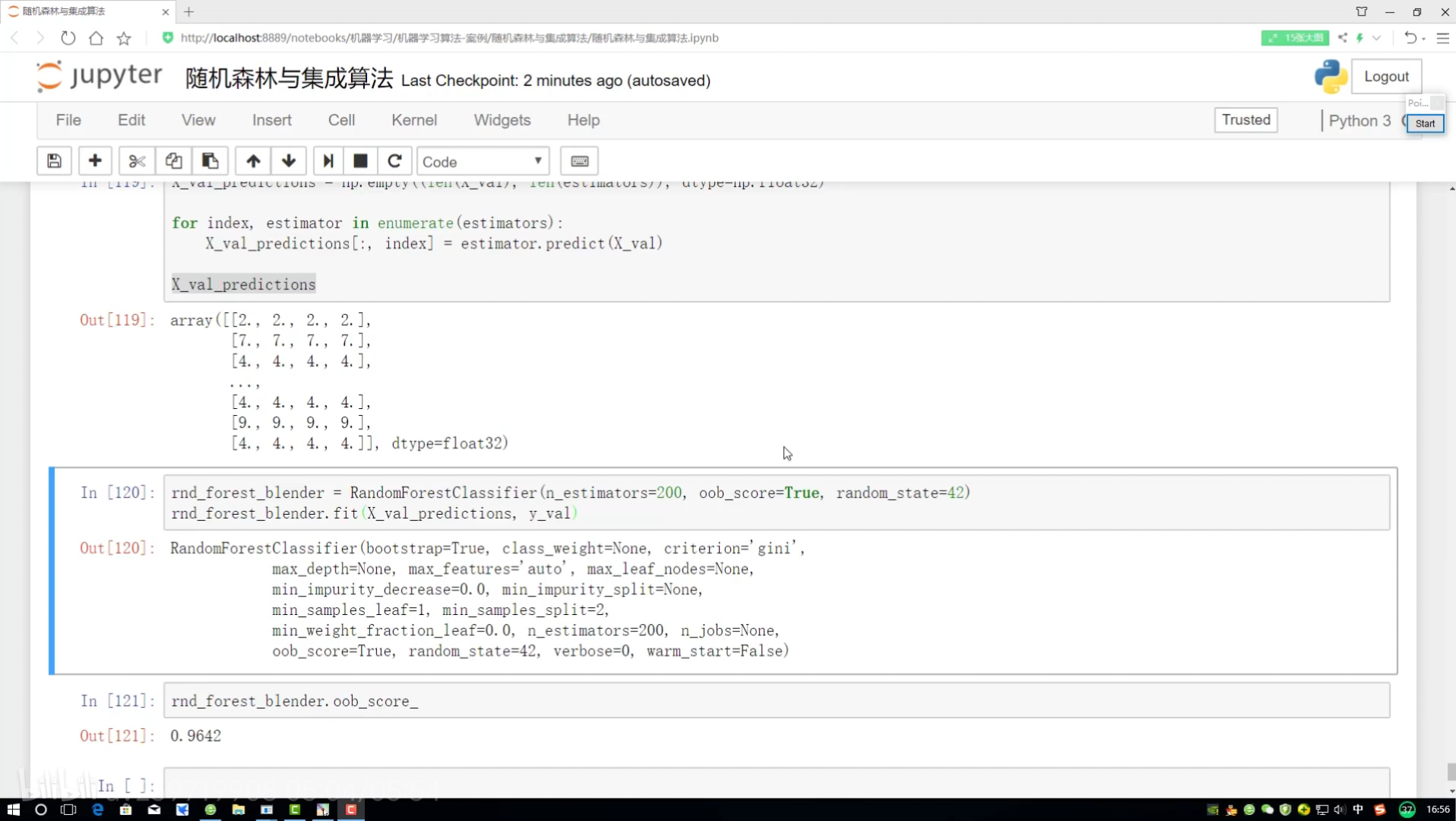

stacking:堆叠集成

经过不同的算法(分类器)ABC

rf:随机森林

数据集切分

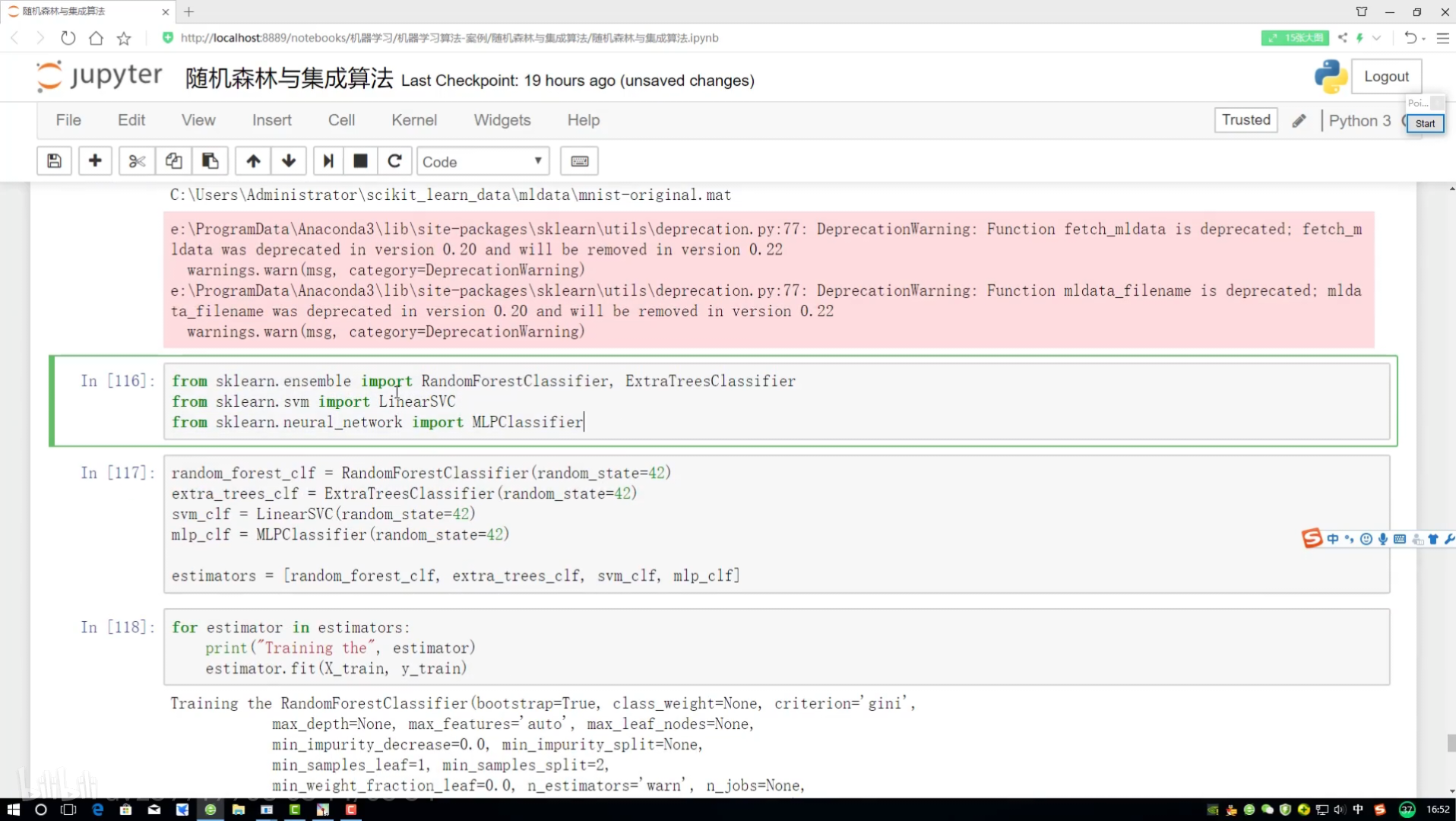

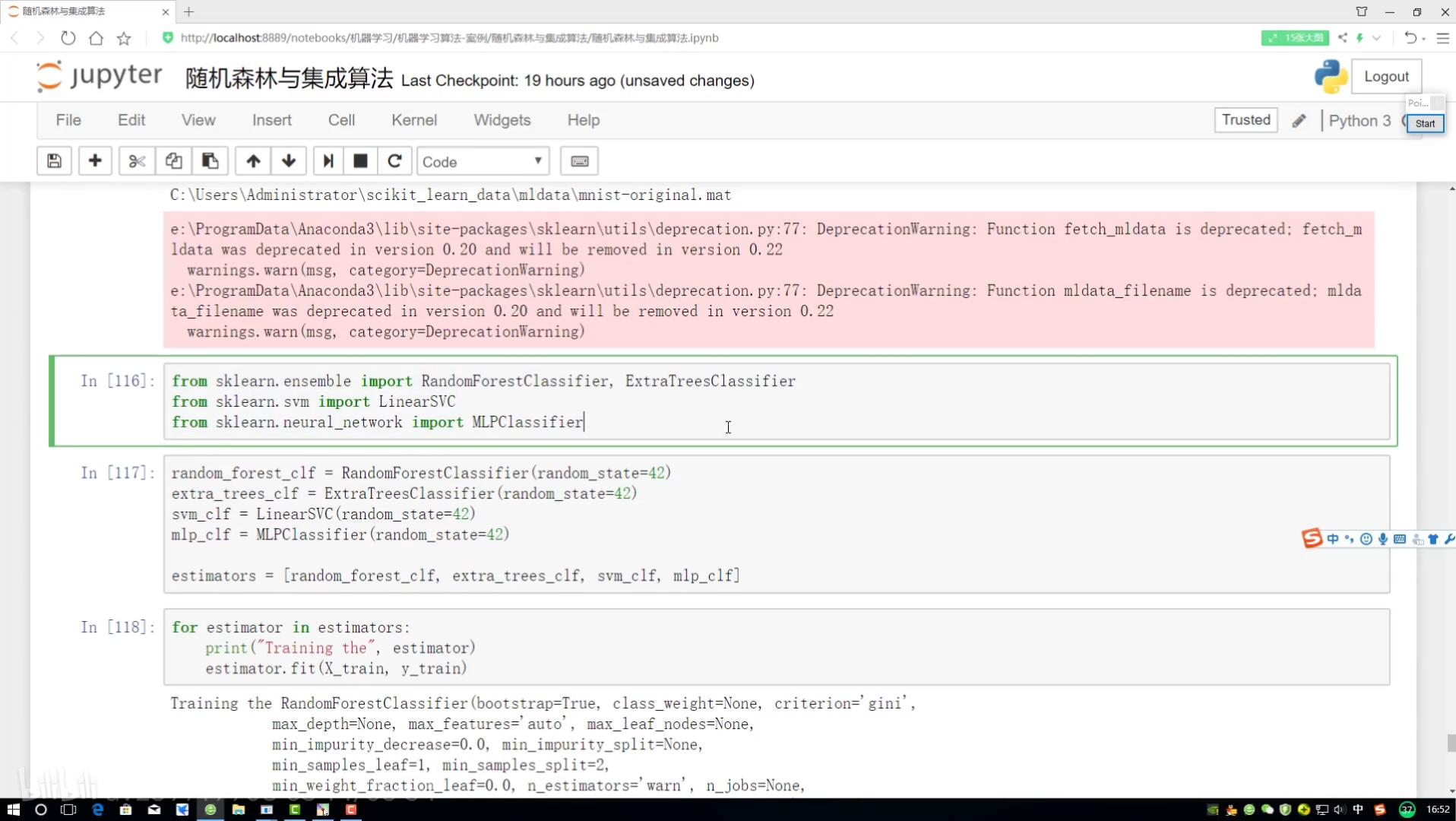

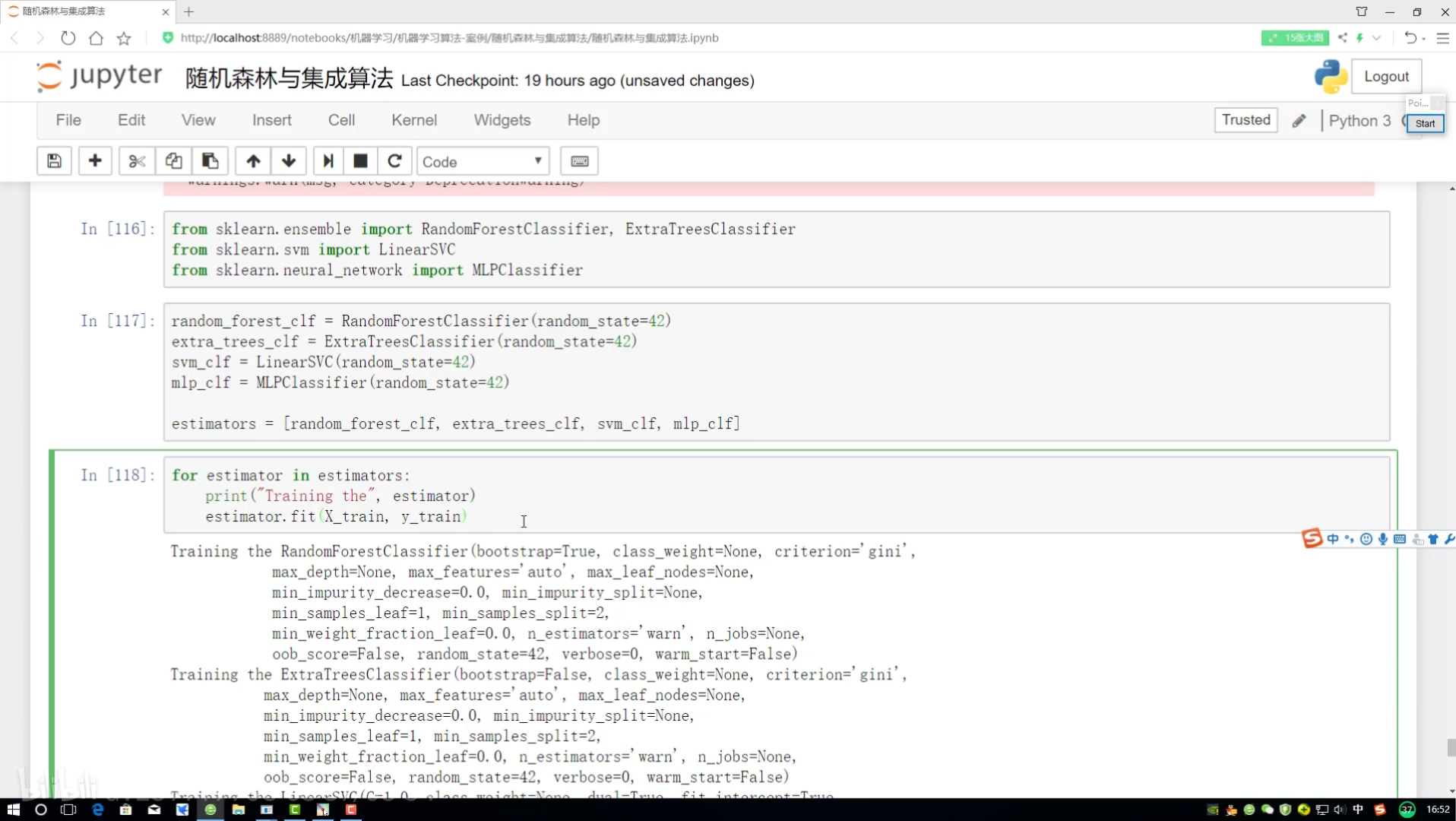

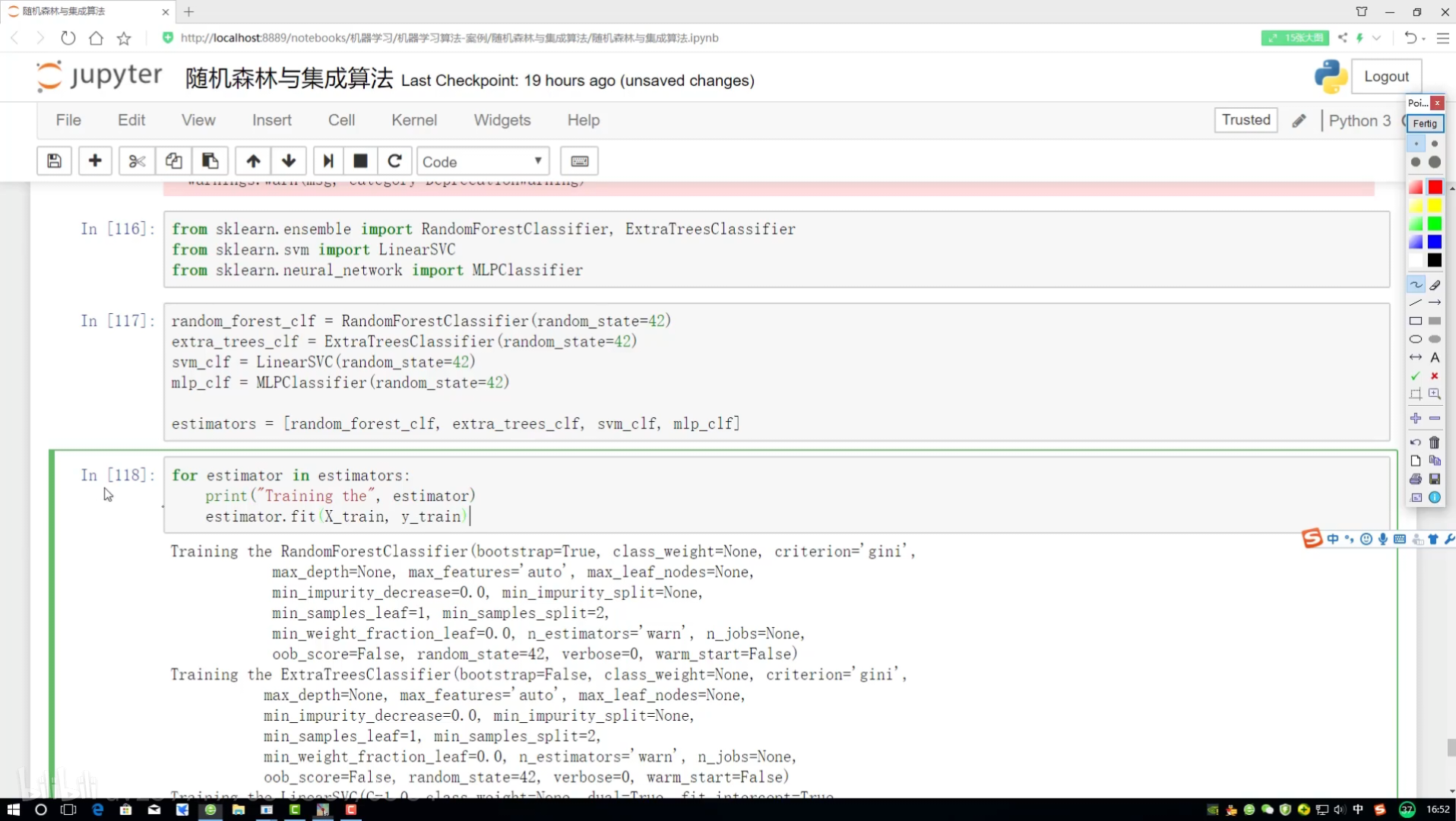

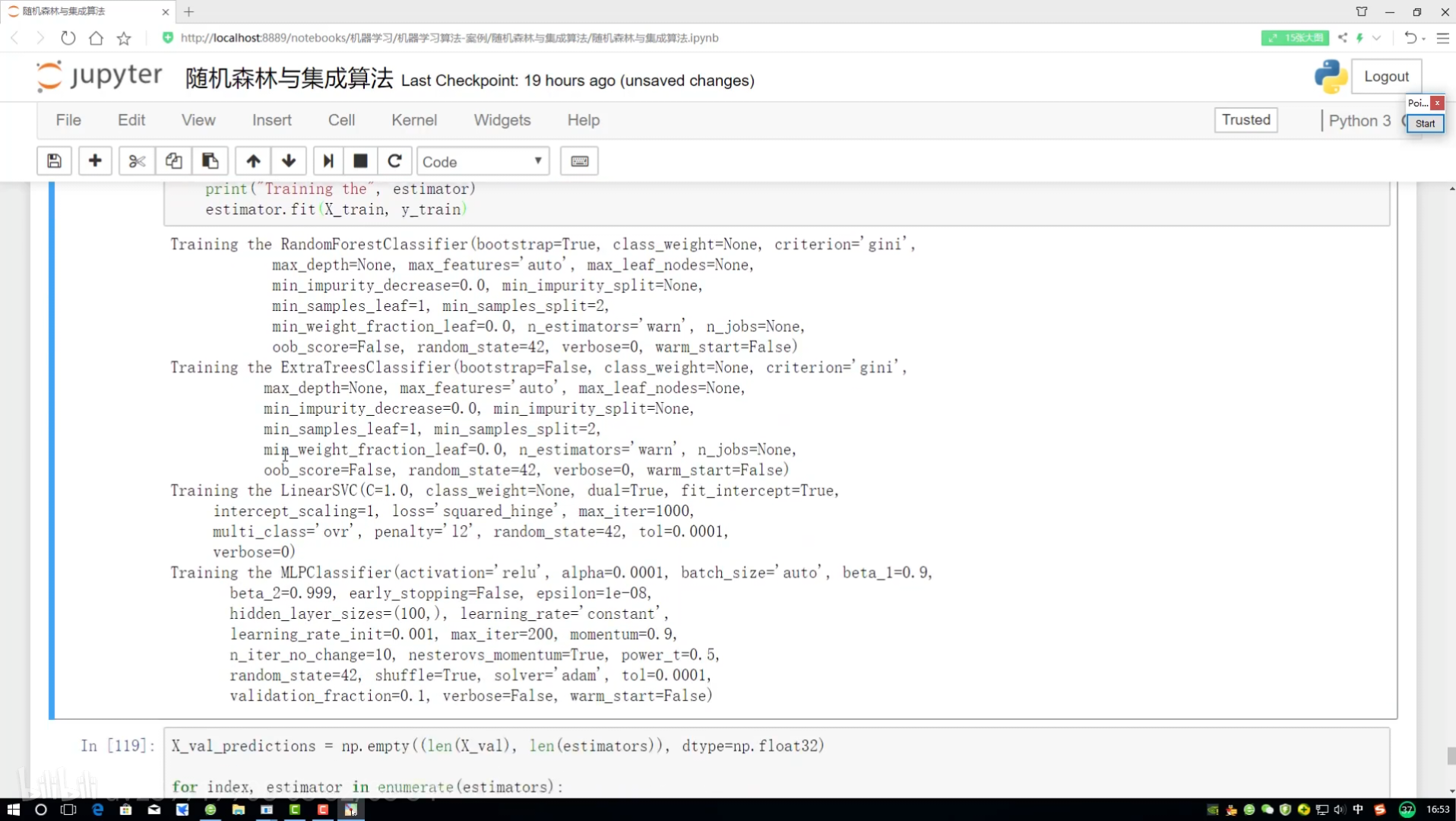

116选择不同分类器

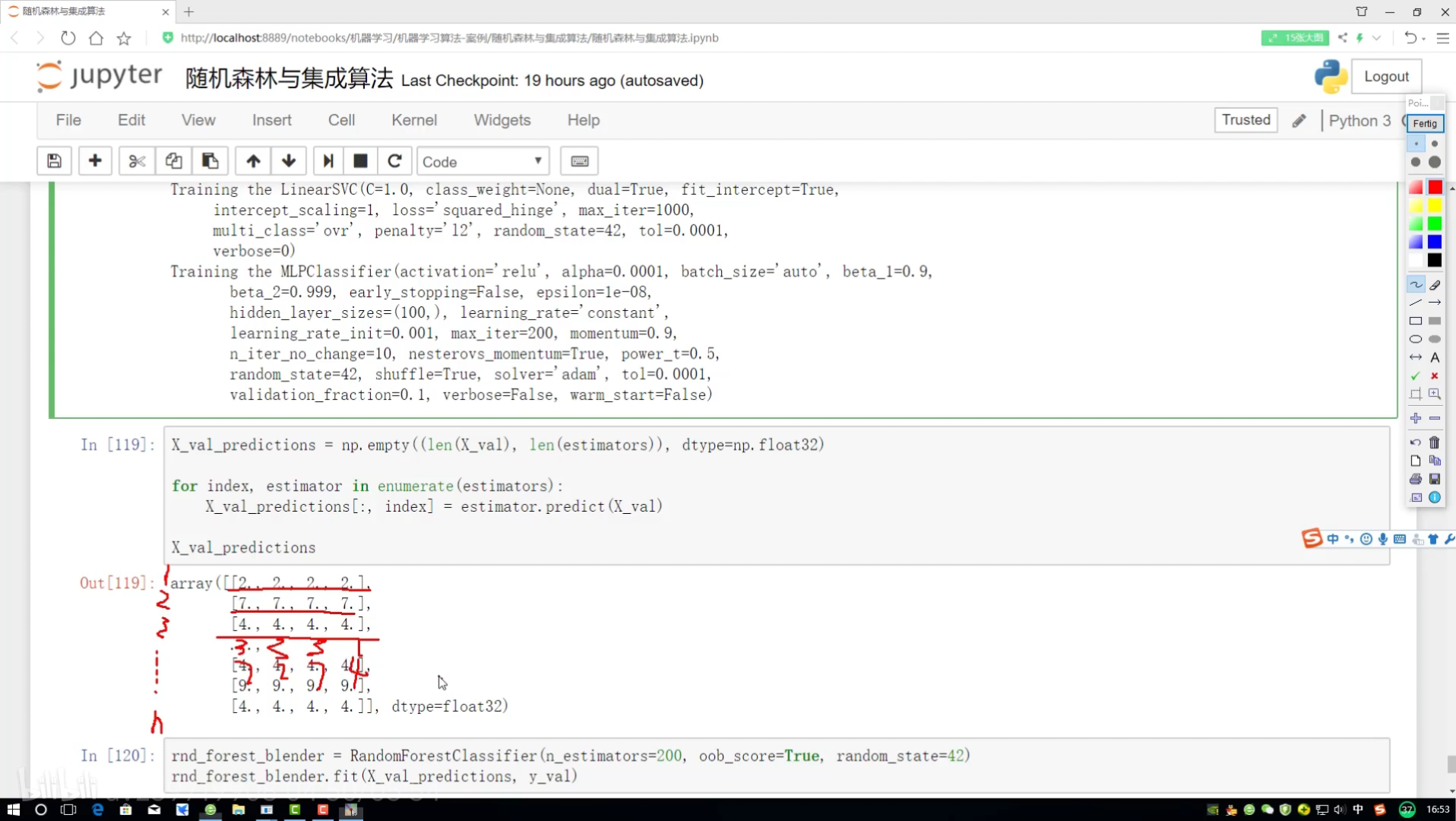

1阶段结果变成2阶段特征

的通用方案)

)

)