目录

前言

1.检查GPU

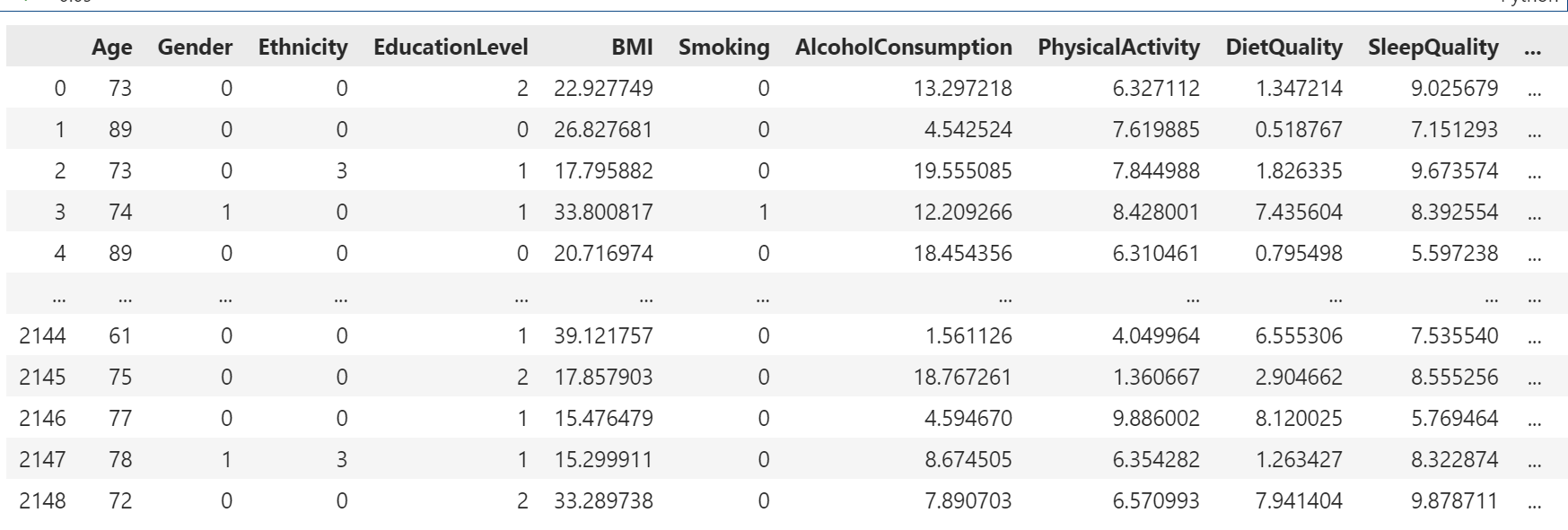

2.查看数据

3.划分数据集

4.创建模型与编译训练

5.编译及训练模型

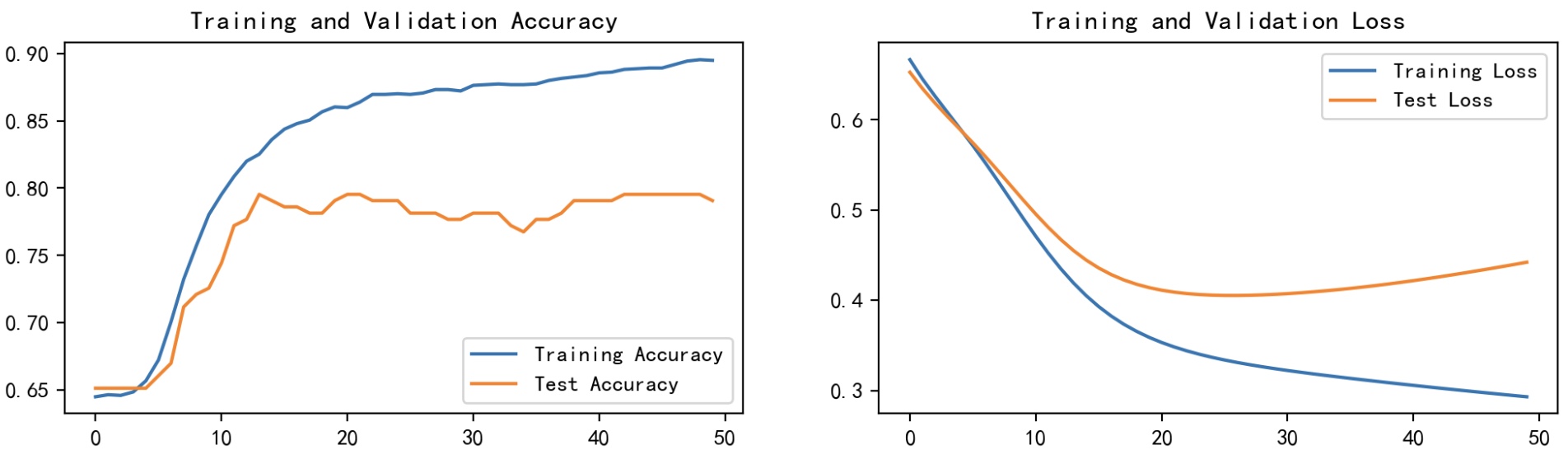

6.结果可视化

7.模型预测

8.总结:

前言

🍨 本文为🔗365天深度学习训练营中的学习记录博客

🍖 原作者:K同学啊

1.检查GPU

import numpy as np

import pandas as pd

import torch

from torch import nn

import torch.nn.functional as F

import seaborn as sns#设置GPU训练,也可以使用CPU

device=torch.device("cuda" if torch.cuda.is_available() else "cpu")

device2.查看数据

df = pd.read_csv("DATA/alzheimers_disease_data.csv")

# 删除第一列和最后一列

df = df.iloc[:, 1:-1]

df 3.划分数据集

3.划分数据集

from sklearn.preprocessing import StandardScaler

from sklearn.model_selection import train_test_splitX = df.iloc[:,:-1]

y = df.iloc[:,-1]# 将每一列特征标准化为标准正太分布,注意,标准化是针对每一列而言的

sc = StandardScaler()

X = sc.fit_transform(X)X = torch.tensor(np.array(X), dtype=torch.float32)

y = torch.tensor(np.array(y), dtype=torch.int64)X_train, X_test, y_train, y_test = train_test_split(X, y, test_size = 0.1, random_state = 1)X_train.shape, y_train.shapefrom torch.utils.data import TensorDataset, DataLoadertrain_dl = DataLoader(TensorDataset(X_train, y_train),batch_size=64, shuffle=False)test_dl = DataLoader(TensorDataset(X_test, y_test),batch_size=64, shuffle=False)4.创建模型与编译训练

class model_rnn(nn.Module):def __init__(self):super(model_rnn, self).__init__()self.rnn0 = nn.RNN(input_size=32, hidden_size=200, num_layers=1, batch_first=True)self.fc0 = nn.Linear(200, 50)self.fc1 = nn.Linear(50, 2)def forward(self, x):out, hidden1 = self.rnn0(x) out = self.fc0(out) out = self.fc1(out) return out model = model_rnn().to(device)

model5.编译及训练模型

# 训练循环

def train(dataloader, model, loss_fn, optimizer):size = len(dataloader.dataset) # 训练集的大小num_batches = len(dataloader) # 批次数目, (size/batch_size,向上取整)train_loss, train_acc = 0, 0 # 初始化训练损失和正确率for X, y in dataloader: # 获取图片及其标签X, y = X.to(device), y.to(device)# 计算预测误差pred = model(X) # 网络输出loss = loss_fn(pred, y) # 计算网络输出和真实值之间的差距,targets为真实值,计算二者差值即为损失# 反向传播optimizer.zero_grad() # grad属性归零loss.backward() # 反向传播optimizer.step() # 每一步自动更新# 记录acc与losstrain_acc += (pred.argmax(1) == y).type(torch.float).sum().item()train_loss += loss.item()train_acc /= sizetrain_loss /= num_batchesreturn train_acc, train_lossdef test (dataloader, model, loss_fn):size = len(dataloader.dataset) # 测试集的大小num_batches = len(dataloader) # 批次数目, (size/batch_size,向上取整)test_loss, test_acc = 0, 0# 当不进行训练时,停止梯度更新,节省计算内存消耗with torch.no_grad():for imgs, target in dataloader:imgs, target = imgs.to(device), target.to(device)# 计算losstarget_pred = model(imgs)loss = loss_fn(target_pred, target)test_loss += loss.item()test_acc += (target_pred.argmax(1) == target).type(torch.float).sum().item()test_acc /= sizetest_loss /= num_batchesreturn test_acc, test_lossloss_fn = nn.CrossEntropyLoss() # 创建损失函数

learn_rate = 1e-4 # 学习率

opt = torch.optim.Adam(model.parameters(),lr=learn_rate)

epochs = 30train_loss = []

train_acc = []

test_loss = []

test_acc = []for epoch in range(epochs):model.train()epoch_train_acc, epoch_train_loss = train(train_dl, model, loss_fn, opt)model.eval()epoch_test_acc, epoch_test_loss = test(test_dl, model, loss_fn)train_acc.append(epoch_train_acc)train_loss.append(epoch_train_loss)test_acc.append(epoch_test_acc)test_loss.append(epoch_test_loss)# 获取当前的学习率lr = opt.state_dict()['param_groups'][0]['lr']template = ('Epoch:{:2d}, Train_acc:{:.1f}%, Train_loss:{:.3f}, Test_acc:{:.1f}%, Test_loss:{:.3f}, Lr:{:.2E}')print(template.format(epoch+1, epoch_train_acc*100, epoch_train_loss, epoch_test_acc*100, epoch_test_loss, lr))

print("="*20, 'Done', "="*20)6.结果可视化

import matplotlib.pyplot as plt

#隐藏警告

import warnings

warnings.filterwarnings("ignore") #忽略警告信息

plt.rcParams['font.sans-serif'] = ['SimHei'] # 用来正常显示中文标签

plt.rcParams['axes.unicode_minus'] = False # 用来正常显示负号

plt.rcParams['figure.dpi'] = 100 #分辨率from datetime import datetime

current_time = datetime.now() # 获取当前时间epochs_range = range(epochs)plt.figure(figsize=(12, 3))

plt.subplot(1, 2, 1)plt.plot(epochs_range, train_acc, label='Training Accuracy')

plt.plot(epochs_range, test_acc, label='Test Accuracy')

plt.legend(loc='lower right')

plt.title('Training and Validation Accuracy')

plt.xlabel(current_time) # 打卡请带上时间戳,否则代码截图无效plt.subplot(1, 2, 2)

plt.plot(epochs_range, train_loss, label='Training Loss')

plt.plot(epochs_range, test_loss, label='Test Loss')

plt.legend(loc='upper right')

plt.title('Training and Validation Loss')

plt.show()import numpy as np

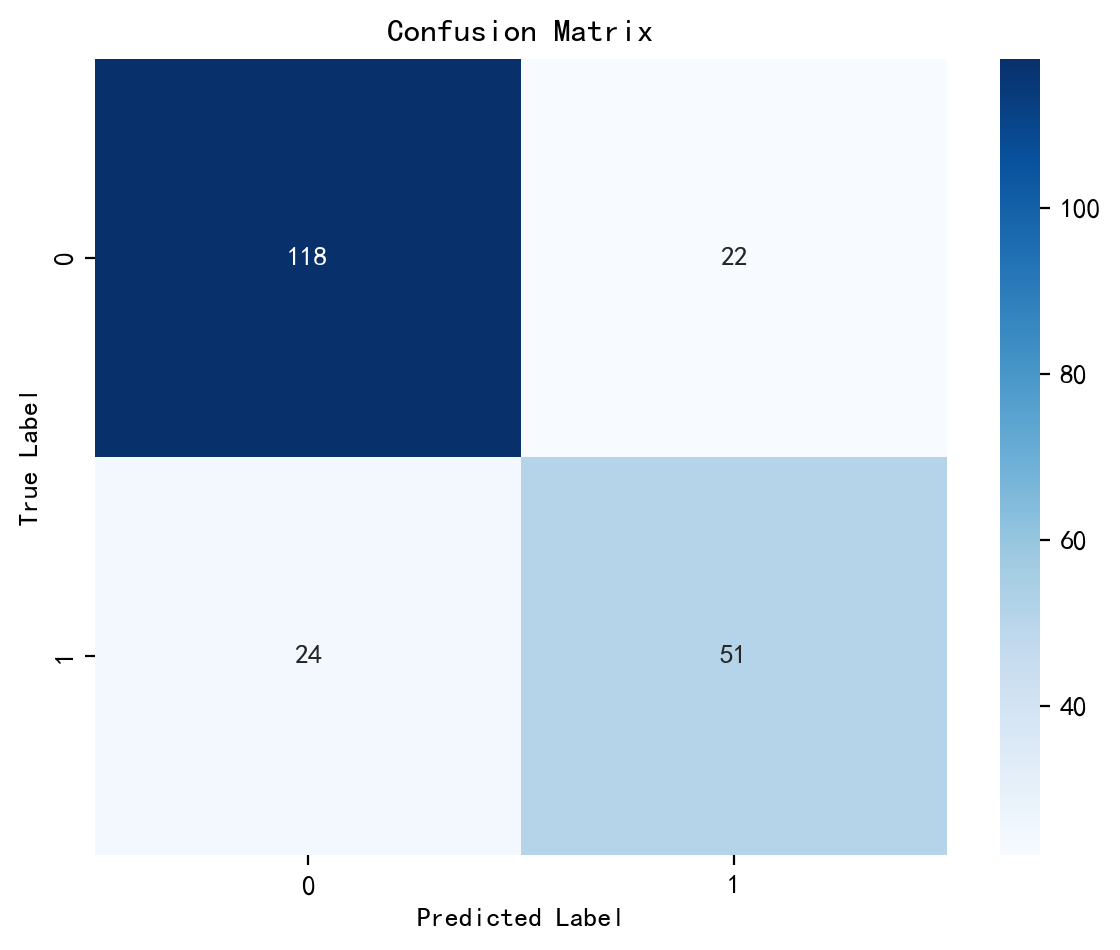

import matplotlib.pyplot as plt

from sklearn.metrics import confusion_matrix, ConfusionMatrixDisplay# 计算混淆矩阵

cm = confusion_matrix(y_test, pred)plt.figure(figsize=(6,5))

plt.suptitle('')

sns.heatmap(cm, annot=True, fmt="d", cmap="Blues")# 修改字体大小

plt.xticks(fontsize=10)

plt.yticks(fontsize=10)

plt.title("Confusion Matrix", fontsize=12)

plt.xlabel("Predicted Label", fontsize=10)

plt.ylabel("True Label", fontsize=10)# 显示图

plt.tight_layout() # 调整布局防止重叠

plt.show()

7.模型预测

test_X = X_test[0].reshape(1, -1) # X_test[0]即我们的输入数据pred = model(test_X.to(device)).argmax(1).item()

print("模型预测结果为:",pred)

print("=="*20)

print("0:未患病")

print("1:已患病")

8.总结:

代码展示了如何使用PyTorch框架进行阿尔茨海默病数据集的分类任务。以下是该代码的主要步骤和功能总结:

检查GPU:首先,代码检查是否有可用的GPU,并设置相应的设备(cuda或cpu)。

查看数据:通过Pandas库加载数据集,并删除第一列和最后一列,这可能是为了去除非特征信息(如ID)或冗余信息。

划分数据集:对数据进行预处理,包括标准化以及将数据划分为训练集和测试集。接着,使用PyTorch的DataLoader创建数据加载器以便于后续模型训练时的数据批次处理。

创建模型与编译训练:定义了一个基于RNN的神经网络模型model_rnn,包含RNN层和两个全连接层。模型被移动到之前设定的设备(GPU或CPU)上。

编译及训练模型:定义了训练和测试函数,分别用于执行模型的训练过程和评估过程。采用交叉熵损失作为损失函数,Adam优化器作为优化算法。经过30个epoch的训练后,记录并打印出每个epoch的训练和测试准确率及损失值。

结果可视化:使用Matplotlib绘制训练和测试的准确率与损失的变化曲线图,直观地展示模型的学习效果。同时,还生成了混淆矩阵以进一步分析模型性能。

模型预测:最后,选取了一条测试数据进行模型预测,输出预测结果,并解释了预测结果的意义(是否患病)。

)

一文解决】var let const)

——链接预测)